Loading AI tools

raisonnement ou une procédure ne respectant pas un ensemble de règles reconnues par la communauté scientifique De Wikipédia, l'encyclopédie libre

L'erreur scientifique consiste en un raisonnement, une théorie ou une affirmation se réclamant de la science mais qui se trouve réfuté par la communauté scientifique. À la différence de la fraude scientifique, l'erreur est involontaire. Elle peut se retrouver dans tous les domaines des sciences, à toutes les époques et sous de multiples formes. Certaines erreurs scientifiques peuvent avoir des conséquences très négatives, notamment celles pouvant altérer la santé humaine, la biodiversité ou l'équilibre de l'environnement.

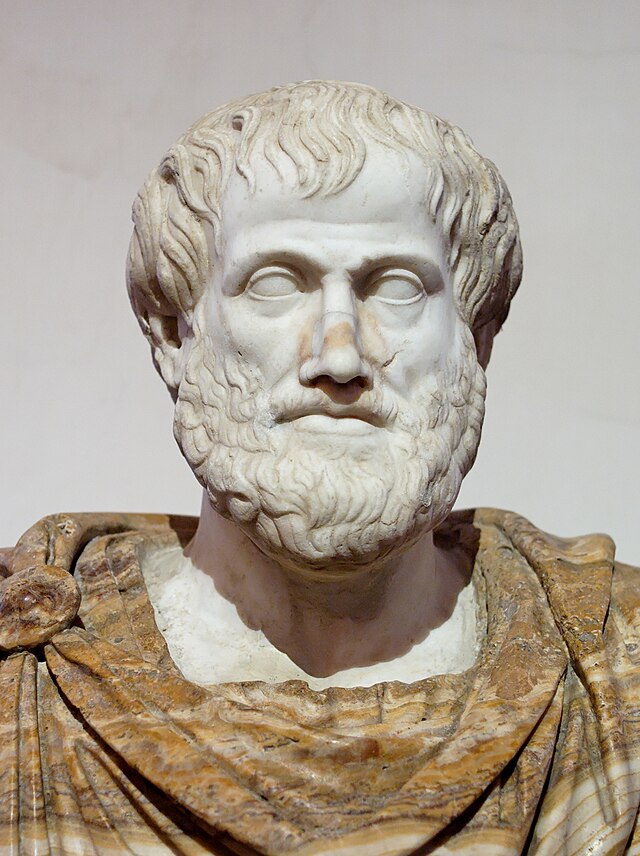

La définition et la caractérisation de la méthode (ou démarche) scientifique fait l'objet de très nombreux ouvrages et études depuis les premières mentions dans les écrits d'Aristote, en passant par le Discours de la Méthode de René Descartes jusqu'aux écrits des XXe et XXIe siècles de Poincaré, Gaston Bachelard, Thomas Kuhn ou encore Karl Popper. Elle peut être résumée comme[1] :

En sciences expérimentales, il est en outre considéré que la méthode employée et le résultat obtenu doivent être reproductibles.

Au XXIe siècle, certaines définitions sont complétées par la nécessité d'une revue par les pairs et la publication dans des revues spécialisées.

Par contraposée, une erreur scientifique est un modèle, une théorie ou, plus généralement, un résultat qui se réclame d'une démarche scientifique mais s'avère erroné.

Des erreurs scientifiques ont été constatées dans tous les domaines de la science, et à toutes les époques. Elles peuvent être de plusieurs natures[2] :

Une autre catégorie d'erreur par ignorance, est celle due à l ' "ignorance de faits non encore connus ou établis révélés par les progrès ultérieurs de la science, notamment par la création de nouveaux outils"[2] : de très nombreux exemples de ce type ont émaillé la progression de la science, et nombreux sont les scientifiques et philosophes qui considèrent que ce type d'erreur est consubstantiel de la progression de la science. Ainsi, selon Albert Einstein : « La seule façon d'éviter de faire des erreurs, c'est la mort[3]. »; pour Jean-François Bach : « Une personne qui n'a jamais commis d'erreur n'a jamais tenté d'innover. »[2]; pour James Joyce « les erreurs sont les portes de la découverte »[4]; pour Gaston Bachelard, « l'esprit scientifique se constitue comme un ensemble d'erreurs rectifiées »[5],[Note 2]; et selon Geoffrey E. R. Lloyd : « Il fallait d'abord aux Grecs de l'Antiquité avoir des idées, fussent-elles inexactes, pour orienter les observations. Ensuite ces observations ont elles-mêmes conduit à remettre en question certains présupposés et à formuler de nouveaux problèmes. »[7].

Plusieurs grandes figures de la science ont d'ailleurs commis des erreurs : Kepler, Galilée, Descartes, Newton, Lavoisier, Darwin, Hilbert, Einstein, Fermi, von Neumann, Hawking, etc[réf. souhaitée]. Elles appartiennent souvent à deux grandes catégories[réf. souhaitée] : celles qui consistent à développer de fausses conceptions et celles qui consistent à considérer comme fausses des théories qui rendent compte de la réalité.

Toute discipline scientifique faisant l'objet d'un enseignement, on retrouve parfois dans son enseignement des erreurs bien après que les scientifiques les ont corrigées : les programmes n'intègrent pas toujours suffisamment rapidement le dernier état de la connaissance.

Les chapitres suivants, organisés par domaine scientifique, donnent quelques exemples de ces différentes catégories d'erreurs, du contexte dans lequel elles sont survenues et de leurs conséquences.

Même si une histoire générale des erreurs scientifiques reste à écrire, les contours peuvent en être esquissés. Afin de pouvoir rechercher ces erreurs le plus loin possible dans le passé, la constitution d'une science, aussi primitive soit-elle, parmi les lointains précurseurs de la science moderne ne suffit pas. Encore faut-il que les témoignages de leurs travaux aient subsisté au fil des siècles voire des millénaires jusqu'à aujourd'hui. D'autre part, il faut pouvoir les déchiffrer espérer en identifier d'éventuelles erreurs, qu'il s'agisse d'observations, de calculs ou encore de conceptions et de théories sous-jacentes. C'est sans doute par le biais de l'astronomie qu'ont subsisté jusqu'à nos jours les plus vieux témoignages précurseurs de travaux scientifiques. De fait, l'un de ces artefacts, mis à la disposition des spécialistes, ne contient aucune écriture à déchiffrer. Ainsi, la tablette d'Ammi-ṣaduqa, datant du VIIe siècle av. J.-C., est la plus ancienne copie d'un texte plus ancien[8]: retrouvée dans la bibliothèque d'Assurbanipal de Ninive elle fait partie des collections du British Museum et contient un registre des levers et couchers héliaques de Vénus sur une période de 21 ans[9]. Cette tablette d'argile recouverte d'écriture cunéiforme renvoie à l'un des documents scientifiques les plus anciens sur lequel il est possible d'en évaluer le contenu.

Dans le domaine des sciences empiriques, de nombreuses erreurs proviennent de l'interprétation soit d'observations soit de résultats.

Les débuts de la science grecque voient se développer, entre autres, les mathématiques, l'astronomie, et la géographie. Dans sa Géographie datant de l'an 150, Ptolémée propose un système de coordonnées qui remonte au moins à l'époque d'Eudoxe[10] et plusieurs cartes contenant de nombreuses erreurs : l'Océan Indien, par exemple, y est représenté comme une mer fermée[Note 3].

Plus tard, une autre erreur, selon laquelle la Californie serait une île, perdure sur des représentations de l'Amérique du Nord datant des XVIIe et XVIIIe siècles, comme celle du cartographe Nicolas Sanson, alors même que cette partie du territoire nord-américain avait été correctement cartographiée comme une péninsule dès 1570 dans le Theatrum Orbis Terrarum sur une carte du monde d'Abraham Ortelius figurant dans cet atlas[réf. souhaitée].

Un autre exemple de ces erreurs de localisation géographique est publié dans l'un des ouvrages les plus connus de l'histoire des sciences : le De revolutionibus orbium coelestium de Nicolas Copernic. Arthur Koestler relevé le fait que, dans son ouvrage majeur, Copernic, pourtant familier de cette région, situe Frauenburg (Frombork) sur l'estuaire de la Vistule alors que la Vistule se jette dans la mer Baltique, près de Gdańsk[Note 4]. Il situe aussi cette dernière sur le méridien de Cracovie alors que ce n'est pas le cas[12].

L'étude des fossiles a conduit à de nombreuses reprises des scientifiques même expérimentés à proposer des conclusions erronées, notamment lorsque ces fossiles étaient peu nombreux ou fragmentaires.

En 1868, Thomas Henry Huxley crut reconnaître une forme de vie primitive dans un échantillon de sédiments du fond marin, prélevé en 1857 dans l'océan Atlantique. Il nomma les restes de ce prétendu organisme fossile, Bathybius haeckelii. Trois ans plus tôt, en 1865, était parue une série d'articles sur un autre prétendu organisme fossile, découvert lui dans des roches du Précambrien : John William Dawson qui en était le principal promoteur l'avait nommé Eozoon canadense. Dans un cas comme dans l'autre, il fut démontré plus tard que les structures observées étaient non pas des fossiles organiques mais le résultat de processus inorganiques. Il est intéressant de constater les réactions toutes différentes des deux protagonistes: alors que Huxley admit rapidement son erreur, Dawson campa sur sa conception initiale jusqu'à sa mort[13].

Anomalocaris est un arthropode ayant vécu au Cambrien moyen. Son identification a longtemps dérouté les paléontologues qui furent induits en erreur parce que les fossiles étudiés n'étaient en fait que certaines parties de cet organisme. Ainsi ce qui sera reconnu plus tard comme un appendice préhenseur de l'animal a été décrit par Joseph Frederick Whiteaves en 1892 comme une créature distincte ressemblant à un crustacé[14]. La bouche fossilisée de l'animal, découverte par Charles Doolittle Walcott, fut considérée comme une méduse[14]. Le corps, découvert séparément fut classé parmi les Holothuries. Cette série d'erreurs perdura jusqu'à ce que Harry Whittington découvre sans équivoque l'appendice et la bouche d'un même organisme dans ce que l'on croyait être jusque-là respectivement une crevette et une méduse[14], puis il fallut encore plusieurs années aux chercheurs pour réaliser que Peytoia, Laggania et les appendices préhenseurs correctement juxtaposés constituaient une seule et énorme créature[14]. Selon Desmond Collins du Musée royal de l'Ontario « La longue histoire de reconstruction inexacte et d'identification erronée d'Anomalocaris... illustre notre grande difficulté à visualiser et à classifier, à partir de restes fossiles, les nombreux animaux du Cambrien sans descendants vivants apparents[15]. »

L'étude des microfossiles de micro-organismes, parmi lesquels on compte les foraminifères, les diatomées et les radiolaires, a conduit à la naissance de la micropaléontologie. Les radiolaires ont été étudiés dès le milieu du XIXe siècle par Johannes Peter Müller qui en établit la nature unicellulaire et les baptisa Radiolaria en 1858[16]. Pendant près d'un siècle, les biologistes ont toutefois considéré que les fossiles de ces micro-organismes n'avait aucune utilité en stratigraphie. Ernst Haeckel dans un ouvrage de 1 800 pages et 140 illustrations, publié en 1887[17], décrit 785 nouvelles espèces[16]. Il propose une classification basée sur les formes géométriques de ces organismes : « Ainsi, deux formes très différentes, mais possédant chacune deux sphères et trois épines par exemple, sont classées à tort dans un même genre qui semble de ce fait avoir une répartition sur des dizaines ou des centaines de millions d'années[16]. ». Les travaux de William Riedel dans les années 1950 puis ceux de Maria Petrushevskaya dans les années 1960 et 1970 ont conduit à revoir complètement cette classification et mis en évidence l'évolution de la structure de l'endosquelette de ces micro organismes[16].

L'histoire de la médecine fournit de très nombreux exemples de successions de théories qui s'avèrent, au fil des découvertes, des observations et des expérimentations, être erronées et sont remplacées par d'autres. Ce remplacement ne se fait pas toujours rapidement, deux théories différentes et incompatibles pouvant coexister durablement avant que la communauté médicale finisse par ne plus admettre que l'une d'entre elles, souvent après de longues controverses. Les sections suivantes donnent des exemples de telles évolutions dans des disciplines médicales et à des époques différentes.

La médecine de la Grèce antique s'était dotée d'un cadre théorique avec la théorie des humeurs du corpus hippocratique, qui sera reprise par Hérophile et développée par Galien en théorie du pneuma[18]. Selon cette approche, la santé humaine était conditionnée par quatre humeurs (sang, flegme, bile jaune, bile noire), associées aux quatre éléments (air, eau, feu, terre), et aux organes (cœur, cerveau, foie, rate), dont le déséquilibre influençait le caractère du patient et pouvait engendrer les maladies[19].

D'autres explications étaient données pour certaines maladies : ainsi l'hystérie était censée résulter d'un déplacement de l'utérus à l'intérieur du corps de la femme. Cette conception erronée perdura jusqu'au milieu des années 1800 : certains gynécologues continuaient de considérer l'hystérie comme une maladie féminine qu'ils traitaient par l'ablation du clitoris ou de l'utérus[20].

L'observation de l'isochronisme du pouls et des battements cardiaques est très ancienne mais depuis Galien les médecins pensaient que le sang sortait du cœur lors de la diastole, le moment où il est en expansion : la théorie était que lorsque le cœur se dilatait, la paroi des artères se dilatait aussi créant un mouvement d'aspiration du sang[21]. Le français Jean Fernel montrera en 1542 qu'en fait le sang sort du cœur avec la systole, au moment de sa contraction[22]. Galien fut, en revanche, à l'origine de la découverte du fait que le sang circulait dans toutes les artères, mais, pour l'expliquer, imagina que le sang devait circuler à travers la paroi séparant les deux ventricules à travers des pores[21]. 1 300 ans plus tard, Léonard de Vinci admettait toujours lui aussi l'existence de tels pores. En réalité, la paroi inter-ventriculaire ne permet pas une telle circulation.

Les médecins de l'Égypte antique pensaient que le cœur était un organe qui pouvait se déplacer dans le corps[23],[24] et que ses déplacements pouvaient causer des maladies qu'on diagnostique en tâtant le pouls[23],[24]. Par ailleurs, ils ne faisaient pas de différence entre vaisseaux sanguins, nerfs et ligaments[25].

Aristote s'est trompé sur le nombre de côtes de la cage thoracique humaine et, pour lui, le cerveau ne contenait pas de sang[26]. Léonard de Vinci, dont les études ont fait faire de très grands progrès à l'anatomie, pensait initialement que le cœur n'était constitué que de deux ventricules, puis décrivit un cœur à quatre cavités. Mais il n'observa et ne décrivit ni le péricarde ni le pancréas[27]. Quant à Hérophile, il écrivit avoir observé chez l'homme le rete mirabile, un ensemble de vaisseaux sanguins et de nerfs qu'on retrouve chez diverses espèces animales mais non chez l'homme[28]. Cette erreur ne sera corrigée qu'avec Thomas Willis au XVIIe siècle et l'observation de ce que l'on nomme le polygone de Willis[29].

Au XVIIIe siècle, l'arrivée du microscope ne met pas un terme aux erreurs d'observation et de description des structures anatomiques : ainsi par exemple, Antoni van Leeuwenhoek, qui fut l'un des premiers à observer des fibres nerveuses au microscope, considère que les nerfs sont des vaisseaux, tout comme les artères et les veines, donc creux[30].

Encore au XXIe siècle, des découvertes corrigent des erreurs passées. Ainsi les scientifiques ont-ils longtemps pensé que le système lymphatique était absent du cerveau de même que du reste du système nerveux central[31]. Mais certains chercheurs se demandaient pourquoi le cerveau ne signalerait pas au système immunitaire s'il était infecté par un intrus microbien. Après la mise en évidence d'une activité immunitaire dans les méninges, des chercheurs découvrirent, en 2014, l'existence de vaisseaux lymphatiques dans ces membranes chez la souris[32]. D'autres équipes ont par la suite observé la présence de vaisseaux lymphatiques similaires chez le poisson, la souris, le rat, le primate non humain et l'humain[33],[31],[34].

Certaines maladies sont plus difficiles à diagnostiquer que d'autres; c'est notamment le cas du trouble bipolaire qui peut être confondu avec la dépression[35],[36],[37].

Des erreurs concernant le développement futur de l'état d'une population ou d’une personne après un diagnostic correct sont également possibles. Sur le plan collectif, un exemple est celui de la fin annoncée des maladies infectieuses dans le monde sous la double pression du développement social (hygiène individuelle, assainissement public, éducation pour la santé, etc.) et du développement continu des médicaments antiinfectieux (antibiotiques, antiparasitaires, antiviraux), théorie qui a prévalu dans les années 1960-70[réf. nécessaire], pour s’effondrer à partir des années 1980 avec l’émergence du sida suivi d’autres viroses humaines et animales, amenant même à définir le concept de maladies infectieuses émergentes[38].

En 1935 eurent lieu les premiers essais de vaccination contre la poliomyélite menés par deux équipes distinctes. L'une dirigée par le professeur John Kolmer, de l'Université Temple de Philadelphie, et l'autre par Maurice Brodie (en), un jeune chercheur de l'Université de New York. L'équipe de Kolmer avait mis au point un vaccin antipoliomyélitique atténué qui fut testé sur environ 10 000 enfants aux États-Unis et au Canada[39]. Cinq de ces enfants moururent de la polio, 10 autres développèrent une paralysie, généralement dans le bras où le vaccin avait été injecté, et la maladie apparut dans des villes où aucune épidémie de polio ne s'était déclarée auparavant mais où des enfants avaient été vaccinés. En outre, il n'avait pas de groupe témoin, ce qui constituait une grave erreur de méthodologie[39]. Le vaccin de Brodie, basé sur un virus tué par le formaldéhyde, fut testé sur 7 500 enfants et adultes, avec un groupe témoin de 4 500 personnes[39]. Le vaccin fur annoncé comme efficace à 88%, mais des études ultérieures mirent en cause ces résultats, imputant même au vaccin la responsabilité, dans certains cas, de la transmission de la maladie[39]. Les deux vaccins furent rejetés et deux décennies s'écoulèrent avant la reprise des recherches dans ce domaine qui mèneront au développement du vaccin Salk.

Après une très grave épidémie de poliomyélite survenue aux États-Unis en 1952, les autorités américaines lancent un plan d'urgence pour la mise au point d'un vaccin et la vaccination massive des enfants. Un biologiste, Jonas Salk, met au point une formule vaccinale basée sur l'inactivation d'une variante du virus. Cinq sociétés sont mises en concurrence pour produire un vaccin, dont une remporte la plus grande part des commandes : la firme Cutter. Entre fin 1954 et le printemps 1955, et malgré les réticences de Salk qui trouvait cette décision précipitée, 380 000 enfants sont vaccinés avec le vaccin Cutter. Des cas de plus en plus nombreux d'effets secondaires indésirables apparaissent : faiblesse musculaire persistante et même paralysie chez des enfants vaccinés, décès de quelques-uns, apparition de la polio chez les proches d'enfants vaccinés. La campagne de vaccination est suspendue au deuxième trimestre 1955. Les industriels concernés contestent initialement le lien entre la vaccination et ces problèmes, puis évoquent la possibilité de sabotages, avant de reconnaître leur implication[Note 5]. Cette situation fut causée par un enchaînement d'erreurs : Salk n'avait pas défini suffisamment strictement le protocole d'inactivation à respecter par les industriels et ceux-ci l'avaient fait évoluer pour pouvoir produire à très grande échelle ; la décision de lancer la campagne de vaccination avait été prise alors que des essais cliniques sur des singes avaient montré un risque de transmission de la maladie ; les tests par prélèvement d'échantillons en production n'étaient pas adéquats ; etc[40].

L'utilisation de la pentamidine à titre préventif dans les années 1950 dans le but d'éradiquer la maladie du sommeil s'est avérée être une autre erreur[41],[42]. Sous le nom Lomidine, plus de 12 millions d'injections préventives furent administrées entre 1945 et 1960 à des personnes saines en Afrique centrale et de l'Ouest. Les effets du médicament sur les personnes non infectées n'ont fait l'objet que d'une seule étude n'ayant porté que sur deux personnes de Léopoldville. La maladie a bien reculé, mais pas sensiblement plus que dans les zones africaines où la vaccination n'a pas eu lieu et les populations vaccinées ont subi des effets secondaires souvent très graves. Certains médecins de l'époque semblaient déjà sceptiques quant à l'efficacité de l'injection, et recommandaient aux Européens de ne l'accepter qu'en cas de risque grave d'infection. En 1970, des études montrèrent en outre qu'une seule injection n'avait aucun effet durable de prévention[42].

L'une des erreurs les plus marquantes de la pharmacologie moderne fut l'utilisation de la thalidomide. Cette molécule fut prescrite durant les années 1950 dans 46 pays aux femmes enceintes comme médicament antiémétique pour contrer les vomissements et les nausées[43]. Ses effets tératogènes sur l'embryon ne furent mis en évidence qu'après plusieurs années d'utilisation faisant des milliers de victimes atteintes de phocomélie, révélant ainsi de graves lacunes dans le protocole lié à la pharmacovigilance des médicaments à usage humain et conduisant au retrait du produit. Les scientifiques n'étaient pas unanimes dans l'appréciation de cette molécule lors de sa demande de mise sur le marché : ainsi Frances Oldham Kelsey, une experte de la Food and Drug Administration, avait refusé que de médicament soit commercialisé aux États-Unis, estimant que son innocuité n'avait pas été suffisamment démontrée[44],[45].

Malgré le renforcement des processus de tests de nouveaux médicaments[46], il y a eu depuis plusieurs autres cas de médicaments q retirés du marché à la suite d'une révision scientifique de leurs bénéfices et de leurs inconvénients :

L'épidémiologie est la discipline scientifique étudiant les maladies épidémiques, leur mode de contagion et les moyens de les combattre[52]. Pour cela l'épidémiologiste réalise des études, ou enquêtes sur des groupes de personnes et compare les résultats obtenus entre eux (les malades et les non-malades, les personnes traitées et les non-traitées, etc.). Comme dans toutes études portant sur des groupes, par exemple les enquêtes d'opinion, une grande attention doit être portée à la constitution des groupes, pour éviter les biais statistiques, et aux conclusions tirées des différences constatées, notamment en termes de causalité[53] qui peuvent être sujettes à des biais de confusion[54].

Un exemple historique de ce type a été démontré par John Snow, qui a étudié une épidémie de choléra en 1854 à Londres (voir aussi Troisième pandémie de choléra). Une corrélation entre la survenue du choléra et l'altitude était constatée : les quartiers les plus bas de la ville étaient les plus touchés. La qualité de l'air, meilleure dans les quartiers plus élevés, a alors été avancée comme cause des différences mesurées. Cette explication venait, de plus, renforcer la vieille conception de la théorie des miasmes qui imputait à la mauvaise qualité de l'air diverses maladies. Les études de Snow ont démontré qu'en réalité c'était la qualité de l'eau fournie par un distributeur qui devait être mise en cause[Note 6]: les quartiers les plus bas de Londres étaient simplement ceux qui recevaient de l'eau de mauvaise qualité[56].

De la Grèce antique au cœur du XIXe siècle, une théorie selon laquelle des organismes vivants pouvaient apparaître spontanément à partir d'éléments chimiques dominait la biologie : Platon, Aristote, Isaac Newton et René Descartes, parmi bien d'autres grands savants, en furent des promoteurs. D'après certains tenants de cette théorie, l'apparition spontanée de mouches, d'asticots et même de souris avait été observée. En 1860, Félix Archimède Pouchet, médecin biologiste français et chef de file de cette école de pensée appelée "hétérogénie", publie un traité dans lequel il relate des expériences prouvant scientifiquement, d'après lui, sa validité. Plusieurs chercheurs avaient pourtant, dès le XVIIe siècle, conduit des expériences mettant en doute la possibilité de cette génération spontanée d'organismes vivants. Ce sont les travaux de Louis Pasteur qui démontreront que les résultats avancés par Pouchet et autres étaient erronés car menés sur des échantillons contaminés par des micro organismes[57].

Dès l'Antiquité, Aristote reconnait deux possibilités pour un organisme de se développer à partir d'un œuf : soit il est déjà préformé, soit l'organisme se forme au cours du développement. La première donnera lieu à la théorie de la préformation, la seconde à celle de l'épigenèse[58],[Note 7].

La théorie de la préformation avait des racines philosophiques dans la métaphysique de Descartes, qui a introduit le concept de matérialisme. Ce concept considère que le monde est complètement mécaniste et déterministe, sans qu'aucune force immatérielle n'intervienne dans les interactions des objets physiques. Pour les matérialistes, l'épigenèse semblait nécessiter l'introduction d'une force vitale ou intelligence qui savait organiser les fluides parentaux dans la structure physique de la progéniture et devait donc être rejetée[61].

Les erreurs des scientifiques des tenants du préformationisme se sont partagées en deux théories rivales : l'ovisme, considérant que les organismes préformés se trouvaient déjà entièrement constitués dans l’œuf[61]; et l' animalculisme, apparu avec l'arrivée du microscope[61] qui permit à Antoni van Leeuwenhoek d'observer les spermatozoïdes et de prétendre y avoir vu des êtres préformés, appelés homunculus[62]. Le préformationisme eut des défenseurs scientifiques jusqu'au XVIIIe siècle[63],[Note 8].

Hérophile et son successeur Érasistrate furent parmi les premiers neuroanatomistes dont les noms nous sont parvenus[Note 9]. En étudiant le cerveau humain ils observèrent les ventricules cérébraux et leur attribuèrent une fonction, distinguèrent le cervelet du reste du cerveau, et décrivent les membranes et les sinus veineux cérébraux[65]. Pour certains médecins, comme Galien, ces cavités étaient remplies d'air, alors que pour d'autres, elles étaient remplies de liquide et jouaient un rôle pour le transport des esprits animaux[66],[Note 10]. Jusqu'à Léonard de Vinci, qui eut l'idée d'injecter de la cire dans les cavités ventriculaires pour mieux les décrire, la description des ventricules cérébraux contenait des erreurs[68]. Il y localise toutefois les « principales fonctions de la pensée humaine : la mémoire, l'attention, la fantaisie, la connaissance, la pensée, l'imagination, l'application et même le siège de « l'âme » se voit attribuer un territoire précis du plancher du troisième ventricule qui reçoit « l'esprit vital » monté du cœur avec la « chaleur vitale » par deux canaux para-médullaires imaginaires[68]. ». René Descartes explique le phénomène des stimulations sensorielles comme la mise en mouvement par le cœur des esprits animaux contenus dans le cœur et les artères se rendant jusque dans les cavités du cerveau par analogie aux soufflets des orgues poussant l'air dans les tuyaux[66]. Descartes fait aussi de la glande pinéale le siège de l'imagination et du sens commun[66]. Vers 1730, alors que certains phénomènes liés à l'électricité commencent à être observés, Pieter van Musschenbroek affirme que l'électricité n'est pas le phénomène expliquant le fluide nerveux mais que ce dernier est propulsé dans les nerfs par la systole du cerveau, tout comme le sang dans les artères par la systole du cœur[66].

Au XVIIe siècle, Thomas Willis fait faire des progrès remarquables à la neuroanatomie (Cf.) mais relie à tort certaines fonctions à diverses structures cérébrales: s'il localise correctement le siège de la mémoire dans le cortex cérébral, Willis attribue au corps calleux celui de l'imagination tandis qu'il conçoit le cervelet comme étant le siège des mouvements involontaires[69].

À la suite des travaux d'Ivan Pavlov qui met en évidence les réflexes conditionnés ou « réflexes conditionnels », plusieurs chercheurs concluent que ces derniers ne peuvent se manifester que chez les espèces pourvues d'un cortex cérébral jusqu'à ce qu'on observe ce phénomène chez certaines espèces de poissons qui en sont dépourvues[70].

Jusqu'aux travaux d'Eduard Hitzig et Gustav Fritsch en 1870, diverses expériences pour tenter de faire réagir le cortex du cerveau au moyen d'un courant électrique n'avaient donné aucun résultat. Il en résulta la théorie de l'inexcitabilité du cortex cérébral. Hitzig et Fritsch réussirent à provoquer chez le chien des mouvements involontaires du côté opposé de la stimulation au moyen de fines électrodes de platine séparées de quelques millimètres et d'un faible courant démontrant ainsi la fausseté de cette théorie[71].

Jusque dans les années 1970-1980, il était admis que le cerveau était incapable de se modifier lors des processus d'apprentissage. Pourtant, dès 1890, William James écrivait dans The Principles of Psychology : « ...la matière organique, spécialement le tissu nerveux, semble doté d'un extraordinaire degré de plasticité[72]. » En 1923, Karl Lashley mena des expériences sur des singes rhésus qui démontrèrent des changements dans les voies neuronales et qui lui firent conclure à une preuve de plasticité cérébrale[73]. En dépit de ces premiers travaux, les neuroscientifiques de l'époque rejetèrent l'idée de la neuroplasticité[73]. En 1949, l'hypothèse de la neuroplasticité reçut l'appui de Donald Hebb[73] qui présenta la règle de Hebb. Cette règle concerne plus particulièrement la plasticité synaptique qui relie l'efficacité des synapses lors de leurs stimulations répétées et propre à « induire un changement cellulaire persistant qui augmente sa stabilité »[74].

En 1964, la neuroanatomiste Marian Diamond, de l'université de Californie à Berkeley, réalisa une série de travaux chez le rat qui apporta les premières preuves scientifiques de la plasticité anatomique du cerveau[75],[76]. En 2000, des chercheurs purent établir sur le plan anatomique cette plasticité cérébrale chez l'être humain adulte, montrant que l’hippocampe postérieur chez les chauffeurs de taxi londoniens est plus développé que celui d'autres personnes observées à titre de sujets de contrôle[77].

Pendant la plus grande partie du XXe siècle, la majorité des chercheurs était convaincue que le cerveau adulte ne fait que perdre des neurones sans aucune possibilité de régénération. Par exemple le célèbre neuroscientifique espagnol Santiago Ramón y Cajal affirmait que « ...les voies nerveuses sont quelque chose de fixe, de fini et d'immuable; tout peut mourir, rien ne peut renaître »[78].

Les premiers résultats à contredire cette théorie ont été publiés en 1965 par Joseph Altman et Gopal Das du Massachusetts Institute of Technology (MIT). Travaillant avec des rats adultes, ils ont observé la naissance de nouvelles cellules dans deux régions du cerveau : le système olfactif et le gyrus denté de l’hippocampe[79]. Deux ans plus tard, ils obtiennent des résultats similaires chez le cochon d'Inde[80]. Une incertitude demeurait toutefois quant à savoir s'il s'agissait bien de neurones ou de cellules gliales[79].

Dans les années 1980, d'autres chercheurs mirent en évidence l'apparition de nouveaux neurones, cette fois dans le cerveau de canaris qui apprenaient de nouveaux chants. Des indices commencèrent à s'accumuler avec d'autres expériences, comme l'augmentation du poids cérébral des rats après qu'ils ont été entraînés à retrouver leur chemin dans des labyrinthes[79]. Mais jusqu'aux années 1990, la plupart des scientifiques restèrent convaincus qu'aucun nouveau neurone ne se forme jamais dans le cerveau adulte[79].

Les travaux d'Elizabeth Gould à la fin des années 1990 mettront en évidence que la genèse de plusieurs milliers de nouveaux neurones se produit chaque jour dans le gyrus denté de l'hippocampe chez le singe adulte[79]. Ces résultats chez les singes ont ensuite été observés chez l'homme[81],[82],[83].

Les chercheurs pensaient autrefois que les neurones en fuseau, parfois appelés neurones de von Economo, ne se retrouvaient que dans le cerveau humain et celui des grands singes[84], dans des parties de cerveau associées à des fonctions cognitives telles que les interactions sociales, l'intuition et le traitement émotionnel[85]. Pour cette raison, ces neurones étaient considérés comme distinguant les humains et les autres grands singes de tous les autres mammifères. Il s'avère que ces neurones en fuseau existent aussi dans les mêmes régions correspondantes du cerveau chez les baleines à bosse, les rorquals communs, les orques et les cachalots[86],[87].

Jusqu'au début des années 1990, les chercheurs croyaient que le rôle du système immunitaire se cantonnait à distinguer les constituants de l'organisme, le soi, de ce qui lui est étranger, le non-soi[88],[89]. Les travaux de Polly Matzinger montrèrent que le système immunitaire avait pour rôle non seulement de combattre les organismes pathogènes mais aussi d'intervenir pour réparer les tissus endommagés lors d'une lésion[88]. Des études ultérieures ont montré que lors d'une lésion, les tissus émettent des signaux qui sont captés par le système immunitaire : ce dernier, ainsi activé, intervient sur le tissu lésé[89]. Lors d'un coup violent, certaines molécules de l'organisme telles l'ATP, l'ADN et l'ARN se propagent dans l'espace intercellulaire[90] : elles deviennent alors détectables par les récepteurs de type Toll et d'autres molécules présentes sur les cellules immunitaires qui réagissent à ces signaux de danger en déclenchant une réaction inflammatoire[90]. D'autres expériences ont montré que si on supprime le fonctionnement du système immunitaire adaptatif chez un organisme, le développement et la croissance des tumeurs s'en trouve accélérés alors que la guérison des tissus s'en trouve ralentie[89],[91],[Note 11].

La relation entre le cerveau et le système immunitaire est longtemps restée méconnue, les chercheurs pensaient qu'elle était inexistante mis à part dans certains cas pathologiques. Des recherches montrent en fait qu'ils sont intimement liés[92]. Les expériences menées à la fin des années 1990 par Michal Scwartz, de l'institut Weizmann, mirent en évidence que l'élimination des cellules immunitaires du système nerveux central ayant subi une lésion aggrave la perte des neurones et les perturbations de fonctionnement du cerveau[93]. De même, des études de Stanley Appel, de l'hôpital méthodiste de Houston (en) et Mathew Blurton-Jones, de l'université de Californie à Irvine, ont montré que la sclérose latérale amyotrophique et la maladie d'Alzheimer se développent plus sévèrement et rapidement chez des souris privées du système immunitaire adaptatif que chez des souris normales[93].

Les développements de la génétique et de la biologie du développement apportèrent les connaissances nécessaires à la correction de nombreuses erreurs dans ce domaine. Ainsi par exemple, Darwin partagea la croyance qu'il fallait plusieurs spermatozoïdes pour féconder un œuf et c'est avec les travaux d'Oscar Hertwig, en 1875, que vit le jour l'idée que la fécondation consistait dans la fusion de deux noyaux[94]. De même, Darwin, tout comme Charles Naudin, soutenaient qu'un seul grain de pollen ne pouvait féconder l'ovule d'une plante, affirmation qui fut démentie par des expériences de Mendel qui put obtenir avec Mirabilis jalapa plusieurs plantes viables dont la graine fut fécondée chaque fois par un unique grain de pollen[95]. Mendel, à son tour, se trompait en pensant que tous les caractères se transmettent indépendamment les uns des autres. Hugo de Vries, Carl Correns et Erich von Tschermak, les redécouvreurs des lois de Mendel, ont commis aussi la même erreur jusqu'à ce que le phénomène de linkage ou liaison génétique fut mis à jour permettant de découvrir que cette indépendance de transmission n'est vérifiée que pour des caractères dont les gènes sont situés sur des chromosomes différents[94].

À la fin des années 1920 et début des années 1930, après avoir conçu une nouvelle technique agricole, la vernalisation, le biologiste russe Trofim Lyssenko élabore une théorie selon laquelle des plantes, notamment des taxons de graminées céréalières, pouvaient être génétiquement modifiées par leur environnement naturel. Sur la base de cette théorie, Lyssenko pense dès lors qu'il est possible de changer le blé en seigle ou encore l'orge en avoine. Cette pseudo-théorie, qui ne s'appuyait alors sur aucune méthode expérimentale et scientifique, n'a été qu'entièrement et unanimement démantelée et réfutée par l'ensemble de la communauté scientifique internationale (y compris par l'Académie des sciences soviétique) qu'à partir des années 1964-1965, après la destitution de Nikita Khrouchtchev[96],[97],[98].

À partir de 1941 et des travaux de George Beadle et Edward Tatum sur les chaînes de synthèse de métabolites apparaît l'idée qu'à la synthèse d'une enzyme ne correspond qu'un seul gène. Vérifiée dans un premier temps chez les champignons et les bactéries[99], elle fut plus tard étendue à toutes les protéines. Avec la découverte de la structure de l'ADN et du code génétique, ce lien devient une certitude pour bon nombre de biologistes. Mais des découvertes ultérieures montrent la correspondance un gène - une protéine n'est pas parfaite : par exemple, l'hémoglobine humaine est composée de deux chaines α et de deux chaînes β alors que la synthèse de chacun de ces deux types de chaînes est dirigée par deux gènes distincts[99]. D'autres biologistes découvrent ensuite le phénomène de l'épissage alternatif qui explique comment un nombre limité de gènes peut être à l'origine d'un nombre incomparablement plus élevé de protéines. En 2008, plusieurs études montrent qu'au moins 95 % des gènes sont assujettis à ce phénomène d'épissage alternatif si bien que 22 000 gènes coderaient de 100 000 à 1 000 000 de protéines distinctes[100]. Un des exemples extrêmes est le gène DSCAM (en) de la drosophile qui peut donner jusqu'à 38 000 protéines de formes distinctes[101],[102],[103].

Jusqu'à la découverte des rétrotransposons et la mise en évidence de leur action dans les cellules somatiques dont les neurones, les chercheurs pensaient que la séquence des nucléotides du génome des cellules cérébrales dans le cerveau d'un mammifère adulte était la même pour toutes les cellules et restait inchangée durant toute la vie de l'organisme[104]. Des biologistes découvrirent qu'en fait, chez la souris et chez l'humain, le phénomène de réinsertion des rétrotransposons avec les éléments longs nucléaires intercalés et les éléments courts nucléaires intercalés modifie cette séquence d'un neurone à l'autre dans l'hippocampe et le noyau caudé[104],[105],[106].

En 1843, Edward Forbes a proposé l'hypothèse azoïque (en) selon laquelle l'abondance et la variété de la vie marine diminuent avec la profondeur et calculé que la vie marine devait cesser d'exister au-delà de 300 brasses (1 800 pieds ; 550 mètres). Sa théorie était basée sur l'analyse d'échantillons de dragage à diverses profondeurs de l'océan qui montrait que plus grande était la profondeur, plus faible était la biodiversité, avec des créatures généralement de plus petite taille[108]. Le géologue David Page (en) fit en outre valoir qu'avec l'augmentation de la profondeur, l'augmentation de la pression devait empêcher le développement de toute forme de vie du fait que, "selon l'expérience, l'eau à 1 000 pieds de profondeur est comprimée à 1⁄340 de son propre volume[109]".

Cette théorie n'a été réfutée qu'à la fin des années 1860[111] lorsque le biologiste Michael Sars découvrit la présence d'une vie animale à une profondeur supérieure à 300 brasses[108],[112]: 427 espèces animales ont été trouvées le long de la côte norvégienne à une profondeur de 450 brasses[111]. En 1869, Charles Wyville Thomson découvrit de la vie marine à partir d'une profondeur de 2 345 brasses (14 070 pieds ; 4 289 m)[111].

Un siècle plus tard, en 1977, la découverte des monts hydrothermaux fit faire un nouveau bond dans l'exploration de la vie marine des grands fonds océaniques avec l'observation d'espèces animales vivant dans des conditions que les biologistes avaient crues jusque-là impropres à toute vie[113],[114] (Voir Origine de la vie).

Jusque dans les années 1980, la communauté scientifique a considéré que les eaux de surface océaniques étaient dénuées de vie microbienne[115]. À la fin des années 1980, des recherches montrèrent au contraire qu'une seule goutte d'eau de ce milieu contenait 1 000 000 de microbes dont 10% sont constitués par la cyanobactérie Prochlorococcus[115], mettant au jour l'organisme photosynthétique le plus abondant du milieu océanique[116]. Parmi les autres organismes de cet écosystème microbien, Pelagibacter est un des composants du bactérioplancton presque aussi abondant que Prochlorococcus[117]. Ces deux types de microorganismes vivent en symbiose regroupés au sein de colonies riches en éléments nutritifs (carbone, phosphore, azote, soufre...)[118].

Pendant longtemps, les spécialistes de biologie marine ont considéré que les réseaux trophiques du milieu marin n'étaient constituées que de deux types d'organismes : le phytoplancton représentant les organismes autotrophes et le zooplancton représentant les organismes hétérotrophes[122]. Une troisième catégorie d'organismes était connue, les mixotrophes[Note 13], considérés comme une simple curiosité sans grande importance dans les chaines alimentaires en milieu marin[122]. Plusieurs études publiées à partir des années 1980 réfutèrent cette conception[122]. et montrèrent qu'en fait la plupart des microorganismes planctoniques sont mixotrophes[123]: répartis dans tous les milieux marins ils colonisent aussi les littoraux, des pôles jusqu'à l'équateur[122],[123].

Une série d'expériences réalisées en 1952 par Alfred Hershey et Martha Chase, démontrèrent que c'était l'ADN et non les protéines qui constituait le support de l'hérédité[124]. Linus Pauling, ainsi que James Watson et Francis Crick, de leur côté, tentèrent de déterminer la structure tridimensionnelle ou structure secondaire de cette molécule. Pauling, en collaboration avec proposa un modèle décrit par une triple hélice[125], plaçant en outre les atomes de phosphore des groupements phosphates au centre de son modèle plutôt qu'à la périphérie[126]. Crick et Watson proposèrent un modèle où se retrouvaient dans les mêmes erreurs[126]. Mais Watson et Crick élaborèrent ensuite la règle d'appariement des bases leur permettant d'affiner leur modèle de la structure de l'ADN[127],[Note 14]. Lorsque Pauling prit conscience de son échec, son attitude fut des plus honorables en reconnaissant publiquement son erreur et allant jusqu'à faire la promotion de ses deux concurrents en invitant Watson et Crick à un congrès qu'il organisa à la fin de 1953[126].

L'une des plus grosses surprises au XXe siècle dans le domaine de la zoologie fut la découverte de cœlacanthes vivants alors qu'on croyait le groupe éteint depuis la fin du Crétacé[129]. Seules deux espèces vivantes sont connues : Latimeria chalumnae et Latimeria menadoensis[130],[131] nommées en l'honneur de Marjorie Courtenay-Latimer, la conservatrice du musée sud-africain, qui a découvert le premier spécimen en 1938[132] lequel avait été repêché dans l'estuaire du fleuve Chalumna dans la province du Cap-Oriental en Afrique du Sud[133],[134]. Le cas du cœlacanthe est devenu un exemple emblématique de ce que l'on nomme un taxon Lazare[130].

Au tournant des années 2010, Gregory Erickson (en) et ses collègues réalisèrent une série d'expériences sur la biomécanique des mâchoires chez les crocodiliens qui leur permirent de conclure que les proportions rostrales ont changé substantiellement tout au long de l'évolution crocodilienne, mais pas en correspondance avec les forces de la morsure[136]. Les résultats de leurs travaux n'ont toutefois pas manqué de surprendre les spécialistes de ce domaine. Erikson écrit : « Auparavant, les spécialistes de ces animaux prédisaient des différences importantes entre les forces de morsure de diverses espèces crocodiliennes. Les animaux dotés de museaux fins, de fines dents et qui se nourrissaient de proies tendres telles que les poissons étaient supposés mordre avec des forces plus faibles, tandis que ceux munis de crânes massifs et de dents capables de broyer os et coquilles étaient censés mordre avec des forces élevées. Au lieu de cela, nous avons constaté que tous les crocodiliens peuvent mordre très fortement. Nos chiffres révèlent que les crocodiliens présentent les mêmes forces de morsure par unité de masse corporelle, indépendamment du régime alimentaire et de la grosseur du museau[137],[Note 15]. ». Erikson poursuit : « Tous les biologistes connaisseurs des crocodiliens [...] affirmaient que les alligators sauvages [...] mordaient avec une force supérieure à celle de leurs congénères en captivité [...] Au lieu de cela, nous avons découvert qu'à poids égal, ils serrent tous leurs mâchoires avec la même puissance[137]. »

Il est arrivé que les botanistes décrètent une espèce éteinte, ou à tout le moins soient convaincus de son extinction, mais que des spécimens vivants soient ensuite retrouvés (Voir Pseudo-extinction). C'est ce qui s'est produit avec l'espèce Crassula micans, une plante vasculaire[138] parmi les cinq du genre Crassula endémiques à Madagascar[139]. Elle fut récoltée par le naturaliste français Philibert Commerson[139] lors de son séjour à Madagascar[140] alors qu'il explorait les environs de Fort-Dauphin en 1770[141]. Cette plante, conservée à Paris dans l'herbier Jussieu, n'avait jamais été retrouvée depuis et les botanistes la croyaient disparue définitivement[142]. Elle fut retrouvée en 2000 sur les rives du lac Andratoloharano par Lucile Allorge-Boiteau[142],[143] (voir Flore de Madagascar).

Certains scientifiques persistent à communiquer au grand public certaines conceptions reconnues erronées concernant les capacités cognitives des animaux en dépit de l'accumulation d'expériences démontrant leur fausseté. Dans la préface d'un livre, Jane Goodall écrit : « ...un nombre incalculable de personnes (tant chez les scientifiques que chez les profanes) persistent à croire que les animaux ne sont que des objets mus par leurs réactions aux stimuli environnementaux. Mais ces gens, trop souvent, consciemment ou inconsciemment, restent sourds à toutes les tentatives que nous faisons pour les faire changer d'avis[144]. ». Le psychologue Daniel Gilbert (en), par exemple, a écrit dans son livre Stumbling on Happiness, publié en 2006, que « ...l'animal humain est le seul à penser à l'avenir et que c'est là un trait définitoire de notre humanité[145]. ». Ce à quoi, Marc Bekoff (en) répond : « On croule sous les données prouvant que des individus issus de nombreuses espèces se projettent dans l'avenir; on pense au geai du Mexique, au renard roux et au loup cachant de la nourriture pour la récupérer plus tard. Mais il y a aussi le chimpanzé subalterne et la louve feignant de ne pas voir leur nourriture favorite en présence d'un individu dominant et qui reviennent la prendre une fois l'autre parti[146]. ». Chez les corvidés, outre le geai du Mexique, le comportement du geai buissonnier (Aphelocoma californica) dans ce domaine a également fait l'objet d'études mettant en évidence le même type de comportement[147],[148],[149]. (Voir aussi Éthologie cognitive et Mise en réserve (comportement animal))

La communauté scientifique a longtemps fait de l'utilisation de l'outil l'une des caractéristiques qui définit l'espèce humaine[150]. Jusqu'aux recherches de Jane Goodall à partir de 1960 dans une région de la Tanzanie qui allait devenir en 1968 le parc national de Gombe Stream[151], selon ce qui était accepté d'emblée, seuls les humains pouvaient construire et utiliser des outils[Note 16]. En observant à plusieurs reprises des chimpanzés se nourrissant sur une termitière, soit en plaçant des brins d'herbe dans les trous de la termitière soit en utilisant des brindilles en enlevant les feuilles pour la rendre plus efficace, Goudall observa ainsi dans ce dernier cas une forme de modification d'objet qui constitue le début rudimentaire de la fabrication d'outils[153],[Note 17]

De même, les éthologistes croyaient les chimpanzés exclusivement végétariens jusqu'à ce que Goodall les observe chasser et manger de petits mammifères[152]. Les primatologues croyaient également à tort que les chimpanzés n'usaient pas de violence envers leurs congénères : les travaux de Goodall prouveront que certains individus tuent parfois les membres d'autres groupes de chimpanzés[155].

Bien que l'étude des chevaux dans leur milieu naturel n'ait pris son essor qu'à partir des années 1970[156],[157], le comportement des chevaux a fait l'objet d'études dès le moment où l'idée de travailler en sympathie avec un cheval pour obtenir sa coopération s'est peu à peu développée[Note 18].

Le cas de Hans le Malin, survenu au début du XXe siècle, est un exemple d'une compréhension erronée du comportement du cheval[Note 19]. Cet étalon noir nommé « Hans » semblait pouvoir « … additionner, soustraire, multiplier, diviser [de même que] épeler, lire, et résoudre des problèmes d’harmonie musicale » lorsqu'on l'interrogeait[160]. En 1904, une première commission, comportant des scientifiques, étudia les prestations du cheval partant du principe qu'il pouvait s'agir soit d'une fraude soit d'un dressage comme pour les animaux de cirque : elle ne put conclure à aucune de ces possibilités[161]. Le psychologue Oskar Pfungst résolut le mystère et fit faire du même coup des progrès à la méthodologie dans ce champ d'investigation en procédant à des tests en double aveugle[160]. Il découvrit que le cheval ne répondait correctement que lorsque les examinateurs connaissaient la réponse[Note 20]. À l'issue de cette nouvelle enquête, il mit ainsi en évidence deux phénomènes :

L'une des erreurs dont la jeune science de la chimie eut à se libérer fut la théorie du phlogistique initialement conçue par Johann Joachim Becher et développée par le médecin et chimiste allemand, Georg Ernst Stahl. Ainsi Stahl dans son traité Fondement de la chimie[164] publié en 1723 jetait les bases de l'approche scientifique de la chimie en proposant un but et une méthode : réduire les corps composés en leurs éléments et étudier leur recomposition. Il propose dans ce traité l'idée du phlogistique, un fluide expliquant les phénomènes de combustion et lié à l'élément "feu". Bien qu'erronée, cette théorie proposait alors un premier principe unificateur fournissant une explication à divers phénomènes (combustion, calcination, respiration...)[165].

Antoine Lavoisier, dont les travaux ont fait énormément progresser la chimie, a commis certaines erreurs, lui aussi.

Lavoisier reprit à son compte la théorie du calorique proposée par le chimiste écossais Joseph Black selon laquelle la chaleur est un fluide. En l'absence du concept d'énergie, il conçut la lumière et la chaleur comme étant de la matière, et les classa parmi les éléments chimiques.

Lavoisier donne une définition d'un corps simple : le « dernier terme auquel parvient l'analyse [chimique] », autrement dit une substance qui ne peut plus être décomposée[166] qui correspond à la notion moderne d'élément chimique. Mais plusieurs substances de sa liste de trente-trois éléments chimiques simples étaient en réalité des oxydes[166] qui sont des composés chimiques[Note 21]. On y retrouvait entre autres la soude et la potasse[168]

Lavoisier élabora également une théorie des acides selon laquelle l'une des propriétés de l'oxygène est d'entrer dans la composition d'un acide. Cette conception fut invalidée lorsqu'on retrouva cet élément dans diverses substances basiques. Lavoisier considérait par exemple le chlore comme un acide encore plus oxygéné que l'acide chlorhydrique et non comme un corps simple[168].

En 1869, année de la parution du système périodique de Mendeleïev, seulement les deux tiers des éléments avaient été découverts et certains de ces éléments occupèrent pendant de nombreuses années des cases placées au mauvais endroits[169].

Dmitri Mendeleïev rencontra des difficultés avec le groupe des lanthanides, particulièrement ceux qui suivent le cérium. Plusieurs de ces éléments nouveaux qui étaient en fait une combinaison d'éléments connus est l'une des raisons qui ont conduit le chimiste russe à les placer au mauvais endroit dans la classification[169].

Le chimiste britannique William Odling est aussi l'un des scientifiques à avoir contribué à donner naissance à un arrangement systématique des éléments chimiques[170]. En dépit de certains résultats justes auxquels il aboutit, Odling a commis l'erreur de penser que toutes les périodes du tableau périodique comptaient huit éléments[170],[Note 22].

Divers éléments du tableau périodique firent l'objet d'erreurs d'identification ou de classification. Certaines de ces erreurs survenues dans l'identification des éléments chimiques sont dues au fait que les chercheurs impliqués pensaient avoir découvert un nouvel élément qui avait déjà été découvert alors que d'autres sont dues au fait que des chimistes pensaient avoir isolé un élément pur alors qu'il s'agissait en fait d'un composé chimique.

En 1812, Thomas Thomson pense avoir découvert un nouvel élément qu'il baptise "junonium"[171] alors qu'il s'agit du cérium[172] découvert en 1803[173].

En 1841, Carl Gustaf Mosander annonce avoir découvert dans une substance minérale qu'il appelle "lanthana" un nouvel élément qu'il nomme didyme alors que Carl Auer von Welsbach démontrera en 1885 que cette substance est en fait composée de deux éléments : le praséodyme et le néodyme[174],[175].

En 1844, Heinrich Rose annonce avoir découvert deux nouveaux éléments dans la colombite. Le minéralogiste et chimiste allemand les nomme pélopium et niobium[176] en référence à Pélops et Niobé, le fils et la fille de Tantale[175]. Rose a cru avoir identifié deux nouveaux éléments là où, en réalité, il s'est avéré n'en avoir qu'un seul[175].

En 1851, Carl Bergmann annonça la découverte d'un nouveau métal dans de l'orangite, une variété minérale de thorite. Il baptisa ce métal "donarium"[177] qui s'est avéré être par la suite du thorium[175] découvert en 1829[178].

En 1862, Jön Fridrik Bahr publia l'article On a New Metal Oxide dans lequel il nomme "wasium" le nouveau métal qu'il affirme avoir découvert[175],[179]. Moins d'un an plus tard, ses conclusions sont attaquées par Jérôme Nicklès (1820-1869)[179]. Bahr reconnaîtra son erreur tout en corrigeant lui-même l'erreur de Nicklès qui affirmait que le wasium était plutôt un mélange de divers éléments connus : l'yttrium, le terbium et le didyme. Bahr établira finalement qu'il s'agit en fait de thorium[179].

En 1864, l'astronome britannique William Huggins annonce avoir découvert un nouvel élément inconnu sur Terre, grâce à une étude spectroscopique de la lumière émise par certaines nébuleuses planétaires et qu'il nomme pour cette raison, nébulium[180]. Ce n'est qu'en 1927 que l'astronome américain Ira Sprague Bowen démontrera que les raies des spectres observées par Huggins sont en fait celles de l'oxygène doublement ionisé[181].

En 1869, Charles Augustus Young commet une erreur similaire à celle de Huggins lorsqu'il affirme avoir détecter un nouvel élément dans la couronne solaire durant l'éclipse solaire du et qu'il baptise coronium. Bengt Edlén montra en 1943 que les raies spectrales provenaient du fer, ionisé treize fois (Fe13+) soumis à une température extrêmement élevée[182],[Note 23].

En 1878, le chimiste suisse Marc Delafontaine annonce avoir découvert deux nouveaux éléments qu'il nomme "philippium" et "décipium"[184] tandis que le chimiste américain John Lawrence Smith fait savoir qu'il a découvert, lui aussi cette année-là, un nouvel élément qu'il nomme "mosandrum" dans de la samarskite de la Caroline du Nord[185]. Le mosandrum de Smith s'avérera être du terbium qui fut découvert en 1843 par Carl Gustaf Mosander[186] alors que le philippium et le décipium de Delafontaine seront identifiés par la suite comme étant respectivement de l'holmium et du samarium (plus exactement un mélange de samarium et de terres rares dans le cas du décipium[187]),[Note 24].

En 1907, Georges Urbain[189], Carl Auer von Welsbach[190] et Charles James[190]découvrent indépendamment les uns des autres que l'élément ytterbium, découvert par le chimiste suisse Jean Charles Galissard de Marignac, en 1878[191], à partir de l'ytterbine, n'est pas pur et constitue en fait un mélange de deux éléments[190]. Après une controverse opposant Urbain et von Welbach, c'est finalement la dénomination du chimiste français qui l'emporte pour la mise en évidence du nouvel élément qui porte le nom de lutécium (également orthographié lutétium)[192].

En 1917, Konstantin Avtonomovich Nenadkevich (ru) pensa avoir isolé l'élément 72 à partir d'orthite, un minéral qui contient une quantité significative d'éléments du groupe des terres rares. D'autres recherches n'ont malheureusement pu confirmer la présence de cet élément dans ce minéral[193]. Dix ans plus tôt, Georges Urbain annonce avoir identifié ce même élément et le nomme celtium. En mai 1922, Georges Urbain, en collaboration avec Alexandre Dauvillier, annoncent avoir clairement identifié l'élément 72 à l'aide d'analyses spectroscopiques. Toutefois, Urbain classe cet élément parmi les terres rares alors que Niels Bohr prédit qu'il doit plutôt faire partie du groupe des métaux de transition au même titre que le zirconium. D'autres travaux expérimentaux auront été nécessaires, dont ceux de George de Hevesy et Dirk Coster, réalisés à Copenhague en 1923, pour établir que, tout comme le zirconium, le hafnium est un métal de transition[194],[195].

En 1926, la découverte de l'élément de numéro atomique 61 à partir de cristallisations fractionnées de dérivées de sable de monazite est annoncée par deux groupes distincts de chimistes. Le premier, affilié à l'université d'Illinois et mené par B. Smith Hopkins, adopte le nom illinium (de symbole Il) quand le second, de l'Istituto di Studi Pratici e di Perfezionament (université de Florence) et mené par Luigi Rolla propose le nom florentium (de symbole Fr). Une controverse concernant l'attribution de la découverte de l'élément émerge dans un contexte de tensions entre les États-Unis et l'Italie. Cependant, Walter Noddack et Ida Tacke, étant incapables d'identifier l'élément 61 au sein de minéraux où il est attendu, suggèrent qu'il pourrait ne pas posséder d'isotope suffisamment stable pour être présent dans le milieu naturel. La formulation de la loi de Mattauch (en) renforce cette idée. Les découvertes de l'illinium et du florentium sont consécutivement rétractées. L'élément 61 est isolé par Jacob A. Marinsky, Lawrence E. Glendenin (en) et Charles D. Coryell en 1945 [Note 25], parmi les produits de fission de l'uranium. Le groupe adopte le nom prométhéum (de symbole Pm), modifié plus tard en prométhium (le symbole est inchangé). Finalement, l'élément est identifié dans la nature en 1968, dans de la pechblende d'Oklo, grâce à l'évolution des techniques d'analyse[197].

De nombreuses erreurs ont été commises en criminalistique notamment en ce qui concerne les résultats d'analyses d'ADN. Le travail de contre-expertise de Brandon L. Garrett, professeur à l’école de droit de l'université de Virginie (en), et Peter Neufeld (en), cofondateur de l’Innocence Project, a permis, d’innocenter 261 personnes qui avaient été condamnées. Les experts avaient conclu que l'analyse de leur ADN correspondait à celui recueilli sur les lieux de crimes commis. Garrett et Neufeld purent démontrer que leur ADN ne correspondait pas à celui du véritable coupable (« plus de la moitié d’entre eux avaient pourtant été, notamment, condamnés sur la foi de preuves apportées par la police scientifique et technique qui, par la suite, se sont en fait avérées erronées »). « Sur les 137 cas qu’ils ont analysés, en 2009, pour leur étude qu’ils ont consacrée aux erreurs des “experts” de la police scientifique et technique, Garrett et Neufeld ont découvert 11 erreurs judiciaires imputables, en partie, à une mauvaise interprétation ou exploitation de "la preuve par l’ADN"[198]. »

Ces divergences d’expertises ne sont pas très étonnantes selon Raphaël Coquoz, chargé de cours à l’École des sciences criminelles de l’université de Lausanne et spécialiste de l’ADN:

« Un profil ADN n’est pas quelque chose d’univoque. [...] L’analyse ADN donne une probabilité que telle ou telle personne ait été présente à un endroit. Le concept de probabilité est parfois difficile à entendre quand on aimerait voir les choses en blanc ou en noir. En présence d’un profil “faible”, lorsque les traces sont infimes ou mélangées, la probabilité diminue. Lorsque le profil est de bonne qualité, les certitudes sont élevées, mais on n’est jamais sûr à 100%. L’ADN n’est qu’un outil parmi d’autres, qui peut mener à des erreurs judiciaires[198]. »

L'archéologie offre un exemple d'erreurs rencontrées lors de l'émergence d'une nouvelle discipline scientifique[Note 26]. À la même époque que Giuseppe Fiorelli, qui dirigea apparemment les premiers travaux méthodiques de fouilles archéologiques en Italie[199], Heinrich Schliemann entreprit des fouilles sur la colline d'Hissarlik située à l'entrée du détroit des Dardanelles, dans la province turque de Çanakkale, dans une région qui s'appelait autrefois la Troade. Schliemann, qui avait été précédé sur ce site par le diplomate et archéologue amateur Frank Calvert, entreprit de fouiller ce site à partir de 1870[200]. Bien que les travaux sur le site de Hissarlik, qu'il fit considérablement avancer, firent progresser les connaissances de la région de l'époque préhomérique — époque dont les évènements se sont déroulés durant l'Helladique (de 3000 à 1000 av. J.-C.) et les siècles obscurs (du XIIe au VIIIe siècle av. J.-C.) — les méthodes de fouilles de Schliemann étaient différentes de celles de Fiorelli pour ne pas dire à l'opposé. Elles évoluèrent avec l'arrivée de Wilhelm Dörpfeld en 1882[201],[Note 27]. Sur le plan strictement scientifique, la principale erreur de Schliemann fut de situer l'époque concernant le récit homérique de la guerre de Troie, soit les 12e, 13e voire 14e siècle av. J.-C. (voir Guerre de Troie (datation)), dans le mauvais niveau du site. Schliemann était convaincu que cette période se trouvait localisée dans le niveau II. Ce niveau « ...contenait les murs d'une fortification détruite par un incendie et de spectaculaires objets d'or, que Schliemann nomma le « trésor de Priam »[203], Priam étant le roi de Troie dans le récit homérique de l'Iliade[202]. ». Wilhelm Dörpfeld aurait été le premier à constater l'erreur de Schliemann et de concevoir que l'époque en question se trouvait plutôt située au niveau VI ou VII, indépendamment de la cité antique dont l'identification restait à confirmer[Note 28].

Dans le domaine de l'archéologie, une autre des erreurs notables a porté sur la localisation de l'antique cité de Pi-Ramsès que les archéologues Flinders Petrie dans les années 1880 et Pierre Montet dans les années 1930 ont cru avoir retrouvée sur le site de Tanis[205],[206]. En dépit de statues de Ramsès II et d'inscriptions y faisant référence les ayant induit en erreur, les travaux de l'archéologue et égyptologue autrichien Manfred Bietak montrèrent que Qantir était le lieu où avait été édifiée la ville de Pi-Ramsès[207]. (Des hésitations demeureraient sur sa localisation précise. Il semblerait en fait que cette ville portuaire, dont la superficie aurait été estimée à 18 km2, soit correspondrait à l’actuelle Tell el-Dab'a, Qantir et Kathana, soit aurait été située entre ces trois sites[208],[209].)

Avant la découverte de la radioactivité, diverses procédures furent imaginées par les scientifiques pour tenter d'obtenir une estimation de l'âge de la Terre. D'abord un débat qui ne prendra véritablement naissance sur le plan scientifique qu'au XVIIIe siècle avec Buffon et Halley[210], ce débat finira par devenir une véritable controverse à partir des années 1860[211]. C'est à cette époque que physiciens, géologues et naturalistes aboutirent à des estimations inconciliables pour l'âge de notre planète. Charles Darwin, avec sa théorie de la sélection naturelle, avait besoin de concevoir que la Terre avait au moins quelques centaines de millions d'années[Note 29]. Les géologues, à l'instar de Darwin, optaient pour une échelle des temps géologiques d'une durée comparable[211].

Le physicien William Thomson, quant à lui, était d'un tout autre avis. Thomson fit appel à la thermodynamique pour établir une estimation située dans une fourchette de 20-400 millions d’années en 1862, puis, en 1897[210], il aboutit à un âge avoisinant les 20 à 40 millions d’années[210].

En 1895, John Perry, qui fut l'un des assistants de Thomson à l'université de Glasgow, contesta l'hypothèse de ce dernier sur la faible conductivité thermique à l'intérieur de la Terre à partir du même gradient de température et, par voie de conséquence, ses estimations. Son modèle le conduisit plutôt à suggérer un âge de 2 milliards d’années[210],[212].

En 1904, lors d'une conférence à la Royal Institution de Londres, en présence de Thomson lui-même, Ernest Rutherford montre que les calculs du physicien s'appuient sur une hypothèse fausse en présupposant l'absence d'une source de chaleur à l'intérieur de la Terre[211]. Dès novembre 1905, Bertram Boltwood put dater, grâce à sa méthode de datation radiométrique, l'âge de plusieurs minerais entre 92 et 570 millions d'années[211]. Quelques années plus tard, Boltwood, obtint comme valeurs des âges de plus de 1,6 milliard d'années pour la datation de certaines roches[211]. Et, en 1956, Clair Patterson, parvint à estimer l'âge de notre planète à 4,55 milliards d'années grâce à la méthode de datation par l'uranium-plomb qu'il développa[213],[214].

Des erreurs de raisonnement dans les sciences empiriques sont également présentes. De nombreuses erreurs dans l'histoire des sciences ont consisté à maintes reprises à proclamer l'impossibilité d'un phénomène dont les raisonnements ont été réfutés par la suite. Ainsi, à la suite des travaux d'Alfred Wegener, le mathématicien et géophysicien britannique Harold Jeffreys était convaincu d'avoir prouvé, chiffres à l'appui, que la Terre était trop rigide pour que la dérive des continents fut possible[215],[216].

L'une des erreurs de Galilée fut de proposer une explication erronée au phénomène des marées. Galilée rejetait l'explication, admise à son époque, selon laquelle la Lune est responsable de ce phénomène. Le savant italien traite de ce sujet dans un ouvrage qui s'était intitulé à l'origine Dialogue sur les marées[217] et qui sera finalement connu sous le titre Dialogue sur les deux grands systèmes du monde. Selon lui, le flux et le reflux de la mer était attribuable uniquement aux mouvements annuels et diurnes de la Terre[218],[Note 30].

La météorologie est un domaine, parmi d'autres, très sensible aux erreurs. Les météorologues se doivent de fournir une image suffisamment précise de l'état de l'atmosphère lors de la modélisation sans quoi les erreurs introduites au début se propageront et iront en s'amplifiant[220].

Les modèles informatiques doivent intégrer des connaissances sur de nombreux phénomènes interagissant entre eux: vitesse et direction des vents; transformation de la chaleur reçue du Soleil par les océans, le sol, l'air, et les nuages; condensation de la vapeur d'eau en nuages et transformation des gouttelettes d'eau en pluie, en glace, ou en neige et mélange de l'air près du sol, entre autres phénomènes. Les erreurs commises dans la prévision d'un de ces phénomènes peuvent se propager à la prévision des autres, ou peuvent amplifier les erreurs d'autres sous-systèmes du modèle[220]. Les spécialistes doivent donc s’assurer que le niveau d’erreur reste stable au cours de la simulation[221].

Pour certaines modélisations, les erreurs peuvent croître très rapidement si certaines conditions ne sont pas respectées telle la contrainte classique de stabilité, connue sous le nom de condition de Courant-Friedrich-Lewy ou condition CFL[222] qui « ...spécifie que le vent dans une maille ne doit pas transporter l’air présent dans cette maille de plus de la taille d’une maille en un pas de temps. Si cette condition n’est pas vérifiée dans un schéma, l’erreur grossit jusqu'à atteindre des nombres infiniment grands, le schéma devient instable, on dit que le modèle explose[221]. »

L'une des erreurs d'Isaac Newton se trouve dans son traité d'optique intitulé Opticks : or a Treatise of the Reflexions, Refractions Inflexions and Colours of Light. Dans la septième proposition de la première partie du livre premier, Newton mentionne que la lumière des étoiles nous apparaît ponctuelle. Il écrit : « Or que la distance incommensurable des étoiles fixes les fasse paraître comme autant de points, c'est ce qu'on peut inférer de ce qu'étant éclipsées par la Lune, elles ne disparaissent et ne reparaissent point par degré comme le font les planètes mais instantanément ou presque instantanément car la réfraction de l'atmosphère de la Lune prolonge un peu la durée de leur disparition et réapparition[223]. ». La Lune étant pratiquement dénuée d'atmosphère, l'explication proposée par Newton est incorrecte[Note 31].

Il arrive qu'un chercheur ou un savant fasse des erreurs et que celles-ci se compensent pour donner le bon résultat! L'un des exemples les plus édifiants à ce sujet est sans doute la démarche qu'a suivie Kepler pour parvenir à la découverte de ses deux premières lois. Pour ce faire, Kepler a commis non pas une mais trois erreurs. Ce cas est suffisamment inusité pour qu'il vaille la peine de citer Arthur Koestler qui le détaille. Kepler découvre d'abord le rapport inverse des vitesses d'une planète aux points extrêmes de son orbite (le périhélie et l'aphélie). Toutefois... « en étendant [cette relation] à l'orbite toute entière il faisait une généralisation parfaitement injustifiée. Kepler le savait et l'admit... [Ensuite pour faciliter ses calculs, voici ce qu'il écrit dans son Astronomia nova] : « Sachant qu'il y a un nombre infini de points sur l'orbite et un nombre infini de distances il me vint l'idée que la somme de ces distances est contenue dans l'aire de l'orbite. » C'est sa deuxième erreur car, comme le rappelle Koestler, « il n'est pas permis d'égaler une aire à la somme infinie de lignes [se trouvant à l'intérieur de celle-ci]. Et à nouveau, Kepler le sait et il explique même pourquoi ce n'est pas permis! Il ajouta qu'il avait fait une erreur en considérant une orbite comme circulaire. En concluant : « Mais ces deux erreurs — c'est comme un miracle — s'annulent [...] comme je le prouverai ci-dessous »[226]. Le résultat est encore plus miraculeux que ne le croyait Kepler car en expliquant pourquoi ses erreurs s'annulent il se trompa une fois de plus [...] Or par trois méthodes fausses défendues de façon encore plus fausse, il tomba sur la loi juste[227]. » Ses trois suppositions fausses étaient :

De même, des contradictions peuvent se glisser dans un ouvrage de vulgarisation écrit par un savant. Galilée lui-même n'en a pas été exempt. Ainsi, dans son ouvrage Dialogue sur les deux grands systèmes du monde, il tente d'expliquer pourquoi il ne serait pas possible à un corps céleste tel le Soleil de se déplacer autour d'un autre tout en maintenant son axe de rotation parallèle à lui-même alors que plus loin, dans le même ouvrage, Galilée explique que la Terre se déplace de cette façon[228].

La trépidation des équinoxes (en) est une théorie selon laquelle à une oscillation accompagne le mouvement de précession des équinoxes. Les premières traces de cette théorie se retrouvent dans un écrit de Théon d'Alexandrie du IVe siècle de notre ère : Petit commentaire sur les tables pratiques de Ptolémée. L'auteur y mentionne que d'après certains astronomes anciens, la précession des équinoxes, plutôt que d'être un mouvement constant et sans fin, inverse sa direction tous les 640 ans[229],[230]. Les équinoxes, dans cette théorie, se déplacent à travers l'écliptique au rythme de 1 degré en 80 ans jusqu'à atteindre 8 degrés, après quoi ils inversent soudainement la direction de leur mouvement et reviennent à leur position d'origine.

Au IXe siècle, la description de ce mouvement est reprise avec les travaux de l'astronome arabe Thābit ibn Qurra dans son ouvrage De motu octavae sphaerae (Sur le mouvement des huit sphères)[231]. Selon lui, l'écliptique était affecté d'un mouvement d'oscillation décrivant un cercle d'une amplitude de 8° avec une périodicité de 4 000 ans[232]. Pendant le Moyen Âge et jusqu'à la fin du XVIe siècle, la précision des tables astronomiques fut affectée en tenant compte de ce mouvement d'oscillation[232]. L'astronome andalou Al-Zarqali, entre autres, pris en compte ce mouvement dans l'établissement des tables de Tolède[233]. Il fallut attendre la précision des observations de Tycho Brahe pour que les astronomes réalisent que ce mouvement n'existe pas[232].

En 1750, l'astronome anglais Thomas Wright émit l'idée que les étoiles de la Voie lactée seraient maintenues ensemble par des forces gravitationnelles et constituer un ensemble en rotation semblable au système solaire mais à une échelle beaucoup plus grande[234],[235]. Dans un traité paru en 1755, Emmanuel Kant développe cette idée et va jusqu'à suggérer que certaines nébuleuses sont aussi vastes que la Voie lactée et constituent elles aussi des "univers-îles", ce qu'on nommera plus tard des galaxies[236].

Il faudra attendre le XXe siècle pour que ces idées soient acceptées. Certaines observations s'y sont opposées dont celles de Heber Curtis et d'Adriaan van Maanen. En se basant sur les vitesses radiales de certaines galaxies mesurées par Vesto Slipher, Curtis en avait déduit qu'elles se situaient à environ 3 000 parsecs, les situant ainsi à l'intérieur de la Voie lactée. Van Maanen, quant à lui, travailla pendant plus de dix ans à déterminer la période de rotation de certaines galaxies spirales : la période moyenne qu'il obtint était de l'ordre de 85 000 ans ce qui aurait donné une vitesse de rotation inconcevable si elles avaient été situées à l'extérieur de la Voie lactée[237]. Il s'avéra plus tard admettre que les résultats de Curtis et de van Maanen n'étaient pas valables[237]. Curtis admit son erreur et devint même un fervent défenseur de la thèse extragalactique[238]. En 1922, John Charles Duncan découvrit des étoiles variables dans M31 (la galaxie d'Andromède) : onze des quinze étoiles étaient des céphéides. Utilisant ces données, Edwin Hubble put calculer la distance de M31 et M33 à environ 250 000 parsecs. La localisation extragalactique de ces nébuleuses était ainsi clairement établie[237].

Les travaux de Harlow Shapley à l'observatoire du Mont Wilson à partir de 1914 ont permis de corriger une erreur en localisant le système solaire à une certaine distance du centre de notre galaxie. Des travaux antérieurs basés sur des techniques de comptage d'étoiles indiquaient faussement que le Soleil se trouvait au centre de la Voie lactée[239].

Il n'est pas rare que les astronomes doivent réviser leurs estimations concernant la trajectoire d'astéroïdes qu'ils observent et leur probabilité d'impact avec la Terre : « ...la raison [...] est que la détermination de l'orbite est basée sur des mesures erronées dues à l'atmosphère terrestre et d'autres facteurs (voir, entre autres, Effet YORP, Effet Yarkovsky et Sensibilité aux conditions initiales). Cela limite la mesure de la position de l'astéroïde et se combine avec toutes les autres erreurs de mesure pour créer l'espace d'incertitude original[240]. » Ces erreurs se combinent avec celles provoquées par des données d'observation insuffisantes lorsqu'un nouvel astéroïde est détecté : deux ou trois semaines d'observations ne suffisent souvent pas pour déterminer de façon concluante la trajectoire d'un astéroïde observé pour la première fois[240]. À titre d'exemple, il faut deux à quatre ans de suivi pour un astéroïde avec une période orbitale de 2,29 ans pour prédire suffisamment précisément son orbite sur quelques décennies[240]. En juillet 2002, un risque de facteur d'impact positif sur l'échelle de Palerme avec la Terre impliquant l'astéroïde (89959) 2002 NT7 a alerté les médias[241]: les révisions de ses paramètres orbitaux permirent d'écarter tout risque de collision[242].

Albert Einstein publie sa formulation de la relativité générale dans l'édition du des Comptes rendus de l'Académie des sciences de Prusse. Presque aussitôt, Karl Schwarzschild en prend connaissance, calcule, à partir de la nouvelle équation d'Einstein, la courbure de l'espace-temps pour une étoile sphérique sans mouvement de rotation et transmet ses résultats à Einstein[243]. D'après Shwarzschild, lorsque l'étoile poursuit son effondrement, une singularité apparaît à une certaine distance de l'étoile, dite rayon de Schwarzschild. La plupart des physiciens, y compris Einstein, pensent alors que la géométrie de l'espace-temps devient singulière à cet endroit. Or les études ultérieurs montrèrent que cette singularité n'apparait que dans le système de coordonnées stationnaires employé par Schwarzschild[244]. En 1921, Paul Painlevé soutient qu'il est possible de prolonger cette solution à travers cette région jusqu'à la singularité réelle située au centre[245]. En 1932, Georges Lemaître démontre explicitement que de la matière en chute libre peut franchir ce rayon sans rencontrer de singularité[246] et, en 1958, David Finkelstein propose une description simple de ce phénomène[247].

Nombreux sont les modèles cosmologiques qui ont été proposés depuis le début de l'astronomie moderne. Ceux proposés avant le XXe siècle ne tiennent évidemment pas compte du mouvement de fuite des galaxies conduisant à l'idée d'expansion de l'Univers. Au XXe siècle apparut une multitude de modèles pour décrire l'évolution de notre univers. Certains de ces modèles ont pu être écartés tels par exemple le modèle d'univers statique d'Einstein de 1917, le modèle d'Univers de Milne ou encore celui de la théorie de l'état stationnaire présentée par Fred Hoyle, Thomas Gold et Hermann Bondi.

Lorsque Edwin Hubble établit la valeur de la relation entre la distance et la vitesse de récession apparente des galaxies dans l'univers observable, il obtint comme résultat une valeur avoisinant les 500 km/s/Mpc ou environ 160 km/s par million d'années-lumière pour ce taux d'expansion, maintenant appelé la constante de Hubble. Ceci impliquait un âge de l'Univers de deux milliards d'années. Or, la datation radiométrique des roches démontra, dans les années 1930, que l'âge de la Terre était d'au moins trois milliards d'années[248]. Des études ultérieures montrèrent que l'erreur venait non pas de la théorie de Hubble, mais de l'imprécision et de l'interprétation des observations qu'il avait faites. Ainsi, par exemple, ce que Hubble avait cru être des étoiles individuelles très distantes étaient en fait des amas d'étoiles : il pensait, à tort, avoir observé des chandelles standards, objets dont la luminosité absolue ne varie pas avec la distance[248]. Au XXIe siècle, des mesures de plus en plus précises de la constante de Hubble donnent des valeurs comprises entre 69,8 et 76,5 km/s/Mpc[Note 32].

L'un des exemples notoire dans l'histoire des sciences concerne l'erreur d'Aristote qui affirmait que la vitesse d'un corps en chute libre est proportionnelle à son poids. Il faudra attendre le VIe siècle pour que Jean Philopon conteste cette relation liant vitesse de chute et poids[249]. Dans un commentaire de la Physique d'Aristote publié en 1545, Domingo de Soto décrira explicitement le mouvement de chute libre comme un mouvement uniformément accéléré[250].

Sur le même sujet, Galilée commettra une erreur, puis la rectifiera lui-même. Dans sa formulation de la loi de la chute des corps en 1604, il affirme que la vitesse d'un corps en chute libre croit proportionnellement à l'espace parcouru. En 1632 qu'il rectifie cette formulation erronée et montre que la vitesse d'un corps en chute libre croit proportionnellement au temps de chute[251],[252].