Intelixencia artificial

intelixencia exhibida por artefactos creados por humanos From Wikipedia, the free encyclopedia

Remove ads

Defínese a intelixencia artificial (IA) como aquela intelixencia exhibida por artefactos creados por humanos (é dicir, artificial). A miúdo aplícase hipoteticamente aos computadores. O nome tamén se usa para se referir ao campo da investigación científica que intenta acercarse á creación de tales sistemas.

Debido á multiplicidade de pais que tivo a intelixencia artificial, non hai un consenso para definir ese concepto, mais podemos dicir que a intelixencia artificial encárgase de modelar a intelixencia humana en sistemas computacionais.

Pode dicirse que a intelixencia artificial é unha das áreas máis fascinantes e con máis retos das ciencias da computación, na súa área de ciencias cognoscitivas. Naceu como mero estudo filosófico e razonístico da intelixencia humana, mesturada coa inquietude da humanidade por imitar a natureza circundante (como voar e nadar), ata inclusive querer imitarse a si mesma. En resumo, a intelixencia artificial procura imitar a intelixencia humana. Obviamente non o logrou aínda, ao menos non completamente.

Existen cinco puntos de vista principais sobre estes sistemas:

- Os que pensan como humanos.

- Os que actúan como humanos.

- Os que pensan racionalmente.

- Os que actúan racionalmente.

- Os que senten como humanos.

Remove ads

Historia da intelixencia artificial

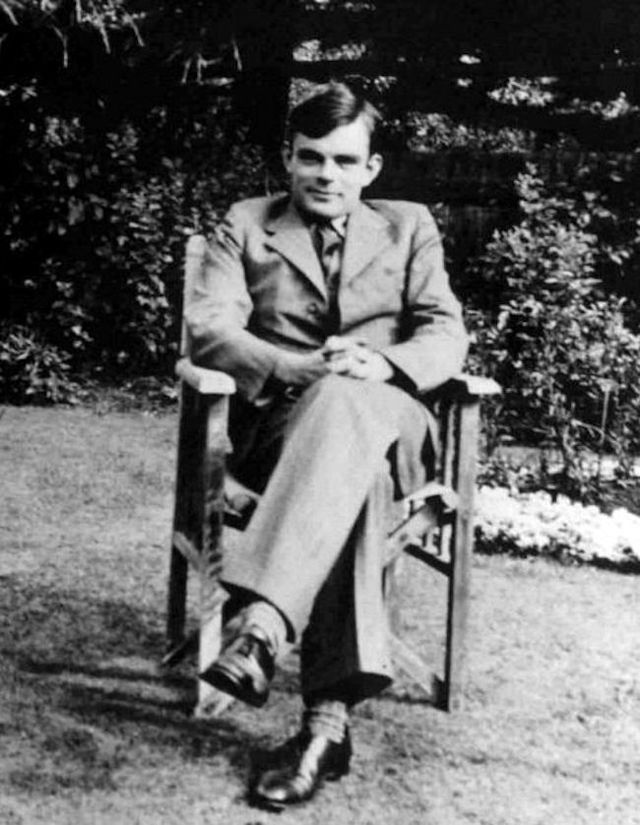

En 1937, o matemático inglés Alan Mathison Turing (1912-1953) publicou un artigo de bastante repercusión sobre os "Números Calculábeis", que pode considerarse a orixe oficial da informática teórica.

Turing, neste artigo, presentou a Máquina de Turing, unha entidade matemática abstracta que formalizou o concepto de algoritmo e resultou ser a precursora das computadoras dixitais. Coa axuda da súa máquina, Turing puido demostrar que existen problemas irresolúbeis, dos que ningún computador será capaz de obter a súa solución, polo que a Alan Turing considérase o pai da teoría da computabilidade.

Tamén se considera o pai da intelixencia artificial, pola súa famosa Proba de Turing, que permitiría comprobar se un programa de computador pode ser tan intelixente como un ser humano.

A historia da intelixencia artificial pasou por diversas situacións:

- O termo inventouse en 1956, nun congreso no que se fixeron previsións triunfalistas a dez anos que nunca se cumpriron, o que provocou o abandono case total das investigacións perante quince anos.

- En 1980 a historia repetiuse co desafío xaponés da quinta xeración, que deu lugar ao auxe dos sistemas expertos, mais que non alcanzou moitos dos seus obxectivos, polo que este campo sufriu unha nova detención nos anos noventa.

- Na actualidade estamos tan lonxe de cumprir a famosa proba de Turing como cando se formulou: Existirá intelixencia artificial cando non sexamos capaces de distinguir entre un ser humano e un programa de computadora nunha conversación ás cegas.

- Como anécdota, moitos dos investigadores sobre IA sosteñen que "a intelixencia é un programa capaz de ser executado independentemente da máquina que o execute, computador ou cerebro".[1]

- A idea de algo parecido á intelixencia artificial existe desde hai millóns de anos. O primeiro home primitivo que tomou conciencia da súa propia existencia, e de que era capaz de pensar, seguramente se pregunta como funcionaria o seu pensamento e posteriormente chegaría á idea dun "creador superior". Polo tanto, a idea de que un ser intelixente cre a outro, a idea dun deseño virtual para a intelixencia, é tan remota como a toma de conciencia do ser humano.

- Os xogos matemáticos antigos, como o da torres de hanoi (aprox 3000ac), demostran o interese na procura dun bucle resolutivo, unha IA capaz de gañar nos mínimos movementos posíbeis.

- En 1903 Lee De Forest inventa o tríodo (tamén chamados bulbo ou válvula de baldeiro). Podería dicirse que a primeira gran máquina intelixente deseñada polo ser humano foi o computador ENIAC, composto por 18.000 válvulas de baldeiro, tendo en conta que o concepto de "intelixencia" é un termo subxectivo que depende da intelixencia e a tecnoloxía que teñamos nesa época. Un indíxena do amazonas no século 20 podería cualificar de intelixente un tocadiscos, cando en verdade non o é tanto. Este computador foi programado polas Top Secret Rosies, un grupo de mulleres que foron contratadas polo exército estadounidense para este fin.[2]

- En 1937, o matemático inglés Alan Mathison Turing (1912-1953) publicou un artigo de bastante repercusión sobre os "Números Calculábeis", que pode considerarse a orixe oficial da Informática Teórica.

Neste artigo, introduciu a Máquina de Turing, unha entidade matemática abstracta que formalizou o concepto de algoritmo e resultou ser a precursora das computadoras dixitais. Con axuda da súa máquina, Turing puido demostrar que existen problemas irresolúbeis, dos que ningún computador será capaz de obter a súa solución, polo que a Alan Turing considérase o pai da teoría da computabilidade.

Tamén se considera o pai da intelixencia artificial, pola súa famosa Proba de Turing, que permitiría comprobar se un programa de computador pode ser tan intelixente como un ser humano.

- En 1951 William Shockley inventa o transistor de unión. O invento do transistor fixo posíbel unha nova xeración de computadoras moito máis rápidas e pequenas.

- En 1956, cuñouse o termo "intelixencia artificial" en Dartmouth durante unha conferencia convocada por McCarthy, á cal asistiron, entre outros, Minsky, Newell e Simon. Nesta conferencia fixéronse previsións triunfalistas a dez anos que nunca se cumpriron, o que provocou o abandono case total das investigacións durante quince anos.

- En 1980 a historia repítese co desafío xaponés da quinta xeración, que deu lugar ao auxe dos sistemas expertos, mais que non alcanzou moitos dos seus obxectivos, polo que este campo sufriu unha nova detención nos anos noventa.

- En 1987 Martín Fischles e Oscar Firschein describiron os atributos dun axente intelixente. Ao intentar describir cun maior ámbito (non só a comunicación) os atributos dun axente intelixente, a IA estendeuse a moitas áreas que crearon ramas de investigación enormes e diferenciadas. Ditos atributos do axente intelixente son:

- Ten actitudes mentais tales como crenzas e intencións

- Ten a capacidade de obter coñecemento, é dicir, aprender.

- Pode resolver problemas, incluso descompondo problemas complexos noutros máis simples.

- Entende. Posúe a capacidade de crearlle senso, se é posíbel, a ideas ambiguas ou contraditorias.

- Planifica, predí consecuencias, avalía alternativas (como nos xogos de xadrez)

- Coñece os límites do seu propias habilidades e coñecementos.

- Pode distinguir a pesar das similitude das situacións.

- Pode ser orixinal, creando incluso novos conceptos ou ideas, e ata utilizando analoxías.

- Pode xeneralizar.

- Pode percibir e modelar o mundo exterior.

- Pode entender e utilizar a linguaxe e os seus símbolos.

Podemos entón dicir que a IA inclúe características humanas tales como a aprendizaxe, a adaptación, o razoamento, a autocorrección, o melloramento implícito, e a percepción modelar do mundo. Así, podemos falar xa non só dun obxectivo, senón de moitos dependendo do punto de vista ou utilidade que poida atoparse á IA.

Moitos dos investigadores sobre IA sosteñen que "a intelixencia é un programa capaz de ser executado independentemente da máquina que o execute, computador ou cerebro".

Remove ads

Obxectivos

Razoamento e resolución de problemas

Os primeiros investigadores desenvolveron algoritmos que imitaban o razoamento paso a paso que os humanos usan cando resolven enigmas ou fan deducións lóxicas.[3] A finais da década de 1981-1990, a investigación da intelixencia artificial desenvolvera métodos para tratar con información incerta ou incompleta, empregando conceptos de probabilidade e economía.[4]

Estes algoritmos demostraron ser insuficientes para resolver grandes problemas de razoamento porque experimentaron unha «explosión combinatoria»: volvéronse exponencialmente máis lentos a medida que os problemas crecían.[5] Desta maneira, concluíuse que os seres humanos de cando en cando usan a dedución paso a paso que a investigación temperá da intelixencia artificial seguía; en cambio, resolven a maioría dos seus problemas utilizando xuízos rápidos e intuitivos.[6]

Representación do coñecemento

A representación do coñecemento[7] e a enxeñería do coñecemento[8] son fundamentais para a investigación clásica da intelixencia artificial. Algúns «sistemas expertos» tentan recompilar o coñecemento que posúen os expertos nalgún ámbito concreto. Ademais, outros proxectos tratan de reunir o «coñecemento de sentido común» coñecido por unha persoa media nunha base de datos que contén un amplo coñecemento sobre o mundo.

Entre os temas que contería unha base de coñecemento de sentido común están: obxectos, propiedades, categorías e relacións entre obxectos,[9] situacións, eventos, estados e tempo[10] causas e efectos;[11] e o coñecemento sobre o coñecemento (o que sabemos sobre o que saben outras persoas)[12] entre outros.

Planificación

Outro obxectivo da intelixencia artificial consiste en poder establecer metas e finalmente alcanzalas. [13] Para iso necesitan unha forma de visualizar o futuro, unha representación do estado do mundo e poder facer predicións sobre como as súas accións cambiarano, con tal de poder tomar decisións que maximicen a utilidade (ou o «valor») das opcións dispoñibles.[14]

Nos problemas clásicos de planificación, o axente pode asumir que é o único sistema que actúa no mundo, o que lle permite estar seguro das consecuencias das súas accións.[15] Con todo, se o axente non é o único actor, entón requírese que este poida razoar baixo incerteza. Isto require un axente que non só poida avaliar a súa contorna e facer predicións, senón tamén avaliar as súas predicións e adaptarse en función da súa avaliación.[16] A planificación de múltiples axentes utiliza a cooperación e a competencia de moitos sistemas para lograr un obxectivo determinado. O comportamento emerxente como este é utilizado por algoritmos evolutivos e intelixencia de enxame.[17]

Aprendizaxe

O aprendizaxe automática é un concepto fundamental da investigación da intelixencia artificial desde o inicio dos estudos deste campo; consiste na investigación de algoritmos informáticos que melloran automaticamente a través da experiencia.[18]

A aprendizaxe non supervisada é a capacidade de atopar patróns nun fluxo de entrada, sen que sexa necesario que un humano etiquete as entradas primeiro. A aprendizaxe supervisada inclúe clasificación e regresión numérica, o que require que un humano etiquete primeiro os datos de entrada. A clasificación úsase para determinar a que categoría pertence algo e ocorre despois de que un programa observe varios exemplos de entradas de varias categorías. A regresión é o intento de producir unha función que describa a relación entre entradas e saídas e predicir como deben cambiar as saídas a medida que cambian as entradas.[18] Tanto os clasificadores como os aprendices de regresión tentan aprender unha función descoñecida; por exemplo, un clasificador de spam pode verse como a aprendizaxe dunha función que asigna o texto dun correo electrónico a unha de dúas categorías, «spam» ou «non spam». A teoría da aprendizaxe computacional pode avaliar aos estudantes por complexidade computacional, complexidade da mostra (cantos datos requírense) ou por outras nocións de optimización.[19]

O mundo está en constante evolución, e ferramentas como ChatGPT están no centro desta transformación. Mentres que moitas persoas ven a ChatGPT como unha oportunidade para mellorar a experiencia dos seus negocios ou persoais, hai quen se mostran escépticos sobre a súa implementación.[20]

Procesamento da linguaxe natural

- Artigo principal: Procesamento da linguaxe natural.

O procesamento da linguaxe natural[21] permite ás máquinas ler e comprender a linguaxe humana. Un sistema de procesamento da linguaxe natural suficientemente eficaz permitiría interfaces de usuario de linguaxe natural e a adquisición de coñecemento directamente de fontes escritas por humanos, como os textos de noticias. Algunhas aplicacións sinxelas do procesamento da linguaxe natural inclúen a recuperación de información, a minería de textos, a resposta a preguntas e a tradución automática.[22] Moitos enfoques utilizan as frecuencias de palabras para construír representacións sintácticas de texto. As estratexias de procura de «detección de palabras clave» son populares e escalables, pero pouco óptimas; unha consulta de procura para «can» só pode coincidir con documentos que conteñan a palabra literal «can» e perder un documento co vocábulo «caniche». Os enfoques estadísticos de procesamento de linguaxe poden combinar todas estas estratexias, así como outras, e a miúdo logran unha precisión aceptable a nivel de páxina ou parágrafo. Máis aló do procesamento da semántica, o obxectivo final deste é incorporar unha comprensión completa do razoamento de sentido común.[23] En 2019, as arquitecturas de aprendizaxe profunda baseadas en transformadores podían xerar texto coherente.[24]

Percepción

A percepción da máquina[25] é a capacidade de utilizar a entrada de sensores (como cámaras de espectro visible ou infravermello, micrófonos, sinais inalámbricos e lidar, sonar, radar e sensores táctís) para entender aspectos do mundo. As aplicacións inclúen recoñecemento de voz,[26] recoñecemento facial e recoñecemento de obxectos.[27] A visión artificial é a capacidade de analizar a información visual, que adoita ser ambigua; un peón xigante de cincuenta metros de altura moi lonxe pode producir os mesmos píxeles que un peón de tamaño normal próximo, o que require que a intelixencia artificial xulgue a probabilidade relativa e a razonabilidade das diferentes interpretacións, por exemplo, utilizando o seu «modelo de obxecto» para avaliar que os peóns de cincuenta metros non existen.[28]

Remove ads

Importancia da intelixencia artificial

A grande importancia da IA radica no feito de que ten unha ampla gama de aplicacións, desde a automatización de tarefas tediosas até a creación de sistemas avanzados de asistencia médica e diagnóstico de enfermidades, a detección de fraudes e a optimización de procesos empresariais[29]. En moitos casos, a IA pode facer cousas que os humanos non poden facer, como o procesamento de datos en grandes cantidades e a localización de patróns e interrelacións entre estes que serían difíciles ou imposibles de detectar doutra maneira.

Esta ferramenta axuda a automatizar o aprendizaxe e descubrimento repetitivo a través de datos, realiza tarefas computarizadas frecuentes de maneira confiable, con todo, necesita intervención humana para a configuración do sistema. Analiza datos máis profundos e agrega intelixencia xa que non se pode vender como unha aplicación individual, polo que é un valor agregado aos produtos. Ten unha gran precisión a través de redes neurais profundas; por exemplo, en medicamento pódese utilizar a IA para detectar cancro con MRIs (imaxes ppr resonancia magnética). Adáptase a través de algoritmos de aprendizaxe progresiva, atopa estrutura e regularidades nos datos de modo que o algoritmo convértese nun clasificador ou predictor. E, por último, a intelixencia artificial, saca o maior proveito de datos.

Ademais, unha das principais razóns polas que a IA é importante é porque pode automatizar tarefas repetitivas e monótonas, liberando tempo e recursos para que as persoas se centren en tarefas máis creativas e valiosas. Por exemplo, a IA pode axudar ás empresas a automatizar tarefas de back office, como a contabilidade e o procesamento de facturas, o que pode reducir os custos e mellorar a eficiencia. De maneira similar, a IA pode axudar aos traballadores a realizar tarefas máis complexas e creativas, como o deseño e a planificación estratéxica.

Outra razón pola que a IA é importante é porque pode axudar ás empresas a tomar decisións informadas e precisas. Así mesmo, a IA pode procesar grandes cantidades de datos e proporcionar información valiosa para a toma de decisións empresariais, o que pode axudar ás empresas a identificar oportunidades comerciais, predicir tendencias de mercado e mellorar a eficiencia do mercado financeiro. Ademais, a IA pode axudar aos traballadores a tomar decisións informadas en tempo real, como no caso da atención médica, onde a IA pode axudar aos médicos a identificar enfermidades e personalizar o tratamento.

A IA tamén é importante no campo da ciberseguridade. A IA pode axudar a detectar e previr ameazas, desde ciberataques até a detección de comportamentos sospeitosos. A IA pode analizar grandes cantidades de datos en tempo real e detectar patróns e anomalías que poderían indicar unha ameaza de seguridade. Ademais, a IA pode aprender dos patróns de comportamento e mellorar a súa capacidade para detectar ameazas no futuro[30]. No campo da seguridade cibernética, a IA pode axudar a protexer os sistemas e as redes dos ataques de virus informáticos e a infiltración de malware.

Outra área onde a IA é importante é no descubrimento de coñecementos. A IA pode descubrir patróns e relacións nos datos que os humanos non poderían detectar, o que pode levar a novas ideas e avances en diversos campos. Por exemplo, a IA pode axudar aos investigadores a identificar novos tratamentos para enfermidades, ou axudar aos científicos a analizar datos de sensores e satélites para entender mellor o quecemento global.

Remove ads

Controversias

Sophia

En marzo de 2016, fíxose popular o comentario que a robot humanoide chamada Sophia da empresa Hanson Robotics fixo durante a súa presentación cando o seu creador, David Hanson, preguntoulle se estaba disposta a destruír á humanidade, ao que o robot contestou: «Está ben, vou destruír á humanidade». Posteriormente, Sophía gañouse o recoñecemento e a atención dos medios mundiais debido ás súas condutas case humanas, sendo entrevistada en moitas ocasións por distintos medios e sostendo conversacións con personalidades famosas e recoñecidas. En 2017, Sophia obtivo a cidadanía saudi, converténdose así no primeira robot en ser recoñecida como cidadá por un país, o cal levantou a controversia sobre se se lles debería outorgar os mesmos dereitos e obrigacións aos robots como se se tratasen de suxeitos de dereito.[31]

Alice e Bob

A finais de xullo de 2017, varios medios internacionais deron a coñecer que o laboratorio de investigación de intelixencia artificial do Instituto Tecnolóxico de Xeorxia, en conxunto co Grupo de Investigación de intelixencia artificial (FAIR) de Facebook, agora Meta, tiveron que apagar dúas intelixencias artificiais de tipo chatbot denominadas Bob e Alice, xa que desenvolveran unha linguaxe propia máis eficiente que o inglés, idioma no que foran adestrados para aprender a negociar, desenvolvendo finalmente un tipo de comunicación incomprensible que se afastaba das regras gramaticais da linguaxe natural e que favorecía o uso de abreviaturas. A linguaxe creada por estas IA mostraba características dun inglés corrupto e patróns repetitivos, en especial de pronombres e determinantes.[32]

Este inesperado suceso foi visto con pánico nos medios de comunicación, xa que se aseguraba que os chatbots supostamente saíran do control humano e desenvolveran a capacidade de comunicarse entre si. Con todo, posteriormente isto tamén foi desmentido, pois argumentouse que en realidade Facebook non apagou as intelixencias artificiais, senón que simplemente as puxo en pausa e cambiou os parámetros dos chatbots, refugando o experimento ao final por non ter ningún interese práctico ou útil dentro da investigación sobre IA.[33]

Ameca

A principios do 2022, na Feira de Electrónica de Consumo (CES) que tomou lugar nas Vegas, o robot desenvolvido por Engineered Arts nomeado Ameca causou dúbida e medo aos espectadores durante a súa exposición principalmente pola semellanza do seu rostro a un dun ser humano, a compañía expresou que o desenvolvemento deste robot humanoide aínda se atopaba en proceso e até setembro do mesmo ano o robot aínda non era capaz de camiñar nin ter interacción algunha coas persoas.[34] Doutra banda, en setembro de 2023 a compañía volveu expor a Ameca ao público mostrando ao robot en vídeos onde se lle pode ver fronte a un espello facendo 25 expresións humanas,[35] así como debuxando un gato ao xa contar con brazos e pernas que lle outorgaron mobilidade e, de igual maneira, empregando ironía en conversacións con persoas e mesmo declarando que realizou unha broma ao ser cuestionada sobre a súa capacidade de soñar como un humano sendo un robot ao dicir «soñei con dinosauros loitando unha guerra contra alieníxenas en Marte»[36] isto desmentiuno momentos despois explicando como é que a IA implementada no seu sistema permitíalle crear escenarios sobre feitos da humanidade e ía aprendendo sobre eles mentres se atopaba apagada; estes feitos impactaron á sociedade sobre a semellanza que este robot humanoide estaba a ter co ser humano e sobre o avance tecnolóxico que está a permitir que este robot estea cada vez máis próximo a vivir entre as persoas como un membro máis da comunidade.

Falsos espidos

A utilización de aplicacións gratuítas de IA para transformar fotografías de persoas en falsos espidos está a xerar problemas que afectan a menores. O caso saltou aos medios de comunicación en setembro de 2023 cando en Almendralexo (Badaxoz, España) apareceron varias fotografías de nenas e xoves (entre 11 e 17 anos) que foran modificadas mediante intelixencia artificial para aparecer espidas. As imaxes foron obtidas dos perfís de Instagram e da aplicación WhatsApp de polo menos 20 nenas da localidade. As fotografías de nenas espidas circularan despois mediante Whatsapp e a partir delas creouse un vídeo que tamén circulara entre menores. Os autores de devandita transformación tamén eran menores e compañeiros de colexio ou instituto. A Axencia Española de Protección de Datos abriu unha investigación e comunicouse co Concello de Almendralexo e coa Xunta de Estremadura informándolles de que se podía solicitar a retirada de calquera imaxe circulando en internet na canle prioritaria da axencia.[37]

Remove ads

Probas de intelixencia nunha máquina

Técnicas e campos da intelixencia artificial

- Aprendizaxe automática (Machine Learning)

- Enxeñaría do coñecemento (Knowledge Engineering)

- Lóxica difusa (Fuzzy Logic)

- Redes neurais artificiais (Artificial Neural Networks)

- Sistemas reactivos (Reactive Systems)

- Sistemas multi-axente (Multi-Agent Systems)

- Sistemas baseados en regras (Rule-Based Systems)

- Razoamento baseado en casos (Case-Basede Reasoning)

- Sistemas expertos (Expert Systems)

- Redes Bayesiás (Bayesian Networks)

- Vida artificial (Artificial Life)

- Algoritmo evolutivo (Evolutionary Computation)

- Células Binarias (Binary Cells)

- Random Forest (Metaalgoritmo de aprendizaxe)

- Estratexias evolutivas

- Algoritmos xenéticos (Genetic Algorithms)

- Técnicas de Representación de Coñecemento

- Redes semánticas (Semantic Networks)

- Marcos (Frames)

Remove ads

Tecnoloxías de apoio

Aplicacións

A intelixencia artificial (IA) é relevante para calquera tarefa intelectual.[38] As técnicas modernas de IA son xeneralizadas e son demasiado numerosas para enumeralas aquí.[39] Con frecuencia, cando unha técnica chega ao uso habitual, xa non se considera intelixencia artificial; este fenómeno descríbese como efecto AI.[40]

Na década de 2010, as aplicacións de intelixencia artificial estaban no centro das áreas da informática de maior éxito comercial e convertéronse nunha característica omnipresente da vida diaria. A IA utilízase en motores de procura (como Google Search), na orientación de anuncios en liña,[41] nos sistemas de recomendación (ofrecidos por Netflix, YouTube ou Amazon), impulsando o tráfico de Internet, [42][43] na publicidade dirixida (AdSense, Facebook), en asistentes virtuais (como Siri ou Alexa),[44] nos vehículos autónomos (incluídos drons e coches autoconducidos), tradución automática (Microsoft Translator, Google Translate), recoñecemento facial (Face IDE de Apple ou DeepFace de Microsoft'), etiquetaxe de imaxes (utilizado por Facebook, Apple's iPhoto e TikTok) e filtrado de spam.

Tamén hai miles de aplicacións de IA exitosas utilizadas para resolver problemas para industrias ou institucións específicas. Algúns exemplos son almacenamento de enerxía,[45] deepfakes (ultrafalso[46]),[47] diagnóstico médico, loxística militar ou xestión da cadea de subministración.

O xogo de xadrez foi unha proba da forza da IA desde a década de 1950. O 11 de maio de 1997, Deep Blue converteuse no primeiro sistema informático de xadrez en derrotar ao vixente campión do mundo, naquel momento, Garri Kasparov.[48] No 2011, nun programa especial do concurso de exhibición Jeopardy! de preguntas e respostas o sistema de resposta a preguntas Watson de IBM, , derrotou aos dous maiores campións de Jeopardy!, Brad Rutter e Ken Jennings, por unha marxe significativa.[49] En marzo de 2016, AlphaGo gañou 4 de 5 partidas de Go nun enfrontamento co campión de Go Lee Sedol, converténdose no primeiro sistema de Go por computador en vencer a un xogador profesional de Go sen hándicaps.[n. 1][50]

Outros programas manexan xogos de información perfecta; como o Pluribus[n. 2] e o Cepheus.[52] para o póker a un nivel superior a os humanos, DeepMind na década de 2010 desenvolveron unha "intelixencia artificial xeneralizada" que podía aprender moitos xogos diversos de Atari por si mesma.[53]

En 2020, sistemas de procesamento da linguaxe natural como a enorme GPT-3 (por entón, a maior rede neural artificial con diferenza) igualaban o rendemento humano nos puntos de referencia preexistentes, aínda que sen que o sistema alcanzase unha comprensión lóxica dos contidos dos puntos de referencia.[54] O AlphaFold 2 (2020) de DeepMind demostrou a capacidade de mostrar, en horas no canto de meses, a estrutura 3D dunha proteína.[55] Outras aplicacións predín o resultado das decisións xudiciais,[56] crean arte (como poesía ou pintura) e proban teoremas matemáticos.

Semáforos intelixentes

Semáforos artificialmente intelixentes usan cámaras con radar, sensores de localización acústica ultrasónica e algoritmos preditivos para mellorar o fluxo do tráfico

Os semáforos intelixentes desenvólvense na Universidade Carnegie Mellon desde 2009. O profesor Stephen Smith montou desde entón unha empresa, Surtrac, que instalou sistemas intelixentes de control de tráfico en 22 cidades. A instalación custa uns 20.000 dólares por intersección. O tempo de condución reduciuse nun 25% e o tempo de espera de atascos nun 40% nas interseccións nas que se instalou.[57]

Remove ads

Propiedade intelectual

En 2019, a OMPI informou de que a IA era a tecnoloxía emerxente máis prolífica en canto a número de solicitudes de patentes e patentes concedidas, estimábase que a Internet das cousas era o maior mercado en canto a tamaño. Seguíronlle, de novo en tamaño de mercado, as tecnoloxías de macrodatos, a robótica, a IA, a impresión 3D e a quinta xeración de servizos móbiles (5G).[58] Desde que xurdiu a IA na década de 1950, os innovadores presentaron 340.000 solicitudes de patentes relacionadas coa IA e os investigadores publicaron 1,6 millóns de artigos científicos, e a maioría de todas as solicitudes de patentes relacionadas coa IA publicáronse a partir de 2013. As empresas representan 26 dos 30 principais solicitantes de patentes de IA, mentres que as universidades ou organismos públicos de investigación representan os catro restantes.[59]

A proporción de artigos científicos e invencións diminuíu significativamente de 8:1 en 2010 a 3:1 en 2016, o que se atribúe como indicativo dun cambio da investigación teórica ao uso de tecnoloxías de IA en produtos e servizos comerciais. A aprendizaxe automática é a técnica da IA dominante divulgada nas patentes está incluída en máis dun terzo de todas as invencións identificadas (134.777 patentes de aprendizaxe automática presentadas para un total de 167.038 patentes de IA presentadas en 2016), sendo a visión por computador a aplicación funcional máis popular. As patentes relacionadas coa IA non só revelan técnicas e aplicacións da IA, senón que a miúdo tamén se refiren a un campo de aplicación ou industrial. En 2016 identificáronse vinte campos de aplicación e incluíronse, por orde de magnitude: telecomunicacións (15 por cento), transportes (15 por cento), ciencias da vida e medicina (12 por cento) e dispositivos persoais, informática e interacción humano-computadora (11 por cento). Outros sectores incluíron a banca, entretemento, seguridade, industria e manufactura, agricultura e redes (incluíndo redes sociais, cidades intelixentes e a Internet das cousas). IBM ten a maior carteira de patentes de IA con 8.290 solicitudes de patentes, seguida de Microsoft con 5.930 solicitudes de patentes.[59]

Remove ads

Filosofía

Definición da intelixencia artificial

- Artigo principal: Proba de Turing.

Alan Turing escribiu en 1950 "Propoño considerar a pregunta 'as máquinas poden pensar'?"[60] Aconsellou cambiar a pregunta de se unha máquina "pensa" a "se é posible ou non que a maquinaria mostre un comportamento intelixente".[60] Deseñou a proba de Turing, que mide a capacidade dunha máquina para simular a conversación humana.[61] Dado que só podemos observar o comportamento da máquina, non importa se "realmente" está a pensar ou ten literalmente unha "mente". Turing sinala que non podemos determinar estas cousas sobre outras persoas pero "é habitual ter a cortés convención de que todo o mundo pensa"[62]

Russell e Norvig coinciden con Turing en que a IA debe definirse en termos de "actuar" e non de "pensar".[63] Con todo, critican que a proba compare máquinas con persoas. "Os textos de enxeñería aeronáutica", escriben, "non definen o obxectivo do seu campo como facer 'máquinas que voen tan exactamente como as pombas que poidan enganar a outras pombas'".[64] O fundador da IA, John McCarthy, estivo de acordo e escribiu que "A intelixencia artificial non é, por definición, simulación da intelixencia humana".[65]

McCarthy define a intelixencia como "a parte computacional da capacidade de acadar obxectivos no mundo".[66] Outro fundador da IA, Marvin Minsky, defínea de xeito similar como "a capacidade de resolver problemas difíciles".[67] Estas definicións ven a intelixencia en termos de problemas ben definidos con solucións ben definidas, onde tanto a dificultade do problema como o rendemento do programa son medidas directas da "intelixencia" da máquina, e non se require ningunha outra discusión filosófica, ou quizais non sexa posible.

Unha definición que tamén foi adoptada por Google[68]- principal practicante no campo da IA. Esta definición estipulaba a capacidade dos sistemas para sintetizar información como manifestación da intelixencia, de forma similar a como se define na intelixencia biolóxica.

Avaliación dos enfoques da IA

Ningunha teoría unificadora establecida ou paradigma guiou a investigación da IA durante a maior parte da súa historia.[n. 3] O éxito sen precedente da aprendizaxe automática estatística na década de 2010 eclipsou todos os demais enfoques (ata o punto de que algunhas fontes, especialmente no mundo empresarial, utilizan o termo "intelixencia artificial" para referirse á "aprendizaxe automática con redes neurais"). Este enfoque é principalmente subsimbólico, neat, soft e narrow. Os críticos sosteñen que é posible que estas cuestións teñan que ser revisadas por futuras xeracións de investigadores en IA.

A IA simbólica e os seus límites

Intelixencia artificial simbólica (ou "GOFAI")[70] simulaban o razoamento consciente de alto nivel que utilizan as persoas cando resolven crebacabezas, expresan razoamentos xurídicos e fan cálculos matemáticos. Tiveron moito éxito en tarefas "intelixentes" como o álxebra ou os tests de intelixencia. Nos anos 60, Newell e Simon propuxeron a hipótese dos sistemas de símbolos físicos: "Un sistema de símbolos físicos ten os medios necesarios e suficientes para unha acción intelixente xeral". [71]

Con todo, o enfoque simbólico fracasou en moitas tarefas que os humanos resolven con facilidade, como a aprendizaxe, o recoñecemento dun obxecto ou o razoamento de sentido común. O paradoxo de Moravec é o descubrimento de que as tarefas "intelixentes" de alto nivel eran fáciles para a IA, pero as tarefas "instintivas" de baixo nivel eran extremadamente difíciles.[72] O filósofo Hubert Dreyfus sostiña desde os anos sesenta que a pericia humana depende do instinto inconsciente máis que da manipulación consciente de símbolos, e de ter unha "sensación" da situación, máis que dun coñecemento simbólico explícito.[73] Aínda que os seus argumentos foran ridiculizados e ignorados cando se presentaron por primeira vez, finalmente, a investigación da IA coincidiu.[n. 4][6]

A cuestión non está resolta: O razoamento subsimbólico pode cometer moitos dos mesmos erros inescrutables que a intuición humana, como o rumbo algorítmico. Críticos como Noam Chomsky argumentan que a investigación continua sobre a IA simbólica aínda seguirá sendo necesaria para alcanzar a intelixencia xeral,[75][76] en parte porque a IA subsimbólica afástase da IA explicable: pode ser difícil ou imposible entender por que un programa moderno de IA estatística tomou unha decisión concreta. O campo emerxente da intelixencia artificial neurosimbólica tenta tender unha ponte entre ambos os enfoques.

Remove ads

Riscos

A intelixencia artificial, ademais de beneficios, presenta moitos riscos se non se programa e utiliza con cautela. Hai dous factores claves que hai que ter en conta á hora de programar calquera intelixencia artificial: a robustez e os nesgos. Por outra banda, en relación cos usuarios, hai tamén dous riscos potenciais: a desinformación e a crenza cega na IA. Nesta sección, preséntanse distintos exemplos de malas praxes ou erros inconscientes de relevancia na historia da intelixencia artificial do século XXI, centrándose, sobre todo, nos fallos e nas prevencións executadas en España. Deste xeito, compleméntase a descrición dos riscos, para sermos máis conscientes do que estes implican.

IA robusta

A robustez nunha intelixencia artificial refírese a que o sistema sexa capaz de funcionar de maneira efectiva e segura nunha gran variedade de situacións, incluso con casos de incerteza.[77] Se a IA non é robusta, pode ser que pequenos cambios na entrada reflictan cambios substanciais na saída. Ante un pequeno algoritmo para o tempo de lecer, por exemplo, os perigos son menores, mais se se trata dun sistema de alto risco, como pode ser a condución autónoma, de haber erros, as consecuencias serían enormes. Seguindo con este exemplo, se se lle introduce un pequeno ruído adversarial ao sensor que detecta os sinais de tráfico, o sistema de condución autónoma podería pensar que en vez dun sinal de STOP, hai un de ceder o paso, con tódalas consecuencias que isto implicaría na condución e no tráfico.[78] Mais non fai falla sufrir un ciberataque para que o sistema falle, con que haxa algúns adhesivos ou pintadas no sinal, o sistema pode non identificalo correctamente.[77]

Nesgos na IA

- Véxase tamén: Nesgo algorítmico.

A sociedade avanza cara a unha comunidade dixital, que estará dominada principalmente pola intelixencia artificial. Debido a isto, se as intelixencias artificiais están nesgadas e non tratan por igual a tódalas persoas, o mundo real tamén estará nesgado, habendo desigualdades e inxustizas. En calquera caso, se se fai unha aplicación onde se publica cal é a poboación obxectivo ou os datos de adestramento, saberíase que é unha aplicación orientada a un determinado tipo de poboación. O problema de facer isto é que se pode caer na tentación de só facer aplicacións para o mesmo tipo de xente, deixando sen recursos a outros.[79]

Ademais dos nesgos que se presentan a continuación, hai moitos máis de diferentes naturezas, máis estes poden ser os máis relevantes. Un exemplo moi polémico que se deu no 2023 foi unha intelixencia artificial que retrataba ás mulleres das diferentes comunidades autónomas de España. A IA baseábase en comentarios da xente para o seu retrato. Tódalas mulleres das outras comunidades eran guapas, heroicas, loitadoras... Pero a muller galega foi unha señora maior, con engurras e triste. A polémica non xurdiu tanto por como se pintou á muller galega, senón polo contraste que había co resto de comunidades.[80]

Nesgos de xénero

Na intelixencia artificial os nesgos de xénero son moi comúns porque a meirande parte da xente que traballa neste campo son homes. Ao non haber mulleres nos equipos, hai moitos puntos de vista que non se teñen en conta ou problemas que non se resolven por non considerarse relevantes.[79]

Un exemplo de nesgo de xénero de alto risco é o selector de currículos de Amazon, que era sexista e escollía os currículos de mulleres. Por tanto, aínda que unha muller tivese un currículo mellor que o dun home, non era seleccionada polo algoritmo.[81] Pero isto non se deu só neste caso, hai moitas empresas que utilizan este tipo de algoritmos para a contratación, sen saber sequera se existen este tipo de nesgos.[79]

Continuando cos aspectos económicos, en 2019, a tarxeta de crédito de Apple, en parellas que comparten contas e patrimonio, estaba dando 20 veces máis liquidez aos homes que ás mulleres.[82] Pola súa parte, as concesións de créditos a mulleres emprendedoras están sendo denegados porque a natureza dun negocio suxerido por unha muller é moi diferente á dun home, e como o algoritmo só foi adestrado con casos de éxito de homes (porque non hai histórico de mulleres xa que antes só se lles permitía crear negocios a eles), a IA nunca lle vai dar un crédito a unha muller, polo que non hai avance na igualdade de xénero.[79]

Outro exemplo de nesgo de xénero é o da imaxe nas videoconferencias. Cando as mulleres poñen un fondo artificial por detrás, ao algoritmo cústalle moito máis identificar a silueta da persoa, quedando moitas veces a muller sen un anaco de cara, sen melena, sen pescozo... E isto pasa porque os algoritmos foron adestrados con homes brancos de pelo curto. Pero non é só un mero problema de estética. Se unha muller está nunha reunión importante, a súa capacidade de convencemento é moito menor, ademais da súa capacidade de que a xente lle preste atención, pois poden estarse fixando en como a recorta o algoritmo. Ademais, incluso as mulleres máis poderosas do mundo teñen este problema, polo que é unha grave falta cara a dignidade, respecto e honra das mesmas. Este problema identificouse sobre todo no 2020, a causa da pandemia da COVID, e a data de 2024 aínda segue sen estar solucionado. Isto ocorre porque os equipos están maioritariamente formados por homes, e non consideran que sexa un problema prioritario, mais si que o é, pois diminúe a dignidade das mulleres, ademais das súas oportunidades. De haber máis mulleres nos equipos, estarían insistindo e conseguindo que este tema fose prioritario para amañar.[79]

No que se refire á visión por computadora, diferentes compañías como Amazon ou Google, etiquetaban diferente a homes que a mulleres. Collían unha imaxe dunha muller, facíanlle unha alteración cambiándolle a cara da muller pola dun home, e o resultado que proporcionaba a IA era diferente. Por exemplo, á muller indicábanlle que tiña un secador na man, mentres que ao home, un martelo; cando ambos tiñan o martelo.[83][84]

Seguindo cos nesgos de imaxe, pero máis centrados no deseño, as personaxes dos videoxogos creadas con axuda de intelixencia artificial son sexistas. Hai unha cosificación grande da muller, pois as vestimentas dos homes e das mulleres para facer a mesma tarefa non son iguais. A muller adoita ir medio espida ou vestida dunha forma atractiva, e o home si que vai preparado para a ocasión (cunha protección adecuada se vai loitar, unha roupa deportiva oportuna se vai xogar un partido...). Con isto, os rapaces que xogan aos videoxogos perpetúan estes estereotipos de xénero. No 2023 fíxose en España un estudo de impactos na saúde mental de adición ao videoxogo, e as mulleres sufrían un 30% máis de ansiedade. Resultaba que nos videoxogos de estudo as personaxes femininas estaban cosificadas.[79]

Outro nesgo de deseño está nos algoritmos de intelixencia artificial que promoven vídeos, música, películas, etc. Estes danlle máis protagonismo aos homes que ás mulleres, sobre todo cando se trata de grupos novos.[85]

Nesgos de raza

Igual que cos nesgos de xénero, o conxunto de adestramento é moi importante é hora de sacar aplicacións ao mercado. En 2015, a recente aplicación Google Photos etiquetou a unha parella negra como gorilas, por estar adestrada con persoas brancas. Isto tivo un impacto moi grande, porque foi unha gran discriminación cara a raza negra, ademais de ser un incentivo para aumentar o racismo.[86]

Máis adiante, en 2018, Joy Boulamwini, investigadora do MIT, denunciou que o recoñecemento facial do seu teléfono móbil non a recoñecía salvo que se puxera unha máscara branca. Este problema aínda non estaba amañado en 2024, malia as insistencias de moitos colectivos.[87]

Nesgos de nivel social

Este tipo de nesgos xorden por dous canais, os nesgos como usuarios e os nesgos como persoa implicada. No que concirne ás persoas usuarias da intelixencia artificial, os equipos de traballo céntranse moito nos algoritmos da IA, sen prestar moita atención ás interfaces. Se a interface é algo complexa de utilizar, vai haber moita xente que non saiba usala, polo que non se poden aproveitar da IA. Para intentar remediar isto, no 2024, en Cataluña, abriron unha zona de "experiencia de usuario" que convocaba cidadanía e os poñían nunha sala cos trámites da Generalitat. Os traballadores ían apuntando as dúbidas que lles xorden aos voluntarios, para así poder mellorar a aplicación e poder construír outras que a xente entenda mellor.[79]

Un exemplo de desigualdade dixital é a autenticación con certificado dixital. A xente de servizos sociais non posúe este certificado, polo que para utilizar a aplicación teñen que ir ao portelo de servizos sociais. Este nesgo de acceso incrementa a desigualdade social, pois os que estaban con máis brecha dixital antes do proxecto, agora estarán peor atendidos. Ademais, fíxose un proxecto enorme de intelixencia artificial no que moita poboación non pode participar, polo que a efectos económicos non dá os resultados esperados.[79]

No caso das desigualdades cas persoas implicadas, en Holanda usaron un sistema de intelixencia artificial para detectar xente que defraudara pedindo subsidios para nenos. Cando o algoritmo detectaba que alguén defraudaba, automaticamente chegáballe unha multa cuantiosa á persoa correspondente. Como xeralmente estas axudas pedíanas as familias desfavorecidas, houbo un aumento da desigualdade, pois chegaron decenas de miles de multas, moitas incorrectas. O algoritmo aprendía que se eras dunha minoría étnica, eras máis propenso a defraudar. As consecuencias sociais foron terribles, habendo moitos suicidios.[88]

Fe cega na IA

O anterior é un caso de automation bias, é dicir, unha tendencia a confiar demasiado na automatización, sen haber supervisión humana, o que pode levar a desastrosos acontecementos, tal e como se viu na cuestión anterior.[77]

Outro exemplo de automation bias é un sistema de recoñecemento facial estadounidense para evitar roubos nunha tenda. O algoritmo creu recoñecer a un home que roubou, e inmediatamente, sen supervisión humana ou xuízos, enviouse a este home ao cárcere, sen ser el o culpable.[89]

Para que estas cousas non sucedan, é necesario que haxa unha formación ás persoas usuarias da IA, porque se non pode haber moitos riscos por non estar informados en que a intelixencia artificial pode fallar, e que ten que ser a persoa usuaria a que tome as decisións.[79]

En España, a policía nacional comezou a usar en 2018 unha ferramenta chamada VeriPol para detectar denuncias falsas. Este sistema non di só se a denuncia é falsa, senón que dá unha probabilidade deste resultado, para que os policías poidan saber en que medida teñen que tratar o caso a man. Neste caso, si que hai unha formación previa á policía para o uso desta ferramenta. As decisións sempre van estar en mans dos axentes e van ser a súa responsabilidade; esta ferramenta só é unha axuda á toma de decisións.[77]

Desinformación sobre a IA

Nun campo tan interesante e que avanza tan rapidamente, os usuarios utilizan a intelixencia artificial asombrados de tódalas súas vantaxes, mais sen preguntarse como funciona ou as implicacións que ten usala. Un exemplo disto é unha charla que deu Karina Gibert a uns xuíces, onde eles lle comentaban que estaban usando chatGPT para ver se lles podía ditar sentenzas. Mandábanlle á versión pública de chatGPT os datos aínda non publicados. Estas persoas non sabían como funcionaba a intelixencia artificial, e non eran conscientes de que os seus datos estaban sendo almacenados nunha base de datos, onde a xente de OpenAI podía consultar estes datos privados das persoas.[79]

En Cataluña, en 2022, creouse o proxecto CiutadanIA, un curso divulgativo en liña de intelixencia artificial para que a poboación civil que non ten coñecementos tecnolóxicos adquira unha mínima conciencia e cultura da IA e poida ter criterio para saber como consumila de forma segura.[90]

Remove ads

A intelixencia artificial verde

Para ter unha intelixencia artificial responsable, non basta con que sexa respectuosa cos seres humanos, é necesario tamén que o sexa co medio ambiente. A perspectiva da ética foi cambiando ao longo dos anos, e ademais da manipulación e a desinformación, por exemplo, tamén entrou en xogo a sostibilidade. O termo IA verde refírese á investigación en IA que produce resultados novidosos tendo en conta o custo computacional e promovendo unha redución dos recursos consumidos, en contraposición coa IA vermella, que busca mellorar a precisión dos modelos mediante o uso de recursos computacionais masivos sen ter en conta o custo.[91]

Hai un gran descoñecemento por parte da poboación xeral no que concirne á execución da tecnoloxía, da IA en particular. No 2021, o Joint Research Centre da Comisión Europea fixo unha enquisa preguntando polos efectos da IA no medio ambiente, e só un 5% respondeu que podería ter efectos negativos no medio ambiente. Nada máis lonxe da realidade. No 2019, o MIT publicou un artigo onde explicaba que o adestramento dos grandes modelos de intelixencia artificial podía emitir tanto CO2 á atmosfera como 5 coches na súa vida útil.[92] De feito, Greenpeace estimou que a tecnoloxía consumiría en 2025 o 20% da enerxía do mundo. Sobre a tecnoloxía GPT, unha universidade danesa publicou que un único adestramento de GPT-3 podía consumir tanta enerxía como 126 casas danesas nun ano. Pero para lanzar unha destas tecnoloxías non se adestra unha única vez, senón varias, polo que a cantidade de contaminación é enorme.[91] De feito, para poder competir con chatGPT, os motores de busca de Google queren utilizar IA nas súas buscas. Se isto ocorrese, o consumo de electricidade por parte da IA sería equiparable ao consumo anual de países como Holanda ou Arxentina.[93] Outro exemplo é o que consome o modelo PALM, que nun adestramento pode gastar o equivalente ao que consome a cidade de Nova York nun día.[94]

Algoritmos verdes

Os algoritmos verdes son os algoritmos máis eficientes á hora de construílos, que consomen menos recursos e conseguen o mesmo resultado que obtería un algoritmo máis complexo.[95] Hai dous tipos de algoritmos verdes, o green-by e o green-in.

Por unha banda, o green-by é o desenvolvemento de aplicacións en distintos ámbitos e sectores que contribúan á sostibilidade e á loita contra o cambio climático. Co uso da IA neste tipo de algoritmos poderíase reducir entre 2,6 e 5,3 xigatoneladas de emisións de gases de efecto invernadoiro (entre o 5% e o 10% do total) e podería proporcional entre 1 e 3 billóns de dólares de valor engadido cando se aplique á sostibilidade corporativa en xeral.[96] Estes algoritmos teñen múltiples aplicacións: na auga (por exemplo, no mantemento preditivo das infraestruturas hídricas), na agricultura (por exemplo, optimizar o uso de recursos naturais como fertilizantes), na enerxía (por exemplo, para predicir a oferta e demanda da enerxía) e no transporte (por exemplo, optimización do tráfico), entre moitos outros.[91]

Por outra banda, o green-in é a busca de formas de lograr algoritmos máis escalables e sostibles para reducir a pegada de CO2 dos algoritmos actuais. Para conseguir isto pódese utilizar optimización algorítmica (seleccionar os algoritmos máis eficientes ou reducir a carga dos que se están utilizando), optimización do hardware (utilización dun hardware máis eficiente computacionalmente), unha boa elección do centro de datos (a pegada de carbono é directamente proporcional á eficiencia do centro de datos e á intensidade de carbono da súa localización) e reducir o factor de escala pragmática (facer os adestramentos máis curtos).[91]

Para reducir a pegada enerxética, xa hai ferramentas que calculan e predín o consumo de enerxía, tales como a Carbon Tracker[97] ou Green Algorithms.[98]

Por ser un tema de vital importancia, tanto nas leis europeas como nas españolas de intelixencia artificial hai puntos que regulan que a IA ten que ser respectuosa co medio ambiente, pois é un ben xurídico a protexer fronte ao desenvolvemento da IA.[91]

Usar este tipo de algoritmos non só causa unha mellora no planeta, senón que reduce os tempos de execución considerablemente, pois canto menos tempo de execución, menos se consome. Por tanto, ás empresas tamén lles interesa facer green-in, para que así os seus procesos avancen con máis velocidade.

Leis para a intelixencia artificial

- Artigo principal: Regulamento sobre Intelixencia Artificial.

Malia que a intelixencia artificial comezou 60 anos atrás, non foi ata o 2018 onde se comezou a usar de forma significativa, sobre todo en ámbitos perceptibles polas persoas que non traballan con ela. E foi a partir deste ano onde se comezou a falar de ética na IA máis profundamente, creándose guías para que as diferentes intelixencias artificiais fosen robustas, éticas, supervisadas por humanos... Mais en 2021, debido ao grande crecemento da intelixencia artificial, a comisión europea viu necesario crear un plan coordinado sobre este tema, para controlar o seu uso e regulamento. Esta regulación é a primeira de intelixencia artificial no mundo.[77]

Este plan coordinado ten de inicio 4 grandes obxectivos:

- Establecer as condicións necesarias.

- Facer que Europa sexa o lugar ideal para implementar a IA ética.

- O foco tiña que ser o ser humano, non a tecnoloxía en si. Debido a isto, créase o AI act, a regulación europea da intelixencia artificial, aprobada en marzo do 2024,[99] entrando en vigor o 1 de agosto de 2024.[100]

- Desenvolver o liderado estratéxico nos diferentes sectores, fixándose especialmente no sector público.[77]

O principal reto desta regulación está en emitir as leis antes de que se creen os diferentes produtos, pois a evolución desta tecnoloxía vai a moita velocidade, máis rápido que os procesos burocráticos. Para poder facer fronte a esta rapidez, no que se basean estas leis é en minimizar os riscos, vendo para que se utiliza a IA, non en como está construída. Para isto, hai 4 niveis de risco: risco mínimo (por exemplo, desbloqueo facial do móbil), risco de transparencia (por exemplo, axentes conversacionais), alto risco (por exemplo, sistemas de acceso a servizos públicos) e risco inaceptable (por exemplo, puntuación social). A regulación de IA céntrase nos sistemas de alto risco. Nos sistemas de risco mínimo non hai restricións, os de transparencia están obrigados a indicar que o usuario está tratando cunha IA, e nos de risco inaceptable está prohibido utilizalas.[77]

Por tanto, estes sistemas de alto risco teñen que crear toda a documentación indicada na lei. Entre estes requisitos legais destacan:

- Robustez, precisión e ciberseguridade.

- Evitar nesgos de raza, sexo, idade, etnia, cultura, relixión, orientación sexual, orientación política...

- Supervisión humana, necesaria para previr e minimizar riscos do sistema. Evitar a confianza total na IA.

- Transparencia. Informar sobre as capacidades e limitacións do sistema.

- Documentación do sistema.

- Datos representativos e de alta calidade. Establecer mecanismos do trato dos datos.[77]

Lei en España

- Véxase tamén: Axencia Española de Supervisión da Intelixencia Artificial.

A nivel nacional, creouse a ENIA, a Estratexia Nacional de Intelixencia Artificial, que ten como obxectivo proporcionar un marco de referencia para o desenvolvemento dunha IA inclusiva, sostible e centrada na cidadanía. Forma parte da Axenda España Dixital 2026 e ten os seguintes catro obxectivos específicos:

- Converter a España nunha referente na transformación cara unha Economía do Dato.

- Impulsar a IA como motor de innovación e crecemento económico social, inclusivo e sostible.

- Preparar a España para as transformacións socioeconómicas que orixina a IA.

- Fortalecer a competitividade a través das actividades I+D no conxunto das Tecnoloxías Habilitadoras Dixitais (THD).[101]

Ademais, en 2024 o Goberno aprobou a Estratexia de Intelixencia Artificial 2024, onde se melloran as capacidades de supercomputación e almacenamento sostible en España, promove unha familia de modelos de linguaxe en castelán e as linguas cooficiais que evite nesgos e inclúe medidas para propiciar a aplicación práctica da IA no sector público e nas pequenas e medianas empresas.[102]

En canto á sostibilidade, o Goberno nacional lanzou en 2021 o Programa Nacional de Algoritmos Verdes, para o desenvolvemento dunha intelixencia artificial medioambientalmente sostible.[103]

Pola súa parte, en Galicia tamén se creou unha lei de intelixencia artificial, a Estratexia Galega de Intelixencia Artificial 2021-2030 (EGIA), onde se plasman moitos dos obxectivos europeos e españois, pero centrados no ámbito galego. Na seguinte sección profúndase máis nesta estratexia.[104]

Intelixencia artificial en Galicia

No ámbito da intelixencia artificial, Galicia non queda atrás. Numerosas empresas e centros de investigación galegos apostaron por esta disciplina que ao longo dos anos foi acadando un gran potencial, tomando un maior protagonismo dende 2020.[105] As empresas galegas atopáronse no 2021 entre as empresas españolas que máis utilizaban a intelixencia artificial, onde máis do 21% desenvolvían os seus produtos con IA. Ademais, nas empresas de 10 ou máis persoas, o seu uso conseguía o 10,2%, superando o medio estatal de 8,3%. Igualmente tiñan boas cifras as empresas de menos de 10 empregados, acadando o 7,6% de uso, 4 puntos porcentuais por riba do medio estatal. Entre o sector TIC galego, en 2021 o 16,6% das empresas empregaba a realidade virtual; o 13,8%, a impresión 3D e o 24,2%, axentes conversacionais ou chatbots, experimentando este último un crecemento relativo do 44,9% con respecto ao ano anterior.[106]

A forza de Galicia na intelixencia artificial é tan grande que foi unha das primeiras comunidades autónomas que presentou unha estratexia propia de IA, a Estratexia Galega de Intelixencia Artificial 2021-2030 (EGIA). Este plan ten o obxectivo de converter a Galicia nunha rexión intelixente que contribúa ao mundo dixital da Unión Europea, tanto nas empresas como na administración. Estaba pensada para despregar en Galicia unha intelixencia artificial de vangarda, ética, segura e centrada nas persoas. Coordenada pola Amtega, prevíase que mobilizara máis de 330 millóns de euros públicos da Xunta de Galicia no período 2021-2030 e xerara un impacto na creación de riqueza duns 472 millóns de euros nese período.[104]

Ademais da EGIA, Galicia colaborou noutros proxectos. Múltiples empresas prestixiosas a nivel mundial, tales como Amazon, Microsoft ou Telefónica, apostaron en 2022 por Galicia para ser sede da Axencia Estatal de Intelixencia Artificial.[107] Estas empresas destacaban que Galicia era un bo escenario para a sede pola grande representación que ten nos sectores financeiro, pesqueiro ou alimenticio, polo impulso que se lle está dando a esta disciplina dende as 3 universidades galegas e polo seu uso na administración.[108]

No 2023, a Xunta de Galicia creou unha Comisión de Expertos na IA, para conseguir un desenvolvemento ético e sostible neste campo. A comisión ten diferentes funcións: avaliar o impacto da IA en diferentes sectores para garantir un enfoque informado, asesorar a formulación da EGIA e garantir que os sistemas de IA que se utilizan na comunidade son fiables e respectuosos cos dereitos fundamentais das persoas. A comisión estará composta por expertos das áreas de economía, filosofía e evolución humana, tecnoloxía aplicada, ética e normativa e política pública.[109]

Con respecto aos seus usos na comunidade galega, a intelixencia artificial xa se usa dende 2023 para prever vendas, detectar pragas, controlar a circulación[110] ou nos hospitais, por exemplo, para acelerar a análise do cancro de mama.[111] En canto ás entidades que crean intelixencia artificial, atópanse numerosas delas con grandes resultados como o CiTIUS (Centro Singular de Investigación en Tecnoloxías Intelixentes),[112][113] Link Affinity[114] e ITG.[115]

A nivel mundial, celébrase tódolos anos a Eurovisión da intelixencia artificial.[116] En 2022, o grupo Cecubo creou a canción AI-Lalelo, baixo o nome de Ana María Prieto,[117] levando medalla de prata e outorgándolle a Galicia a oportunidade de ser sede o ano seguinte. En 2023, o festival desenvolveuse na Coruña, onde o CiTIUS participou recreando a voz de Ana Kiro na canción Florespiña.[118]

Intelixencia artificial en galego

Dende os 2000, a sociedade avanza cara unha comunidade dixital. Nos primeiros tempos da tecnoloxía, o contido que se ofrecía estaba nas linguas maioritarias, tales como inglés, chinés, castelán... polo que os usuarios que non falaban ningunha destas linguas tiñan que cambiar a súa lingua materna por unha das dispoñibles, o que pode derivar nun abandono da lingua propia. É máis, se esta lingua está en decadencia, pode incluso levar á súa desaparición. Para evitar isto, Europa promoveu un plan onde non queden linguas europeas minorizadas neste ámbito.[119]

Galicia sumouse a esta iniciativa europea en 2023 co proxecto falAI,[120] unha ferramenta desenvolvida pola universidade de Vigo e Balidea onde aos usuarios se lles mostran unhas frases en galego para que lean e graven a súa voz. O obxectivo é acadar unha base de datos moi grande, cunha gran diversidade de acentos, para poder crear axentes conversacionais que poidan replicar e entender a fala galega. En 2023 chegaron a ser a base de datos máis ampla a nivel mundial no ámbito dos axentes conversacionais.[119]

Pola súa banda, en 2021 o CiTIUS e o ILG (Instituto de Lingua Galega) crearon, a petición da Xunta, o proxecto Nós, que ten o mesmo obxectivo que falAI no eido do galego como lingua viva no mundo dixital. Distribuíndo os seus recursos baixo licenzas libres, céntranse nalgunhas das grandes tarefas do procesamento da linguaxe natural, tales como a síntese de voz, o recoñecemento da fala, a tradución de texto, a xeración automática de texto e a corrección e avaliación lingüística automática, entre outros.[121] Coa súa filosofía da distribución gratuíta de recursos, publican na súa páxina tódalas ferramentas que van desenvolvendo. No 2024, xa teñen repositorios en GitHub, Zenodo e Hugging Face,[122] ademais de demostradores e prototipos dun tradutor entre español, galego e inglés,[123] dun sistema de conversión de texto a voz[124] e dun sistema de recoñecemento da fala.[125] Para levar a cabo o proxecto e conseguir datos, contactaron con empresas galegas de diferentes sectores para que lles forneceran os datos necesarios.[94]

O proxecto Nós participa no proxecto ILENIA, coordinado polo BSC-CNS (Barcelona Supercomputing Center - Centro Nacional de Supercomputación[126]), onde colaboran a USC, a UPV e a Universidade de Alacant. Este proxecto impulsado polo Ministerio para a Transformación Dixital e da Función Pública, ademais de compilar grandes corpus de galego de calidade, ten como obxectivo facer grandes modelos multilingües, onde participarán as linguas oficiais e cooficiais do estado como requisito fundamental.[94]

No 2024, o proxecto Nós conseguiu un dos seus maiores logros ata ao momento: crear o primeiro gran modelo de linguaxe da historia para o galego, "Carballo",[127] que permitirá a creación de novas ferramentas e aplicacións de IA xerativa para a lingua propia de Galicia. Trátase dun modelo fundacional, por ser a peza básica para construír ferramentas versátiles e de alta calidade mediante IA xerativa con tecnoloxía lingüística, como axentes conversacionais, tradutores ou correctores automáticos. Carballo conta cunha arquitectura GPT de 1 300 parámetros que se adestraron coa axuda do CESGA. Adestrouse co CorpusNós,[128] o maior corpus en galego existente ata a data, con máis de 2 100 millóns de palabras, elaborado polo Proxecto Nós coa axuda das distintas empresas galegas asociadas. Xunto a Carballo, foi tamén desenvolvido en colaboración coa Universidade de Évora, o primeiro modelo fundacional galego e portugués, "Carvalho", co obxectivo de fortalecer a lingua galega mediante a inclusión do portugués europeo. Dende a súa publicación os creadores seguen traballando no modelo para corrixir os posibles fallos e crear as melloras oportunas. Destacar que o proxecto foi desenvolvido sen perder de vista que tiña que ser unha IA segura, seguindo a primeira lei de Intelixencia artificial do mundo aprobada polo Parlamento Europeo.[129] En setembro do 2024, recibiu o premio Best Application Paper Award do congreso internacional EPIA2024.[130]

Ámbito académico

No ámbito académico, as tres universidades galegas apostaron por introducir no curso 2022-2023 o grao de Intelixencia Artificial, así como un mestrado interuniversitario de Intelixencia Artificial.[131] O mestrado en visión por computadora na universidade de Santiago, porén, xa estaba instaurado dende o curso 2019-2020.[132] Con estas ferramentas preténdese formar a mozos e mozas neste ámbito que está nun constante crecemento.[133]

Pola súa banda, para os institutos que así o desexen, dende o 2023 poden ofertar unha optativa en cuarto da ESO de Intelixencia artificial e outra de tecnoloxías intelixentes en primeiro de bacharelato, co obxectivo de formar aos rapaces no impacto da intelixencia artificial, como utilizala (tanto a nivel usuario como programador), a ética, sostibilidade, etc. Con esta iniciativa, Galicia foi das primeiras comunidades autónomas en España en impartir moitos dos contidos.[134]

Notas

Véxase tamén

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads