Loading AI tools

Aspect thématique de l'Histoire De Wikipédia, l'encyclopédie libre

L'histoire de l'électricité, en tant que processus d'étude et de compréhension, est amorcée au XVIIe siècle, s'appuie sur de très fortes avancées expérimentales depuis le XVIIIe siècle, et sur une formalisation théorique croissante au XIXe siècle et au XXe siècle : l'électricité est depuis considérée comme ayant une double nature corpusculaire et ondulatoire, et le mot électricité désigne un ensemble de phénomènes créés par le déplacement de particules élémentaires et se manifestant sous forme calorifique, chimique, lumineuse, magnétique ou mécanique, dont les manifestations naturelles sont la foudre et la capacité d'attraction/répulsion qu'ont certains matériaux préalablement frottés. La production, le transport et les usages de l'électricité se développent rapidement à partir du milieu du XIXe siècle, impactant de nombreux secteurs industriels, comme la métallurgie et la chimie, permettant l'émergence des télécommunications et de l'électronique, et provoquant des changements profonds du cadre de vie, notamment avec l'éclairage, l'électroménager, la radio et la télévision. Vecteur d'information et d'énergie, l'électricité est devenue incontournable dans les sociétés modernes depuis le milieu du XXe siècle.

La foudre, manifestation naturelle la plus visible et la plus spectaculaire de l'électricité, a été observée, probablement avec frayeur, par les humains depuis l'aube des temps. Elle a influencé les récits mythologiques de nombreuses civilisations : ainsi Zeus, le roi des dieux antiques grecs, comme Jupiter, son équivalent dans la mythologie romaine, Illapa chez les Incas, Thor, le dieu scandinave, ou encore Indra en Inde contrôlent et manient la foudre[1].

D'autres phénomènes électriques ont été constatés[note 1] et parfois reproduits par l'homme à partir du premier millénaire avant J.-C.[2]. Ainsi, les propriétés électrostatiques de l'ambre, qui lui permettent d'attirer des corps légers, ont été rapportées par Thalès vers et, au Ier siècle, Pline l'Ancien puis Plutarque soulignent que cette faculté peut être obtenue en frottant le morceau d'ambre.

Aristote, vers , mentionne l'existence de poissons pouvant émettre des décharges électriques. On trouve aussi des bas-reliefs de l'Égypte antique représentant des poissons-chats électriques et une mosaïque de Pompéi représente une torpille commune. Scribonius Largus, sous le règne de l'empereur Claude Ier (41-54 apr. J.-C.) décrit un traitement contre la migraine ou contre la goutte qui utilise les décharges électriques produites par un poisson torpille[3].

Autre phénomène naturel, le feu de Saint-Elme, apparaissant en haut des mâts des navires en période d'orages, est connu depuis le IVe siècle.

Les propriétés magnétiques de certaines pierres, provenant notamment d'une région d'Asie Mineure appelée Magnésie, sont quant à elles mentionnées en Chine dès le premier siècle avant J.-C.[note 2], et les compas ou boussoles pouvant servir à l'orientation sont utilisés par les marins chinois et arabes dès le XIe siècle[2]. L'effet des éclairs lumineux pendant les orages sur le comportement de l'aiguille du compas est consigné par les navigateurs[L1b 1].

Une révolution scientifique majeure a lieu durant les XVIIe et XVIIIe siècles[4] : l'approche scientifique se fonde désormais sur l'expérimentation, devenant de plus en plus quantitative, et la recherche d'explications rationnelles s'émancipe des références religieuses passées en s'appuyant sur des méthodes, des outils mathématiques et des instruments de mesure de plus en plus précis.

L'astronomie a un rôle important dans ce mouvement : durant cette période, les scientifiques démontrent notamment le mouvement de la Terre autour du Soleil, puis celui du Soleil par rapport à certaines étoiles, ainsi que la forme elliptique de la trajectoire des planètes autour du Soleil. De nouveaux concepts mathématiques permettent de calculer et démontrer ces théories : calcul infinitésimal, logarithmes, géométrie analytique, etc. sont créés puis progressivement utilisés dans tous les domaines de la mécanique et, plus largement, de la physique.

Cette période est également marquée par la création de grandes académies, qui auront un rôle décisif dans le soutien à la science et à son rayonnement, parmi lesquelles l'Accademia del Cimento (Florence, 1657), la Royal Society (Londres, 1660), ou l'Académie royale des Sciences (Paris, 1666).

La connaissance et l'étude de l'électricité, encore centrées sur l'électricité statique, suivent ce grand mouvement, même s'il faut attendre la moitié du XVIIIe siècle pour que des approches quantitatives se développent.

En 1600, le médecin et physicien anglais William Gilbert publie le résultat de près de vingt années d'études[5]. Dans son ouvrage De Magnete, l'un des tout premiers livres de physique édités en Angleterre, il développe notamment la théorie selon laquelle la Terre serait un gigantesque aimant, qui explique pourquoi les aiguilles aimantées des boussoles pointent toujours vers le Nord, et établit plusieurs différences entre les propriétés d'attraction des aimants et celles de l'ambre. Constatant que plusieurs matériaux ont les propriétés d'attraction de l'ambre, il crée le mot electric, formé à partir du mot grec ἤλεκτρον / ḗlektron, qui désigne l'ambre jaune[6], pour désigner ceux susceptibles d'être « électrisés » par frottement. Gilbert invente en outre un instrument permettant de les caractériser, le versorium, premier exemple d'électromètre fonctionnel.

Vers le milieu des années 1600[note 3], Otto von Guericke crée une machine à produire de l'électricité : la rotation d'une boule de soufre frottée à la main produit des étincelles. C'est la première d'une longue série de machines qui vont servir aux scientifiques étudiant l'électricité, et à l'amusement du grand public grâce aux effets électrostatiques parfois spectaculaires présentés[7].

Dans son ouvrage Principes mathématiques de la philosophie naturelle publié en 1687, Isaac Newton mentionne l'électricité, qui constitue avec la gravitation le cœur de cette œuvre, ainsi que le magnétisme comme capables de créer des forces d'attraction (« centripètes ») ou de répulsion (« centrifuge »). Isaac Newton assume de ne pouvoir expliquer pourquoi ces forces existent, ni quelles caractéristiques de la matière peuvent les produire. Le débat sur la nature de l'électricité va d'ailleurs durer près de deux siècles encore.

Durant le XVIIIe siècle, plusieurs avancées importantes ont lieu, relatives à la compréhension de la nature de l'électricité, de ses différentes formes et des moyens de la produire, de la stocker et de la transmettre. L'existence d'une autre sorte d'électricité, continue et non électrostatique, est notamment démontrée. Ces avancées sont appuyées sur une grande variété d'expériences menées en Europe et aux États-Unis.

Dans les années 1720, l'anglais Stephen Gray établit expérimentalement que l'électricité peut être transmise par certains matériaux et ne l'est pas par d'autres : c'est le début de la notion de matériaux conducteurs et isolants[note 4]. Il constate aussi qu'un corps électrisé peut en électriser un autre qui lui est proche.

Poursuivant les travaux de Gray, le français Charles-Antoine Dufay constate que deux corps électrisés peuvent soit s'attirer, soit se repousser, ce qui le conduit à émettre l'hypothèse de l'existence de deux sortes d'électricité statique : l'électricité « vitrée », obtenue en frottant verre, pierres ou fourrure, et l'électricité « résineuse », obtenue en frottant ambre, résine ou soie. Il formule la théorie selon laquelle deux corps contenant la même électricité se repoussent, alors que deux corps contenant de l'électricité de nature différente s'attirent[8]. Ses travaux, publiés dans plusieurs Mémoires adressés à l'Académie royale des Sciences à partir de 1733[9], relancent la polémique entre scientifiques sur la nature de l'électricité, qui durera jusqu'à la fin du siècle.

Vers 1745, Ewald Von Kleist puis Pieter van Musschenbroek découvrent le moyen d'accumuler de l'électricité, réalisé pratiquement dans un dispositif dénommé bouteille de Leyde, ancêtre des condensateurs actuels. Cette découverte relance la recherche sur la nature de l'électricité, car elle ne peut être expliquée par la théorie des deux fluides.

En 1747, Jean Le Rond d'Alembert établit l'équation de propagation d'onde (analogue aux quatre équations de Maxwell du XIXe siècle)[L1b 1]).

Benjamin Franklin s'intéresse à l'électricité dès la fin des années 1740. Il est à l'origine de plusieurs avancées : avec sa célèbre expérience du cerf-volant, qui sera à l'origine de l'invention du paratonnerre, il démontre notamment que la foudre est un phénomène électrostatique. Il formule auparavant une théorie selon laquelle « le feu électrique n'est pas produit mais rassemblé par le frottement », invente les notions d'électrisation positive et négative, et met en évidence l'importance d'être relié « à la terre » pour y transmettre l'électricité. Il affirme que l'électricité est un fluide unique, ce qui lui permet d'expliquer le fonctionnement de la bouteille de Leyde[10] : la théorie des deux fluides va décliner jusqu'à être abandonnée ensuite.

En 1759, Franz Aepinus met au point un condensateur à air et construit une théorie explicative aux fondements mathématiques précis. En prenant pour hypothèses que la capacité d'attraction (ou de répulsion) des corps électrisés est une propriété intrinsèque[note 5] et que sa force suit une loi dépendant de la distance, Aepinus explique de nombreux phénomènes d'interaction à distance dont l'interprétation résistait aux théories précédentes[10].

En 1767, Joseph Priestley publie The History and Present State of Electricity, ouvrage reprenant les connaissances de l'époque sur l'électricité et décrivant ses propres travaux, dans lequel il avance que les effets d'attraction (ou de répulsion) électrique suivent une loi en carré inverse de la distance séparant les objets concernés. Il ne formalise pas cette idée et n'en donne pas de preuve expérimentale précise. Il reviendra au français Charles-Augustin Coulomb de le faire et d'en apporter des preuves définitives en 1785, grâce à un appareil qu'il a inventé, la balance de Coulomb, ancêtre de tous les électromètres : l'électricité est désormais mesurable. Coulomb énonce ce qui est depuis la loi de Coulomb : « l'action est en raison inverse du carré des distances et directe des densités »[note 6], qui sera l'une des fondations de l'électrostatique[11].

En 1773, le chimiste anglais Henry Cavendish fabrique une « maquette » de poisson-torpille avec des bouteilles de Leyde imbriquées. Il constate l'apparition d'électricité de même nature que celle de la foudre et semblable à l'électricité animale produite par un poisson-torpille.

En 1791, l'anatomiste italien Luigi Galvani publie les résultats de dix années d'étude et d'expérimentation de l'action de l'électricité sur le corps d'animaux (essentiellement des grenouilles). Il en conclut que l'électricité produite par les machines est de la même nature que celle de la foudre, et qu'elle peut provoquer des contractions musculaires chez l'animal, même à distance. Mais il affirme aussi qu'il existe une autre sorte d'électricité, dite « animale », qui serait produite et contenue à l'intérieur du corps des animaux[12].

Cette dernière affirmation suscite une importante controverse scientifique, qui sera tranchée à la fin du siècle grâce aux travaux du physicien italien Alessandro Volta. Après avoir pris connaissance des travaux de Galvani, Volta, physicien déjà reconnu à l'époque[note 7], entreprend une série d'expériences qui l'amènent progressivement à contester la notion d'électricité animale de Galvani[note 8]. En 1799, il met au point le premier générateur continu d'électricité ne faisant pas appel à un mouvement mécanique : la pile de Volta, ancêtre des piles électriques et accumulateurs actuels. La pile de Volta, constituée de disques de deux métaux différents empilés de façon alternée et séparés par des rondelles de feutre imbibées d'une solution aqueuse acide, produit constamment de l'électricité[13]. Volta démontre ainsi que les métaux, utilisés dans certaines conditions, peuvent produire de l'électricité sans intervention mécanique. Cette découverte marque le début de l'électrochimie[14]. Il en conclut que les phénomènes que Galvani attribuait à l'électricité « animale » sont en fait causés par les instruments métalliques utilisés durant les expériences. Après quelques années, la théorie de l'électricité animale est abandonnée. Il faudra près de trente ans pour que, grâce à des appareils plus sensibles, elle redevienne d'actualité, donnant naissance à l'électrophorèse[15].

Les machines « à frottement » produisant de l'électricité se déclinent en de nombreuses variantes[7], comme celle de Hauksbee, puis celle de Ramsden[16] ou celle de Nairne, qui permet de produire de l'électricité positive ou négative. Elles rendent possibles de multiples recherches expérimentales, mais il y a encore très peu d'utilisations pratiques de l'électricité.

Des spectacles, comme ceux organisés par S. Gray, popularisent « l'électrique » (terme anglais « electric » d'époque). On s'extasie devant la « danse électrique » de la « bluette », petite étincelle sortant du doigt s'approchant d'un corps chargé ; des « électriciens »[V 1] (présentateurs) se chargent en électricité pour produire des étincelles pouvant allumer de la poudre, enflammer de l'alcool ou fournir une secousse aux spectateurs. Une expérience de « béatification électrique »[V 1] est également proposée par le physicien Georg Matthias Bose[L16 1],[17] : c'est une chaise isolante sur laquelle se tient une personne portant une couronne métallique produisant un halo (d'électroluminescence dû au champ électrique). En France, l'abbé Nollet publie des ouvrages de vulgarisation de physique expérimentale et organise des démonstrations spectaculaires de transmission de l'électricité au travers de chaînes humaines allant jusqu'à 140 personnes[18].

L'utilisation thérapeutique de l'électricité est probablement la seule application pratique de l'électricité en dehors des spectacles de divertissement. Sans que la théorie ne puisse encore l'expliquer, des résultats semblent être obtenus. Ainsi Jean Jallabert utilise une machine électrostatique en 1748 et déclare avoir obtenu une amélioration notable en dirigeant la décharge sur les muscles de l'avant-bras d'un patient paralysé[19]. L'électrothérapie se répand dans plusieurs pays : en Angleterre dès la fin des années 1760, en Italie avec les démonstrations anatomiques de Luigi Galvani vers 1770 ou en France où Jean-Paul Marat se voit décerner en 1783 le prix de l'Académie de Rouen pour son Mémoire sur l'électricité médicale[20].

C'est au XIXe siècle que l'électricité connait des avancées théoriques et pratiques décisives qui vont l'amener à prendre une part très importante dans les sciences physiques, en relation notamment avec la chimie, le magnétisme et la lumière. À partir des années 1830, inventeurs, ingénieurs et industriels se saisissent des avancées scientifiques pour imaginer et mettre au point des utilisations, des moyens de production et des systèmes de transport et de stockage de l'électricité qui vont participer à la révolution industrielle, avec un impact rapidement croissant sur l'industrie, les transports, les communications, puis la vie courante.

La première moitié du siècle est jalonnée de découvertes capitales, souvent liées à l'étude de l'électromagnétisme ou de la conductivité, comme celles d'Ampère, Ohm ou encore Faraday.

Dès le début du siècle, on constate qu'un fil métallique relié aux bornes d'une pile s'échauffe[21], et le chimiste anglais Humphry Davy utilise l'électrolyse pour isoler des éléments nouveaux, comme le potassium et le sodium[22] : l'électricité est donc liée, d'un façon encore peu expliquée, à l'énergie et à la chimie. Elle est aussi liée à la lumière, comme le montrent la foudre ou les longs arcs électriques produits par Davy.

En 1820, le danois Hans Christian Oersted constate expérimentalement, sans pouvoir l'expliquer, que le courant parcourant un conducteur crée un champ magnétique associé qui peut modifier la direction indiquée par une boussole[23]. Les recherches conduites par le physicien français André-Marie Ampère entre 1821 et 1825 débouchent sur une théorie expliquant certains des liens mutuels entre électricité et magnétisme : les aimants, notamment, contiendraient des particules magnétiques dans lesquelles un courant circule en permanence. Ampère démontre aussi que lorsque deux fils conducteurs parcourus par de l'électricité sont parallèles et assez proches, ils s'attirent (ou se repoussent) mutuellement comme des aimants : c'est la "force d'Ampère"[24]. Ces travaux relancent la recherche sur l'électromagnétisme.

Les recherches sur la conductivité menées dans les années 1825 par le physicien allemand Georg Ohm l'amènent à formuler une loi selon laquelle la résistance d'un fil conducteur ne dépend pas de la quantité d'électricité qui le traverse mais de la nature du fil, de sa longueur et de son diamètre. Il complète sa théorie en affirmant que le courant électrique n'est pas un fluide physique mais, sous l'effet d'une "tension" appliquée entre les deux extrémités du conducteur[note 9], passe de particule en particule à l'intérieur de celui-ci. Ohm publie ses résultats à partir de 1827, ainsi qu'une théorie explicative aux fondements mathématiques avancés résumée par deux lois d'Ohm. Ses travaux sont initialement peu reconnus, voire contestés, notamment en France, mais finiront par être acceptés, et ses deux lois unifiées en une seule vers le milieu du siècle[25].

Les avancées se poursuivent durant les années 1830 avec l'anglais Michael Faraday, qui avait commencé sa carrière scientifique comme assistant de Davy. Faraday, combinant expérimentation, mise au point de matériels et procédés scientifiques et élaboration de théories explicatives, démontre que si le courant électrique crée un champ magnétique, comme Ampère l'avait mis en évidence, la réciproque est également vraie : il est possible de créer du courant électrique avec un aimant. Dans ses expériences de 1831, Faraday découvre ainsi qu'il suffit de déplacer un aimant par rapport à un conducteur (par exemple une bobine de cuivre) pour qu'y apparaisse de l'électricité[26] : c'est le phénomène d'induction, qui sera plus tard largement utilisé pour produire de l'électricité. Durant la même décennie, Faraday s'intéresse aux matériaux diélectriques, et les caractérise par leur "capacité inductive spécifique", définissant leur comportement dans les condensateurs. Il met aussi au point la fameuse "cage de Faraday", qu'il expérimente lui-même, démontrant que l'électricité appliquée à cette cage n'y pénètre pas, et que l'électricité contenue dans la cage n'en sort pas. Ses apports à l'électrolyse sont également importants, avec la conceptualisation de son mécanisme, la création du vocabulaire correspondant (cathode, anode, ion, etc.), et la preuve que le fonctionnement des piles est entièrement électrochimique, selon le processus inverse de celui de l'électrolyse[22]. À la fin des années 1830, il propose une théorie à base de "champs" et de "lignes de force" lui permettant de déclarer que "L'électricité, quelle qu'elle soit, est de nature identique" et d'expliquer l'action électromagnétique à distance. Au milieu des années 1840, il envisage d'élargir cette approche pour unifier électricité, magnétisme et lumière, mais ne parvient pas à prouver ses intuitions[27].

En 1833, Heinrich Lenz (1804-1865), physicien russe d'origine allemande, établit la loi qui donne le sens du courant induit.

En 1840, Gustav Kirchhoff définit le « potentiel électrique[La 1] »[28].

Au début des années 1840, le physicien britannique James Prescott Joule établit les lois de production de chaleur dans un conducteur parcouru par un courant électrique, phénomène dénommé plus tard comme "effet Joule".

En 1848, Gustav Kirchhoff met au point la loi des mailles et des nœuds en électrocinétique[29], puis, en 1857, il invente l' « équation des télégraphistes » par l'étude de la propagation de signaux électriques le long d'un câble métallique. Ses résultats, étendus en 1880 aux circuits non purement ohmiques, seront très utiles pour la conception des réseaux de transport d'électricité et de communications.

La deuxième moitié du siècle est marquée par deux avancées scientifiques et théoriques majeures réalisées par le mathématicien écossais James Clerk Maxwell puis, à la fin du siècle, par le physicien britannique Joseph John Thomson.

Maxwell, appliquant aux travaux d'Ampère et de Faraday une approche mathématique innovante et complexe, crée les équations de Maxwell, qui constituent depuis un des fondements de la physique moderne unifiant électricité, magnétisme et lumière. Il publie ses recherches à partir de la fin des années 1850, jusqu'à son ouvrage le plus connu et le plus complet publié en 1864 : postulant l'existence d'un "éther" assurant la possibilité d'une action à distance[note 10], il y démontre comment courants et charges électriques, ainsi que champs magnétiques sont en interaction. Ses équations ont une autre conséquence : elles permettent notamment d'analyser la lumière, de même que l'électricité et le magnétisme, comme une onde électromagnétique et de prédire l'existence d'ondes hors du spectre visible. Cette prédiction sera vérifiée en 1888, quand Heinrich Hertz découvrira les ondes radio[27].

La théorie ondulatoire de Maxwell rencontre un grand succès dans le monde scientifique. Cependant, plusieurs physiciens continuent de penser que l'électricité doit être portée par des particules de matière de taille et masse très faibles. La découverte des rayons X par Wilhelm Röntgen[30],[note 11], ainsi que les résultats de certaines de ses expériences et de celles de Hertz, amènent J.J. Thomson à réaliser une série d'expériences sur les rayons cathodiques en 1895 et 1896, dont il publie les résultats à partir de 1897. Thomson y affirme l'existence d'une particule unique, commune à tous les atomes[note 12], de masse très faible, portant une charge électrique constante et qui est à l'origine de tous les phénomènes électriques alors connus[note 13]. De nombreuses expériences ultérieures, nécessitant la mise au point d'instruments de mesure sophistiqués, confirmeront la théorie de J.J. Thomson et les caractéristiques de cette particule qui sera dénommée "électron"[31] : masse d'environ 9,109 × 10−31 kg et charge électrique de −1,602 × 10−19 C.

À la fin du XIXe siècle, l'électricité, comme la lumière et tout autre phénomène électromagnétique, est considérée par les scientifiques comme ayant un forme duale : ondulatoire et corpusculaire.

Deux inventions, celles de l'alternateur et la dynamo, rendent possible la production d'électricité en grande quantités en transformant un mouvement mécanique, généralement rotatif, en électricité :

La plupart des alternateurs et des dynamos industrialisés sont des machines rotatives à fonctionnement cyclique. Elles sont constituées d'une partie fixe (le stator) et d'une partie mobile (le rotor) : l'une est constituée d'aimants, l'autre d'un enroulement (ou bobine) de fil métallique. La rotation du rotor, provoquée par le moteur animant le générateur, crée, par effet Faraday, un courant dans le fil métallique.

La production industrielle et l'efficacité de telles machines doivent beaucoup à l'utilisation d'électroaimants, découverts par le britannique William Sturgeon dans les années 1820, et améliorés dans les années 1830 par l'américain Joseph Henry : ces aimants peuvent être fabriqués simplement avec un cœur de fer doux auquel on peut donner des tailles et des formes très variées.

La variété de générateurs électriques inventés durant le XIXe siècle, comprenant un moteur rotatif entraînant un alternateur ou une dynamo, reflète la créativité de cette période, notamment pour utiliser différentes sortes d'énergie :

Le principe des accumulateurs au plomb, qui permettent le stockage d'électricité sous forme électrochimique est découvert par Wilehlm Josef Sinsteden et perfectionné par le français Gaston Planté en 1859. Le chimiste français Camille Alphonse Faure lui apporte de nouveaux perfectionnements en 1881, créant la possibilité d'une production industrielle et d'usages divers, notamment dans les véhicules terrestres[note 14].

Le transport d'électricité par réseau filaire est un sujet important au XIXe siècle et va être au cœur de ce qu'on appelle à l'époque la " guerre des courants" : est-il préférable de transporter du courant alternatif ou continu ? Et, plus généralement, est-il préférable de produire et utiliser un type de courant plutôt que l'autre ?

Les équations d'Ohm () impliquent que la puissance électrique transportée par un réseau est d'autant plus élevée que la tension appliquée à ce réseau est élevée, et que la résistance du réseau est faible. L'effet Joule implique, quant à lui, que la perte de puissance lors du transport croît avec la résistance du réseau et le carré de l'intensité du courant (). Ces deux lois physiques amènent, pour optimiser le transport d'électricité, à avoir une résistance du réseau la plus faible possible, et une tension appliquée à ce réseau la plus élevée possible[32].

La résistance du réseau est proportionnelle à la résistivité du conducteur utilisé et à sa longueur : pour minimiser les pertes par effet Joule, il faut donc choisir un matériau conducteur de faible résistivité (cuivre, aluminium, etc.) et minimiser la distance de transport. Certaines activités consommatrices, notamment industrielles, peuvent s'implanter près des lieux de production d'électricité. Mais les lieux de consommation d'électricité peuvent aussi se trouver éloignés des lieux de production : il faut alors utiliser une tension élevée pour réduire les pertes en ligne. L'invention des transformateurs électriques permet d'envisager d'augmenter la tension du courant produit par un générateur électrique, ou, au contraire, de l'abaisser pour en faciliter l'usage : les travaux de l'irlandais Nicholas Callan dans les années 1830 puis ceux d'Heinrich Ruhmkorff, qui met au point en 1856 la bobine qui porte son nom, sont utilisés pour produire de façon industrielle des transformateurs à partir de la fin des années 1860. Durant les années 1880, ingénieurs européens et américains explorent différentes solutions pour transporter de l'électricité, en courant continu comme alternatif.

Ainsi, fin , Marcel Deprez réalise une expérience de transport d'électricité entre Vizille et Grenoble sur une distance de 14 km en courant continu, pour éclairer avec 108 lampes Edison la halle du centre-ville de Grenoble[33]. La même année, Lucien Gaulard, chimiste de formation, présente à la Société française des électriciens un « générateur secondaire », dénommé depuis transformateur[33]. Devant le scepticisme de ses compatriotes, il s'adresse à l'Anglais John Dixon Gibbs et démontre à Londres le bien-fondé de son invention. Et, en septembre , Lucien Gaulard et John Dixon Gibb se positionnent pour obtenir un prix lors de l'exposition de Turin et contrecarrer les opposants au transport du courant alternatif : ils mettent en service une liaison de démonstration alimentée par du courant alternatif de 133 Hz sous 2 000 volts et faisant l'aller-retour de Turin à Lanzo (80 km)[note 15]. La grande influence de Deprez amènera la France à continuer un temps de privilégier presqu'exclusivement le déploiement du courant continu, retardant la pénétration de l'électricité dans l'industrie[34].

À cette même période, les États-Unis commencent à s'équiper de moyens de production et de réseaux de transport d'électricité. Edison, dont la compagnie avait remporté plusieurs concessions de production et de distribution, soutient l'utilisation de courant continu, qu'il a employé dans ses expériences et dans ses brevets. Tesla, qui a travaillé d'abord en Europe, rejoint Edison aux États-Unis puis le quitte pour rejoindre le grand concurrent d'Edison, George Westinghouse, qu'il convainc de promouvoir le courant alternatif. À la suite d'une longue bataille, durant laquelle Edison et ses partisans déploient de très importants efforts médiatiques pour démontrer les dangers du courant alternatif[note 16], le courant alternatif qui l'emporte[35], notamment grâce à la mise au point de transformateurs à bon rendement[note 17], puis aux inventions relatives au courant triphasé[note 18]: industriels, municipalités, industries et commerces sont les premiers clients desservis, avant les clients particuliers, qui recevront un peu plus tard l'électricité domestique [L40 1]. C'est la solution la plus largement utilisée dans le monde encore au XXIe siècle[note 19].

Durant le XIXe siècle, l'utilisation de l'électricité révolutionne les communications à distance, qui seront appelées télécommunications, avec l'invention du télégraphe électrique puis du téléphone et, à la fin du siècle, de la transmission sans fil.

Dans les années 1830, alors que le télégraphe optique est encore d'usage récent[note 20], plusieurs projets de communication utilisant des courants faibles pour transmettre des messages écrits sont lancés en Europe et aux États-Unis. La première ligne de télégraphe électrique européenne, conçue par les britanniques Cooke et Wheatstone, entre en service commercial en 1838. Le système est utilisé par les chemins de fer britanniques : il est constitué de plusieurs fils de transmission et de plusieurs aiguilles transcrivant les lettres transmises. Au même moment, l'américain Samuel Morse et son assistant Alfred Lewis Vail inventent et brevètent un système de télégraphe électrique, un récepteur automatique de messages et un langage de transmission de messages : le code Morse. La première ligne américaine de longue distance est installée en 1843 entre Baltimore et Washington.

Le télégraphe électrique connait un très rapide développement international à partir des années 1850[36]: liaison Paris/Berlin (1850), France/Angleterre (1851), Londres/New Delhi (1860), Europe/États-Unis (1866), etc. En France, le volume de télégrammes est multiplié par trente entre 1852 et 1862. Et le télégraphe électrique bénéficie, tout du long du siècle, de nombreuses innovations qui en améliorent les performances, notamment l'invention d'un système de codage avec multiplexage temporel pour les téléscripteurs par le français Émile Baudot[note 21]. La normalisation internationale est amorcée par la première convention télégraphique internationale de 1865, signée par vingt pays à Paris, qui crée l'Union Internationale Télégraphique, ancêtre de l'Union Internationale des Télécommunications[37].

La transmission de la voix intéresse de nombreux inventeurs et ingénieurs à partir des années 1850. Le français Charles Bourseul décrit le principe de ce qui deviendra le téléphone dans la revue L'Illustration en 1854[36], mais, devant le scepticisme rencontré, renonce à développer son concept. Ce sont l'anglo-canadien Alexander Graham Bell et, après une longue controverse et à titre posthume, l'italien Antonio Meucci qui en sont reconnus comme les inventeurs[note 22]. Bell dépose son brevet le plus connu en février 1876, et le téléphone entre en service commercial aux États-Unis en 1877 et en France en 1879. Les inventions de Bell, d'Edison (microphone à charbon), de Clément Adler (amélioration du téléphone de Bell), ou encore celles du suédois Lars Ericsson (numérotation automatique par cadran à dix chiffres) assurent un succès rapide du téléphone aux États-Unis, et, dans une moindre mesure en Europe[note 23] : il y 27 000 téléphones en service dans le monde en 1879 et deux millions en 1900[38].

À partir du début des années 1880, plusieurs découvertes, expérimentales puis basées sur des explications scientifiques, vont permettre la transmission de signaux sans fil, le développement de la radioélectricité et celui des radiocommunications. Les découvertes suivantes amènent à l'invention de la télégraphie sans fil (TSF), ancêtre des systèmes de communication sans fil modernes :

Dès les années 1850, inventeurs et ingénieurs constatent qu'un générateur d'électricité est généralement réversible : alimenté par une énergie mécanique, il produit de l'électricité ; et alimenté par de l'électricité, il devient moteur et produit du travail mécanique[41]. Avant que l'électricité soit produite en grande quantité et transportée efficacement, les moteurs électriques doivent être alimentés en courant par des piles, ce qui limite leur puissance et leur durée de fonctionnement.

Les premiers moteurs électriques sont donc tous alimentés en continu, mais doivent être dotés d'un mécanisme particulier, commutateur ou interrupteur, permettant de créer un fonctionnement cyclique, généralement rotatif.

Parmi les inventeurs de ces premiers moteurs, se trouvent notamment[42] :

L'enthousiasme soulevé par ce type de moteurs dans les années 1850-1860 retombe vite : malgré les progrès des piles et les multiples configurations inventées, ces moteurs restent d'emploi difficile, sont fragiles et ont des performances limitées, notamment à cause du commutateur mécanique alors utilisé. Ils sont considérés comme incapables de rivaliser, pour les usages de "force", avec les machines à vapeur[42].

À partir des années 1870, plusieurs inventions vont relancer l'intérêt envers les moteurs électriques.

En 1873, la société fondée par le physicien belge Zenobe Gramme et l'ingénieur français Hyppolyte Fontaine présente à l'Exposition universelle de Vienne deux "machines Gramme" à courant continu qui fonctionnent l'une en générateur, l'autre en moteur[42], avec un bon rendement et une bonne facilité d'utilisation, notamment grâce à un collecteur frotté par des balais, qui remplace le commutateur mécanique[44]. Ces machines rencontrent un réel succès chez les industriels. À la même période commencent à être fabriqués des rhéostats permettant de régler l'intensité du courant fourni à un moteur, donc sa puissance. Et, à partir de la deuxième moitié des années 1880, Nikola Tesla, associé à Westinghouse, commence à produire les premiers moteurs industriels fonctionnant avec du courant alternatif.

L'offre de ces moteurs s'élargit rapidement[45], et, à mesure du déploiement des sites de production et des réseaux de transport électriques, les moteurs électriques pénètrent progressivement l'industrie, animant notamment des machines à coudre, des métiers à tisser ou encore des ascenseurs, ainsi que les transports, notamment avec le déploiement du tramway électrique aux États-Unis puis dans certains pays européens[46].

Les origines de l'électrochimie et de l'électrométallurgie, comme sciences et comme secteurs industriels, remontent aux expérimentations scientifiques relatives à l'électrolyse et aux piles qui ont débuté au tout début du siècle.

La première électrolyse de l'eau est réalisée en par Volta et William Nicholson, qui parviennent en outre à prouver que les gaz produits par cette opération sont de l'hydrogène et de l'oxygène dans un rapport d'un volume d'oxygène pour deux d'hydrogène[47]. Scientifiques et inventeurs vont ensuite multiplier les découvertes expérimentales : pile cuivre/zinc (William Cruikshank, 1802), galvanoplastie (Jacobi, 1837), accumulateur au plomb (Gaston Planté, 1859), loi de la résistance des électrolytes (Friedrich Kohlrausch, 1874[48]), électromouillage (Gabriel Lippmann, 1875), etc.

Au début des années 1850, plusieurs éléments métalliques (aluminium, baryum, calcium, chrome, lithium, magnésium, manganèse, potassium, sodium, etc.) sont produits par électrolyse en laboratoire[note 24], notamment par le chimiste allemand Robert Wilhelm Bunsen[48].

Certains des procédés expérimentaux commencent aussi à être utilisés par des industriels dans les années 1840, par exemple la galvanoplastie par la société Christofle en France. Mais la compréhension des phénomènes en jeu reste fragmentaire jusqu'au milieu des années 1880, et leur utilisation industrielle très limitée.

En 1884, le chimiste suédois Svante August Arrhenius publie sa Théorie chimique des électrolytes, fondement des développements ultérieurs de l'électrochimie scientifique et industrielle, puis, en 1887, élabore la théorie des couples acide-base et de la dissociation ionique[48]. En 1889 le physicien allemand Walther Hermann Nernst établit et formule le lien entre la force électromotrice d'une pile et la nature de ses composants et de son électrolyte, permettant de prédire et calculer la dynamique électrochimique[48]. Avec ces résultats et une électricité plus facilement disponible grâce aux progrès réalisés par les générateurs électriques, les ingénieurs font de l'électrolyse un procédé industriel essentiel avant la fin du siècle, notamment pour les productions métallurgique et chimique.

La production industrielle de cuivre très pur par électrolyse commence dans les années 1870[49]. Et la production industrielle d'aluminium va être rendue possible à partir du milieu des années 1880 grâce à l'ingénieur français Paul Héroult[note 25] et à l'américain Charles Martin Hall qui découvrent et brevètent quasiment simultanément, et séparément, le procédé de fabrication industrielle de l'aluminium par électrolyse en 1886[50]. Ce procédé permet la production importante d'aluminium en Europe dès 1887, avec l'installation par Héroult de l'usine de la chute de Froges alimentée par de l'hydroélectricité[note 26]. À la même époque est créée aux États-Unis la société Alcoa pour exploiter les brevets et procédés de Hall. L'aluminium va connaître ensuite une très large diffusion dans les câbles électriques, les télécommunications, les transports, puis bien d'autres secteurs. Plusieurs autres métaux sont également produits ou raffinés industriellement par des procédés électriques avant la fin du siècle, comme le platine, le nickel ou encore le cobalt. L'électrolyse est aussi utilisée pour analyser la teneur en métaux utiles des minerais.

L'électrolyse est utilisée par le secteur de la chimie minérale à partir des années 1880 pour fabriquer une grande variété de molécules et produits ayant un impact important sur l'industrie et la vie quotidienne[51]. Parmi ceux- ci :

L'électrolyse est également utilisée dans plusieurs autres secteurs. Ainsi, en , est mise au point « l'électrode à hydrogène » qui permet de faire les premières mesures de pH[48]. Et les premiers télégraphes utilisent un montage électrique avec électrolyse au poste final récepteur : l'observation de la production des bulles de gaz dans un électrolyte permet de recueillir le signal[note 27].

L'une des premières applications "grand public" de l'électricité est l'éclairage, public puis privé[21].

Les premières lampes électriques sont "à arc" : elles sont constituées de deux électrodes auxquelles est appliquée une tension qui crée un arc lumineux entre elles. L'électrotechnicien russe Paul Nicolaïewich Jablochkoff les perfectionne et, sous le nom de "bougies électriques" ou "bougies Jablochkoff", elles sont installées dans certaines rues de Paris et de Londres, puis dans d'autres pays, à partir de 1879[52]. Cette technologie présente plusieurs défauts : la durée de vie des lampes est faible et la lumière émise est très intense, donc gênante, voire dangereuse, pour l'œil humain. Elle n'arrive pas à concurrencer l'éclairage au gaz et ne sera utilisée que dans quelques villes en éclairage extérieur puis, plus tard, pour les projecteurs de cinéma.

À la fin des années 1870, le britannique Joseph Swan et l'américain Thomas Edison, qui ont chacun déposé des brevets sur les lampes à incandescence, s'unissent pour créer une société les fabriquant et les commercialisant. Ces lampes fonctionnent sur un principe différent de celui des lampes à arc : un filament (de coton ou de carbone) inclus dans une enceinte étanche en verre contenant du vide s'échauffe lorsqu'il est parcouru par du courant électrique et émet de la lumière. Moins puissantes mais plus sûres que les lampes à arc, les lampes à incandescence permettent le développement de l'éclairage domestique. Plusieurs améliorations visant à augmenter la durée de vie des ampoules et leur pouvoir éclairant seront ensuite apportées à ce système, notamment en emplissant l'ampoule d'un gaz noble et en utilisant divers matériaux pour le filament, comme la céramique. Cette technologie remplace progressivement l'éclairage au gaz et sera ensuite continûment utilisée jusqu'au XXIe siècle.

Inventeurs et ingénieurs se saisissent des inventions relatives à la production et au transport de l'électricité, aux moteurs électriques et aux batteries pour concevoir des moyens de transport utilisant l'électricité : transport sur rails, véhicules automobiles, etc.

Le transport sur rail s'est développé depuis la fin du XVIIIe siècle, la traction étant assurée par des animaux ou des locomotives à vapeur. La traction électrique va trouver à partir des années 1870 une place croissante dans ce secteur, offrant plus de puissance et de rapidité que la traction animale, et moins de bruit et de fumée que celle à vapeur.

Les premières démonstrations de faisabilité ont lieu au milieu des années 1830[53] : en 1837, l'écossais Robert Davidson fait rouler à Aberdeen une locomotive électrique dont l'alimentation est assurée par des batteries embarquées[33]. Le développement industriel et commercial commence à la fin des années 1870 avec de l'électricité produite à distance et transportée jusqu'aux moteurs embarqués par les rails ou un réseau filaire aérien à caténaires.

En 1879, à l'exposition universelle de Berlin, un train de démonstration avec une locomotive électrique conçue par Werner von Siemens transporte 86 000 voyageurs en quatre mois[53]. L'alimentation en 150 V continu est assurée par un troisième rail sur lequel roule un galet collecteur. Deux ans plus tard, Siemens fait à Paris une démonstration avec alimentation par ligne aérienne[note 28].

La traction électrique va ensuite se déployer dans les différentes variantes de transport sur rails :

Les batteries d'accumulateurs au plomb permettent à partir de 1880 la création de véhicules électriques autonomes pouvant concurrencer les automobiles équipées de moteur à essence ou de moteur à vapeur.

Ainsi, en 1881 l'ingénieur français Gustave Trouvé conçoit et produit un tricycle électrique[57], et Charles Jeantaud produit son premier modèle d'automobile électrique, qu'il améliore ensuite pour atteindre 60 km d'autonomie avec 400 kg d'accumulateurs rechargeables[58].

À la fin des années 1890 des taxis électriques, qualifiés de "fiacres sans chevaux", sont mis en service à New York, Londres puis Paris[59]. Et en 1899 c'est une voiture électrique, la Jamais Contente, qui est la première automobile à dépasser les 100 km/h.

Les voitures électriques sont particulièrement appréciées aux États-Unis : à la fin du siècle, une voiture américaine sur trois est électrique[60]. Les automobiles à moteur thermique vont ensuite supplanter leurs concurrentes électriques, qui disparaissent quasi complètement avant de réapparaître à la fin du XXe siècle.

L'électricité n'est cependant pas absente des véhicules à moteurs thermiques. Elle y assure même des fonctions importantes dès leurs débuts. Ainsi, par exemple, les bougies d'allumage, inventées dans les années 1880, créent un arc électrique déclenchant la combustion du carburant ; une magneto, inventée en 1894, est entraînée par le moteur et alimente les bougies ; une batterie permet le stockage local d'électricité et l'alimentation des ampoules à filament assurant l'éclairage ; etc.

L'utilisation croissante de l'électricité entraîne la production d'une large variété de produits industriels et suscite la création d'entreprises qui adressent plusieurs aspects du nouveau marché l'électrotechnique, notamment[64] :

Parmi les très nombreuses entreprises industrielles liées à l'électricité créées à cette époque, certaines seront en activité pendant plusieurs décennies, notamment : Siemens (Allemagne, 1847), Westinghouse, (États-Unis, 1886), General Electric (États-Unis, 1892), Marconi (Grande-Bretagne,1897), etc.

A partir de 1830, le corps médical intègre l'électricité dans ses pratiques :

Dès les années 1880, les premiers ouvrages de référence consacrés à l'usage de l'électricité en médecine paraissent, comme celui du médecin allemand Wilhelm Erb, et des revues spécialisées lui sont consacrées, comme L'électrothérapie dirigée par le Dr Léon Danion[69].

Depuis le XVIIe siècle, plusieurs inventeurs ont contribué à créer un vocabulaire lié à l'électricité pour décrire leurs expériences, résultats et théories, depuis Gray qui crée le mot "electric" en 1600 jusqu'à Ampère (courant, tension) ou encore Faraday (cathode, anode, ion) dans la première moitié du XIXe siècle. C'est en 1881 que se tient, à Paris, le premier Congrès international des électriciens qui va définir officiellement plusieurs grandeurs concernant l'électricité[70]. Le Congrès choisit de les nommer d'après des scientifiques ayant contribué à leur découverte : ampère (intensité, symbole I), volt (tension ou potentiel, V), ohm (résistance, Ω), farad (capacité, F), coulomb (charge électrique, C). Et il en donne une définition précise. Deux de ces grandeurs sont définies directement (V, Ω), les autres en sont dérivées par les formules de base connues à l'époque. Ainsi, par exemple, la formule V=R*I, ou R est exprimé en ohms et V en volts, permet de définir 1 ampère comme l'intensité I du courant créé dans un conducteur de résistance 1 Ω par une tension de 1 V. Avant la fin du siècle, le Congrès élargira la liste de ces grandeurs normalisées, avec notamment le joule, le watt et le henry[71].

Les rapides progrès de l'électricité dans la deuxième moitié du siècle suscitent un réel enthousiasme tant chez les scientifiques que chez les industriels, les intellectuels et le grand public : cette énergie au comportement encore largement mystérieux est surnommée "la fée électricité", tant elle parait capable de multiples applications, sans produire les nuisances sonores, visuelles et olfactives des machines à vapeur ou des moteurs thermiques[72].

Sa présence dans les expositions universelles ou internationales va croissant, dévoilant chaque fois de nouvelles avancées, bientôt considérées comme symboles de la modernité[73] : télégraphe (1867), moteur (1873), éclairage public et téléphone (1878), train (1879), ascenseur (1880), tramway (1881), éclairage par incandescence (1881), trottoir roulant (1893), cuisine électrique (1893), etc.

Les romanciers d'anticipation s'enthousiasment pour ces nouveautés[74], comme Jules Verne dans Vingt Mille Lieues sous les mers qui imagine le sous-marin Nautilus propulsé par l'électricité (1868) ou Albert Robida dans Le Vingtième siècle. La vie électrique (1890) qui écrit[75] : « C’est la conquête définitive de l’Électricité, du moteur mystérieux des mondes qui a permis à l’homme de changer ce qui paraissait immuable, de toucher à l’antique ordre des choses, de reprendre en sous-œuvre la Création, de modifier ce que l’on croyait devoir rester éternellement en dehors et au-dessus de la Main humaine ! ». De nombreuses revues, techniques ou plus grand public, sont publiées, auxquelles participe notamment Louis Figuier, un des plus actifs vulgarisateurs scientifiques de l'époque.

L'exposition universelle de 1900 à Paris conclut le siècle. Desservie par les lignes de métro électrique inaugurées pour l'occasion, elle donne une place prééminente à l'électricité[76], le Palais de l'Électricité qui, illuminé par 7000 lampes et surmonté de la statue du génie électrique, accueille moyens de production et exemples des multiples utilisations, industrielles ou domestiques, de l'électricité. Les visiteurs peuvent aussi essayer un trottoir électrique à trois voies sur plus de 3 km.

Même si certains pressentent que l'électricité n'est pas exempte de défauts et de risques[75], ou questionnent son avenir face aux "rois" charbon et vapeur[77], l'électricité aborde le XXe siècle avec de nombreux atouts.

Malgré les très nombreuses avancées réalisées au XIXe siècle, la diffusion et l'utilisation de l'électricité sont encore très limitées au début du XXe siècle, même dans les pays industrialisés : l'industrie utilise encore principalement des machines à vapeur, et l'éclairage et la traction représentent la plus grande partie des consommations électriques.

La situation change complètement dès le premier tiers du siècle : production et consommation d'électricité connaissent une très rapide croissance, tout particulièrement dans les années 1920 et 1930. La progression de la consommation, favorisée par le développement des réseaux de transport et de distribution, est marquée tant dans l'industrie que chez les particuliers. En France, la consommation passe de 340 MWh en 1901 à 2 180 MWh en 1916, puis 11 000 MWh en 1926[78]. À la fin des années 1920, l'industrie lourde (électrochimie et métallurgie essentiellement) consomme les trois quarts de l'électricité en France, alors que l'éclairage et les usages domestiques n'en représentent qu'environ 10%. Grâce aux programmes d'électrification rurale[note 33], 97% de la population française est desservie par l'électricité en 1938 : éclairage et usages domestiques sont multipliés par 2,5 en 10 ans[79]. La France n'est d'ailleurs pas le pays européen le plus rapidement électrifié : à la fin des années 1930, la consommation annuelle totale ramenée au nombre d'habitants y est de l'ordre de 300 KWh/habitant, contre 430 en Allemagne et en Grande-Bretagne. La progression est encore plus rapide aux États-Unis, où la consommation, à la même époque, est proche de 720 KWh/habitant.

À partir de la fin de la seconde guerre mondiale, l'électricité se répand dans tous les pays et tous les secteurs de l'industrie, des services et de la vie courante, notamment grâce à l'invention de l'électronique, à la miniaturisation de nombre de dispositifs électriques, à l'informatique, à la production en grande série d'appareils électroménagers, à la radio, à la télévision, aux réseaux de données, à l'internet et aux communications mobiles.

Reflet de l'importance de l'électricité dans la recherche scientifique, nombre des prix Nobel de physique sont attribués pour des découvertes liées à l'électricité : 1901 (Roentgen, rayons X), 1905 (Lenard, rayons cathodiques), 1906 (Thomson, conductivité des gaz), 1909 (Marconi et Braun, télégraphie sans fil), 1919 (Stark, diffraction par champ électrique), 1921 (Einstein, effet photoélectrique), 1923 (Millikan, charge élémentaire), 1929 (de Broglie, nature ondulatoire de l'électron), etc. Et beaucoup des autres prix Nobel de physique sont relatifs à sujets connexes, comme la physique des particules, dont les protocoles expérimentaux sont quasiment tous à base d'électricité.

La théorie électrique-électronique ondulatoire/particulaire de la matière a été constatée avec les « rayons "X" » à la fin du XIXe siècle. Puis elle a été expérimentée dès le début du siècle : en Angleterre par la lumière de diode, en France avec le rayonnement de matières minérales avec son traçage sur de la matière "photographique" ; la lumière a conservé - sinon augmenté - son attrait dans l'esprit humain scientifique et symbolique. Les travaux de Louis de Broglie permettront après cette époque la vision de l'« infiniment petit » avec la microscopie électronique[L1b 2] qui touche tous les secteurs de la science qui se constitue, de la géologie au monde du vivant.

Basé sur les mêmes fondements, au début de ce XXe siècle, on invente le circuit électronique, une version à différence de potentiel polarisé du circuit électrique. L'électronique en tant que domaine de savoir apparaît donc comme la version « spécialisée moderne »[note 34] de l'électricité et s'en dissocie temporairement.

Le XXe siècle est une période où la modélisation de Newton et sa trilogie « gravité-électricité-magnétisme » laissent la place à la spécialisation théorique de la mécanique quantique.

L'électron devient, suivant les découvertes de Bohr et Pauli durant les années 1920, une particule élémentaire caractérisée par quatre nombre-propriétés à valeurs unitaires. Puis, après , est analysé comme un « lepton sans sous-structure[80] ».

Cette mise en théorie qui postule l'antimatière[81] où les photons de la lumière ont une charge électrique nulle requiert pour l'expérimentation des instruments de recherche fondamentale combinant champ électrique et champ magnétique[82]. Le premier de ceux-ci est le cyclotron utilisable vers , suivi des autres machines de la « mécanique des quanta »[L1b 2]. (Le premier accélérateur linéaire de particules en France a été installé à Orsay en 1970). Il est aussi mis en place des interféromètres dans des laboratoires institutionnels.

Par la mise en place conséquente de la statistique applicable aux électrons dans les années 1925-30, incidemment, cette recherche sur la constitution de matière hors des voies mathématiques traditionnelles aboutit à la réaction en chaîne « atomique » en 1942.

La supraconductivité est étudiée avec l'aide de la physico-chimie des cristaux dans la deuxième partie du XXe siècle. Par l'excitation thermique donnée par l'électricité au niveau de l'atome sous « champ électrique » (les bandes d'énergie), le rendement nécessaire est atteint : cette supraconductivité trouve un usage dans les ambiances ordinaires non utopiques, et utilise les nanotechnologies.

Après les travaux de recherche de 1920-1930, la conduction par ondes est établie[pas clair].

Pour ce qui concerne l'effet de champ électromagnétique comme énergie chauffante, les recherches aboutissent depuis 1923 à la construction de fours à Haute Fréquence[L4 1], avec une théorisation de l'induction électromagnétique[R 1]. (Cette énergie est utilisée très communément[83] depuis pour le recyclage des ferrailles et pour le forgeage de pièces serties électro-refoulées).

Dans les années 1960, le développement de la recherche appliquée issue de la théorie ondulatoire/particulaire sur la résistivité liée à la lumière des semi-conducteur aboutit[L2 1]. Elle permit la première étape du développement de conversion d'énergie de la lumière dans des capteurs physiques (essentiellement pour l'ordinaire utile dans la photographie). La deuxième étape, celle que la technique installe dans le monde développé industriel comme source d'énergie, est la conversion pure de l'énergie de la lumière solaire en énergie électrique[L2 2]. Elle aboutit aux panneaux solaires.

La recherche sur la résistance des matériaux à l'échelle microscopique a été démarrée dans la deuxième moitié du XXe siècle, elle se fait conjointement avec la recherche sur les structures minces donnant les semi-conducteurs à l'échelle nanométrique. Cela aboutit à une application hors des laboratoires au XXIe siècle (Nanoparticules, nanomatériaux et applications commercialisées)[R 2]. La conduction électrique est dépendante de la constitution cristalline du matériau : suivant la forme de la maille physique de la spirale, le carbone peut être métallique ou semi-conducteur (et les caractéristiques mécaniques sont dépendantes de l'homogénéité). On y découvre aussi que le courant électrique n’est plus constitué d’un flux continu d’électrons mais qu’il est par « paquets d'électrons » dans certaines structures de circuit.

En 2005 un premier prototype d'écran à partir de nanotubes est fabriqué[R 3]. La conduction électrique des nano-réseaux cristalins souples en carbone est déjà mise à profit à partir de 2016 pour faire les toiles souples photovoltaïques[84]. (C'est l'espoir de l'autonomie pour le « nomadisme des loisirs », et une participation possible à la « gouvernance énergétique » des immeubles).

La production d'électricité connait une très rapide croissance dans tous les pays industrialisés dès le début du siècle, et, à partir de la fin de la seconde guerre mondiale, dans la plupart des pays (Japon, Chine, Inde, etc.). Cette croissance s'accompagne d'une évolution de la part des différentes sources d'énergie utilisées : aux centrales hydrauliques et thermiques classiques s'ajoutent, dans certains pays, les centrales nucléaires puis, à la fin du siècle, les productions à base d'énergies renouvelables décarbonées (éolien, solaire, géothermie) ou carbonées (biomasse). La part respective de ces différents moyens de production est très variable selon les pays, dépendant des caractéristiques climatiques et géographiques, des orientations politiques et de l'acceptabilité locale des différents moyens de production. Au début des années 2020, 60% de l'électricité mondiale est encore produite à partir de combustibles fossiles (charbon, fioul, gaz), notamment dans des pays en fort développement comme la Chine (64%) et l'Inde (78%).

Le tableau suivant donne l'origine de l'électricité dans le monde et dans les pays ayant les plus importantes productions en 2023[85] :

| Origine de l'électricité : | Fioul | Gaz | Charbon | Nucléaire | Hydraulique | Autres renouvelables | Autres | Total | |

|---|---|---|---|---|---|---|---|---|---|

| Monde | TWh | 698 | 6746 | 10513 | 2738 | 4240 | 4748 | 241 | 29925 |

| % | 2,3 | 22,5 | 35,1 | 9,1 | 14,2 | 15,9 | 0,8 | 100 | |

| dont : | |||||||||

| TWh | 11,2 | 297,8 | 5753,9 | 434,7 | 1226,0 | 1668,1 | 64,7 | 9456,4 | |

| % | 0,1 | 3,1 | 60,8 | 4,6 | 13,0 | 17,6 | 0,7 | 100 | |

| TWh | 17,7 | 1937,7 | 738,4 | 816,2 | 236,3 | 737,3 | 10,3 | 4493,9 | |

| % | 0,4 | 43,1 | 16,4 | 18,2 | 5,3 | 16,4 | 0,2 | 100 | |

| TWh | 2,8 | 52,6 | 1471,3 | 48,2 | 149,2 | 232,8 | 1,3 | 1958,2 | |

| % | 0,1 | 2,7 | 75,1 | 2,5 | 7,6 | 11,9 | 0,1 | 100 | |

| TWh | 4,8 | 89,9 | 23,6 | 89,0 | 364,2 | 57,0 | 4,7 | 633,2 | |

| % | 0,8 | 14,2 | 3,7 | 14,1 | 57,5 | 9,0 | 0,7 | 100 | |

| TWh | 1,8 | 32,3 | 0,9 | 338,2 | 55,5 | 84,3 | 6,7 | 519,7 | |

| % | 0,3 | 6,2 | 0,2 | 65,1 | 10,7 | 16,2 | 1,3 | 100 | |

| TWh | 4,9 | 77,7 | 127,8 | 7,2 | 19,6 | 252,8 | 23,6 | 513,6 | |

| % | 1,0 | 15,1 | 24,9 | 1,4 | 3,8 | 49,2 | 4,6 | 100 | |

Il y avait environ 1 000 grands barrages dans le monde en 1900. Près de 40 000 sont construits et mis en service durant le XXe siècle[86], notamment aux États-Unis, au Canada, en Italie, en France et en Suisse qui sont, à la fin des années 1930, les cinq pays produisant le plus d'hydroélectricité[87], puis dans de nombreux autres pays (Russie, Chine, Inde, Égypte, Brésil, etc.). Au début des années 2020, les cinq pays les plus importants producteurs d'hydroélectricité sont la Chine, le Brésil, le Canada, les États Unis et la Russie. Dans les années 2000, l'hydroélectricité représente 16 % de la production mondiale, les pays où l'hydraulique a la plus grande part dans la production d'électricité étant le Paraguay (99,7%) et la Norvège (87,5%)[88]. En France, la production hydraulique représente 11 % de la production nationale d'électricité au début des années 2020[89].

L'essentiel de l'hydroélectricité est produite dans des barrages. Plusieurs autres techniques sont aussi utilisées mais dans des proportions très limitées : chutes d'eau en conduites forcées ou encore utilisation des courants de marée, comme dans l'usine marémotrice de la Rance.

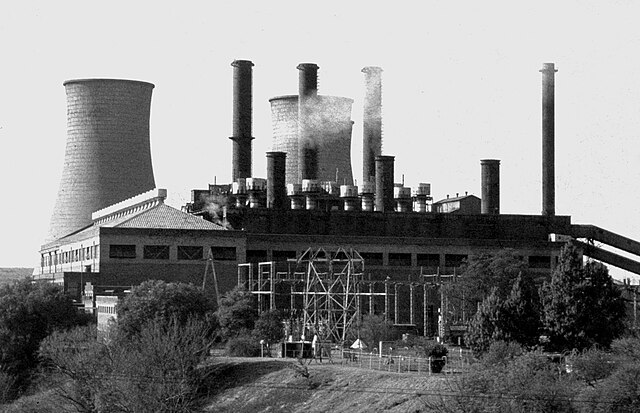

La production d'électricité dans des centrales thermiques brûlant un combustible fossile (charbon, fioul ou gaz) se développe considérablement au XXe siècle.

Les centrales à charbon ont historiquement été déployées dans les pays disposant d'importantes réserves de cette ressource : Allemagne, Etats-Unis, Chine, Inde, etc. Elles sont encore, au début du XXIe siècle, la première source d'électricité et ont représenté jusqu'à 40% de la production mondiale au début des années 2000, consommant environ les deux tiers de la production mondiale de charbon[90]. Une lente décroissance relative s'est amorcée depuis, résultant d'une baisse significative dans les pays de l'OCDE et d'une poursuite de l'augmentation dans d'autres pays, comme la Chine[91]. Le désengagement des pays de l'OCDE traduit des orientations de politique énergétique visant à utiliser d'autres méthodes de production (gaz, nucléaire, énergies renouvelables) moins polluantes.

Les centrales au gaz sont la deuxième source mondiale de production d'électricité, assurant un peu moins du quart de la production totale. Selon les pays, elles sont utilisées en production régulière ou seulement en période de pointe de consommation. Les centrales au fioul n'ont, depuis les chocs pétroliers, qu'une place très réduite dans la production mondiale (3%), et sont utilisées principalement lors des pointes de consommation[92].

Depuis les années 1950, un nouveau type de centrale électrique thermique est déployé : les centrales nucléaires. Il s'agit de centrales à vapeur dans lesquelles la chaleur produisant la vapeur ne provient pas de la combustion d'un produit carboné, mais de l'énergie dégagée par une réaction en chaîne provoquée et contrôlée au sein d'un réacteur nucléaire utilisant un matériau radioactif, généralement composé d'uranium enrichi. La production d'électricité est la plus importante application civile de l'énergie nucléaire. Les premières centrales de ce type, mises en service dans les années 1950, sont de puissance limitée : Idaho (USA, 1951, 400 kWe), Oubninsk (Russie,1954, 5 MWe), Marcoule (France, 1956, 3 MWe), Calder Hall (Royaume-Uni, 1956, 49 MWe), Shippingport (USA, 1957, 68 MWe). Elles ont pour la plupart, en sus de la production d'électricité, un rôle de recherche, civile et militaire. La puissance des réacteurs installés ensuite augmente rapidement pour atteindre plus de 900 MWe à partir des années 1980.

Au début des années 2020, la production électronucléaire représente environ 10% de la production mondiale totale. Elle est réalisée par 440 réacteurs répartis entre 34 pays. Trois pays (Chine, États-Unis et France) détiennent à eux seuls plus de la moitié de la capacité électronucléaire mondiale. Le tableau ci-dessous indique, pour les pays ayant le plus grand produit intérieur brut, le nombre de réacteurs en service, la puissance électronucléaire installée et la proportion d'électronucléaire dans leur production d'électricité[93]:

| Pays | Réacteurs (nombre) | Puissance totale (MWe) | Part du nucléaire dans la production nationale (%) | Part du nucléaire mondial | Commentaires |

|---|---|---|---|---|---|

| États-Unis | 94 | 96952 | 19,7 % | 24,5 % | |

| Chine | 56 | 54362 | 4,9 % | 13,7 % | 26 réacteurs supplémentaires en construction |

| Allemagne | 0 | 0 | 0 % | 0 % | Arrêt des derniers réacteurs en 2023[94] |

| Japon | 33 | 31679 | 5,1 % | 8,0 % | 2 réacteurs supplémentaires en construction |

| Inde | 23 | 7425 | 3,3 % | 1,9 % | 7 réacteurs supplémentaires en construction |

| Royaume-Uni | 9 | 5883 | 14,5 % | 1,5 % | 2 réacteurs supplémentaires en construction |

| France | 56 | 61370 | 67 % | 15,5 % | 1 réacteur supplémentaire en construction |

| Italie | 0 | 0 | 0 % | 0 % | Arrêt des derniers réacteurs en 1990[95] |

| Brésil | 2 | 1884 | 2,1 % | 0,5 % | 1 réacteur supplémentaire en construction |

| Canada | 19 | 13661 | 14,6 % | 3,4 % | |

| Russie | 36 | 28602 | 20,6 % | 7,2 % | 4 réacteurs supplémentaires en construction |

La concentration de l'électronucléaire dans un nombre limité de pays s'explique par plusieurs facteurs :

Deux sources d'énergie renouvelables et décarbonées prennent une place croissante dans la production mondiale d'électricité à partir de la fin des années 1970 : l'éolien et le solaire. Toutes deux ont comme caractéristique commune d'être "intermittentes" : la production ne peut être entièrement pilotée, car elle dépend du vent (éolien) ou du rayonnement solaire (solaire, qui a donc un cycle jour/nuit). Elles permettent aussi de produire de l'électricité de façon décentralisée pour une consommation locale, ce qui permet d'électrifier des sites isolés ou éloignés des réseaux de distribution.

La production d'électricité par éolienne est une technique dont l'origine remonte aux années 1890. Mais avant les années 1970, la production mondiale par éoliennes reste très faible. Des déploiements importants commencent alors au Danemark, puis dans de nombreux autres pays. Le principe est d'appliquer l'énergie mécanique du vent à une machine tournante qui produit de l'électricité. La très grande majorité des éoliennes sont à axe horizontal : un mât, dont la hauteur peut dépasser 180 mètres, supporte à son sommet un axe horizontal supportant une hélice dont le diamètre peut dépasser 250 mètres[96]. Un autre type d'éolienne, moins répandu, est à axe vertical : le mât et le rotor sont dans le même axe et la structure tournante a une forme complexe. Ces éoliennes sont moins encombrantes et plus silencieuses que leurs homologues à hélice. Les éoliennes peuvent être implantées à terre, fixées au sol par des blocs de béton, ou en mer, fixées au fond ou flottantes et ancrées au fond.

En 2022, près de 2 105 TWh d'électricité ont été produits par des éoliennes dans le monde, les plus gros producteurs étant la Chine (36%), les États-Unis (21%), l'Allemagne (6%), le Brésil (4%), le Royaume-Uni (4%), l'Inde (3%), l'Espagne (3%) et la France (2%)[97]. En 2023, l'éolien a produit près de 9% de l'électricité mondiale, devenant la cinquième source d'électricité derrière le charbon (36%), le gaz (22%), l'hydraulique (14%) et le nucléaire (10%)[98].

La production d'électricité à partir du rayonnement solaire est essentiellement réalisée par effet photoélectrique[note 35] dans des cellules photovoltaïques à base de semi conducteurs. Lorsque ces cellules sont nombreuses, elles sont disposées en plaques dites "panneaux solaires". Illuminées par le rayonnement solaire, elles produisent du courant continu. Le rendement d'une cellule, comme celui d'un panneau, dépend de la qualité des cellules, de la durée d'ensoleillement et de l'orientation de la cellule par rapport à cet ensoleillement[note 36]. La première utilisation notable de cette technologie apparait dans les années 1950 sur des satellites qui, une fois en orbite, déploient des panneaux solaires articulés leur permettant une auto alimentation électrique[99]. La production terrestre d'électricité commence vers les années 1970 avec l'utilisation de panneaux solaires couvrant des toits, des terrasses, et même des champs entiers. De très nombreux petits objets du quotidien (calculettes, montres, etc.) utilisent également cette technologie.

En 2022, la production photovoltaïque a dépassé 1 320 TWh, en augmentation de 25% par rapport à l'année précédente. Les pays produisant le plus d'électricité solaire sont la Chine (32% de la production mondiale), les États-Unis (16%), le Japon (8%), l'Inde (7%) et l'Allemagne (5%)[100].

Géothermie

L'utilisation de la géothermie pour produire de l'électricité reste très limitée. Les tentatives du début du XXe siècle en Italie restent sans suite. Les déploiements sur des sites favorables commencent dans les années 1960[101]. Seule l'Islande produit une partie significative (27%) de son électricité grâce à cette technologie[102].

Outre la généralisation de l'éclairage, la percée de l'électricité dans la vie courante peut être illustrée par la très forte pénétration de divers appareils électroménagers dans les pays industrialisés en moins d'un siècle : au début des années 2000, le taux d'équipement des ménages français en réfrigérateur, par exemple, est de 98% ; il est de 90% pour les lave-linge, de 93% pour les téléviseurs couleur, et dépasse 60% pour les chaînes hifi et les fours à micro-ondes[103].

De nombreuses entreprises se créent durant le XXe siècle sur ce segment de marché : Hoover (aspirateurs, États-Unis, 1908), Whirlpool (Etats-Unis, 1911), Electrolux (Suède, 1912), Bauknecht (Allemagne, 1919), Indesit (Italie, 1930), Moulinex (France, 1937), etc. Et plusieurs groupes industriels déjà présents dans d'autres segments de l'industrie s'y diversifient comme General Motors (marque Frigidaire, 1919), Philips (radio et téléviseurs à partir des années 1920), Neff (plaques à induction et fours à micro ondes, années 1950).

La croissance de leurs ventes s'appuie beaucoup sur de la publicité, parfois relayée par des enseignements de "science ménagère", à destination des femmes, vantant la modernité de ces nouveaux appareils, leur facilité d'emploi et le gain de temps qu'ils permettent[104].

L'usage des télécommunications connait une très forte croissance à partir des années 1950[105] : au milieu des années 1990, dans les pays industrialisés, 90 % des ménages ont une ligne téléphonique. Cette croissance est amplifiée puis relayée par celle des communications mobiles : le nombre de téléphones mobiles pour 1 000 habitants dans ces pays est multiplié par huit entre 1990 et 1996. La pénétration du mobile se généralise ensuite à tous les pays[106] : en 2017, cinq milliards de personnes sont équipées de téléphones mobiles, dont plus d'un milliard en Chine et 730 millions en Inde.

Les fonctions de communication offertes par les terminaux mobiles évoluent rapidement : voix, puis SMS et, depuis le début des années 2000, accès à Internet à haut débit. Leur ergonomie évolue également avec l'apparition, à la même époque, d'écrans tactiles de grande taille, entraînant la disparition des touches de numérotation. Ce type d'appareil, surnommé smartphone, est doté de nombreuses autres fonctions : prise de photos et de vidéos, restitution de contenus sonores ou visuels, animés ou non, horloge, chronomètre, calendrier, etc.

Plusieurs marques, dont certaines encore en activité dans ce segment de marché, ont participé à l'essor de la téléphonie mobile, notamment Nokia, Sony Ericsson, Blackberry, Apple, considéré comme l'inventeur du smartphone avec l'iPhone, Samsung, ou, plus récemment, le chinois Huawei.

L'équipement en ordinateurs et l'accès à Internet sont également en très forte croissance à partir des années 1980 : le taux des ménages français ayant un ordinateur, par exemple, passe de 13% en 1995 à 45% en 2006 et 95% en 2017 ; et l'accès à Internet de 31% en 2004 à 84% en 2017.

L'accès et l'usage d'Internet sont, au début des années 2020, très généralisés : près des deux tiers de la population mondiale à accès au Web[107]. Les disparités régionales sont cependant encore importantes : plus de 90% de pénétration en Europe de l'Ouest et aux États-Unis, environ 60% en Chine, autour de 40% en Afrique[108].

Le "progrès industriel" banalise l'utilisation de la lumière électrique dans et hors de l'environnement urbain aussi bien pour l'alimentation humaine directe qu'en objets alimentaires transformés pour le bétail. Et sur la jonction du XXe siècle au XXIe siècle l'électricité est utilisée tout aussi bien pour les autres usages des plantes faits par les hommes urbains.

Le XXe siècle est le siècle où on a établi la politique de la santé pour la population avec des instruments et certaines médicalisations curatives : un usage de l'électricité fait à la place de la chimie pharmaceutique ou du geste médical invasif débuté au XIXe siècle pour l'électricité sur l'homme. L'électricité fait partie des processus admis du monde agricole pour la reproduction du bétail. Mais les gestes utilisant directement l'électricité sur le corps humain sont très déconsidérés dans la jonction du XXe siècle au XXIe siècle cela au moment de l'apparition des prothèses internes de corps robotisées reliées au système nerveux.

Dans tous les cas de modèle d'industrie, le « courant électrique » est une base sur laquelle vient se greffer les autres "progrès". Ceux pour le XXe siècle de la connaissance scientifique, dont le côté dogmatique[L5 1] reste fort. Cela va jusqu'à une certaine connaissance qualitative des cultures entre elles par le flux d'informations des images télévisuelles sonores transitées avec l'électricité ; elles sont en continuation des œuvres des premiers photographes de la fin du XIXe siècle et cinéastes du début du siècle qui passent du journalisme à la connaissance du monde « proche » et « lointain ».

Après avoir fait l'objet une vision d'économie planifiée plus ou moins affirmée selon le pays[109], l'électricité aboutit à la « virtualisation » de la société avec création selon certains points de vue des « homo numericus » et la mise à disposition de la connaissance par le développement de l'outillage informatique électronique électrique. L'économie du secteur tertiaire productrice d'information à stocker - archiver est devenue prédominante quant aux richesses produites dans les sociétés à modèle industriel.

On passe par son usage de l'effet de seuil connu à l'effet de bord mathématique puis parallèlement par le mode calculatoire à l'effet secondaire informatique.

Vers 1950, par la mise en place de la cybernétique se servant nécessairement de machines électriques, la société change de mathématiques, et l'« itération » est impérative avec l'algorithmique d'une façon très généralisée.

Les méthodes (théorie des graphes orientés ou non, dont PERT issu de la NASA avec les langages informatiques génération 1970) mathématisent leur diagrammes devenus automatisés à partir de 1980. La virtualisation des machines électriques à partir des années 1980 apparaît simultanément à la connectivité-connectique.

La non conduction utile à l'isolation de circuits électriques a été donnée pour les matériaux rigides par la découverte de la bakélite en 1910 suivie par celle de la mélamine en 1930 et suivie par celle du polyéthylène en 1933. Les résines alkydes sont vendues dès 1926 pour isoler les fils conducteurs des bobines électromagnétiques. Les huiles minérales sont isolantes électriques mais conductrices thermiques et refroidissent les transformateurs. Les huiles PCB sans combustibilité apparaissent en 1930 et sont utilisées jusqu'en 1970 dans les transformateurs, supprimées pour toxicité. La non conduction du PVC inventé dans les années 1950 a donné le matériau souple gainant les matériaux conducteurs.

Les applications qui découlent des propriétés des électrons sont :

L'interconnexion nationale puis intracontinentale des réseaux se met progressivement en place en Europe de l'Ouest, puis de l'Est. Elle est moins avancée sur le continent américain : inexistante sur la dorsale sud-américaine, elle reste limitée pour les États-Unis entre les régions Est et Ouest. Elle n'existe pas non plus en Chine entre les régions[réf. nécessaire].

L'ingénierie sur la base de l'électricité se développe au XXe siècle :

Après l'eau et le gaz, l'immeuble reçoit l'électricité à tous les étages. Les entreprises de construction se diversifient. Elles installent les circuits électriques et utilisent peu à peu pour produire les bâtiments des moyens électriques au cours du XXe siècle.

Le câblage électrique des immeubles est fait essentiellement en parties apparentes sur les murs et plafonds, et au départ le circuit ne comporte que des manettes, des « contacteurs de puissance » (interrupteurs[La 2]) et des coupe-circuit « fusibles ». Les câbles utilisés depuis la décennie 1900 sont isolés avec du textile enrobé de caoutchouc et goudron, ils peuvent être torsadés. Un bon nombre de courroies de transmission de force aux machines dans les usines sont supprimées par l'introduction des moteurs électriques. En plus de l'usage luxueux du téléphone pour les conversations à distance, la « force électrique » s'utilise dans les habitations. La « prise » de courant murale apparaît vers 1910. Le tournant 1930 de la conception moderne fait apparaître le « tableau électrique » dans l'habitat alors qu'il était de fait présent dans des ateliers[L4 2] depuis le début du siècle. On distingue alors ce qui fait partie du circuit électrique qui est de la compétence des électriciens, de ce qui est du ressort de l'occupant des lieux[La 3]. Les « années folles » sont historiquement le symbole de la forte croissance économique avec le début d'un art de vivre qui est en rupture avec le passé des « fioritures ». L'architecture des bâtiments nouveaux tient compte à partir de cette époque des différents éléments de confort apportés par l'énergie électrique.

En 1926 l'« Habitat social » allemand avec la cuisine laboratoire démarre pour la première fois l'intégration à l'architecture construite[V 2] du mobilier (socle bétonné des éléments bas). Les gratte-ciels imposent des pompes pour la remontée d'eau et des ascenseurs électriques.

La « maison tout-électrique » avec son chauffage à radiateurs électriques apparaît en France à partir des années 1970, notamment après le premier choc pétrolier : son déploiement accompagne la montée en puissance du parc de centrales nucléaires. Diverses variantes de ce type de chauffage apparaissent ensuite, comme les dalles chauffantes dans les immeubles, puis, plus récemment, les pompes à chaleur ou encore les climatiseurs réversibles.

À partir des années 1980, en Europe, la climatisation est un confort "offert" (disponible suivant les plans de promotion immobilière) pour l'habitat ; des « pompes à chaleur » sont aussi mises en place.

Les commissions internationales négocient les normes, dans la perspective de la production en série d'éléments avec des matériaux assortis de procédure d'une sûreté d'emploi ; ceci correspond localement aux contraintes sociales existantes[113] différentes par pays. Les Commissions électrotechniques internationales existent depuis 1906 ; elles tentent de rendre les pratiques locales utilisables économiquement pour le plus grand nombre. En Europe depuis 1950 le câblage d'immeuble est déclaré « conforme » (recevable selon les prescriptions[note 39] et en France le système de production du bâti comporte les DTU concernant l'électricité.