Loading AI tools

галузь знань про збирання, вимірювання, аналіз, тлумачення та поданні даних З Вікіпедії, вільної енциклопедії

Стати́стика (англ. statistics) — це дисципліна, що працює над збиранням, організуванням, аналізом, інтерпретуванням та представленням даних.[1][2][3][4] В застосуванні статистики до наукової, промислової або соціальної задачі є звичним починати з генеральної сукупності (англ. statistical population) або статистичної моделі для дослідження. Генеральні сукупності можуть бути різноманітними групами людей або об'єктів, такими як «всі люди, що живуть в якійсь країні» або «кожен з атомів, що складають кристал». Статистика працює зі всіма аспектами даних, включно з плануванням збирання даних в термінах планування обстежень (англ. surveys) та експериментів.[5] Див. глосарій теорії ймовірностей та статистики[en].

Коли зібрати дані перепису (англ. census) неможливо, статистики збирають дані, розробляючи спеціальні плани експериментів (англ. experiment designs), та вибірки (англ. samples) для обстежування. Репрезентативне вибирання забезпечує можливість розумного розширення висновків та рішень з цієї вибірки на сукупність в цілому. Експериментальне дослідження (англ. experimental study) включає здійснення вимірювань досліджуваної системи, маніпулювання цією системою, а потім здійснення додаткових вимірювань із застосуванням тієї ж процедури, щоби визначити, чи змінило маніпулювання значення цих вимірювань. На противагу цьому, спостережне дослідження[en] (англ. observational study) не включає експериментального маніпулювання.

В аналізі даних використовують два основні статистичні методи: описову статистику (англ. descriptive statistics), яка узагальнює дані з вибірки із застосуванням статистичних індексів[en], таких як середнє значення та стандартне відхилення, та індуктивну статистику (англ. inferential statistics), яка робить висновки з даних, що піддаються випадковій мінливості (наприклад, похибкам спостережень, варіюванню вибірки).[6][7] Описова статистика часто найбільше цікавиться двома наборами властивостей розподілу (вибірки або загальної сукупності): центральна тенденція (або положення) прагне схарактеризувати центральне або типове значення цього розподілу, тоді як дисперсія (або мінливість) характеризує міру, до якої члени цього розподілу відхиляються від його центру, та один від одного. Висновування в математичній статистиці здійснюють в рамках теорії ймовірностей, що займається аналізом випадкових явищ.

Стандартна статистична процедура включає збирання даних, що веде до перевірки взаємозв'язку між двома наборами статистичних даних, або набором даних та синтетичними даними, отриманими з ідеалізованої моделі. Для статистичного взаємозв'язку між двома наборами даних пропонують гіпотезу, і порівнюють її, як альтернативу[en], з ідеалізованою нульовою гіпотезою (англ. null hypothesis) про відсутність взаємозв'язку між цими двома наборами даних. Відхиляння або спростування нульової гіпотези здійснюють із застосуванням статистичних критеріїв (англ. statistical tests), що кількісно виражають сенс, в якому хибність нульової гіпотези можливо вважати доведеною за наданих даних, які використовують в цій перевірці. Працюючи від нульової гіпотези, розпізнаю́ть два основні види помилок: помилки I роду (нульову гіпотезу хибно відхиляють, що дає «хибно позитивне», англ. false positive), та помилки II роду (нульову гіпотезу не вдається відхилити, й справжній взаємозв'язок між сукупностями втрачається, що дає «хибно негативне», англ. false negative).[8] З цією системою виявилося пов'язано численні проблеми: від отримування достатнього розміру вибірки, й до вказування адекватної нульової гіпотези.[джерело?]

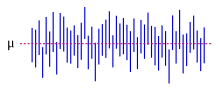

Процеси вимірювання, що породжують статистичні дані, також піддаються помилкам. Багато з цих помилок класифікують як випадкові (шум, англ. noise) або систематичні (упередження, англ. bias), але можуть траплятися й інші типи помилок (наприклад, промахи, англ. blunder, такі як коли аналітик повідомляє неправильні одиниці вимірювання). Існування пропущених даних[en] або цензурування[en] може призводити до упереджених оцінок, й для подолання цих проблем було розроблено спеціальні методики.

Найраніші праці з імовірності та статистики, статистичних методів, що спираються на теорію ймовірностей, сходять до арабських математиків та криптографів[en], зокрема, Аль-Халіля (717—786)[9] та Аль-Кінді (801—873).[10][11] У XVIII сторіччі статистика також почала сильно живитися з диференціального та інтегрального числення. Останніми роками для вироблення цих критеріїв, таких як описовий аналіз, статистика покладалася більше на статистичне програмне забезпечення.[12]

Статистика — це математичний масив наукових знань, що стосуються збирання, аналізу, інтерпретування або пояснювання, та представлення даних,[13][4] або одна з галузей математики.[14] Дехто вважає статистику радше окремою математичною наукою, ніж галуззю математики. В той час як даними користуються багато наукових досліджень, статистика займається використанням даних в контексті невизначеності, та ухвалюванням рішень в умовах невизначеності.[15][16]

В застосуванні статистики до задачі звичною практикою є починати з сукупності або процесу для дослідження. Сукупності можуть бути різноманітної тематики, такі як «всі люди, що мешкають у країні» або «кожен з атомів, що складають кристал». В ідеалі статистики збирають дані про всю сукупність (операція, звана переписом). Це може бути зорганізовано державними статистичними установами. Описову статистику можливо використовувати для узагальнювання даних про сукупність. До чисельних описувачів для неперервних типів даних (таких, як дохід) належать середнє значення та стандартне відхилення, тоді як в термінах описування категорійних даних (таких, як освіта) кориснішими є частота та відсоток.

Коли перепис є нездійсненним, досліджують обрану підмножину сукупності, звану вибіркою (англ. sample). Щойно визначено вибірку, яка для цієї сукупності є репрезентативною, дані для членів цієї вибірки збирають у спостережній або експериментальній постановці. Знов-таки, для узагальнювання цих вибіркових даних можливо застосовувати описову статистику. Проте, вибирання вибірки мало елементи випадковості, тож встановлені чисельні описувачі з цієї вибірки залежать від випадковості. Щоби все ж таки робити змістовні висновки про сукупність в цілому, потрібна індуктивна статистика. Вона використовує закономірності в даних вибірки, щоби робити висновки про представлену нею сукупність, з урахуванням випадковості. Ці висновки можуть набувати вигляду: відповідання на питання «так/ні» (перевіряння гіпотез, англ. hypothesis testing), оцінювання чисельних характеристик даних (оцінювання, англ. estimation), описування пов'язаностей (англ. associations) в даних (кореляція), та моделювання взаємозв'язків всередині даних (наприклад, із застосуванням регресійного аналізу). Висновування може розширюватися до прогнозування, передбачування, та оцінювання неспостережуваних змінних чи то всередині досліджуваної сукупності, чи пов'язаних із нею; до нього можуть належати екстраполювання та інтерполювання часових рядів та просторових даних, а також добування даних.

Математична статистика — це застосування математики до статистики. До математичних методик, які для цього використовують, належать математичний аналіз, лінійна алгебра, стохастичний аналіз, диференціальні рівняння та теорія ймовірностей теорії міри[en].[17][18]

Детальніші відомості з цієї теми ви можете знайти в статті Історія статистики[en] та Засновники статистики[en].

Найраніші праці з імовірності та статистики сходять до арабських математиків та криптографів[en] Золотої доби ісламу між VIII та XIII сторіччями. Аль-Халіль (717—786) написав «Книгу таємної мови», що містить перше застосування перестановок та комбінацій[en] з метою перелічування всіх арабських слів з голосними та без них.[9] Найранішою книгою зі статистики є «Трактат про дешифрування криптографічних повідомлень», написаний арабським вченим Аль-Кінді (801—873). У своїй книзі Аль-Кінді навів докладний опис того, як застосовувати статистику та частотний аналіз для розшифровування зашифрованих повідомлень. Цей текст заклав основи статистики та криптоаналізу.[10][11] Аль-Кінді також здійснив найраніше з відомих застосування статистичного висновування, тоді як пізніші арабські криптографи розробили ранні статистичні методи для розкодовування зашифрованих повідомлень. Ібн Адлан[en] (1187—1268) пізніше зробив важливий внесок стосовно застосування в частотному аналізі розміру вибірки.[9]

Найраніші європейські праці зі статистики сходять до 1663 року, публікації «Природні та політичні спостереження на списках померлих» Джона Ґраунта.[19] Ранні застосування статистичного мислення оберталися довкола потреб держав (лат. statum) ґрунтувати політику на демографічних та економічних даних, звідси етимологія «стат-»[en]. На початку XIX сторіччя сфера дисципліни статистики розширилася, включивши збирання та аналіз даних в цілому. Натепер статистику широко застосовують в урядуванні, бізнесі, а також природничих та соціальних науках.

Математичні основи сучасної статистики було закладено в XVII сторіччі з розробкою Джироламо Карданом, Блезом Паскалем та П'єром Ферма теорії ймовірностей. Математична теорія ймовірностей постала з досліджень ігор випадку, хоч поняття ймовірності й було вже досліджено в середньовічному праві, та філософами, такими як Хуан Карамуель.[20] Метод найменших квадратів було вперше описано Адрієном-Марі Лежандром 1805 року.

Сучасна галузь статистики виникла наприкінці XIX — початку XX сторіччя в три етапи.[21] Першу хвилю, на рубежі сторіч, очолила праця Френсіса Ґолтена та Карла Пірсона, які перетворили статистику на строгу математичну дисципліну, яку використовували для аналізу, і не лише в науці, але також і в промисловості та політиці. До внеску Ґолтена належать введення понять стандартного відхилення, кореляції, регресійного аналізу, та застосування цих методів до дослідження розмаїття людських характеристик — зросту, ваги, довжини вій тощо.[22] Пірсон, серед іншого, розробив коефіцієнт кореляції моменту добутку Пірсона, визначений як момент добутку,[23] метод моментів для допасовування розподілів до вибірок, та розподіл Пірсона[en].[24] Ґолтен та Пірсон заснували «Biometrika[en]» як перший журнал з математичної статистики та біостатистики (яку тоді називали біометрією), й пізніше заснували перший в світі університетський статистичний факультет в Університетськім коледжі Лондона.[25]

Рональд Фішер під час експерименту «пані дегустує чай» закарбував термін нульова гіпотеза, яку «ніколи не доводять та не встановлюють, але, можливо, спростовують в ході експерименту».[26][27]

Початок другій хвилі 1910-х та 20-х років поклав Вільям Сілі Ґоссет[en], й вона досягла своєї кульмінації в осяяннях Рональда Фішера, який написав підручники, що мали визначити цю академічну дисципліну в університетах по всьому світі. Найважливішими публікаціями Фішера були його засаднича праця 1918 року «Кореляція між родичами в припущенні менделевої спадковості[en]» (яка була першою, де було застосовано статистичний термін «дисперсія», англ. variance), його класична праця 1925 року «Статистичні методи для дослідників[en]», та його «Планування експериментів[en]» 1935 року,[28][29][30] де він розробив строгі моделі планування експериментів. Він започаткував поняття достатності, допоміжної статистики[en], лінійного розрізнювача Фішера та інформації за Фішером.[31] У своїй книзі 1930 року «Генетична теорія природного добору[en]» він застосував статистику до різних біологічних понять, таких як принцип Фішера[32] (що його Е. В. Ф. Едвардс[en] назвав «імовірно найвизначнішим аргументом в еволюційній біології») та фішерова неконтрольованість,[33][34][35][36][37][38] поняття в статевім доборі про афект неконтрольованого зворотного зв'язку, що виникає в еволюції.

Заключна хвиля, яка переважно бачила вдосконалення та розширення попередніх розробок, виникла в результаті спільної праці Еґона Пірсона та Єжи Неймана в 1930-х роках. Вони ввели поняття помилки «II роду», статистичної потужності критерію (англ. power of a test), та довірчих інтервалів. Єжи Нейман 1934 року показав, що стратифіковане випадкове вибирання було в цілому кращим методом оцінювання, аніж вибирання цілеспрямоване (квотне).[39]

Сьогодні статистичні методи застосовують в усіх областях, які передбачають ухвалювання рішень, щоби отримувати точні висновки з консолідованого масиву даних для ухвалювання рішень в умовах невизначеності на основі статистичної методології. Використання сучасних комп'ютерів форсувало великомасштабні статистичні обчислення й також уможливило нові методи, що є недоцільними для виконання вручну. Статистика продовжує бути областю активних досліджень, наприклад, щодо проблеми аналізу великих даних.[40]

Коли зібрати дані повного перепису неможливо, статистики збирають вибіркові дані, розробляючи особливі плани експериментів та вибірки для обстеження[en]. Статистика сама по собі також пропонує інструменти для передбачування та прогнозування за допомогою статистичних моделей. Ідея робити висновки на основі вибіркових даних виникла близько середини 1600-х у зв'язку з оцінюванням чисельності населення та розробки предтеч страхування життя.[41]

Щоби використовувати вибірку як взірець для всієї сукупності, важливо, щоби вона справді представляла генеральну сукупність. Репрезентативне вибирання забезпечує можливість безпечного розширення висновків та рішень з цієї вибірки на сукупність в цілому. Основна проблема полягає у визначені міри, до якої обрана вибірка є насправді репрезентативною. Статистика пропонує методи для оцінювання та виправляння будь-яких упереджень у вибірці та процедурах збирання даних. Також існують методи планування експериментів для таких експериментів, що можуть зменшувати ці проблеми на початку дослідження, підсилюючи його здатність розпізнавати істину стосовно генеральної сукупності.

Теорія вибирання є частиною математичної дисципліни теорії ймовірності. Ймовірність використовують в математичній статистиці, щоби досліджувати вибіркові розподіли вибіркових статистик та, загальніше, властивості статистичних процедур. Використання будь-якого статистичного методу є правильним, коли система або сукупність, яку розглядають, задовольняє припущення цього методу. Різниця в поглядах класичної теорії ймовірності та теорії вибирання, грубо, полягає в тім, що теорія ймовірності починає з заданих параметрів генеральної сукупності для дедуктивного виведення ймовірностей, притаманних вибіркам. Проте статистичне висновування рухається в протилежному напрямку, індуктивно виводячи з вибірок параметри більшої або генеральної сукупності.

Загальною метою статистичного дослідницького проєкту є дослідження причинності, й зокрема висновування стосовно впливу змін значень передбачувачів чи незалежних змінних на залежні змінні. Існує два основні типи причиннісних статистичних досліджень: експериментальні дослідження, та спостережні дослідження[en]. В обох типах досліджень спостерігають за впливом відмінності в незалежній змінній (або змінних) на поведінку залежної змінної. Різниця між цими двома типами полягає в тім, як фактично здійснюють дослідження. Кожен з них може бути дуже дієвим. Експериментальне дослідження включає вимірювання досліджуваної системи, маніпулювання цією системою, а потім здійснення нових вимірювань з використанням тієї ж процедури, щоби визначити, чи змінило це маніпулювання значення вимірювань. На противагу цьому, спостережне дослідження не містить експериментального маніпулювання. Натомість збирають дані та досліджують кореляції між передбачувачами та відгуками. Й хоч інструменти аналізу даних найкраще працюють на даних з рандомізованих досліджень, їх також застосовують і до інших типів даних, таких як природні експерименти та спостережні дослідження[en],[42] для яких статистик використовуватиме видозмінений, структурованіший метод оцінювання (наприклад, серед багатьох інших, оцінювання різниці в різницях[en] та інструментальні змінні), що вироблятиме слушні оцінювачі.

Основними етапами статистичного експерименту є:

Експерименти з людською поведінкою несуть особливі турботи. В знаменитім Готорнськім дослідженні вивчали зміни до робочого середовища на Готорнськім заводі компанії Western Electric. Дослідників цікавило визначити, чи призведе збільшення освітлення до збільшення продуктивності працівників конвеєра[en]. Дослідники спочатку виміряли продуктивність заводу, потім змінили освітлення в одній області заводу, й перевірили, чи вплинули ці зміни в освітленні на продуктивність. Виявилося, що продуктивність і справді покращилася (в експериментальних умовах). Проте це дослідження сьогодні сильно критикують через помилки в процедурах експерименту, особливо через брак контрольної групи та сліпоти. Готорнський ефект стосується виявлення того, що результат (в цьому випадку — продуктивність працівників) змінився через саме спостереження. Піддослідні в Готорнськім дослідженні стали продуктивнішими не через зміну освітлення, а через те, що за ними спостерігали.[43]

Прикладом спостережного дослідження є таке, що вивчає пов'язаність паління та раку легенів. Цей тип дослідження зазвичай використовує опитування для збирання спостережень про цільову область, і потім виконує статистичний аналіз. В цьому випадку дослідники збирали би спостереження як про курців, так і про не курців, певно, шляхом когортного дослідження, а потім дивилися би на число випадків раку легенів у кожній з груп.[44] Іншим типом спостережного дослідження є дослідження «випадок—контроль», в якому запрошують взяти участь людей з та без цільового результату (наприклад, раку легенів), і збирають їхні історії піддавання впливові.

Існувало чимало спроб виробити таксономію шкал вимірювання. Психолог Стенлі Сміт Стівенс[en] визначив номінальну (англ. nominal), порядкову (англ. ordinal), інтервальну (англ. interval) шкали, та шкалу відношень (англ. ratio scale). Номінальні вимірювання не мають змістовного порядку ранжування їхніх значень, й дозволяють будь-яке перетворення один-в-одного (ін'єктивне). Порядкові вимірювання мають неточні відмінності між послідовними значеннями, але мають змістовний порядок цих значень, й дозволяють будь-яке перетворення зі збереженням порядку. Інтервальні вимірювання мають визначені змістовні відстані між вимірюваннями, але нульове значення є довільним (як у випадках вимірювань довготи та температури в градусах Цельсія та Фаренгейта), й дозволяють будь-яке лінійне перетворення. Вимірювання відношень мають визначені змістовні як нульове значення, так і відстані між вимірюваннями, й дозволяють будь-яке перетворення масштабування.

Оскільки змінні, що відповідають лише номінальним та порядковим вимірюванням, раціонально виміряти числами неможливо, іноді їх об'єднують як категорійні змінні, тоді як відносні та інтервальні вимірювання об'єднують як кількісні змінні, що можуть бути або дискретними, або неперервними, в силу своєї числової природи. Таке розмежування часто може бути нестрого співвідносним з типом даних в інформатиці, оскільки дихотомні категорійні змінні може бути представлено логічним типом даних, багатозначні категорійні змінні — довільно призначуваними цілими числами в цілочисловім типі даних, а неперервні змінні — дійснозначним типом даних[en] із застосуванням обчислень з рухомою комою. Але відображення типів даних інформатики на типи статистичних даних залежить від того, яку категоризацію останніх втілюють.

Було запропоновано й інші категоризації. Наприклад, Мостеллер та Тьюкі (1997)[45] розрізнювали ступені (англ. grades), ранги (англ. ranks), зліченні дроби (англ. counted fractions), кількості (англ. counts), суми (англ. amounts) та баланси (англ. balances). Нелдер (1990)[46] описав неперервні кількості (англ. continuous counts), неперервні відношення (англ. continuous ratios), відношення кількостей (англ. count ratios), та категорійні види даних. Див. також Крісмана (1998),[47] ван ден Берґа (1991).[48]

Питання доречності чи недоречності застосування різних видів статистичних методів до даних, отриманих з різних видів процедур вимірювання, ускладнюється питаннями перетворювання змінних та точною інтерпретацією досліджуваних питань. «Взаємозв'язок між даними та тим, що вони описують, просто відображає той факт, що певні види статистичних висловлень можуть мати значення істинності, що не є інваріантними за деяких перетворень. Чи є доцільним розглядати певне перетворення, чи ні, залежить від питання, на яке намагаються відповісти.»[49]

Описо́ві стати́стики (в сенсі злічуваного іменника[en] англ. descriptive statistic в однині) — це зведені статистики, які кількісно описують або узагальнюють ознаки сукупності інформації,[50] в той час як опис́ова стати́стика в сенсі незлічуваного іменника (англ. descriptive statistics) — це процес використання та аналізу цих статистик. Описова статистика відрізняється від висновувальної статистики[51] (англ. inferential statistics, або індуктивної статистики, англ. inductive statistics) тим, що описова статистика має на меті узагальнювання вибірки, а не використання цих даних, щоб дізнатися щось про генеральну сукупність, яку, як вважають, ця вибірка даних представляє.

Статисти́чне висно́вування (англ. statistical inference) — це процес використання аналізу даних для встановлення властивостей розподілу ймовірності, що лежить в їх основі.[52] Висновувальний статистичний аналіз робить висновки про властивості генеральної сукупності, наприклад, шляхом перевіряння гіпотез та отримування оцінок. Він виходить з припущення, що спостережувані дані є вибіркою з більшої сукупності. Індуктивну статистику можливо протиставляти описовій статистиці. Описова статистика цікавиться виключно властивостями спостережуваних даних, і не спирається на припущення, що ці дані походять із більшої сукупності.

Розгляньмо незалежні однаково розподілені (н. о. р.) випадкові змінні із заданим розподілом ймовірності: стандартне статистичне висновування та теорія оцінювання визначає випадкову вибірку як випадковий вектор, заданий стовпчиковим вектором цих н. о. р. змінних.[53] Досліджувану генеральну сукупність описують розподілом ймовірності, що може мати невідомі параметри.

Статистика (англ. statistic) — це випадкова змінна, що є функцією випадкової вибірки, але не функцією невідомих параметрів. Розподіл імовірності цієї статистики, проте, невідомі параметри мати може.

Розгляньмо тепер функцію невідомого параметра: статистична оцінка (англ. estimator) — це статистика, яку використовують для оцінювання цієї функції. До широко вживаних статистичних оцінок належать вибіркове середнє, незміщена дисперсія вибірки та коваріація вибірки[en].

Випадкову змінну, що є функцією випадкової вибірки та невідомого параметру, але чий розподіл імовірності не залежить від невідомого параметру, називають центральною величиною[en] (англ. pivotal quantity, pivot). До широко вживаних центральних величин належать z-оцінка, статистика хі-квадрат та t-величина Стьюдента.

Серед двох оцінок заданого параметру ефективнішою вважають ту, що має нижчу середньоквадратичну похибку. Крім того, оцінку називають незміщеною (англ. unbiased), якщо її математичне сподівання дорівнює істинному значенню оцінюваного невідомого параметра, й асимптотично незміщеною, якщо її математичне сподівання збігається до границі істинного значення такого параметра.

До інших бажаних властивостей статистичних оцінок належать: рівномірно незміщені оцінки з мінімальною дисперсією[en] (англ. UMVUE), що мають найнижчу дисперсію для всіх можливих значень оцінюваного параметра (це зазвичай є легшою властивістю для перевірки, ніж ефективність), та слушні оцінки (англ. consistent estimators), що збігаються за ймовірністю до істинного значення такого параметра.

Це все ще залишає відкритим питання, як отримувати статистичні оцінки в заданій ситуації та виконувати обчислення, було запропоновано декілька методів: метод моментів, метод максимальної правдоподібності, метод найменших квадратів, та новіший метод оцінних рівнянь[en].

Інтерпретування статистичної інформації часто може включати розробку нульової гіпотези (англ. null hypothesis), яка зазвичай (але не обов'язково) полягає у відсутності взаємозв'язку серед змінних, або що зміни з часом не відбуваються.[54][55]

Найкращою ілюстрацією для новачка є утруднення, з яким зіткнувся кримінальний процес в суді присяжних. Нульова гіпотеза, H0, стверджує, що відповідач є невинним, тоді як альтернативна гіпотеза, H1, стверджує, що відповідач є винним. Висувається звинувачення через підозру в винності. H0 (статус кво) протистоїть H1, й підтримується, поки H1 не стане підтримано доказами «поза розумним сумнівом». Проте «нездатність відхилити H0» в цьому випадку означає не невинність, а лише те, що докази були недостатніми для засудження. Тож присяжні не обов'язково приймають H0, їм не вдається відхилити H0. І хоч «довести» нульову гіпотезу неможливо, її можливо перевірити на те, наскільки вона є близькою до істини, через статистичну потужність, яка робить перевірку на помилки другого роду.

Те, що статистики називають альтернативною гіпотезою[en], — це просто гіпотеза, що суперечить нульовій гіпотезі.

Працюючи від нульової гіпотези, розпізнаю́ть два основні види помилок:

Стандартне відхилення (англ. standard deviation) вказує на те, наскільки окремі спостереження в вибірці відрізняються від центрального значення, такого як середнє за вибіркою або середнє за генеральною сукупністю, тоді як стандартна похибка (англ. standard error) вказує на оцінку різниці між середніми за вибіркою та середнім за генеральною сукупністю.

Статистична похибка (англ. statistical error) — це величина, на яку спостереження відрізняються від їхнього математичного сподівання, залишок (англ. residual) — це величина, на яку спостереження відрізняються від значення, якого набуває статистична оцінка очікуваного значення на заданому зразкові (яку також називають передбаченням).

Середньоквадратичну похибку (англ. mean squared error) використовують для отримування ефективних оцінок, широко вживаного класу статистичних оцінок. Коренева середньоквадратична похибка[en] (англ. root mean square error) є просто квадратним коренем середньоквадратичної похибки.

Багато статистичних методів прагнуть мінімізувати залишкову суму квадратів[en] (англ. residual sum of squares), і їх називають методами найменших квадратів (англ. methods of least squares), на противагу до методів найменших модулів[en] (англ. least absolute deviations). Останні надають однакової ваги як маленьким, так і великим похибкам, тоді як перші надають великим похибкам більшої ваги. Також, залишкова сума квадратів є диференційовною, що забезпечує зручну властивість для виконання регресії. Найменші квадрати в застосуванні до лінійної регресії називають звичайним методом найменших квадратів[en] (англ. ordinary least squares method), а найменші квадрати в застосуванні до нелінійної регресії[en] називають нелінійним методом найменших квадратів[en] (англ. non-linear least squares). Також, в лінійній регресійній моделі недетерміновану частину моделі називають членом похибки (англ. error term), збуренням (англ. disturbance), або просто шумом (англ. noise). Як лінійну, так і нелінійну регресію розглядають у поліноміальнім методі найменших квадратів (англ. polynomial least squares), що також описує дисперсію в передбаченні залежної змінної (вісь y) як функцію від незалежної змінної (вісь x) та відхилень (похибок, шуму, збурення) відносно оцінюваної (допасовуваної) кривої.

Процеси вимірювання, що породжують статистичні дані, також є схильними до похибок. Багато з цих похибок класифікують як випадкові (англ. random, шум) та систематичні (англ. systematic, зсув), але важливими можуть бути й інші типи похибок (наприклад, промахи, такі як коли аналітик повідомляє неправильні одиниці вимірювання). Існування пропущених даних[en] або цензурування[en] може призводити до упереджених оцінок, й для подолання цих проблем було розроблено спеціальні методики.[56]

Детальніші відомості з цієї теми ви можете знайти в статті Інтервальне оцінювання[en].

Більшість досліджень вибирають лише частину генеральної сукупності, тож результати не представляють всю генеральну сукупність вповні. Будь-які оцінки, отримані з такої вибірки, лише наближують значення генеральної сукупності. Довірчі інтервали (англ. confidence intervals) дозволяють статистикам виражати те, наскільки близько вибіркова оцінка відповідає істинному значенню для всієї генеральної сукупності. Часто їх виражають як 95-відсоткові довірчі інтервали. Формально, 95 %-вий довірчий інтервал для значення є діапазоном, який, якщо вибирання та аналіз повторювати за таких же умов (отримуючи відмінний набір даних), включатиме істинне значення (генеральної сукупності) в 95 % всіх можливих випадків. Це не означає, що ймовірність перебування істинного значення в цьому довірчому інтервалі становить 95 %. З частотницької точки зору таке твердження не має сенсу, оскільки істинне значення не є випадковою змінною. Істинне значення або перебуває в даному інтервалі, або ні. Проте, істинним є те, що до того, як буде вибрано якісь дані, і за заданого плану побудови довірчого інтервалу, ймовірність того, що інтервал, який ще належить обчислити, покриватиме істинне значення, становить 95 %: в цей момент межі інтервалу є випадковими змінними, які ще належить проспостерігати. Одним із підходів, що видає інтервал, який можливо інтерпретувати як такий, що має задану ймовірність вміщування істинного значення, є застосування ймовірних інтервалів (англ. credible intervals) з баєсової статистики: цей підхід залежить від відмінного способу інтерпретування того, що мається на увазі під «імовірністю», а саме, баєсової ймовірності.

Довірчі інтервали, в принципі, можуть бути симетричними та асиметричними. Інтервал може бути асиметричним, бо він працює як нижня та верхня межі для параметру (лівобічний та правобічний інтервали), але він також може бути асиметричним, оскільки цей двобічний інтервал будують із порушенням симетрії навколо оцінки. Іноді межі асимптотичного інтервалу досягають асимптотично, й використовують їх для наближення істинних меж.

Статистика рідко дає на аналізоване питання просту відповідь на кшталт Так/Ні. Інтерпретація часто зводиться до рівня статистичної значущості (англ. statistical significance), застосовуваного до чисел, і часто посилається на ймовірність значення, що точно відкидає нульову гіпотезу (яку іноді називають p-значенням).

Стандартним підходом[53] є перевіряти нульову гіпотезу відносно альтернативної гіпотези. Критична область є множиною значень оцінювача, які ведуть до спростування нульової гіпотези. Ймовірність помилки I роду є відтак ймовірністю того, що оцінювач лежить у критичній області за умови, що нульова гіпотеза є істинною (статистична значущість), а ймовірність помилки II роду є ймовірністю того, що оцінювач не належить до критичної області за умови, що істинною є альтернативна гіпотеза. Статистична потужність (англ. statistical power) критерію є ймовірністю того, що він належним чином відхиляє нульову гіпотезу, коли ця нульова гіпотеза є хибною.

Посилання на статистичну значущість не обов'язково означає, що загальний результат є значущим в термінах реального світу. Наприклад, у великому дослідженні лікарського засобу може бути показано, що цей медикамент має статистично значущий, але дуже маленький сприятливий ефект, такий, що він навряд чи може помітно допомагати пацієнтові.

І хоча в принципі прийнятний рівень статистичної значущості може бути предметом обговорення, p-значення є найменшим рівнем значущості, який дозволяє критерію відхиляти нульову гіпотезу. Цей критерій є логічно рівнозначним твердженню, що p-значення є ймовірністю спостерігання результату, щонайменше настільки ж екстремального, як і статистика критерію, за умови, що нульова гіпотеза є істинною. Таким чином, що меншим є p-значення, то нижчою є ймовірність трапляння помилки I роду.

Деякі проблеми, зазвичай пов'язувані з цією системою (див. критику перевірки статистичних гіпотез[en]):

Деякі відомі статистичні критерії та процедури:

Розві́дувальний ана́ліз да́них (РАД, англ. exploratory data analysis, EDA) — це один з підходів до аналізу наборів даних для узагальнювання їхніх основних характеристик, часто за допомогою візуальних методів. Статистичну модель можуть використовувати чи ні, але в першу чергу РАД призначено, щоби побачити, що дані можуть сказати нам за межами формальної задачі моделювання та перевірки гіпотез.

Детальніші відомості з цієї теми ви можете знайти в статті Неналежне застосування статистики.

Неналежне застосування статистики може спричинювати тонкі, але серйозні помилки в описі та інтерпретації — тонкі в тому сенсі, що навіть досвідчені фахівці можуть робити такі помилки, а серйозні в тому сенсі, що вони можуть призводити до руйнівних помилок в ухвалюванні рішень. Від належного застосування статистики залежать, наприклад, соціальна політика, медична практика та надійність таких споруд, як мости.

Навіть коли статистичні методики застосовують коректно, їхні результати можуть бути складними для інтерпретування для тих, кому бракує досвіду. Статистична значущість тенденції в даних, яка вимірює ступінь, до якого тенденцію може бути спричинено випадковою мінливістю вибірки, може узгоджуватися з інтуїтивним відчуттям її значущості, а може й не узгоджуватися. Набір базових статистичних навичок (та скептицизму), необхідних людям для належної роботи з інформацією у своєму повсякденному житті, називають статистичною грамотністю[en].

Існує думка, що статистичні знання занадто часто цілеспрямовано застосовують неналежним чином, шукаючи шляхи інтерпретувати лише ті дані, що є сприятливими для доповідача.[59] Недовіра та нерозуміння статистики пов'язані з цитатою «Існує три види брехні: брехня, нахабна брехня й статистика». Неналежне застосування статистики може бути як ненавмисним, так і навмисним, й ряд міркувань окреслено в книзі «Як брехати за допомогою статистики».[59] В намаганні пролити світло на належне та неналежне застосування статистики проводять перегляди статистичних методик, використовуваних в певних областях (наприклад, Варн, Лазо, Рамос і Ріттер (2012)).[60]

До способів запобігання неналежному застосуванню статистики належать застосування правильних діаграм та запобігання упередженню.[61] Неналежне застосування може траплятися, коли висновки переузагальнюють, і претендують, що вони є репрезентативними для більшого, ніж вони є насправді, часто через навмисне або ненавмисне не враховування упередженості вибірки.[62] Стовпчикові діаграми є, мабуть, найпростішими діаграмами для застосування та розуміння, й їх можливо робити вручну або за допомогою простих комп'ютерних програм.[61] На жаль, більшість людей не дивляться на упередження та помилки, тож вони лишаються непоміченими. Таким чином, люди можуть часто вірити в те, що щось є істинним, навіть якщо воно не є достатньо репрезентативним.[62] Щоби зібрані зі статистики дані були правдоподібними та точними, здійснювана вибірка мусить бути репрезентативною для генеральної сукупності в цілому.[63] Згідно Гаффа, «Надійність вибірки може бути зруйновано [упередженістю]… дозволяйте собі певну міру скептицизму.»[64]

Для допомоги в розумінні статистики Гафф запропонував ряд питань, які слід задавати в кожному випадку:[59]

Стентон Ґлентц[en], американський професор медицини, який викладає статистику студентам медичного профілю, автор ряду курсів та книг зі статистики та колишній редактор «Journal of the American College of Cardiology[en]», зазначає, що близько 50 % публікацій, які надходять в редакцію журналу, містять статистичні помилки отримання та обробки медичних даних.[65] Основними причинами є недостовірність отриманих даних (неправильно поставлені експерименти або ж взяті непрезентабельні дані), а також незнання та неправильне застосування статистичних методів. Також він зазначає, що часто дослідник та особи, причетні до експерименту, можуть підсвідомо видавати бажане за дійсне. Причому ненавмисне підтасування даних може відбуватися як на етапі постановки експерименту, збору даних, так і на етапі аналізу даних. Виходом є максимальне врахування та усунення сторонніх чинників, які можуть вплинути на процес експерименту та на аналіз даних. Він пропонує якомога ширше використовувати «сліпий метод» чи навіть «подвійно сліпий метод», коли ані піддослідні, ані дослідники (чи помічники дослідників) достеменно не знають, що на якій групі хворих досліджується, і навіть аналіз даних бажано щоб робила особа, незацікавлена у некоректній інтерпретації даних, чи, ще краще, якщо вона буде необізнаною в конкретних деталях експерименту. В будь-якому разі, в постановці, зборі та аналізі даних повинні брати участь особи, які добре володіють прикладними статистичними методами.

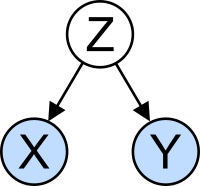

Поняття кореляції особливо привертає увагу потенційною плутаниною, яку воно може спричинювати. Статистичний аналіз набору даних часто виявляє, що дві змінні (властивості) досліджуваної генеральної сукупності мають схильність змінюватися разом, так, ніби вони пов'язані. Наприклад, дослідження річного доходу, яке також дивиться на вік смерті, може виявити, що тривалість життя в бідних людей схильна бути меншою, ніж у заможних. Про ці дві змінні кажуть, що вони корелюють, проте, вони можуть бути, а можуть і не бути причиною одна одної. Явище кореляції може бути спричинено третім, раніше не розгляданим явищем, що називають неявною змінною (англ. lurking variable) або змішувальною змінною (англ. confounding variable). З цієї причини немає можливості негайно зробити висновок про існування причинно-наслідкового зв'язку між цими двома змінними. (Див. корелювання не означає спричинювання.)

Прикладна статистика включає описову статистику та застосування індуктивної статистики.[66][67] Теоретична статистика розглядає логічні аргументи, що лежать в основі обґрунтування підходів до статистичного висновування, а також охоплює математичну статистику. Математична статистика включає не лише маніпулювання розподілами ймовірності, необхідними, щоби виводити результати, пов'язані з методами оцінювання та висновування, але також і різні аспекти обчислювальної статистики[en] та планування експериментів.

Статистичні консультанти[en] можуть допомагати організаціям та компаніям, які не мають власної компетенції, що стосується їхніх конкретних питань.

Моделі машинного навчання — це статистичні та ймовірнісні моделі, що фіксують закономірності в даних через застосування обчислювальних алгоритмів.

Статистику застосовують до широкого спектру академічних дисциплін, включно з природничими та суспільними науками, урядуванням та бізнесом. Бізнесова статистика застосовує статистичні методи в економетрії, аудиті, виробництві та операційній діяльності, включно з удосконаленням обслуговування та маркетинговими дослідженнями.[68] В галузі біологічних наук 12-ма найчастішими статистичними критеріями є: дисперсійний аналіз (англ. ANOVA), критерій хі-квадрат, t-критерій Стьюдента, лінійна регресія, коефіцієнт кореляції Пірсона, U-критерій Манна — Уітні, критерій Краскела — Уоліса[en], індекс різноманітності Шеннона, критерій Тьюкі[en], кластерний аналіз, коефіцієнт кореляції рангу Спірмена та метод головних компонент.[69]

Типовий курс статистики охоплює описову статистику, ймовірність, біноміальний та нормальний розподіли, перевірку гіпотез та довірчих інтервалів, лінійну регресію та кореляцію.[70] Сучасні фундаментальні курси статистики для студентів останнього курсу зосереджуються на правильному обиранні критеріїв, інтерпретації результатів, та застосуванні безкоштовного статистичного програмного забезпечення[en].[69]

Детальніші відомості з цієї теми ви можете знайти в статті Обчислювальна статистика[en].

На практику статистичної науки, починаючи з другої половини XX сторіччя, суттєво вплинуло швидке й стійке зростання обчислювальної потужності. Ранні статистичні моделі майже завжди походили з класу лінійних моделей, але потужні комп'ютери, в поєднанні з відповідними чисельними алгоритмами, спричинили зростання зацікавлення нелінійними моделями[en] (такими як нейронні мережі), а також створення нових типів, таких як узагальнені лінійні[en] та багаторівневі моделі[en].

Збільшення обчислювальної потужності також призвело до зростання популярності обчислювально містких методів, що ґрунтуються на перевибиранні[en], таких як пермутаційний тест та натяжка, тоді як такі методики, як вибирання за Ґіббсом[en], зробили здійсненнішим застосування баєсових моделей. Комп'ютерна революція має наслідки для майбутнього статистики з новим акцентом на «експериментальній» та «емпіричній» статистиці. Наразі є доступною велика кількість статистичного програмного забезпечення[en] як загального, так і спеціального призначення. До прикладів доступного програмного забезпечення, здатного до складних статистичних обчислень, належать такі програми як Mathematica, SAS[en], SPSS та R.

Традиційно статистика займалася висновуванням із застосуванням напівстандартизованої методології, що була «обов'язковою для вивчення» в більшості наук.[джерело?] Ця традиція змінилася із застосуванням статистики в не висновувальних контекстах. На те, що колись було нудною темою, обов'язковою для отримання ступеня в багатьох галузях, тепер дивляться з ентузіазмом.[на чию думку?] Висміювану спершу деякими математичними пуристами, її тепер вважають важливою методологією в певних областях.

Статистичні методики використовують в широкому спектрі типів наукових та суспільних досліджень, включно з біологічною статистикою, обчислювальною біологією, обчислювальною соціологією, мережною біологією[en], суспільствознавством, соціологією та суспільствознавчими дослідженнями. В деяких областях досліджень прикладну статистику використовують настільки широко, що вони мають спеціалізовану термінологію. До цих дисциплін належать:

Крім того, існують певні типи статистичного аналізу, в яких також було розроблено свою власну спеціалізовану термінологію та методологію:

Статистика також є ключовим базовим інструментом у бізнесі та виробництві. Її використовують для розуміння варіативності систем вимірювання, керування процесами (як у статистичнім керуванні процесами, англ. statistical process control, SPC), узагальнювання даних, та для здійснення керованих даними рішень. В цих ролях вона є ключовим, і, можливо, єдиним надійним інструментом.

{{cite journal}}: Обслуговування CS1: Сторінки із непозначеним DOI з безкоштовним доступом (посилання) (англ.)Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.