Loading AI tools

particule subatomique de charge électrique négative De Wikipédia, l'encyclopédie libre

L'électron, un des composants de l'atome avec les neutrons et les protons, est une particule élémentaire qui possède une charge élémentaire de signe négatif. Il est fondamental en chimie, car il participe à presque tous les types de réactions chimiques et constitue un élément primordial des liaisons présentes dans les molécules. En physique, l'électron intervient dans une multitude de rayonnements et d'effets. Ses propriétés, qui se manifestent à l'échelle microscopique, expliquent la conductivité électrique, la conductivité thermique, l'effet Tcherenkov, l'incandescence, l'induction électromagnétique, la luminescence, le magnétisme, le rayonnement électromagnétique, la réflexion optique, l'effet photovoltaïque et la supraconductivité, phénomènes macroscopiques largement exploités dans les industries. Possédant la plus faible masse de toutes les particules chargées, il sert régulièrement à l'étude de la matière.

| Classification | |

|---|---|

| Famille | |

| Groupe | |

| Génération |

1re |

| Interaction(s) | |

| Symbole | |

| Nbr. de types |

1 |

| Antiparticule |

| Masse | |

|---|---|

| Charge électrique | |

| Moment magnétique |

9,274 × 10−24 J/T |

| Spin |

½ |

| Parité |

+1 |

| Durée de vie |

> 2,1 × 1036 s[4] |

| Prédiction | |

|---|---|

| Découverte |

1897 |

| Découvreur |

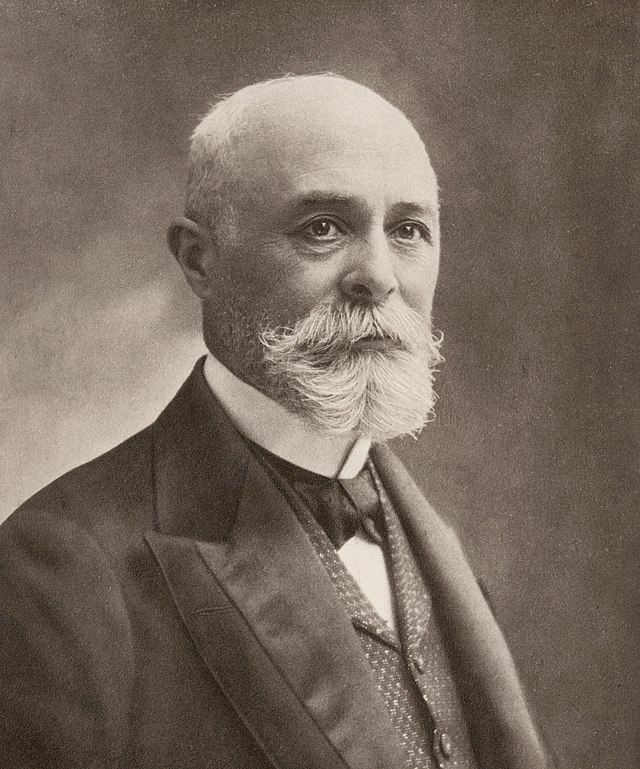

Le concept d'une quantité indivisible de charge électrique est élaboré à partir de 1838 par le naturaliste britannique Richard Laming afin d'expliquer les propriétés chimiques des atomes. L'électron est identifié comme le corpuscule envisagé par Joseph John Thomson et son équipe de physiciens britanniques en 1897, à la suite de leurs travaux sur les rayons cathodiques.

C'est à cette époque que Thomson propose son modèle atomique. En 1905, Albert Einstein propose une explication de l'effet photoélectrique — des électrons émis par la matière sous l'influence de la lumière — qui servira d'argument en faveur de la théorie des quanta. En 1912, Niels Bohr explique les raies spectrales en postulant la quantification de l'orbite des électrons de l'atome hydrogène, autre argument soutenant cette théorie. En 1914, les expériences d'Ernest Rutherford et d'autres ont solidement établi la structure de l'atome comme un noyau positivement chargé entouré d'électrons de masse plus faible. En 1923, les résultats expérimentaux d'Arthur Compton convainquent une majorité de physiciens de la validité de la théorie des quanta. En 1924, Wolfgang Pauli définit le principe d'exclusion de Pauli, ce qui implique que les électrons possèdent un spin. La même année, Louis de Broglie émet l'hypothèse, vérifiée plus tard, que les électrons présentent une dualité onde-corpuscule. En 1928, Paul Dirac publie son modèle de l'électron qui l'amènera à prédire l'existence du positon puis de l'antimatière. D'autres études des propriétés de l'électron ont mené à des théories plus complètes de la matière et du rayonnement.

Les anciens Grecs ont déjà remarqué que l'ambre attire de petits objets quand il est frotté avec de la fourrure ; en dehors de la foudre, ce phénomène est la plus ancienne expérience de l'humanité en rapport avec l'électricité[6], un déplacement de particules électriquement chargées.

En 1269, Pierre de Maricourt, un ingénieur militaire au service du prince français Charles Ier de Sicile, étudie les propriétés des aimants permanents. « Cette étude, qui nous a été transmise sous forme d'une lettre écrite à l'un de ses collègues, comprend la plupart des expériences élémentaires aujourd'hui décrites dans les manuels de physique. »[7] Dans son traité de 1600 De Magnete, le médecin anglais William Gilbert crée le mot latin « electricus » pour désigner la propriété d'attirer les petits objets après frottement[8]. Le mot « électrique » dérive de l'anglais « electrick », qui dérive lui-même du latin « electricus » : « propre à l'ambre[9] ». Le mot latin ēlectrum dérive du grec ἤλεκτρον / êlectron désignant l'ambre.

Francis Hauksbee dans les années 1700 et C. F. du Fay en 1737 découvrent indépendamment deux sortes d'électricité : l'une obtenue en frottant du verre et l'autre engendrée en frottant de la résine. Du Fay en conclut que l'électricité peut se réduire à deux fluides électriques, « vitreux » et « résineux », que l'on sépare par frottement, et que l'on peut recombiner ensemble[10]. Une décennie plus tard, Benjamin Franklin soutient que l'électricité ne diffère pas des autres types de fluides électriques mais qu'il s'agit de la même chose, sous des pressions différentes. Il lui apporte la terminologie moderne de charge positive ou négative respectivement[11],[12].

Entre 1838 et 1851, le naturaliste britannique Richard Laming développe l'idée qu'un atome est composé d'un noyau de matière, entouré de particules subatomiques qui ont une charge électrique unité[13]. À partir de 1846, le physicien allemand Wilhelm Eduard Weber défend la théorie que l'électricité est composée de fluides chargés positivement et négativement, et qu'une loi en carré inverse régit leur interaction[14]. Après avoir étudié l'électrolyse en 1874, le physicien irlandais George Stoney suggère qu'il existe « une seule quantité définie d'électricité » : la charge d'un ion monovalent. Ce postulat lui donne la capacité d'estimer la valeur de cette charge élémentaire e à partir des lois de l'électrolyse de Faraday[15]. Cependant, Stoney croit que ces charges sont attachées de façon permanente aux atomes, et ne peuvent donc leur être enlevées[16]. En 1881, le physicien allemand Hermann von Helmholtz est convaincu que les charges positives et négatives sont composées de parties élémentaires, chacune « se comportant comme des atomes d'électricité[17] ».

En 1894, Stoney invente le terme d'« électron » pour désigner ces charges élémentaires, écrivant « [...] une estimation a été faite de la valeur réelle de cette unité fondamentale très remarquable d'électricité, pour laquelle je me suis risqué à proposer le nom d'"électron" »[18]. Le mot électron est une combinaison du mot « électrique » et du suffixe « -on », ce dernier étant par la suite utilisé pour désigner une particule subatomique, comme le proton ou le neutron[19],[20].

Pendant le XIXe siècle, les physiciens allemands Julius Plücker et Johann Wilhelm Hittorf étudient la conductivité électrique des gaz dans des ampoules de verre scellées munies d'une cathode et d'une anode[22] qui permettent de soumettre le gaz à un courant électrique. En 1869, Hittorf observe l'émission, par la cathode, de « faisceaux de particules » chargées si l'ampoule contient un gaz à basse pression[23],[24]. En 1876, le physicien allemand Eugen Goldstein montre que les rayons de cette lueur provoquent une ombre, et il les appelle rayons cathodiques[25]. Pendant les années 1870, le chimiste et physicien anglais William Crookes met au point le premier tube à rayons cathodiques avec un vide poussé à l'intérieur — nommé par la suite « tube de Crookes[26] ». Puis il montre que les rayons lumineux apparaissant dans le tube transmettent de l'énergie, et se déplacent de la cathode vers l'anode. De plus, en appliquant un champ magnétique, il est capable de défléchir les rayons, montrant ainsi que le faisceau se comporte comme s'il était chargé[27],[28]. En 1879, il propose d'expliquer ces propriétés par ce qu'il appelle « matière radiante ». Il estime qu'il s'agit d'un quatrième état de la matière, consistant en molécules chargées négativement, projetées à grande vitesse de la cathode[29].

Le physicien britannique né allemand Arthur Schuster développe les expériences de Crookes en disposant des plaques métalliques parallèlement aux rayons cathodiques, par lesquelles il peut appliquer différents potentiels électriques. Le champ électrique défléchit les rayons vers la plaque chargée positivement, ce qui renforce la preuve que les rayons portent une charge négative. En mesurant la déflexion selon la différence de potentiel, Schuster est capable en 1890 de mesurer le rapport masse sur charge des composants des rayons. Cependant, son calcul donne une valeur plus de mille fois inférieure à la valeur attendue, si bien que les contemporains n'accordent que peu de confiance à son calcul[27],[30]. En 1895, le doctorant et futur physicien français Jean Perrin établit expérimentalement la nature corpusculaire de l'électron, alors que plusieurs scientifiques de cette époque considèrent l'électron comme une onde[31],[32].

En 1896-1897, le physicien britannique Joseph John Thomson et ses collègues John Townsend et Harold A. Wilson réalisent des expériences indiquant que les rayons cathodiques sont effectivement des particules individualisées, plutôt que des ondes, des atomes ou des molécules comme les spécialistes le croient à l'époque[33],[34]. Thomson fait de bonnes estimations à la fois de la charge e et de la masse m, trouvant que les particules des rayons cathodiques, qu'il appelle « corpuscules », ont environ un millième de la masse de l'ion le plus léger connu alors : l'hydrogène[35]. Il montre que le rapport charge sur masse e/m est indépendant de la matière de la cathode. Il montre de plus que les particules chargées négativement produites par les matériaux radioactifs, les matières chauffées et les matières illuminées sont les mêmes[36]. Son travail considérable sur la déflexion des rayons cathodiques dans un champ électrique est probablement la raison pour laquelle on lui attribue la découverte de l'électron[37],[38],[39]. Le nom d'électron est proposé à nouveau par le physicien irlandais George F. Fitzgerald, cette fois avec succès[27]. Historiquement, l'électron est la première particule élémentaire mise en évidence[40].

En 1900, Paul Drude propose de considérer l'ensemble des électrons d'un métal comme un gaz parfait. Il parvient alors à justifier théoriquement une conclusion expérimentale selon laquelle les bons conducteurs électriques sont aussi de bons conducteurs thermiques. Même si son hypothèse est fausse selon les connaissances actuelles, ce concept de « gaz parfait d'électrons » est encore utilisé en mécanique quantique[41].

En étudiant les minéraux naturellement fluorescents, le physicien français Henri Becquerel découvre que ceux-ci émettent des rayonnements en l'absence de toute source d'énergie externe. Ces matériaux radioactifs provoquent l'engouement des scientifiques, y compris celui du physicien néo-zélandais Ernest Rutherford, qui découvre qu'ils émettent des particules. Il leur donne le nom de particules alpha, bêta et gamma, selon leur pouvoir de pénétration de la matière[42]. En 1900, Becquerel montre que les rayons bêta émis par le radium sont défléchis par un champ électrique, et que leur rapport masse sur charge est le même que celui des rayons cathodiques[43]. Ce résultat conforte l'idée que les électrons existent comme composants des atomes[44],[45].

La charge de l'électron est mesurée de façon plus précise en 1909 par l'expérience de la goutte d'huile du physicien américain Robert Millikan, qui en publie les résultats en 1911. Cette expérience utilise un champ électrique pour compenser la pesanteur et empêcher ainsi une goutte d'huile chargée de tomber. Ce système permet de mesurer la charge électrique depuis quelques ions jusqu'à 150, avec une marge d'erreur de moins de 0,3 %. Des expériences comparables ont été faites plus tôt par le groupe de Thomson, en utilisant des brouillards de gouttelettes d'eau chargées par électrolyse[33] et en 1911 par Abram Ioffé, qui a obtenu indépendamment le même résultat que Millikan en utilisant des microparticules de métal, et a publié ses résultats en 1913[46]. Cependant, les gouttes d'huile, moins volatiles, se prêtent mieux à des expériences de longue durée[47].

Vers le début du XXe siècle, des physiciens découvrent que, sous certaines conditions, une particule rapide provoque sur sa trajectoire la condensation de la vapeur d'eau sursaturée. En 1911, le physicien écossais Charles Thomson Rees Wilson, l'un des collaborateurs de Thomson[48], utilise cet effet pour mettre au point sa chambre à brouillard, qui permet de photographier les traces de particules chargées, comme des électrons rapides[49], ce qui facilite donc leur étude.

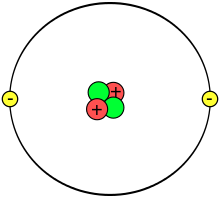

Les travaux du physicien néo-zélandais Ernest Rutherford, de 1909 à 1912, l'amènent à conclure que l'atome est constitué d'un petit noyau comprenant toute la charge positive et presque toute la masse de l'atome, noyau qui est entouré d'un nuage électronique[51],[52] (voir Expérience de Rutherford). Le physicien britannique Henry Moseley, qui travaille dans le laboratoire de Rutherford en 1913, établit avec certitude l'ordre des éléments chimiques dans le tableau périodique[53] (voir Loi de Moseley).

En 1913, le physicien danois Niels Bohr postule que les électrons sont dans des états quantifiés, dont l'énergie est déterminée par le moment angulaire autour du noyau. Les électrons peuvent passer d'un état à l'autre, par émission ou absorption de photons à des fréquences spécifiques. Au moyen de ces orbites quantifiées, il explique avec toute la précision requise les raies spectrales de l'atome d'hydrogène[54].

Les travaux des physiciens allemands James Franck et Gustav Hertz, de 1912 à 1914, prouvent la quantification des niveaux d'énergie des électrons dans les atomes et confirment donc les hypothèses du modèle de l'atome de Bohr[55] (voir Expérience de Franck et Hertz). Toutes ces expériences établissent solidement la structure de l'atome comme un noyau chargé positivement et entouré d'électrons de masse plus faible[56].

Cependant, le modèle de Bohr ne peut rendre compte des intensités relatives des raies spectrales, ni expliquer les spectres d'atomes plus complexes[56]. Malgré ces faiblesses, ce modèle atomique servira d'argument en faveur de la théorie des quanta[57].

Les liaisons chimiques entre atomes sont expliquées par Gilbert Lewis, qui propose en 1916 que la liaison covalente entre atomes est une paire d'électrons partagés[58]. Plus tard, en 1927, Walter Heitler et Fritz London expliquent complètement la formation des paires d'électrons et des liaisons chimiques en termes de mécanique quantique[59]. En 1919, le chimiste américain Irving Langmuir raffine le modèle statique d'atome de Lewis, et suggère que tous les électrons sont distribués sur des « couches concentriques (à peu près) sphériques, toutes de même épaisseur[60] ». Les couches sont à leur tour divisées en un certain nombre de cellules, chacune contenant une paire d'électrons. Avec ce modèle, Langmuir explique qualitativement les propriétés chimiques de tous les éléments du tableau périodique[59], que les scientifiques rapprochent selon la loi de similitude[61].

En 1924, le physicien autrichien Wolfgang Pauli remarque que la structure en couches de l'atome s'explique par le jeu de quatre paramètres qui définissent tous les états énergétiques, tant que chaque état n'est occupé que par un seul électron[62],[63]. Cette interdiction faite à deux électrons d'occuper le même état est devenue connue sous le nom de « principe d'exclusion de Pauli ». Le mécanisme déterminant le quatrième paramètre et ses deux valeurs, est fourni par les physiciens néerlandais Samuel Goudsmit et George Uhlenbeck, quand ils suggèrent que l'électron, outre le moment angulaire de son orbite, pourrait avoir un moment angulaire intrinsèque[56],[64]. Cette propriété devient notoire sous le nom de « spin » : elle explique le dédoublement des raies spectrales observé avec un spectrographe à haute résolution, qui est resté mystérieux jusque-là ; ce phénomène est connu sous le nom de structure hyperfine des raies[65]. Le principe de Pauli explique pourquoi la matière dite ordinaire crée ce qui est appelé le « volume » de la matière[66],[67],[68],[69],[70].

Les électrons possèdent, comme toute la matière, la propriété quantique d'être à la fois ondes et corpuscules, si bien qu'ils peuvent avoir des collisions avec d'autres particules, et être diffractés comme la lumière. Cette dualité est facile à constater avec les électrons en raison de leur faible masse. Un électron, en raison de son spin, est un fermion, et satisfait donc au principe d'exclusion de Pauli[71].

En 1887, l'effet photoélectrique est observé par Heinrich Hertz alors qu'il étudie les ondes électromagnétiques[72], et plusieurs scientifiques ont tenté d'en expliquer les mécanismes, sans résultat. Vingt ans plus tard, en 1905, Albert Einstein propose une première explication, qui lui vaudra le prix Nobel de physique de 1921[73]. Selon lui, des électrons sont émis par la matière seulement si la fréquence de la lumière est supérieure à un certain seuil. Pour y parvenir, il introduit le concept de photon, en utilisant celui de quantum d'énergie récemment proposé dans un tout autre contexte par Max Planck. L'explication d'Einstein sera l'un des premiers arguments en faveur de la théorie des quanta[74]. En 1923, Arthur Compton observe l'allongement de la longueur d'onde du photon causée par la diffusion qui porte son nom, laquelle est provoquée par l'interaction des photons et des électrons. « Ces résultats expérimentaux [sont] les premiers à convaincre la majorité des physiciens de la validité de la théorie quantique[75]. »

Dans sa publication Recherches sur la théorie des quanta, en 1924, le physicien français Louis de Broglie émet l'hypothèse que toute matière possède une onde de De Broglie semblable à la lumière[76]. C'est-à-dire que, selon les conditions, les électrons et autres particules matérielles montrent les propriétés soit de particules, soit d'ondes. Les propriétés corpusculaires d'une particule sont patentes quand elle apparaît à tout moment localisée à un endroit dans l'espace le long d'une trajectoire[77]. La nature ondulatoire est observée, par exemple, quand un faisceau passe à travers des fentes parallèles et crée des figures d'interférence. En 1927, l'effet d'interférence avec un faisceau d'électrons est montré par le physicien anglais George Paget Thomson, au moyen d'un mince film métallique, et par les physiciens américains Clinton Davisson et Lester Germer en utilisant un cristal de nickel[78].

Le succès de la prédiction de De Broglie conduit à la publication par Erwin Schrödinger, en 1926, de l'équation de Schrödinger qui décrit avec succès la propagation des électrons en tant qu'onde[79]. Plutôt que de fournir une solution donnant la position d'un électron, cette équation d'onde peut être utilisée pour calculer la probabilité de trouver un électron dans un certain volume. Cette approche est ultérieurement nommée mécanique quantique, et donne une très bonne approximation des états d'énergie dans l'atome d'hydrogène[80]. Une fois le spin et les interactions entre les électrons pris en compte, la mécanique quantique modélise avec succès le comportement des électrons dans les atomes plus complexes que celui de l'hydrogène[81].

En 1928, améliorant le travail de Wolfgang Pauli[82], le physicien britannique Paul Dirac conçoit un modèle de l'électron — l'équation de Dirac — compatible avec la théorie de la relativité et la mécanique quantique[83]. Pour résoudre certaines lacunes de son équation relativiste, Dirac développe en 1930 un modèle de vide avec une mer infinie de particules d'énergie négative, parfois nommée « mer de Dirac ». Ceci le conduit à prédire l'existence du positon, équivalent de l'électron dans l'antimatière[84],[85], « substance » également prédite par Dirac[86],[87]. Le positon est découvert par Carl D. Anderson, qui propose d'appeler les électrons standard « négatrons » et d'utiliser le terme « électron » comme terme générique pour désigner les deux charges sans distinction. Cet usage du terme « négatron » est encore rencontré à l'occasion, et peut être abrégée en « négaton »[88],[89].

En 1947, le physicien américain Willis Lamb, en collaboration avec le thésard Robert Retherford, découvre que certains états quantiques de l'atome d'hydrogène, qui devraient avoir la même énergie, se distinguent par un certain décalage[90], c'est le décalage de Lamb. À peu près au même moment, le physicien germano-américain Polykarp Kusch, travaillant avec Henry M. Foley, découvre que le moment magnétique de l'électron est un peu plus grand que celui prédit par la théorie de Dirac. Cet écart sera ultérieurement appelé « moment magnétique anomal » de l'électron. Pour résoudre ces problèmes, une théorie plus élaborée, appelée « électrodynamique quantique », est mise au point par Sin-Itiro Tomonaga, Julian Schwinger et Richard Feynman à la fin des années 1940[91],[92],[93].

Photo des participants du 5e Congrès Solvay tenu en 1927 sur le thème « Électrons et photons ». Plusieurs ont réalisé des travaux marquants sur les propriétés de l'électron ou ont mis au point des instruments importants pour les étudier :

Dix-sept lauréats du prix Nobel apparaissent sur cette photo. C'est pendant ce congrès que commencent les débats Bohr-Einstein sur les conséquences philosophiques de la mécanique quantique[94]. |

La masse d'un électron est approximativement 9,109 × 10−31 kg[3],[note 1], ou 5,489 × 10−4 unité de masse atomique[95]. Sur la base du principe d'équivalence masse-énergie d'Einstein, ceci correspond à une énergie de 511 keV[3],[note 2]. Le rapport entre les masses du proton et de l'électron est d'environ 1 836[note 3],[96],[97]. Les mesures astronomiques montrent que ce rapport n'a pas changé de façon mesurable pour la moitié de l'âge de l'Univers, comme prédit par le modèle standard[98].

L'électron a une charge électrique de −1,602 × 10−19 C[3],[note 4], qui est utilisée comme unité standard de charge pour les particules subatomiques. Selon la limite actuelle de la précision des expériences, la charge de l'électron est directement opposée à celle du proton[100]. Comme le symbole e est utilisé pour la charge élémentaire, le symbole de l'électron est e−, le signe – indiquant la charge de l'électron. L'antiparticule de l'électron[101], le positon, de symbole e+, est de charge électrique opposée[3],[102]. Ceci permet l'annihilation d'un électron avec un positon, en ne produisant que de l'énergie sous forme de rayons gamma[103],[104].

Selon le modèle standard, l'électron n'a pas de sous-composant connu[105], c'est donc une particule élémentaire[106],[107]. On le définit comme une particule ponctuelle avec une charge ponctuelle[71],[note 5]. L'observation d'un électron isolé dans un piège de Penning démontre que le rayon de cette particule est inférieur à 10−22 m[109]. Il y a bien pourtant une constante physique que l'on appelle « rayon classique de l'électron »[110], dont la valeur bien plus grande est de 2,817 9 × 10−15 m[note 6]. Cependant cette terminologie provient d'un calcul qui ignore les effets de la mécanique quantique : ce supposé rayon ne peut servir à décrire la structure fondamentale de l'électron, qui n'est pas assimilable à un objet solide et compact, mais à la fluctuation diffuse d'une onde, conformément à la mécanique ondulatoire[111],[note 7]. Néanmoins, il donne un ordre de grandeur des dimensions pour lesquelles l'électrodynamique quantique devient importante pour comprendre la structure et le comportement de l'électron, notamment par la renormalisation.

Les scientifiques pensent, en s'appuyant sur des bases théoriques, que l'électron est stable : comme c'est la particule la plus légère de charge non nulle, sa désintégration violerait la conservation de la charge électrique[113]. Expérimentalement, la limite inférieure pour la vie moyenne de l'électron est de 2,1 × 1036 s[4] (l'âge de l'Univers est estimé à 4,34 × 1017 s[114]). L'électron diffère en cela des autres leptons chargés, le muon et le tauon, de courtes durées de vie[115].

L'électron a un moment angulaire intrinsèque, ou spin, de [3]. Cette propriété est généralement exprimée en appelant l'électron « particule de spin »[102]. Pour ce genre de particules, la valeur absolue du spin est [note 8], tandis que le résultat de la mesure de la projection du spin sur n'importe quel axe ne peut être que ± ħ/2. Outre le spin, l'électron possède un moment magnétique le long de son spin[3]. Il est approximativement égal à un magnéton de Bohr[116],[note 9], qui est une constante physique égale à 9,274 × 10−24 J/T[3],[note 10]. La projection du spin sur la direction de la quantité de mouvement de l'électron définit la propriété connue sous le nom d'« hélicité »[117],[118].

La forme d'un électron, si elle existe (en tant que particule élémentaire, l'électron ne devrait pas avoir de dimension et donc pas de forme mais il est entouré d'un nuage de particules virtuelles qui lui, a une forme[119]) ne peut être mesurée que de manière détournée : par la mesure de la répartition spatiale de sa charge électrique. Ainsi une forme de nuage parfaitement sphérique donnerait lieu à un champ électrique homogène dans toutes les directions (monopôle électrique) et une forme non sphérique donnerait lieu à un dipôle électrique (dipôle électrostatique). Le modèle standard suggère que le nuage n'est pas sphérique et qu'il constitue un dipôle électrique. Or il semble que la répartition de sa charge électrique soit proche d'une sphère parfaite, à 10−27 cm près[120],[121], c'est-à-dire que le moment de ce dipôle est quasi nul. Si l'on grossissait le nuage de particules virtuelles d'un électron de sorte qu'il ait le diamètre du système solaire, son dipôle électrostatique (supposé représenter son défaut de sphéricité) serait, au maximum, de l'ordre de la largeur d'un cheveu[122]. Ce résultat a été mesuré grâce à l'étude par laser de molécules de fluorures d'ytterbium refroidies à très basse température[123]. Si les électrons avaient un défaut de sphéricité (un moment dipolaire), leur champ électrique oscillerait et induirait des déformations de la molécule, ce qui n'a pas été mis en évidence[124].

L'électron présente une dualité onde-particule, qui peut être démontrée par l'expérience des fentes de Young. Cette propriété lui permet de passer à travers deux fentes parallèles simultanément, plutôt que juste une seule fente, comme cela serait le cas pour une particule classique[126]. En mécanique quantique, la propriété ondulatoire d'une particule peut être décrite mathématiquement comme une fonction à valeurs complexes, la fonction d'onde, couramment dénotée par la lettre grecque psi (ψ). Quand la valeur absolue de cette fonction est élevée au carré, cela donne la probabilité d'observer une particule dans un petit volume près de la position choisie — une densité de probabilité[127]. L'électron peut franchir une barrière de potentiel par effet tunnel, phénomène que la mécanique classique est incapable d'expliquer et que la mécanique quantique explique en faisant appel à la notion de fonction d'onde[128].

Les électrons sont des particules indiscernables, parce qu'ils ne peuvent pas être distingués entre eux par leurs propriétés physiques intrinsèques. En mécanique quantique, ceci signifie qu'une paire d'électrons en présence doit pouvoir intervertir leur position sans provoquer de changement observable dans l'état du système. La fonction d'onde des fermions, notamment des électrons, est antisymétrique, c'est-à-dire qu'elle change de signe lors de l'échange de deux électrons :

où et sont les positions des deux électrons. Comme la valeur absolue est invariable lors du changement de signe de la fonction, ceci indique que les probabilités sont les mêmes. Les bosons, tels les photons, ont des fonctions d'onde symétriques[127].

Dans le cas de l'antisymétrie, les solutions de l'équation d'onde pour des électrons en interaction résultent en une probabilité nulle que deux électrons occupent la même position, ou, en tenant compte du spin, le même état. C'est la cause du principe d'exclusion de Pauli, qui empêche deux électrons d'occuper le même état quantique. Ce principe explique beaucoup de propriétés des électrons. Par exemple, il permet d'affirmer que des nuages d'électrons liés au même noyau occupent des orbitales toutes différentes, plutôt que de tous se concentrer dans l'orbitale la moins énergétique[127].

Dans le modèle standard de la physique des particules, les électrons appartiennent au groupe des particules subatomiques appelées « leptons »[71], que les scientifiques pensent être des particules élémentaires ou fondamentales, c'est-à-dire qu'elles ne comportent pas de sous-particules. Les électrons ont la plus faible masse de toutes les particules chargées, et appartiennent à la première famille ou génération[131]. Ils sont soumis aux forces gravitationnelles, faibles et électromagnétiques, mais échappent aux interactions fortes[132].

Les seconde et troisième générations contiennent des leptons chargés, le muon et le tauon, identiques à l'électron sous tous rapports, sauf leur masse, bien plus élevée. Les leptons diffèrent des autres constituants de base de la matière, les quarks, parce qu'ils ne sont pas sensibles aux interactions fortes. Tous les membres du groupe des leptons sont des fermions, parce qu'ils ont un spin [102].

Les physiciens pensent que le vide peut être rempli de paires de particules « virtuelles », comme des électrons et des positons, qui se créent et s'annihilent rapidement ensuite[133]. La combinaison de la variation d'énergie nécessaire à la création de ces particules, et du temps pendant lequel elles existent, reste en dessous du seuil de détectabilité exprimé par le principe d'incertitude de Heisenberg :

Pratiquement, l'énergie demandée pour créer les particules, , peut être « empruntée » au vide pour une durée , dans la mesure où le produit n'est pas plus grand que la constante de Planck réduite [134]. Donc pour une paire électron-positon virtuelle, [135].

Tant qu'une paire virtuelle électron-positon subsiste, la force coulombienne du champ électrique ambiant entourant un électron fait que le positon est attiré par ce dernier, tandis que l'électron de la paire est repoussé. Ceci provoque ce que l'on appelle la « polarisation du vide »[note 11]. En fait, le vide se comporte comme un milieu ayant une permittivité diélectrique supérieure à l'unité. Donc la charge effective d'un électron est plus faible que sa valeur nominale[137]. Elle est de plus en plus élevée en s'approchant de la particule : les charges portées par les particules virtuelles masquent celle de l'électron[138],[139],[140]. Les particules virtuelles provoquent un effet de masquage comparable pour la masse de l'électron[141].

L'interaction avec des particules virtuelles explique aussi la légère déviation (environ 0,1 %) entre le moment magnétique intrinsèque de l'électron et le magnéton de Bohr (le moment magnétique anomal)[116],[142]. La précision extraordinaire de l'accord entre cette différence prévue par la théorie et la valeur déterminée par l'expérience est considérée comme une des grandes réussites de l'électrodynamique quantique[143].

En physique classique, le moment angulaire et le moment magnétique d'un objet dépendent de ses dimensions physiques. Il paraît donc incohérent de concevoir un électron sans dimensions possédant ces propriétés. Le paradoxe apparent peut être expliqué par la formation de photons virtuels dans le champ électrique engendré par l'électron. Ces photons font se déplacer l'électron de façon saccadée (ce qui s'appelle Zitterbewegung en allemand, ou mouvement de tremblement)[144] qui résulte en un mouvement circulaire avec une précession. Ce mouvement produit à la fois le spin et le moment magnétique de l'électron[71],[145]. Dans les atomes, cette création de photons virtuels explique le décalage de Lamb observé dans les raies spectrales[138].

Un électron engendre un champ électrique qui exerce une force attractive sur une particule positivement chargée, comme un proton, et une force répulsive sur une particule négative. La valeur de cette force est donnée par la loi de Coulomb[146]. Quand un électron est en mouvement, il engendre aussi un champ magnétique[147], cause du magnétisme[148]. La loi d'Ampère-Maxwell relie le champ magnétique au mouvement d'ensemble des électrons (le courant électrique) par rapport à un observateur. C'est cette propriété d'induction qui fournit l'induction électromagnétique qui fait tourner un moteur électrique[149]. Le champ électromagnétique d'une particule chargée animée d'un mouvement arbitraire est exprimé par les potentiels de Liénard-Wiechert, valables même quand la vitesse de la particule s'approche de celle de la lumière (relativiste)[150].

Quand un électron se déplace dans un champ magnétique, il est soumis à une force de Lorentz, dirigée perpendiculairement au plan défini par le champ et la vitesse de l'électron. Cette force perpendiculaire à la trajectoire contraint l'électron, dans un champ magnétique uniforme, à suivre une trajectoire hélicoïdale dans le champ, sur un cylindre (imaginaire) dont le rayon est appelé « rayon de Larmor ». L'accélération due à ce mouvement en courbe conduit l'électron à émettre de l'énergie sous forme de rayonnement synchrotron[151],[152],[note 12]. L'émission d'énergie à son tour provoque un recul de l'électron, ce qui est connu sous le nom de « force d'Abraham-Lorentz-Dirac », qui crée une friction qui ralentit l'électron. Cette force est provoquée par une réaction du propre champ de l'électron[153].

En électrodynamique quantique, l'interaction électromagnétique entre particules est transmise par des photons. Un électron isolé, qui ne subit pas d'accélération, ne peut pas émettre ni absorber un photon réel : ceci violerait la conservation de l'énergie et de la quantité de mouvement. En revanche, des photons virtuels peuvent transférer de la quantité de mouvement entre deux particules chargées. C'est cet échange de photons virtuels qui, en particulier, engendre la force de Coulomb[154]. Une émission d'énergie peut avoir lieu quand un électron en mouvement est défléchi par une particule chargée, comme un proton. L'accélération de l'électron résulte en émission de rayonnement continu de freinage[155].

Une collision inélastique entre un photon (lumière) et un électron solitaire (libre) s'appelle « diffusion Compton ». Cette collision résulte en un transfert d'énergie et de moment entre les particules, qui modifie la longueur d'onde du photon par une quantité appelée « décalage Compton »[note 13]. La valeur maximale de ce décalage est (avec , la constante de Planck, , la masse de l'électron et , la vitesse de la lumière), que l'on désigne sous le nom de « longueur d'onde de Compton »[157]. Pour un électron, elle vaut 2,43 × 10−12 m[3]. Une telle interaction entre la lumière et les électrons libres est appelée « diffusion Thomson » ou « diffusion linéaire de Thomson »[158].

La force relative de l'interaction électromagnétique entre deux particules, comme un électron et un proton, est donnée par la constante de structure fine. C'est une quantité sans dimension formée par le rapport de deux énergies : l'énergie électrostatique d'attraction (ou de répulsion) à la distance d'une longueur d'onde de Compton, et l'énergie au repos de la charge. La constante est donnée par α ≈ 7,297 353 × 10−3, qui vaut approximativement 1/137[3].

Quand des électrons et des positons entrent en collision, ils peuvent s'annihiler, donnant 2 ou 3 photons. Si l'électron et le positon ont un moment négligeable, il peut se former un état lié (positronium) avant que l'annihilation ne se produise, donnant 2 ou 3 photons, dont l'énergie totale est 1,022 MeV[159],[160]. Par ailleurs, des photons de haute énergie peuvent se transformer en une paire d'électron et positon par un processus inverse de l'annihilation que l'on appelle « production de paires », mais seulement en présence d'une particule chargée proche, comme un noyau, susceptible d'absorber le moment de recul[161],[162].

En théorie des interactions électrofaibles, la composante gauche de la fonction d'onde de l'électron forme un doublet d'isospin faible avec le neutrino-électron. Vis-à-vis des interactions faibles, les neutrinos-électrons se comportent en effet comme des électrons. Chaque membre de ce doublet peut subir une interaction par courant chargé transformant l'un en l'autre par émission ou absorption de boson W±, cette transformation étant à la base de la désintégration β des noyaux. L'électron, comme le neutrino, peut subir une interaction par courant neutre couplé au Z0, ce qui est notamment la cause de la diffusion électron-neutrino[163]. En plus de l'isospin, l'électron est doté d'une hypercharge selon la théorie électrofaible[164].

Un électron peut être « lié » au noyau d'un atome par la force de Coulomb attractive[165]. Un système d'électrons liés à un noyau en nombre égal à la charge positive de ce dernier est appelé un « atome neutre »[166]. Si le nombre d'électrons est différent, le système s'appelle un « ion »[167]. Le noyau des atomes comporte des protons et, en général, des neutrons. Les atomes sont donc formés de trois particules : électrons, neutrons et protons[168],[169]. Le comportement ondulatoire d'un électron lié est décrit par une fonction appelée « orbitale atomique ». Chaque orbitale a son propre ensemble de nombres quantiques, tels que l'énergie, le moment angulaire et la projection de ce dernier sur un axe donné[170]. Suivant le principe d'exclusion de Pauli, chaque orbitale ne peut être occupée au plus que par deux électrons, de spins différents[171].

Les électrons peuvent changer d'orbitale par émission ou absorption d'un photon dont l'énergie égale la différence d'énergie potentielle entre ces orbitales atomiques[172]. D'autres méthodes de transfert d'orbitale comprennent les collisions avec des particules comme les électrons, et l'effet Auger[173]. Pour s'échapper d'un atome, l'énergie de l'électron doit être hissée au-dessus de son énergie de liaison à l'atome. Ceci peut arriver dans l'effet photoélectrique, quand un photon incident a une énergie qui dépasse l'énergie d'ionisation de l'électron qui l'absorbe[174].

Le moment angulaire orbital des électrons est quantifié. Comme l'électron est chargé, il produit un moment magnétique orbital proportionnel à son moment angulaire. Le moment magnétique total d'un atome est égal à la somme des moments magnétiques propres et orbitaux de tous les électrons et du noyau. Celui du noyau, cependant, est négligeable par rapport à celui des électrons. Les moments magnétiques des électrons qui occupent la même orbitale (électrons en paire) s'annulent[175].

En physique, la liaison chimique entre atomes résulte d'interactions électromagnétiques, décrites par les lois de la mécanique quantique[176]. Selon leur proximité du noyau, les chimistes considèrent les électrons de cœur et les électrons de valence ; ce sont ces derniers qui interviennent dans la liaison chimique[177]. Les plus fortes sont les liaisons covalentes et les liaisons ioniques, qui permettent la formation de molécules[178]. Dans une molécule, les électrons se déplacent sous l'influence de plusieurs noyaux, et occupent des orbitales moléculaires, de la même façon qu'ils occupent des orbitales dans des atomes isolés[179]. Un facteur fondamental dans ces structures moléculaires est l'existence de paires d'électrons : celles-ci sont des électrons de spins opposés, ce qui leur permet d'occuper la même orbitale moléculaire sans violer le principe d'exclusion de Pauli (de la même manière que dans les atomes). Les orbitales moléculaires différentes ont des distributions spatiales de densité d'électrons différentes. Par exemple, dans les paires liantes — qui lient les atomes ensemble, on trouve des électrons avec une densité maximale dans un relativement petit volume entre les atomes. Au contraire, pour les paires non liantes, les électrons sont distribués dans un grand volume autour des noyaux[180]. C'est l'existence de paires liantes, où des électrons périphériques sont mis en commun par deux atomes voisins, qui caractérise la liaison covalente. La liaison ionique s'établit lorsque deux ions sont fortement liés par attraction électrostatique[181], ce qui se produit si un électron d'un atome a une orbitale moléculaire majoritairement située à proximité de l'autre atome.

Les réactions d'oxydoréduction — des échanges d'électrons — englobent la combustion, la métallurgie, l'électrochimie, la corrosion et la respiration cellulaire[182],[183].

Si un corps a trop d'électrons, ou pas assez, pour équilibrer les charges positives des noyaux, il a une charge électrique non nulle : négative s'il y a trop d'électrons ; positive dans le cas contraire. Si les charges s'équilibrent, le corps est dit neutre[187].

Des électrons se déplaçant indépendamment, comme dans le vide, sont dits « libres ». Les électrons de valence dans les métaux se comportent aussi comme s'ils étaient libres. De plus, il peut y avoir dans un solide des trous, qui sont des endroits où manque un électron. Ces trous peuvent être comblés par les électrons voisins, mais cela ne fera que déplacer les trous. On peut avoir dans des solides une prédominance de la conduction de l'électricité par le déplacement de trous, plutôt que par le déplacement d'électrons. En fait, les particules porteuses de charge dans les métaux et autres solides sont des « quasi-particules », de charge électrique négative ou positive, semblables aux électrons réels[188].

Quand les électrons libres se déplacent — que ce soit dans le vide ou dans un métal, ils produisent un courant de charges net, que l'on appelle courant électrique, qui engendre un champ magnétique. De même, un courant peut être engendré par un champ électrique, éventuellement provoqué par un champ magnétique variable (induction électromagnétique). Ces interactions sont décrites mathématiquement par les équations de Maxwell[189].

À une température donnée, chaque matériau a une conductivité électrique qui détermine la valeur du courant électrique quand un potentiel électrique est appliqué. Des exemples de bons conducteurs comprennent des métaux comme le cuivre et l'or, tandis que le verre et le Teflon sont de mauvais conducteurs (ce sont des isolants). Dans tout matériau diélectrique, les électrons restent liés à leurs atomes respectifs, et le matériau se comporte comme un isolant électrique. La plupart des semi-conducteurs ont un degré de conductivité variable entre les extrêmes du conducteur et de l'isolant[190]. Par ailleurs, les métaux ont une structure en bandes électroniques dont certaines ne sont que partiellement remplies. La présence de ce type de bandes permet aux électrons de se comporter comme s'ils étaient libres ou délocalisés. Quand un champ électrique est appliqué, ils peuvent se déplacer comme les molécules d'un gaz (appelé « gaz de Fermi »)[191] à travers la matière, un peu comme des électrons libres. Ces phénomènes sont à la base de toute l'électricité : électrocinétique, électronique et radioélectricité.

En raison des collisions entre électrons et atomes, la vitesse de dérive des électrons dans un conducteur est de l'ordre du mm/s. Cependant la vitesse à laquelle un changement de courant en un point de la matière se répercute sur les courants en d'autres points, la célérité, est typiquement 75 % de la vitesse de la lumière dans le vide[192]. Ceci se produit parce que les signaux électriques se propagent comme une onde, avec une vitesse qui ne dépend que de la constante diélectrique, ou permittivité[193], du milieu.

Les métaux sont de relativement bons conducteurs de la chaleur, avant tout parce que les électrons délocalisés peuvent transporter de l'énergie thermique d'un atome à l'autre. Cependant, contrairement à la conductivité électrique, la conductivité thermique d'un métal est pratiquement indépendante de la température. Ceci s'exprime mathématiquement par la loi de Wiedemann et Franz[191], qui dit que le rapport de la conductivité thermique à la conductivité électrique est proportionnel à la température. Comme le désordre thermique du réseau du métal accroît la résistivité du milieu, cela conduit le courant électrique à dépendre de la température[194]. Dans les matériaux conducteurs, les électrons entrent en collision entre eux à un certain taux. Ces collisions expliquent la résistance électrique et les pertes d'énergie. Dans les métaux dits étranges, le nombre de collisions est nettement plus grand que celui des matériaux conducteurs. Lorsque soumis à une très basse température, un matériau constitué d'un cuprate perd toute résistance électrique. S'il est de plus soumis à une champ magnétique très grand, le taux de collisions des électrons ne peut pas excéder une certaine limite, qui semble indépendante du type de matériau[195],[196].

Quand on les refroidit en dessous d'une température critique, les substances peuvent subir une transition de phase qui leur fait perdre toute résistivité au courant électrique, phénomène appelé « supraconductivité ». Dans la théorie BCS, ce comportement est expliqué par des paires d'électrons (formant des bosons) qui entrent dans l'état connu sous le nom de « condensat de Bose-Einstein ». Ces paires de Cooper voient leur mouvement couplé à la matière environnante par des vibrations du réseau nommées « phonons », évitant ainsi les collisions avec les atomes responsables de la résistance électrique[197],[198],[199],[200].

Dans les conducteurs solides, les électrons sont des quasi-particules. Quand ils sont fortement confinés aux températures proches du zéro absolu, ils se comportent comme s'ils se décomposaient en deux autres quasi-particules, des spinons et des chargeons[201],[202]. La première transporte le spin et le moment magnétique ; la seconde, la charge électrique : c'est la séparation spin-charge.

L'incandescence, qui apparaît dans les matériaux chauffés[204], est provoquée par les changements d'orbitales des électrons dans l'atome. La luminescence est une émission de lumière qui survient à de relativement basses températures[205] et est aussi une conséquence des changements d'orbitales des électrons dans l'atome. Quand un électron est accéléré, il peut rayonner de l'énergie sous forme de photons[206],[207]. Ce rayonnement électromagnétique se manifeste sous la forme d'ondes radio, de micro-ondes, d'infrarouges, de lumière visible (perçue par l'œil humain[208]), d'ultraviolets, de rayons X ou de rayons gamma.

La diffusion optique, une interaction entre la lumière et les électrons, explique la réflexion optique[209]. La diffusion Rayleigh permet d'expliquer la couleur du ciel[210] et la couleur des plumes de certains oiseaux[211]. La réfraction des ondes électromagnétiques est aussi issue de l'interaction de la lumière et des électrons[212]. Ces phénomènes optiques sont aussi causés par l'interaction des photons avec d'autres particules chargées tel le proton[213]. La plupart des interactions des photons avec la matière se ramènent à trois phénomènes : effet photoélectrique, diffusion Compton et production de paires électron-positon (ou matérialisation)[214],[215]. Ils se manifestent la plupart du temps en présence d'électrons, car ce sont les particules chargées les moins lourdes[216],[217]. L’effet photovoltaïque est obtenu par absorption des photons dans un matériau semi-conducteur qui génère alors des paires électrons-trous (excitation d'un électron de la bande de valence vers la bande de conduction) créant une tension ou un courant électrique. Il est notamment utilisé dans les panneaux solaires photovoltaïques[218].

Selon la relativité restreinte d'Albert Einstein, quand la vitesse d'un électron se rapproche de la vitesse de la lumière, du point de vue d'un observateur, sa masse relativiste augmente, ce qui rend de plus en plus difficile de l'accélérer à partir du repère de l'observateur. Ainsi, la vitesse d'un électron peut s'approcher de la vitesse de la lumière dans le vide c, mais jamais l'atteindre. Si un électron relativiste, c'est-à-dire se déplaçant à une vitesse proche de c, est injecté dans un milieu diélectrique comme l'eau, où la vitesse de la lumière est significativement inférieure à c, il va se déplacer plus vite que la lumière dans le milieu. Le déplacement de sa charge dans le milieu va produire une légère lumière appelée « rayonnement Tcherenkov »[219],[220],[221] par effet Tcherenkov.

Les effets de la relativité restreinte sont basés sur une quantité appelée facteur de Lorentz[222], défini comme

où v est la vitesse de la particule. L'énergie cinétique d'un électron se déplaçant à la vitesse v est :

où est la masse de l'électron[223]. À titre d'exemple, l'accélérateur linéaire de SLAC peut accélérer un électron jusqu'à environ 51 GeV[224]. Puisque la masse de l'électron est de 0,51 MeV/c2, ceci donne une valeur d'environ 100 000 pour . Le moment relativiste d'un tel électron est donc 100 000 fois celui que la mécanique classique prédirait à un électron de cette vitesse[note 14].

Comme un électron se comporte également comme une onde, à une vitesse donnée, il a une longueur d'onde de De Broglie caractéristique donnée par

où h est la constante de Planck et p la quantité de mouvement[225],[76].

Les électrons sont détruits lors de la capture électronique qui survient dans les noyaux d'atomes radioactifs. En 1937, étudiant les réactions nucléaires dans le vanadium 49, le physicien américain Luis Walter Alvarez observe le premier des captures électroniques[227],[228].

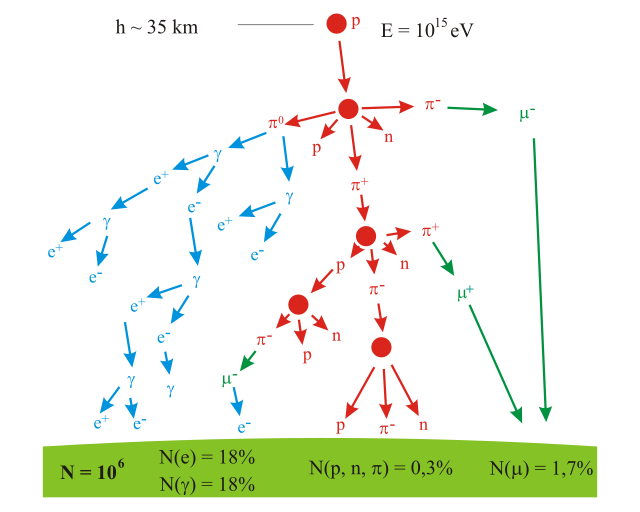

La plupart des électrons de l'Univers ont été créés lors du Big Bang[229],[230]. Ils peuvent être aussi produits par radioactivité β des noyaux radioactifs[231] et dans des collisions de haute énergie telles celles engendrées par la pénétration de rayons cosmiques dans l'atmosphère terrestre[232],[233]. Il existe trois processus de création d'électrons.

Le Big Bang est la théorie scientifique la plus largement acceptée pour expliquer les premiers stades de l'évolution de l'Univers[234], dont l'âge est estimé en 2011 à environ 13,75 milliards d'années[235]. Pendant la première milliseconde après le Big Bang, les températures atteignent 107 K, et les photons ont une énergie moyenne supérieure à 1 MeV. Ils ont donc des énergies suffisantes pour réagir ensemble et former des paires d'électron-positon :

où γ est un photon, e+ un positon et e− un électron. Inversement, des paires électron-positon s'annihilent pour émettre des photons énergétiques. Il y a donc pendant cette période un équilibre entre électrons, positons et photons. Au bout de 15 secondes, la température de l'Univers est descendue sous la valeur où la création de paires positon-électron peut avoir lieu. La plupart des électrons et des positons qui restent s'annihilent, relâchant des photons qui réchauffent l'univers pour un temps[236].

Pour des raisons encore inconnues de nos jours, pendant le processus de leptogénèse, il y a en fin de compte plus d'électrons que de positons[237]. Il en résulte qu'un électron sur environ un milliard a survécu au processus d'annihilation. Cet excès a compensé l'excès des protons sur les antiprotons, dans le processus appelé « baryogénèse », ce qui résulte en une charge nette nulle pour l'Univers[238],[239]. Les protons et neutrons qui ont survécu ont commencé à réagir ensemble, dans un processus appelé nucléosynthèse primordiale, formant des isotopes de l'hydrogène et de l'hélium, ainsi qu'un tout petit peu de lithium. Ce processus a culminé au bout de 5 minutes[240]. Tous les neutrons résiduels ont subi une désintégration β, avec une vie moyenne de mille secondes, relâchant un proton, un électron et un antineutrino, par le processus :

où n est un neutron, p un proton et un antineutrino électronique. Pour la période allant jusqu'à 300 000-400 000 ans, les électrons restants sont trop énergétiques pour se lier aux noyaux atomiques[241], et toute la lumière circulant dans l'Univers est constamment diffusée par ces électrons. Il suit une période que l'on appelle la « recombinaison », où les atomes neutres sont formés, et l'univers en expansion devient transparent au rayonnement[242].

Environ un million d'années après le Big Bang, la première génération d'étoiles commence à se former[242]. Dans une étoile, la nucléosynthèse stellaire aboutit à la production de positons par fusion de noyaux atomiques et désintégration β+ des noyaux ainsi produits, qui transforme l'excès de protons en neutrons. Les positons ainsi produits s'annihilent immédiatement avec les électrons, en produisant des rayons gamma. Le résultat net est une réduction constante du nombre d'électrons, et la conservation de la charge par un nombre égal de transformations de protons en neutrons. Cependant, le processus d'évolution stellaire peut aboutir à la synthèse de noyaux lourds instables, qui à leur tour peuvent subir des désintégrations β−, ce qui recrée de nouveaux électrons[243]. Un exemple en est le nucléide cobalt 60 (60Co), qui se désintègre en nickel 60 (60Ni)[244].

Au bout de sa vie, une étoile plus lourde que 20 masses solaires peut subir un effondrement gravitationnel pour former un trou noir[245]. Selon la physique classique, ces objets stellaires massifs exercent une attraction gravitationnelle suffisamment forte pour empêcher tout objet, y compris le rayonnement électromagnétique, de s'échapper du rayon de Schwarzschild[246]. Cependant des astrophysiciens pensent que les effets quantiques permettent au trou noir d'émettre un faible rayonnement de Hawking à cette distance et que des électrons (et des positons) sont créés à l'horizon des trous noirs[247].

Quand des paires de particules virtuelles — comme un électron et un positon — sont créées au voisinage de l'horizon, leur distribution spatiale aléatoire peut permettre à l'une d'entre elles d'apparaître à l'extérieur : ce processus est nommé effet tunnel quantique. Le potentiel gravitationnel du trou noir peut alors fournir l'énergie qui transforme cette particule virtuelle en une particule réelle, ce qui lui permet de se répandre dans l'espace[248]. En échange, l'autre membre de la paire reçoit une énergie négative, ce qui résulte en une perte nette de masse-énergie du trou noir. Le rythme du rayonnement de Hawking croît quand la masse décroît, ce qui finit par provoquer l'évaporation complète du trou noir[249].

Les rayons cosmiques sont des particules se déplaçant dans l'espace avec de très grandes énergies. Des événements avec des énergies jusqu'à 3 × 1020 eV ont été observés[250]. Quand ces particules rencontrent des nucléons dans l'atmosphère terrestre, elles engendrent une gerbe de particules, comprenant des pions[251]. Plus de la moitié du rayonnement cosmique observé au niveau du sol consiste en muons. Le muon est un lepton produit dans la haute atmosphère par la désintégration d'un pion[252]. À son tour, le muon va se désintégrer pour former un électron ou un positon. Donc, pour le pion négatif π−,

où est un muon et un neutrino muonique.

L'observation à distance des électrons exige la détection de l'énergie qu'ils rayonnent. Par exemple, dans des environnements riches en phénomènes énergétiques comme la couronne des étoiles, les électrons libres forment un plasma et transmettent de l'énergie par rayonnement continu de freinage. Le gaz d'électrons peut subir une onde de plasma, qui consiste en ondes provoquées par des variations synchronisées de la densité d'électrons, ce qui provoque des émissions d'énergie détectables avec des radiotélescopes[254].

Dans les conditions de laboratoire, les interactions d'un électron peuvent être observées au moyen de détecteurs de particules, ce qui permet la mesure des propriétés spécifiques telles que l'énergie, le spin ou la charge[174]. La mise au point des pièges de Paul et de Penning permet de contenir des particules chargées dans un petit volume pour de grandes durées. Ceci permet des mesures précises des propriétés des particules[255],[note 15].

Les premières images de la distribution en énergie d'un électron ont été réalisées par un groupe de l'université de Lund en Suède, en . Les scientifiques ont utilisé des impulsions très brèves de lumière (de 1 attoseconde, soit 10−18 s), qui ont permis pour la première fois d'observer le mouvement de l'électron[257],[258].

La distribution des électrons dans les solides peut être visualisée par spectrométrie photoélectronique UV analysée en angle. Cette technique utilise l'effet photoélectrique pour mesurer le réseau réciproque — représentation mathématique des structures périodiques utilisée pour déduire la structure originelle. L'ARPES peut être utilisée pour déterminer la direction, la vitesse et la diffusion des électrons au sein du solide[259].

Les propriétés de l'électron sont exploitées dans le microscope électronique[260], le tube cathodique[261], le soudage[262], l'effet laser[263], le capteur photographique[264] et l'accélérateur de particules[265].

D'autres expressions, tels « modèle de l'électron libre[276] » et « gaz d'électrons[277] », comprennent le mot « électron ».

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.