Cloud Computing

Bereitstellung digitaler Ressourcen über ein entferntes Rechenzentrum Aus Wikipedia, der freien Enzyklopädie

Cloud Computing (aus dem Englischen, für Rechnerwolke oder Datenwolke[1]) beschreibt ein Modell, das bei Bedarf – meistens über das Internet und geräteunabhängig – zeitnah und mit wenig Aufwand geteilte Computerressourcen als Dienstleistung, etwa in Form von Servern, Datenspeicher oder Applikationen, bereitstellt und nach Nutzung abrechnet. Angebot und Nutzung dieser Computerressourcen ist definiert und erfolgt in der Regel über eine Programmierschnittstelle (API) bzw. für Anwender über eine Website oder App.[2][3] Der Begriff Cloud Computing wird meistens als Cloud abgekürzt.

Das National Institute of Standards and Technology definiert fünf notwendige Merkmale für Cloud Computing:[2]

- On-demand self-service

- Der Nutzer kann Leistungen selbst und ohne menschliche Interaktion bei Bedarf bereitstellen lassen (Selbstbedienung).

- Broad network access

- Die Leistungen sind mit Standardmechanismen über das Netzwerk erreichbar, die eine Nutzung mit heterogenen Endgeräten wie Smartphones, Tablets, Notebooks oder Workstations fördern.

- Resource pooling

- Die Computerressourcen des Anbieters werden zusammengefasst, um mehrere Nutzer nach dem Mandantenprinzip bedarfsgerecht bedienen zu können. Damit einhergehend hat der Nutzer in der Regel keine Kontrolle darüber, mit welchen Computerressourcen die Leistung erbracht wird (z. B. auf welchem Server oder mit welcher Datenbank).

- Rapid elasticity

- Die Leistung kann dynamisch bereitgestellt und freigegeben werden, um bedarfsgerecht skalieren zu können. Aus Sicht des Nutzers scheinen die verfügbaren Computerressourcen unbegrenzt und Leistungen können jederzeit in beliebiger Höhe angepasst werden.

- Measured service

- Cloud-Systeme steuern und optimieren Computerressourcen abhängig von der jeweiligen Leistung anhand von messbaren Zahlen. Das können Speicher, Bandbreite oder aktive Benutzerkonten sein. Die Nutzung der Leistung kann überwacht, gesteuert und als Bericht bereitgestellt werden, um die Transparenz für den Nutzer wie auch den Anbieter zu gewährleisten.

Diese Definition ist heute weitgehend akzeptiert.[3][4][5] Cloud Computing geht damit über andere diskutierte Ansätze (z. B. Virtualisierung) hinaus. Unter der Bedingung einer öffentlichen Verfügbarkeit, ähnlich beispielsweise dem öffentlichen Telefonnetz, kann man Cloud Computing je nach Architektur auch als Summe von Software as a Service (SaaS) und Utility Computing ansehen.[6]

Servicemodelle

Zusammenfassung

Kontext

Cloud-Computing enthält vier verschiedene Servicemodelle:

Infrastructure as a Service (IaaS)

Clouds bieten Nutzungszugang von virtualisierten Computerhardware-Ressourcen wie Rechnern, Netzen und Speicher. Mit IaaS gestalten sich Nutzer frei ihre eigenen virtuellen Computer-Cluster und sind daher für die Auswahl, die Installation, den Betrieb und das Funktionieren ihrer Software selbst verantwortlich.

Platform as a Service (PaaS)

Clouds bieten Nutzungszugang von Programmierungs- oder Laufzeitumgebungen mit flexiblen, dynamisch anpassbaren Rechen- und Datenkapazitäten. Mit PaaS entwickeln Nutzer ihre eigenen Software-Anwendungen oder lassen diese hier ausführen, innerhalb einer Softwareumgebung, die vom Dienstanbieter (Service-Provider) bereitgestellt und unterhalten wird.

Software as a Service (SaaS)

Clouds bieten Nutzungszugang von Software-Sammlungen und Anwendungsprogrammen. SaaS-Diensteanbieter offerieren spezielle Auswahlen von Software, die auf ihrer Infrastruktur läuft. SaaS wird auch als Software on demand (Software bei Bedarf) bezeichnet.[7]

Function as a Service (FaaS)

Clouds bieten Nutzungszugang zu Funktionsinhalten. FaaS-Anbieter stellen immer wieder gebrauchte Funktionen auf eine einfache Weise zur Verfügung. Somit können beliebte Funktionen oder auch Funktionen mit hohen Rechenleistungen ausgelagert werden.

Liefermodelle

Zusammenfassung

Kontext

Zudem enthält die Definition des National Institute for Standards and Technology (NIST) vier Liefermodelle:[8]

Public Cloud – die öffentliche Rechnerwolke

Bietet Zugang zu abstrahierten IT-Infrastrukturen für die breite Öffentlichkeit über das Internet. Public-Cloud-Diensteanbieter vermieten IT-Infrastruktur an ihre Kunden. Die Bezahlung erfolgt entsprechend der tatsächlichen Nutzung (pay-as-you-go), ohne Kapital in Rechner- und Datenzentrumsinfrastruktur investieren zu müssen.

Private Cloud – die private Rechnerwolke

Eine Private Cloud ist eine Cloud-Umgebung, die ausschließlich für eine Organisation oder ein Unternehmen betrieben wird. Das Hosten und Verwalten der Cloud-Plattform kann intern (beispielsweise durch firmeneigene Rechenzentren), aber auch durch Dritte erfolgen. Die Cloud liegt in so einem Fall dann in einem externen Rechenzentrum.

Hybrid Cloud – die hybride Rechnerwolke

Bietet kombinierten Zugang zu abstrahierten IT-Infrastrukturen aus den Bereichen von Public Clouds und Private Clouds, nach den Bedürfnissen ihrer Nutzer.

Community Cloud – die gemeinschaftliche Rechnerwolke

Bietet Zugang zu abstrahierten IT-Infrastrukturen wie bei der Public Cloud – jedoch für einen kleineren Nutzerkreis, der sich, meist örtlich verteilt, die Kosten teilt (z. B. mehrere städtische Behörden, Universitäten, Betriebe oder Firmen mit ähnlichen Interessen, Forschungsgemeinschaften, Genossenschaften).

Weiterhin gibt es Mischformen der oben genannten Cloud-Typen:

Virtual Private Cloud – eine private Rechnerwolke auf prinzipiell öffentlich-zugänglichen IT-Infrastrukturen

Die Abschottung der „virtuell privaten“ Bereiche auf der öffentlichen Infrastruktur wird durch geeignete Sicherheitsmaßnahmen (VLANs) gewährleistet.[9]

Multicloud – Bündelung verschiedener Cloud-Computing-Dienste

Weiterentwicklung der Hybrid Cloud, bei der mehrere Cloud-Computing-Dienste in einer heterogenen Systemarchitektur gleichzeitig genutzt werden können.

Geschichte

Zusammenfassung

Kontext

Die Cloud ist eines der ältesten Sinnbilder der Informationstechnik und steht als solches für Rechnernetze, deren Inneres unbedeutend oder unbekannt ist.[10]

Bereits Anfang der 1990er Jahre prophezeiten einige Persönlichkeiten der IT-Branche, dass sich „Computer auf das Netz verteilen“ werden, sprich, dass Cloud Computing entstehen werde, sobald die Technik reif sei.[11] Die Zeit war Ende der 1990er Jahre mit der Entwicklung der Multitenant-Architektur gekommen.

1995 wurde von der GMD (heute Fraunhofer FIT) mit dem BSCW ein System vorgestellt, das heute als Cloud bezeichnet werden würde. Man konnte webbasiert Dokumente in Ordner hochladen und diese mit anderen teilen.[12] Seit 1996 wird BSCW durch das Fraunhofer-Spin-off OrbiTeam kommerziell angeboten.[13]

Als 2004 das soziale Netzwerk Facebook ins Leben gerufen wurde, gab man dessen Mitgliedern die Möglichkeit, Fotos, Videos etc. online zu speichern und zu veröffentlichen („posten“). Der Begriff Cloud-Computing wurde jedoch hauptsächlich durch einige schnell wachsende Internetfirmen wie Amazon, Google und Yahoo geprägt. Diese Firmen standen auf Grund des schnellen Wachstums ihrer Nutzerbasis vor dem Problem, ständig wachsende Systeme vorhalten zu müssen, die auch zu Spitzenlastzeiten (für Amazon wäre dies z. B. das Weihnachtsgeschäft) ausreichende Performance bereitstellen.[14]

Für Amazon war diese Spitzenlast im Jahr 2006 um den Faktor 10 höher als die Grundlast im Tagesgeschäft. Um diesem Problem zu begegnen, entschied man sich, die (serviceorientierte) Architektur und die Dienste, die man zum Bewältigen der zum Teil stark schwankenden oder auch sehr hohen Nutzerzahlen entworfen und etabliert hatte, zu einem Produkt zu machen, das man nach außen hin anbietet, d. h., dass dieses Problem in Spitzenlastzeiten auf die Nutzer der Cloud verteilt wird.

Für Amazon war dieser Schritt Anfang der 2000er Jahre eine logische Konsequenz, da man intern zu diesem Zeitpunkt schon auf kleine schnell bewegliche Teams (fast-moving „two-pizza teams“) umgeschwenkt hatte, die neue Funktionalitäten auf Basis der bestehenden Cloud-Infrastruktur implementierten. Die Skalierungseffekte der Cloud-Dienste wurden damit zur Basis des Produktes Cloud-Computing selbst, das man ab da nicht mehr nur intern, sondern auch extern anbot. Amazon ist heute weltweit der größte Anbieter von Cloud-Computing.[15]

Zwingende Voraussetzung für die Inanspruchnahme und Verbreitung von Cloud-Computing-Diensten sind so schnelle Breitbandverbindungen, dass es für die Benutzung keinen Unterschied mehr macht, ob Daten lokal auf einem PC oder auf entfernten Servern einer Cloud gespeichert sind. Mithin ist die zunehmende Relevanz des Cloud-Computing für Privatanwender an die Marktversorgung mit ebenso schnellen wie zuverlässigen und kostengünstigen DSL- und LTE-Verbindungen gekoppelt.

In der ersten Phase des Cloud Computings ging es vorwiegend um Kostenreduzierung, da zentrale Software von mehreren Unternehmen gleichzeitig über den Browser genutzt werden kann, ohne dass dabei irgendein Zugriff auf die Daten anderer möglich ist. Hinzu kamen eine deutlich stärkere Flexibilität sowie eine Abrechnung nach Nutzung. Inzwischen hat sich Cloud Computing als Plattform für Innovation, Produktivität und Business Value etabliert.

Heute stehen bei der Nutzung der Cloud höherwertige Anwendungen wie KI, Microservices/Container, Mobile, IoT, Basis-Infrastruktur, Analytics und Blockchain im Fokus. Der Cloud-Markt entwickelt sich weg von Infrastructure-as-a-Service-Anwendungen hin zur Multicloud und zu Hybrid-Cloud-Anwendungen, die laut IDC-Analysten in den nächsten Jahren 85 Prozent der Unternehmens-IT ersetzen werden. Auch wenn Private Clouds in Zukunft im Einsatz bleiben werden, ist davon auszugehen, dass für bestimmte Anwendungen hybride Umgebungen expandieren werden. Und das gilt umso mehr, als 80 Prozent der weltweiten Daten nicht analysierbar sind, weil sie auf internen Systemen und nicht im öffentlichen Bereich liegen. Das ist einer der wesentlichen Gründe, warum Cloud-Anbieter wie beispielsweise IBM, AWS, Microsoft oder Google auf verschiedene verteilte oder hybride Cloud-Ansätze[16] setzen, um Cloud-Dienste sowohl in der Public Cloud als auch im eigenen Data-Center gleichwertig anzubieten.

Abgrenzung von anderen Techniken

Bei „Grid-Computing“ geht es um die gemeinschaftliche Nutzung der gemeinsamen Ressourcen und es gibt keine zentrale Steuerung. Im Fall von Cloud-Computing hat man einen Anbieter der Ressourcen und einen Nutzer. Die Steuerung der Ressourcen ist zentralisiert.

Fog Computing stellt die dezentralisierte Erweiterung des Cloud-Computings dar. Ressourcen wie Speicher, Rechenleistung und Software-Anwendungen werden näher an den Endgeräten platziert, um durch eine optimierte Aufteilung eine bessere Effizienz und geringere Latenzzeiten zu erreichen. An die zentralen Systeme werden dann nur noch relevante und gegebenenfalls komprimierte Daten geleitet. Fog Computing steht in engem Zusammenhang mit Edge Computing, wo beispielsweise Sensordaten direkt im Sensorsystem aufbereitet werden, um sie dann an Fog und Cloud weiterzuleiten. Zwischen Fog und Edge Computing gibt es große Überschneidungen, weshalb sie teilweise synonym benutzt werden.

Architektur

Zusammenfassung

Kontext

Da Clouds primär durch den Skalierungsgedanken entstanden sind, finden sich dort auch die stärksten Unterscheidungsmerkmale.

Um sich der Architektur zu nähern, kann man sich einen einfachen Rechner vorstellen. Er hat Prozessorkerne, Arbeitsspeicher, eine Festplatte und Programme. Diese Komponenten finden sich auch in einer Cloud, nur in einer Form, die massive Skalierung ermöglicht.

Demzufolge lesen sich die Kenndaten einer „Cloud-Festplatte“ dann auch anders als die einer klassischen Festplatte im Computer. Amazon sagt über seine Persistenzschicht (S3): „Die Anzahl der speicherbaren Objekte ist unbegrenzt.“[17] Google hat seine Persistenzschicht Google File System auf etwa 15.000 einzelne Rechner verteilt (Stand 2009).[18]

Für die anderen Komponenten wie Programme oder Prozessorkerne gelten ähnliche große Maße. Warum dies so ist, erklärt sich allein durch die Zahlen. Im Jahr 2008 gibt Google bekannt, 10 Milliarden Datensätze, die über 1000 physische Computer verteilt sind, innerhalb von 68 Sekunden sortieren zu können.

“We are excited to announce we were able to sort 1 TB (stored on the Google File System as 10 billion 100-byte records in uncompressed text files) on 1,000 computers in 68 seconds.”

„Wir freuen uns, bekanntzugeben, dass wir in der Lage waren, 1 TB (gespeichert im Google File System in 10 Milliarden Dokumenten mit je 100 Bytes Datensatzgröße in unkomprimierten Textdateien), verteilt auf 1000 Computer, innerhalb von 68 Sekunden zu sortieren.“[19]

Technische Realisierungen von Cloud-Computing

Zusammenfassung

Kontext

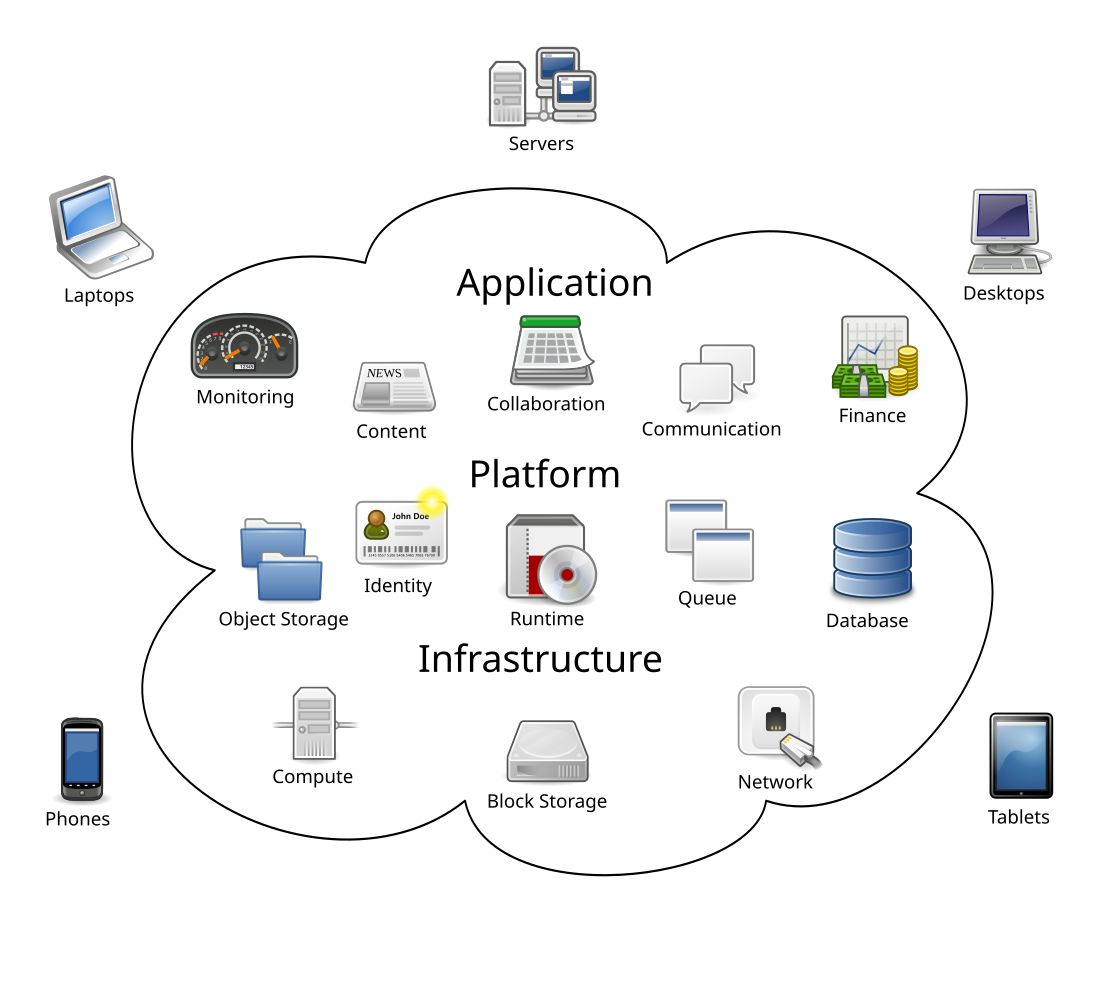

Es gibt unterschiedliche Arten von Cloud-Computing. Eine mögliche Gliederung ist der sogenannte technische Cloud-Stack mit drei Schichten, in der obere Schichten auf den unteren Schichten aufbauen können, es aber nicht müssen:[20]

- Anwendung

- Plattform

- Infrastruktur

Jede Schicht stellt hier einen Grad an Abstraktion dar. Auf diese Art können auch die unterschiedlichen Typen von „Clouds“ klassifiziert werden.

Anwendung (SaaS)

Die Anwendungsschicht stellt die abstrakteste Schicht auf Cloud-Dienste dar. Hierbei bringt der Benutzer seine Applikation weder in eine Cloud-Plattform ein, noch muss er sich um Skalierbarkeit oder Datenhaltung kümmern. Er nutzt eine bestehende Applikation, die ihm die Cloud nach außen hin anbietet. Dieser Anwendungsfall inkludiert die beiden darunterliegenden Ebenen, da die Cloud-Funktionalitäten wie hochskalierender, verteilter Speicher, ausfallsichere Infrastruktur und üblicherweise ein hochskalierendes Queuingsystem zwar die Grundlage der benutzten Anwendung sind, der Nutzer des SaaS-Dienstes damit allerdings nicht in Kontakt kommt.

Eine „Cloud-Anwendung“ im SaaS-Modell berücksichtigt typischerweise die folgenden Aspekte:

- Das Design soll modular und serviceorientiert sein (Aufsetzbarkeit auf dem PaaS-Szenario).

- Die Last ist nicht vorhersehbar, denn über Nutzungsintensität und Nutzerzahl einer Anwendung kann oft keine zuverlässige Aussage gemacht werden.

- Die Anwendung soll dynamisch, verteilt und mandantenfähig sein.

Bekannte Beispiele für Cloud-Anwendungen sind Apple iCloud, Google Drive, Microsoft OneDrive, ownCloud, Nextcloud oder Salesforce.com.

Plattform (PaaS)

Ein Entwickler erstellt eine Anwendung und lädt diese in eine Cloud-Plattform. Diese kümmert sich dann selbst um die Aufteilung auf die eigentlichen Verarbeitungseinheiten. Im Unterschied zu IaaS hat der Benutzer hier keinen direkten Zugriff auf die Recheninstanzen. Er betreibt auch keine virtuellen Server. Im PaaS-Szenario bringt er ausschließlich seine Programmlogik in die Cloud-Plattform ein, die ihm gegenüber als Programmierschnittstelle auftritt.

Die Infrastruktur der Cloud selbst kümmert sich hierbei um die erforderliche Instanziierung der Verarbeitungseinheiten und das Verteilen der zu verarbeitenden Daten.

Als Beispiel können hier die Produkte Windows Azure von Microsoft, „App Engine“ von Google oder „force.com“ von Salesforce.com der Plattform-Schicht zugeordnet werden.

Dadurch, dass der Benutzer hier nur seine Applikationslogik liefert, kann die Cloud-Plattform die Anzahl der tatsächlich arbeitenden Instanzen nach Belieben erhöhen oder reduzieren. Die Abstraktion von jeglicher technischen Komponente ist hierbei explizit gewünscht, da der Benutzer der Cloud in erster Linie Daten verarbeiten, nicht aber das System administrieren möchte.

Infrastruktur (IaaS)

Die Infrastruktur oder „Cloud-Foundation“ stellt die unterste Schicht im Cloud-Computing dar. Der Benutzer greift hier auf bestehende Dienste innerhalb des Systems zu, verwaltet seine Recheninstanzen (siehe virtueller Server) allerdings weitestgehend selbst. Dienste innerhalb des IaaS-Konzeptes sind typischerweise verteilte Persistenz (siehe Amazons Simple Storage Service) und ein Nachrichtendienst (siehe Message Oriented Middleware). Sind die Cloud-Dienste selbst noch hochskalierend ausgelegt, trifft dies nicht zwingend auf die Programme zu, die auf den vom Benutzer eingebrachten Recheninstanzen laufen.

Der Vorteil gegenüber traditionellen Datencentern ist die Skalierbarkeit: Die Recheninstanzen können je nach Anforderungen beliebig um weitere Instanzen erweitert oder verkleinert werden. Der Benutzer hat dabei vollen Zugriff auf die Instanzen mit der Eigenschaft, dass er für die Instanzen ab der Betriebssystemebene selbst verantwortlich ist.

Die größten Beispiele hierfür sind Microsoft Azure, Amazon Web Services und die Open Telekom Cloud.

Organisatorische Arten von Clouds

Zusammenfassung

Kontext

Man kann neben dem technischen Cloudstack auch zwischen verschiedenen Organisationsformen von „Clouds“ unterscheiden, die je nach Anwendungsfall ihre Berechtigung haben. Die Definitionen für die Begriffe „private“, „public“ usw. wurden vom NIST geprägt, werden in gleicher Art von den Wirtschaftsprüfern verwendet (führend hierzu sei für die Definition der Standards die ISACA angeführt) und sind seit 2014 auch in ISO/IEC 17788 verfügbar. Die Definitionen durch diese Gremien sind von hohem Erkenntniswert, da hier die korrekten Definitionen der Models international gültig festgelegt sind.

Zusammenfassend lässt sich sagen, dass die Definitionen sich auf den möglichen Nutzerkreis beziehen und nichts damit zu tun haben, wo „die Cloud“ betrieben wird oder wie Eigentumsverhältnisse aussehen. Unter „Private Cloud“ ist demnach eine Cloud zu verstehen, bei der die Ressourcen durch einen vordefinierten Benutzerkreis angesprochen wird und wo die Verwaltung durch ausgezeichnete User erfolgt. Am anderen Ende der Skala ist dann die „Public Cloud“ zu finden, bei der a priori keinerlei Information über die möglichen Nutzer vorhanden ist. Mischformen dazwischen sind möglich (z. B. „Hybrid Cloud“), beziehen sich aber ebenfalls auf den Nutzerkreis und nicht auf die technische Ausgestaltung.

Die Begrifflichkeiten, wie sie teilweise gemeinhin anzutreffen sind, und im Rahmen deren Verwendung „Public Cloud“ mit „off premises“ und „Private Cloud“ mit „on premises“ gleichgesetzt werden, sind irreführend und entsprechen in dieser Verwendung weder der Grundidee der ISO/IEC Normen noch der anderer Gremien.

Cloud-Computing in der Wirtschaft

Zusammenfassung

Kontext

Cloud-Computing verlagert die Investition für Anwendungsprogramme auf den Anbieter der Dienste und eine der tatsächlichen Leistung entsprechende Gebühr. Das erlaubt es, schwerfällige Entscheidungsprozesse in dem Unternehmen des Bestellers der Dienste abzulösen. Im Jahr 2019 nutzen drei von vier Unternehmen in Deutschland Rechenleistungen aus der Cloud.[21] Der Anteil ist weiter gestiegen und lag 2021 bei 82 Prozent und stieg im Jahr 2022 auf 84 Prozent.[22] Der Markt für Cloud Computing wächst. Die weltweiten Ausgaben für Public Cloud-Dienste stiegen 2021 laut einem Marktforschungsinstitut auf 412 Mrd. US-Dollar. Für 2022 werden 490 Mrd. US-Dollar prognostiziert und bis 2023 wird ein weiterer Anstieg um mehr als 20 % auf über 591 Mrd. US-Dollar erwartet.[23]

Potenziale und Vorteile

Wie die Virtualisierung ermöglicht Cloud-Computing Kostenvorteile[24] gegenüber konventionellen Systemen, wenn sich beispielsweise die Bezahlung nach der Dauer der Nutzung des Dienstes richtet und der Dienst nur gelegentlich genutzt wird. Lokale Ressourcen (Software und Hardware) lassen sich einsparen. Ein vielzitiertes Beispiel ist die Realisierung von E-Mail-Systemen auf Basis von Cloud-Computing. Hier nimmt die Komplexität der Anwendung durch Maßnahmen zur Unterbindung von Kompromittierungsversuchen zu, so dass kleineren Unternehmen eine Auslagerung nutzen können. Vorteile ergeben sich auch bei stark schwankender Nachfrage: An sich müsste man genug Kapazität für Lastspitzen vorhalten. Durch Cloud-Computing kann die genutzte Kapazität am Bedarf kurzfristig angepasst werden. Laut einer Studie des Fraunhofer-Instituts für Materialfluss und Logistik IML ist eine Kostenhalbierung im Bereich Warehouse Management machbar.[25]

Risiken und Nachteile

Die Migration in die Cloud geht für Unternehmen häufig mit Sicherheitsbedenken einher.[26] Ein Problem ist die Absicherung des Zugriffs auf Anwendungsdaten beim Transfer zwischen lokalem Client und entferntem Server. Eine Entschärfung des Problems brachten Teilfortschritte im Bereich der SSL/TLS-Verschlüsselung mit sich. Risiken durch über Jahrzehnte bestehende CPU-Designfehler oder den künftigen Quantencomputer-Einsatz bestehen dagegen weiterhin.

Ein weiteres Problem ist die Verschlüsselung der Daten in Datenbanken und Datei-Systemen der Cloud. Ein drittes Risiko liegt in unautorisierten Zugriffen von Seiten des Cloud-Anbieters während der Verarbeitung. Dieses bedarf einer verteilten Authentisierung und Autorisierung.

Kritiker behaupten, dass die Kontrolle privater Anwenderdaten durch marktdominante Anbieter wie Google überhandnähme.[27] Allerdings gibt es Algorithmen, die Berechnungen so auf Instanzen aufteilen, dass es selbst allen Instanzen gemeinsam nicht möglich ist, Rückschlüsse auf die verarbeiteten Daten zu ziehen.[28] Dies ist lediglich der ausführenden Instanz möglich, da nur sie den Algorithmus kennt, der Teilergebnisse zusammenführt. Ein bisher nur experimenteller Ansatz zur Behebung des Problems ist eine homomorphe Verschlüsselung. Dabei wird in der Cloud nur auf verschlüsselten Daten gerechnet, die im privaten Bereich entschlüsselt werden können.

Ein alternativer Ansatz ist das Konzept der Sealed Cloud. Dabei trennt die Schlüsselverwaltung die Verschlüsselung von der Entschlüsselung durch jeweils eigene Schlüssel. Es erfolgt eine geordnete Sicherung und anschließende Löschung unverschlüsselter Daten, bevor ein Administrator, beispielsweise zu Wartungszwecken, Zugriff zum Speicher erhält.

Eine weitere Herausforderung besteht in der Abhängigkeit (Lock-in-Effekt) vom Cloud-Anbieter, da die Schnittstellen zur Cloud oft herstellerspezifisch sind. Zudem besteht die Frage, was mit Anwenderdaten bei der Insolvenz des Cloudbetreibers oder eines der vielen beteiligten Dienste-Anbieter passiert.[29] Daher bieten einige Anbieter eine Datenrücksicherung auf eigenen Speichern an.[30]

Ungeachtet technischer Risiken bringt Cloud Computing schwer absehbare juristische Risiken mit sich. So führte Adobe 2013 ein Abonnement-Modell ein, was zu deutlich höheren Umsätzen und Preisen führte. Dolby Laboratories Inc. befindet sich seit 2018 in einem Rechtsstreit um Lizenzkosten für das Cloud-basierte Abonnement-Modell.[31] Adobe verbot Mietern der Lightroom-Classic-, Photoshop-, Premiere-, Animate- und Media-Director-Programme deren Verwendung aufgrund eines Rechtsstreites mit einem Lizenzpartner mit den Worten: „Vor kurzem haben wir einige ältere Versionen von Creative-Cloud-Anwendungen eingestellt. Aufgrund unserer Vereinbarung haben Sie keine Lizenz mehr für deren Verwendung. Bitte beachten Sie, dass bei der weiteren Verwendung der abgekündigten Version(en) das Risiko besteht, dass Dritte möglicherweise Verstöße geltend machen.“

Anwender sind kurzfristigen Änderungen der Endbenutzer-Lizenzvereinbarungen (EULAs) durch Lizenzgeber schutzlos ausgeliefert. Lizenzgeber wie auch Cloudbetreiber können bislang bestehende Zugangsberechtigungen jederzeit rechtlich als auch physisch beenden oder einen Nachkauf fordern. Diese Abhängigkeit bestand vor Einführung des Cloud Computings nicht.

Energie

Schätzungen zufolge fällt 1 % des weltweiten Stromverbrauchs für Cloud-Computing an.[32]

Eine Studie von Bitkom schätzte den Strombedarf von Rechenzentren und kleinerer IT-Installationen in Deutschland im Jahr 2020 auf 16 Terawattstunden.[33] Die entstehende Abwärme wird selten genutzt; einer Studie zufolge eignen sich viele der bestehenden Fernwärmenetze nicht zur Nutzung von Wärme auf entsprechend niedrigem Temperaturniveau.[34] Der Koalitionsvertrag für die 20. Legislaturperiode sieht eine Nutzung der Abwärme von Rechenzentren und eine Klimaneutralität neuer Rechenzentren ab 2027 vor.[35]

Das 2011 gegründete Dresdner Unternehmen Cloud & Heat vermarktet in Deutschland und international wassergekühlte Server und die Nutzung der Abwärme für Heizung und Warmwasser.[36][37]

Kosten

Die Cloud zeichnet sich durch ein nutzenbasiertes Pay-Per-Use-Kostenmodell aus. In diesem Kontext hat sich auch die Disziplin des Cloud-Kostenmanagements entwickelt.[38]

Es gibt verschiedene Untersuchungen über die Kosten von Cloud-Computing. Nach einer Untersuchung von Dachyuk (2018) ist Colocationing ab etwa 150 großen AWS-Instanzen (m4.2xlarge) günstiger als Cloud-Computing.[39]

Im Allgemeinen können durch die Nutzung von Public Cloud Services vor allem Fixkosten im Vergleich zu On-Premise-Lösung variabilisiert und Sprungfixe Kosten vermieden werden.[40][41]

Ersatzlösungen

Da manche Privatanwender Bedenken haben, ihre Daten bei Unternehmen zu speichern, die beispielsweise ihre Geschäftsbedingungen jederzeit ändern könnten, stellen viele NAS-Systeme für zu Hause Funktionen bereit, wie man sie von Cloud-Speicher-Betreibern kennt. In diesem Fall spricht man von einer Personal Cloud, da die Infrastruktur der Datenspeicherung vollständig vom Anwender selbst betrieben wird. NAS-Lösungen übernehmen jedoch kein Verarbeiten von Daten.

Abgrenzung von anderen Dienstleistungsformen

Cloud-Computing ist in einigen Elementen mit dem klassischen Online Outsourcing verwandt. Es grenzt sich jedoch in wesentlichen Punkten von diesem ab. In der Regel wird im Bereich der Infrastructure as a Service-Anbieter die IT-Infrastruktur von mehreren Kunden genutzt, sodass Kapazitätsspitzen leichter verteilt werden können und Reserven gemeinsam genutzt werden. So können Cloud-Dienstleistungen kurzfristig angepasst werden und unterscheiden sich dadurch vom klassischen Modell, in dem Kunden Rechnerinfrastruktur „exklusiv“ nutzen. Weiterhin erfolgt die Steuerung und Administration der Dienste durch den Nutzer via Webinterface selbst.

Rechtliche Fragen

Zusammenfassung

Kontext

Rechtlich müssen sowohl die Beziehungen zwischen Cloud-Anbietern und ihren Kunden als auch die Rechte betroffener Dritter betrachtet werden.

Datensicherheit

Es ist zu berücksichtigen, dass der gesetzlich geforderte Datenschutz grundsätzlich ohne technische Datensicherheit nicht erreicht werden kann. Die Datensicherheit wird durch die verwendete Technik des Anbieters und durch die verwendeten Anwendungen des Anbieters bestimmt. Grundsätzlich bietet ein internes IT-System eine höhere Sicherheit. Ein Cloudsystem gilt dennoch nicht als unsicher.[42]

Datenschutz

Nach Urteil des Europäischen Gerichtshofs dürfen nur eingeschränkt Daten in die USA gelangen, wo sich über 90 % der Cloud-Computing-Infrastruktur befinden.[43] Nationale Datenschutzagenturen stützen sich auf Arbeiten der ENISA, wenn sie darlegen, warum Cloud-Computing trotz Safe Harbor beispielsweise für Schulen unzulässig ist.[44] Auch die Datenschutzbeauftragten der Schweiz warnen insbesondere vor Verletzung des Datenschutzrechts bei Verwendung von Rechenzentren im Ausland.[45]

Wenn personenbezogene Daten Dritter online gespeichert werden, müssen sich beispielsweise deutsche Auftraggeber vorab und anschließend regelmäßig nachvollziehbar vor Ort davon überzeugen, dass die Vorgaben des Bundesdatenschutzgesetzes eingehalten werden.[46] Weil namhafte Cloud-Anbieter Datenbestände ihrer Kunden weitergeben, drohen den Kunden Bußgelder.[47] Cloud-Betreiber mit Sitz in den USA unterliegen dem US-Recht und demnach dem Patriot Act. Unternehmen mit Sitz in den USA sind deshalb gezwungen, auch Daten an amerikanische Behörden auszuliefern, die sich auf Servern in fremdem Hoheitsbereich befinden. Dies ist beispielsweise von Amazon, Microsoft und Google bestätigt worden.[48]

Nicht zuletzt wegen dieser Problemlagen im Datenschutz sowie in der Frage, inwieweit der Einzelne die Verfügungsgewalt über seine Daten tatsächlich behält, erhielt die Cloud bzw. Cloud-Computing als Technik 2012 den Negativpreis Big Brother Award in der Kategorie „Kommunikation“, die Laudatio hielt Rena Tangens vom FoeBuD.[49]

Leistungsschuld

Bei den Cloud-spezifischen Leistungen werden in der Regel Web- oder Filespace, Datenbanken, Applikationen und Hostingservices zur Verfügung gestellt. Beim Webhosting (ggf. auch für das Storage-Management), bei dem Daten auf den Host des Hosting-Providers gespeichert werden, wird vertreten, dass es sich hierbei nicht um einen Mietvertrag nach §§ 535 ff. BGB handelt, sondern um einen Werkvertrag nach §§ 631 ff. BGB. Der Hosting-Provider schuldet als Leistung lediglich, dass die Website des Kunden bei ihm irgendwo gespeichert wird und dass sie im Internet aufgerufen werden kann. Eigentliche Leistung ist daher die Aufbewahrung der Information und ihr Zurverfügunghalten für den Abruf im Internet. Für den Kunden ist vor allem wichtig, dass die Inhalte dauernd abrufbar sind. Wie der Hosting-Provider oder Cloudanbieter diese Leistung erbringt, ist dem Kunden gleichgültig. Damit wird nicht primär Speicherplatz überlassen, sondern primär ein Erfolg, nämlich die Abrufbarkeit im Internet geschuldet. Das Einspeichern der Website ist nur technische Voraussetzung des geschuldeten Erfolgs.

Bei der Zurverfügungstellung von Applikationen wird in der Regel ein Software-as-a-Service- (SaaS) oder „Application-Service-Providing“-Modell (ASP) gewählt. Hierbei wird vom ASP-Anbieter einem Kunden die temporäre Nutzung von Applikationen zur Verfügung gestellt. Der Bundesgerichtshof hat entschieden,[50] dass auf Application-Service-Providing-Verträge grundsätzlich die mietrechtlichen Vorschriften Anwendung finden. Auch wenn diese Entscheidung sicherlich bedeutsam gewesen ist, bedarf es doch einer erheblichen vertraglichen Gestaltung, insbesondere bei der Gestaltung der Service-Levels, da hier die mietrechtlichen Regelungen des §§ 535 ff. BGB allein nicht ausreichend sein dürften.

Die Einordnung von Hosting-Verträgen für Datenbanken in die vertragstypologische Einordnung des BGB richtet sich nach der vertraglich geschuldeten Leistung. Hierbei ist grundsätzlich zu unterscheiden, ob wie weiter oben beschrieben Filespace zur Speicherung der Datenbank vom Provider zur Verfügung gestellt wird (sogenanntes Datenbank-Hosting) oder eine Applikation wie eine Oracle-Datenbank (zur zeitweiligen Nutzung) zur Verfügung gestellt wird. Schuldet der Cloud-IT-Anbieter über die Hosting-Leistung hinaus Leistungen, wie z. B. bei der Gestaltung der Datenbanken, sind ggf. die Regelungen von §§ 87a bis 87e UrhG zu berücksichtigen.

Urheberrecht

Zu beachten sind auch urheberrechtliche Fragestellungen, wenn urheberrechtlich geschützte Daten online gespeichert werden. Der Upload von Daten stellt rechtlich gesehen nichts anderes als eine Vervielfältigung gem. § 16 UrhG dar, die der Zustimmung des Urhebers bedarf. Nur wenn der Upload zu rein privaten Zwecken geschieht und die Datei nicht öffentlich zugänglich gemacht wird, kann der Upload als Privatkopie gem. § 53 UrhG zulässig sein. Die öffentliche Zugänglichmachung von Dateien der Cloud (§ 19a UrhG) ist jedoch ohne Zustimmung des Urhebers immer rechtswidrig.

Hinzu kommt, dass nach Marcel Bisges durch Cloud-Computing das derzeitige System der Urhebervergütung ausgehebelt werden kann, indem dem Urheber der Anspruch auf angemessene Vergütung (für Privatkopien) vermindert wird.[51] Aus urheberrechtlicher Sicht ist Cloudcomputing andererseits, so Bisges, für die Hersteller von Software von Vorteil, da im Gegensatz zu herkömmlicher Softwareüberlassung die Schäden durch illegale Kopien vermieden werden.[52]

Konferenzen

Inzwischen gibt es auch eine Reihe an Cloud-Konferenzen sowohl in Deutschland als auch international. Innerhalb Deutschland sind dies die CCX[53], die Cloud-Tage des Magazins Informatik Aktuell[54] sowie die Cloud Expo Europe[55]. International gibt es die IEEE Cloud Conference[56], die International Conference on Cloud Computing[57] und die Cloudfest[58].

Liste an Clouds

Mit Stand 2024 sehen die Marktanteile der drei größten Cloud-Computing-Anbieter wie folgt aus: Amazon Web Services (31 %), Microsoft Azure (25 %) und Google Cloud Platform (10 %).[59] Weitere Cloud-Computing-Anbieter sind OpenStack, Oracle Cloud und IBM Cloud.

Literatur

- Christian Metzger, Juan Villar: Cloud-Computing. Chancen und Risiken aus technischer und unternehmerischer Sicht. Hanser, München 2011, ISBN 978-3-446-42454-8.

- Alexander Bell: Mobile- und Cloud-Computing. Mobile- und Cloud-Computing – unter Betrachtung der Unternehmen Google, Amazon und SAP AG. München 2012, ISBN 978-87-403-0264-6. Download Free eBook

- Wolfgang Tichy, Günther Leissler, Michael Woller: Cloud Computing. Wien: Manz 2019. (Reihe Systematische Werke.), ISBN 978-3-214-08972-6.

- Roland Frank, Gregor Schumacher, Andreas Tamm: Cloud-Transformation. Wie die Public Cloud Unternehmen verändert. Berlin: Springer 2019, ISBN 978-3-658-27324-8.

Weblinks

Commons: Cloud Computing – Sammlung von Bildern, Videos und Audiodateien

- Alexander Weisser: International Taxation of Cloud Computing, 1. Oktober 2020, abgerufen am 7. Februar 2022.

- Cloud Computing. In: Informatik Aktuell. 1. Februar 2019, abgerufen am 7. März 2019.

- Sebastian Minnich: Die Vorteile und Nachteile des Cloud-Computing. Heise Online, 11. Mai 2017, abgerufen am 7. März 2019.

- Aktueller Begriff: Cloud Computing. (PDF; 64 kB) Deutscher Bundestag, Wissenschaftliche Dienste Nummer 15/10, 12. März 2010, abgerufen am 7. März 2019 (2 Seiten).

- Cloud-Dienste für private Anwender. Stiftung Warentest, 24. April 2012, abgerufen am 7. März 2019.

- Cloud Computing Risk Assessment (including recommendations). (PDF; 2 MB) Europäische Agentur für Netz- und Informationssicherheit (ENISA), 7. März 2009, abgerufen am 7. März 2019 (englisch, 125 Seiten).

- Cloud Computing – Leitfaden. (PDF; 4 MB) Bitkom, abgerufen am 7. März 2019 (87 Seiten).

- Guidelines on Security and Privacy in Public Cloud Computing. (PDF; 1 MB) NIST Special Publication 800-144, abgerufen am 7. März 2019 (englisch, 80 Seiten).

- The European Commission has proposed a comprehensive reform of the EU’s 1995 data protection rules to strengthen online privacy rights and boost Europe’s digital economy., (englisch). hostingtecnews.com, abgerufen am 7. März 2019.

- Cloud Computing (Podcast). cre.fm, abgerufen am 7. März 2019.

- Cloud Computing als Instrument für effiziente IT-Lösungen (PDF; 953 kB). (PDF) Abgerufen am 7. März 2019.

Einzelnachweise

Wikiwand - on

Seamless Wikipedia browsing. On steroids.