Loading AI tools

application permettant la recherche d'information De Wikipédia, l'encyclopédie libre

Un moteur de recherche est une application permettant à un utilisateur d'effectuer une recherche locale ou en ligne, c'est-à-dire de trouver des ressources à partir d'une requête composée de termes. Les ressources peuvent notamment être des pages web, des articles de forums Usenet, des images, des vidéos, des fichiers, des ouvrages, des sites, pédagogiques, des applications, des logiciels open source.

Sur le principe, ils fonctionnent généralement :

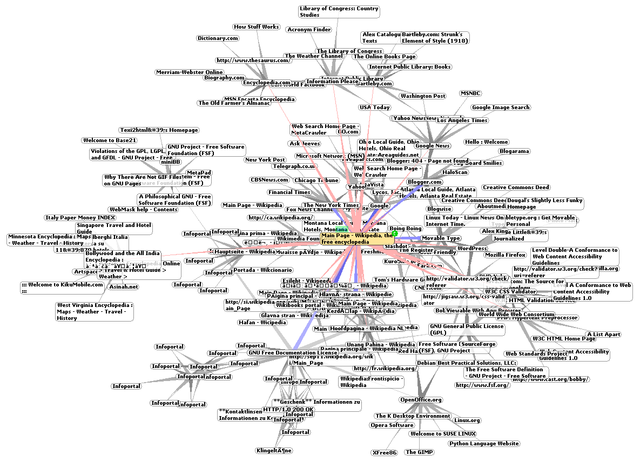

Certains sites web offrent un moteur de recherche comme principale fonctionnalité ; on appelle alors « moteur de recherche » le site lui-même. Ce sont des recherches sur le web sans intervention humaine, ce qui les distingue des annuaires. Ils sont basés sur des « robots », encore appelés « bots », « spiders «, « crawlers » ou « agents », qui parcourent automatiquement les sites à intervalles réguliers afin de découvrir de nouvelles adresses (URL). Ils suivent les liens hypertexte qui relient les pages les unes aux autres, les uns après les autres. Chaque page identifiée est alors indexée dans une base de données, accessible ensuite par les internautes à partir de mots-clés.

C'est par abus de langage qu'on appelle également « moteurs de recherche » des sites web proposant des annuaires de sites web : dans ce cas, ce sont des instruments de recherche élaborés par des personnes qui répertorient et classifient des sites web jugés dignes d'intérêt, et non des robots d'indexation.

Les moteurs de recherche ne s'appliquent pas uniquement à Internet : certains moteurs sont des logiciels installés sur un ordinateur personnel. Ce sont des moteurs dits « de bureau » qui combinent la recherche parmi les fichiers stockés sur le PC et la recherche parmi les sites Web — on peut citer par exemple Copernic Desktop Search, Windex Server, etc.

On trouve également des métamoteurs, c'est-à-dire des sites web où une même recherche est lancée simultanément sur plusieurs moteurs de recherche, les résultats étant ensuite fusionnés pour être présentés à l'internaute.

Les moteurs de recherche Internet précèdent les débuts du Web à la fin des années 1990 :

Les moteurs de recherche sont inspirés des outils de recherche documentaire (à base de fichiers inversés, alias fichiers d'index) utilisés sur les mainframes depuis les années 1970, comme le logiciel STAIRS sur IBM. Le mode de remplissage de leurs bases de données est cependant différent, car orienté réseau. Par ailleurs la distinction entre données formatées (« Champs ») et texte libre n'y existe plus, bien que commençant depuis 2010 à se réintroduire par le biais du web sémantique.

Des moteurs historiques ont été Yahoo! (1994), Lycos (1994), AltaVista (1995, premier moteur 64 bits) et Backrub (1997), ancêtre de Google (1998).

Google apporte un changement important: il stocke dans ses serveurs les pages qu'il indexe, ce que ne faisaient pas les autres moteurs.

Pour répondre aux besoins des étudiants, des universitaires, chercheurs et ingénieurs, des moteurs spécialisés destinés aux sujets scientifiques et techniques sont apparus.

Le fonctionnement d'un moteur de recherche comme tout instrument de recherche se décompose en trois processus principaux :

Des modules complémentaires sont souvent utilisés en association avec les trois briques de bases du moteur de recherche. Les plus connus sont les suivants :

| Le correcteur orthographique : | Le lemmatiseur : | L'anti-dictionnaire : |

|---|---|---|

| Il permet de corriger les erreurs introduites dans les mots de la requête en s'assurant de leur pertinence par la prise en compte de leur forme canonique. | Il permet de réduire les mots recherchés à leur lemme pour ainsi étendre leur portée de recherche.

|

Il supprime tous les mots « vides » (tels que « de », « le », « la ») qui sont non-discriminants, et qui perturbent le score de recherche en introduisant du bruit. La suppression se fait dans l'index et dans les requêtes. |

Afin d'optimiser les moteurs de recherche, les webmestres insèrent des métaéléments (métatags) dans les pages web, dans l'en-tête HTML (head). Ces informations permettent d'optimiser les recherches d'information sur les sites web.

Les sites dont la recherche est le principal service se financent par la vente de technologie et de publicité.

Le financement par la publicité consiste à présenter des publicités correspondant aux mots recherchés par le visiteur. L'annonceur achète des mots-clés : par exemple une agence de voyages peut acheter des mots-clés comme « vacances », « hôtel » et « plage » ou « Cannes », « Antibes » et « Nice » si elle est spécialisée dans cette région. Cet achat permet d'obtenir un référencement dit « référencement payant » à distinguer du référencement dit « référencement naturel ».

Le moteur de recherche peut afficher la publicité de deux manières : en encart séparé ou en l'intégrant aux résultats de la recherche. Pour le visiteur, l'encart séparé se présente comme une publicité classique. L'intégration aux résultats se fait en revanche au détriment de la pertinence des résultats et peut avoir des retombées négatives sur la qualité perçue du moteur. De ce fait, tous les moteurs ne vendent pas de placement dans les résultats.

Les moteurs de recherche constituent un enjeu économique. La valeur boursière du holding Alphabet propriétaire de Google, principal moteur de recherche, était de 831 milliards USD en avril 2020[1].

L'importance des enjeux économiques a généré des techniques de détournement malhonnêtes des moteurs de recherche pour obtenir des référencements « naturels », le spamdexing (référencement abusif en français).

Les techniques les plus pratiquées de spamdexing sont :

Les techniques de référencement abusif sont pourchassées par les éditeurs de moteurs de recherches, qui constituent des listes noires, provisoires ou définitives.

On distingue le spamdexing, détournement malhonnête, du « SEO », Search Engine Optimization (optimisation pour les moteurs de recherche en français). Les techniques de SEO sont commercialisées par des sociétés spécialisées.

Les grandes organisations (entreprises, administrations) disposent généralement de très nombreuses ressources informatiques dans un vaste intranet. Leurs ressources n'étant pas accessibles depuis Internet, elles ne sont pas couvertes par les moteurs de recherche du web. Elles doivent donc installer leur propre moteur si elles veulent mener des recherches dans leurs ressources. Elles constituent donc un marché pour les développeurs de moteurs de recherche. On parle alors de moteur de recherche pour entreprise (voir plus bas).

Il arrive également que des sites web publics utilisent les services d'un moteur de recherche pour étoffer leur offre. On parle alors de « SiteSearch ». Ces logiciels permettent la recherche de contenus dans un ou plusieurs groupes de sites. Ces technologies sont particulièrement exploitées sur les sites de contenus et les sites de vente en ligne. La particularité de ces outils est souvent la complexité de mise en œuvre et les ressources techniques nécessaires disponibles.

Il arrive aussi que les grands portails exploitent la technologie des moteurs de recherche. Ainsi Yahoo!, spécialiste de l'annuaire web, a utilisé pendant quelques années la technologie de Google pour la recherche jusqu'à ce qu'elle lance son propre moteur de recherche Yahoo Search Technology en 2004 dont les fondations proviennent de Altavista, Inktomi et Overture, sociétés fondatrices des moteurs de recherche et rachetées par Yahoo!.

De plus en plus de producteurs de contenu, à la suite des recommandations du W3C sur le web sémantique, indexent leurs bases avec des métadonnées ou des taxinomies (ontologies), en vue de permettre aux moteurs de recherche de s'adapter aux analyses sémantiques.

Ces formes de recherches et d'analyses de corpus d'informations par voie informatique ne sont encore que des potentialités.

Par comparaison avec des recherches plein texte, des recherches réalisées sur le web sémantique doivent être plus conviviales pour l'utilisateur :

Il n'existe pas encore à proprement parler de moteur de recherche sémantique qui permette de comprendre une question en langue naturelle et d'adapter une réponse en fonction des résultats trouvés.

Quelques tentatives existent néanmoins pour chercher à répondre par des formes intermédiaires à cette problématique du sens dans la recherche d'information :

L'abandon progressif des annuaires imprimés conduit les usagers à effectuer les mêmes recherches sur l'internet « profession+localité ». Google a donc acquis en 2010 un fichier d'entreprises (pour la France et un certain nombre de pays), pour effectuer un mixage des données web et annuaire lorsque les requêtes correspondent a une activité localisée. Cette nouvelle tendance se vérifie chez les principaux moteurs de recherche et de nouveaux « outils mixte » voient le jour. Yandex et Baidu n'ont pas encore adopté ce modèle de mixage.

Selon une étude réalisée par McKinsey&Co[2], seulement 65 % des PME françaises disposaient d'une présence sur Internet en 2013. Selon une autre étude[réf. nécessaire], cette proportion atteint 72 % pour les professions libérales (avocats, dentistes, médecins, notaires, huissiers, infirmières...).

Les moteurs de recherche qui par définition collectent uniquement des données issues de l'internet, ont donc été obligés d'acquérir et de proposer ces adresses d'annuaire en complément pour satisfaire la recherche d'adresses des internautes. Google a baptisé ces adresses « Google Adresses », puis d'office basculées vers « Google + », actuellement « Google My Business ». Les moteurs de recherche Bing et Google ne communiquent pas l'origine de ces fichiers d'entreprises intégrés, hormis Yahoo! qui est en partenariat avec Pages Jaunes.

| Moteur | Logo | France | Allemagne | Canada | États-Unis | Mexique | Brésil | Maroc |

|---|---|---|---|---|---|---|---|---|

| 90,14 % | 94,54 % | 92,38 % | 84,8 % | 94,9 % | 97,35 % | 97,31 % | ||

| Bing | 5,25 % | 2,89 % | 4,31 % | 5,59 % | 3,36 % | 1,32 % | 1,79 % | |

| Yahoo! | 1,32 % | 0,84 % | 2,33 % | 8,35 % | 1,51 % | 1,18 % | 0,71 % | |

| Qwant | 1,07 % | |||||||

| DuckDuckGo | 0,59 % | 0,67 % | 0,73 % | 1,01 % | 0,09 % | 0,01 % | 0,08 % | |

| MSN | 0,1 % | 0,08 % | 0,1 % | 0,02 % | ||||

| Yandex | 0,03 % |

Les métamoteurs sont des outils de recherche qui interrogent plusieurs moteurs de recherche simultanément et affichent à l'internaute une synthèse pertinente.

On désigne par « multi-moteurs (en) » (ou plus rarement, « super moteur »[4]) une page web proposant un ou plusieurs formulaires permettant d'interroger plusieurs moteurs. Il peut également (mais plus rarement) s'agir d'un logiciel, d'une fonction ou d'une extension de navigateur web, ou d'une barre d'outils…

Le choix d'un des moteurs peut se faire par bouton, bouton radio, onglet, liste déroulante ou autre.

Les premières pages de ce type recopiaient le code des formulaires de plusieurs moteurs. Avec l'apparition du JavaScript il est devenu possible de n'avoir plus qu'un seul formulaire.

On peut citer par exemple Creative Commons Search[5], Ecosia, Disconnect, le moteur de recherche de Maxthon, HooSeek (fermé en 2012), searchall.net, etc.

Le moteur de recherche le plus connu et le plus utilisé concernant la littérature scientifique et technique est Google Scholar, dont l'algorithme indexe un grand nombre de bases de données et de métadonnées structurées de littérature scientifique et technique et de brevets, mais il existe d'autres moteurs, plus ou moins spécialisés :

| Nom | Descriptif |

|---|---|

| Base (Bielefeld Academic Search Engine) | Spécialisé dans l’échange d’archives numériques[6], il explore plus de 300 millions de documents d'intérêt scientifique, issus de plus de 10 000 ressources libres (en 2022) et exploitant l'Open Archives Initiative (OAI). |

| OAIster (moteur du WorldCat Discovery) | fouille les corpus d'images de plus de 500 entités académiques : articles de journaux, textes, livres, vidéos, sons open-sources et d'intérêt académique, avec environ 25 millions de notices en 2022 ; plutôt orienté Biologie, médecine et chimie |

| BioTechSearchEngine | fouille les contenus d'environ 300 revues en libre accès |

| BioMed Central | fouille les contenus en libre accès de 200 revues des domaines de la médecine et la biologie et en médecine |

| PubChem | destiné à la chimie |

| CiteSeerX | bibliothèque numérique et moteur de recherche, destiné aux sciences de l’information et à l'informatique |

| TechXtra | explore des articles, ouvrage, journaux, rapports techniques, thèses, mémoires et « ressources éducatives libres » (OER) |

| WorldWideScience | destiné aux brevets et aux contenus issus de sociétés savantes du monde entier |

| Moteur de l’INIST | information scientifique et technique |

| Science.gouv | Portail gouvernemental français (disparu) |

| NARCIS | co-élaboré et géré par l'Académie royale néerlandaise des arts et des sciences et le Canada Institute for Scientific and Technical Information |

| Journal@rchive (japonais) | Archives de journaux et revues scientifiques japonaises. |

| Isidore | conçu par le CNRS pour les étudiants, doctorants, enseignants et chercheurs en sciences humaines et sociales. Il explore 3 millions de documents dans plus de 2 000 sources (en 2022), dont notamment du SUDOC, de la BnF, de la bibliothèque du Congrès, et de l'Institut de recherche et d'histoire des textes |

| Jurn | destiné aux arts et aux sciences humaines et sociales (SHS), avec un accès à plus de 1 000 revues électroniques en libre accès |

On désigne par « moteur de recherche solidaire », un moteur qui reverse une partie de ses revenus à des causes écologiques, sociales ou humanitaires. Ces moteurs sont nés du constat que les revenus annuels générés par la publicité sur les moteurs de recherche sont assez importants (environ 45 $ par an par utilisateur pour Google en 2014[7]). Les moteurs de recherches solidaires se distinguent notamment dans la façon de distribuer les revenus générés. Certains moteurs comme Ecosia reversent alors une partie des revenus à une seule et unique cause, alors que des moteurs comme Lilo et YouCare permettent aux internautes de choisir les projets à financer.

Certains moteurs ont également adopté une politique de neutralité carbone, tels que Google, DuckDuckGo et Ecosia. Google affirme qu'il sera neutre en carbone d'ici 2030, en partie en achetant des énergies renouvelables et dès 2017, l'entreprise en rachète autant qu'elle en consomme mais il ne faut pas oublier que l’utilisation des énergies renouvelables produit souvent des gaz à effet de serre. Au début des années 2020 Google est le plus gros acheteur privé au monde de ce type d'énergie. Les énergies renouvelables étant essentiellement intermittentes, Google ne peut les utiliser directement ou de façon permanente : une entreprise qui se déclare neutre en carbone utilise dans les faits des « garanties d’origines renouvelables »(ce qui n’est pas forcément vrai car certaines entreprises achète des garanties d’origine renouvelables mais fournisse en réalité l’électricité du réseau) qui permettent de s'assurer que l'énergie carbonée qu'elle consomme sera compensée par une production équivalente d'énergie renouvelable. Or, selon l'association The Shift Project, le modèle économique de Google nécessite toujours plus de puissance de calcul, de renouveler et d'augmenter son infrastructure, ses réseaux et ses équipements dont la production est une source importante de gaz à effet de serre. Pour l'association négaWatt, la communication de Google se focalise sur l'usage mais éclipse les problèmes environnementaux liés à l'extraction des ressources, du transport et du recyclage[8],[9].

Le métamoteur de recherche Ecosia utilise 80 % de ses revenus publicitaires pour des projets de reforestation aux quatre coins du monde[10].

On désigne par « moteurs verticaux » une page web ou un service multimédia qui propose une recherche spécialisée dans un domaine professionnel ou qui est particulièrement ciblée. Cet outil de recherche est spécialisé dans un secteur particulier, tel que les télécommunications, le droit, la biotechnologie, la finance (assurance) ou encore l'immobilier. Son fonctionnement général est basé sur une base de données constituée à partir des bases de tous les sites spécialisés de l'activité ciblée.

Ce type de moteur est utilisé par les professionnels et ciblé sur le consommateur, avec le plus souvent une finalité économique qui dérive sur la géolocalisation.

On retrouve ainsi pour le grand public des annuaires, des comparateurs. Il en existe maintenant pour toutes les activités : immobilier, tourisme, recherche d'emploi, recrutement, automobile, loisirs, jeux.

L'explosion du nombre de contenus de formats divers (données, informations non structurées, images, vidéos…) disponibles dans les entreprises les poussent à s'équiper de moteurs de recherche en interne.

Selon une étude menée par MARKESS International en , 49 % des organisations ont déjà recours à un moteur de recherche d'entreprise, et 18 % envisagent son utilisation d'ici à 2010. Ces moteurs de recherche sont en majeure partie intégrés aux postes de travail ou aux outils de gestion électronique des documents, mais ils sont dans un nombre grandissant d'entreprises capables de couvrir à la fois les contenus internes et externes de l'entreprise, ou encore intégrés aux outils de gestion de contenu ou aux solutions décisionnelles.

Parmi les acteurs proposant des moteurs de recherche d'entreprise figurent Google, Exalead, PolySpot ou OpenSearchServer.

Les technologies d'analyse du langage, telles que la lemmatisation, l'extraction d'entités nommées, la classification et le clustering permettent d'améliorer grandement le fonctionnement des moteurs de recherche. Ces technologies permettent à la fois d’améliorer la pertinence des résultats et d’engager l'internaute dans un processus de recherche plus performant, comme c'est le cas avec la recherche à facettes [précision nécessaire].

Selon l'étude de l'ADEME « Internet, courriels, réduire les impacts » publiée en , aller directement à l’adresse d’un site, soit en tapant son adresse dans son navigateur, soit en l’ayant enregistré comme « favori » (plutôt que de rechercher ce site via un moteur de recherche) divise par 4 les émissions de gaz à effet de serre, ce qui dépend en réalité du type de moteur de recherche, les recherches dans les moteurs comme Ecosia ayant une empreinte moyenne négative.

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.