Loading AI tools

Ethernet ([][1] oder englisch []) ist eine Technik, die Software (Protokolle usw.) und Hardware (Kabel, Verteiler, Netzwerkkarten usw.) für kabelgebundene Datennetze spezifiziert, welche ursprünglich für lokale Datennetze (LANs) gedacht war und daher auch als LAN-Technik bezeichnet wird. Sie ermöglicht den Datenaustausch in Form von Datenframes zwischen den in einem lokalen Netz (LAN) angeschlossenen Geräten (Computer, Drucker und dergleichen).[2] Derzeit sind Übertragungsraten von 1, 10, 100 Megabit/s (Fast Ethernet), 1000 Megabit/s (Gigabit-Ethernet), 2,5, 5, 10, 25, 40, 50, 100, 200 und 400 Gigabit/s spezifiziert, 800 Gigabit/s und 1,6 Terabit/s werden entwickelt. In seiner ursprünglichen Form erstreckt sich das LAN dabei nur über ein Gebäude; Ethernet-Standard-Varianten über Glasfaser haben eine Link-Reichweite von bis zu 80 km, proprietäre auch mehr.

| Anwendung | HTTP | IMAP | SMTP | DNS | … |

| Transport | TCP | UDP | |||

| Internet | IP (IPv4, IPv6) | ||||

| Netzzugang | Ethernet | ||||

| Anwendung | AFP | ADSP | ||||

| Management | ZIP | ASP | NBP | RTMP | AEP | |

| Transport | ATP | |||||

| Internet | DDP | |||||

| Netzzugang | ELAP | AARP | ||||

| Ethernet | ||||||

Die Ethernet-Protokolle umfassen Festlegungen für Kabeltypen und Stecker sowie für Übertragungsformen (Signale auf der Bitübertragungsschicht, Paketformate). Im OSI-Modell ist mit Ethernet sowohl die physische Schicht (OSI Layer 1) als auch die Data-Link-Schicht (OSI Layer 2) festgelegt. Ethernet entspricht weitestgehend der IEEE-Norm 802.3. Es wurde ab den 1990ern zur meistverwendeten LAN-Technik und hat andere LAN-Standards wie Token Ring verdrängt oder, wie im Falle von ARCNET in Industrie- und Fertigungsnetzen oder FDDI in hoch verfügbaren Netzwerken, zu Nischenprodukten für Spezialgebiete gemacht. Ethernet kann die Basis für Netzwerkprotokolle, wie z. B. AppleTalk, DECnet, IPX/SPX und TCP/IP, bilden.

Für Anwendungen, in denen hohe Anforderungen an die Zuverlässigkeit der Kommunikation gestellt werden, kommt Echtzeit-Ethernet zum Einsatz.[3]

Ethernet wurde am Xerox Palo Alto Research Center (PARC) entwickelt und lehnte sich am gemischten ALOHAnet an, das auch Funkstrecken von Insel zu Insel umfasste. Robert Metcalfe bezeichnete 1973 auf einem Memo zwei Strecken als Telephone Ether und Radio Ether.[4]

Die erste Version arbeitete mit 3 Mbit/s, deutlich schneller als serielle Verbindungen, mit denen man bis dahin Rechner und Terminals verbunden hatte. 1976 veröffentlichten Metcalfe und sein Assistent David Boggs einen Artikel mit dem Titel Ethernet: Distributed Packet-Switching For Local Computer Networks.[5] Das Patent 4063220 wurde 1977 erteilt.

Metcalfe verließ Xerox 1979 und gründete die Firma 3Com. Er überzeugte DEC, Intel und Xerox mit ihm zusammenzuarbeiten, um Ethernet zum Standard zu machen. Ihre erste Ethernet-Version 1 wurde ab 1980 vom IEEE (Institute of Electrical and Electronics Engineers) in der Arbeitsgruppe 802 weiterentwickelt. Ursprünglich war nur ein LAN-Standard für Übertragungsraten zwischen 1 und 20 Mbit/s geplant. Ebenfalls 1980 kam noch eine sogenannte „Token-Access-Methode“ hinzu. Ab 1981 verfolgte das IEEE drei verschiedene Techniken: CSMA/CD (802.3), Token Bus (802.4) und Token Ring (802.5), wovon die letzten beiden bald in einer wahren Flut von Ethernet-Produkten untergingen. 3Com wurde dabei ein großes Unternehmen.

Die Arbeiten am „Cheapernet“-Standard (10BASE2) wurden im Juni 1983 veröffentlicht. Zur gleichen Zeit begann die Arbeit an den Spezifikationen für Ethernet-on-Broadband (10BROAD36) und für StarLAN (1BASE5). Als 1985 der Ethernet-Standard auch als internationaler Standard ISO/DIS 8802/3 veröffentlicht wurde, wurde er binnen kurzer Zeit von über 100 Herstellerfirmen unterstützt. 1986 begannen einige kleinere Firmen mit der Übertragung von Daten im Ethernet-Format auf Vierdrahtleitungen aus dem Telefonbereich (CAT-3). Danach verstärkte das IEEE seine Aktivitäten in den Gebieten Ethernet-over-Twisted Pair, was 1991 zum Standard 10BASE-T wurde, sowie Ethernet auf Glasfaserkabeln, was 1992 zu den 10BASE-F-Standards (F für Fibre-Optics) führte. Mitte der 1990er Jahre kam es zu einem Tauziehen um den Nachfolge-Standard; auf der einen Seite standen AT&T und HP, die eine technisch elegantere Lösung nach IEEE 802.12 (100BASE-VG) anstrebten, auf der anderen Seite standen die Hersteller der Fast Ethernet Alliance, bestehend aus ca. 35 namhaften Firmen wie Bay Networks, 3Com, Intel, SUN, Novell usw., die 100 Mbit/s nach dem altbewährten IEEE-802.3-Standard propagierten.

Letztendlich wurde 1995 der 100-Mbit/s-Standard für Ethernet auf Bestreben der Fast Ethernet Alliance gemäß IEEE 802.3u verabschiedet, etwa gleichzeitig mit dem Standard für ein Wireless-LAN mit der Bezeichnung 802.11. Inzwischen nehmen die Arbeiten am 10-Gbit/s-Ethernet und am Ethernet in the First Mile (EFM) statt des rein lokalen Betriebs bereits Universitäts- und Stadtnetze ins Visier.

In der Form des Industrial Ethernet findet der Ethernet-Verkabelungsstandard heutzutage immer mehr auch in industriellen Fertigungsanlagen Anwendung. Die weltweite Vernetzung und die dadurch wachsenden Anforderungen an die Datenübertragung – nicht nur für berufliche, sondern auch für private Zwecke – hat dazu geführt, dass auch in Privatgebäuden und sogar Kreuzfahrtschiffen leistungsfähige Netzwerke installiert werden.

Robert Metcalfe wurde für seine Verdienste um die Entwicklung des Ethernets im Jahr 2003 die „National Medal of Technology“ verliehen.[6]

Am 21. März 2019 wurde beim DE-CIX als erstem Internetknoten weltweit 400-Gbit/s-Ethernet angeboten.[7]

Ethernet basiert auf der Idee, dass die Teilnehmer eines LANs Nachrichten durch Hochfrequenz übertragen, allerdings nur innerhalb eines gemeinsamen Leitungsnetzes. Jede Netzwerkschnittstelle hat einen global eindeutigen 48-Bit-Schlüssel, der als MAC-Adresse bezeichnet wird. (Tatsächlich werden MAC-Adressen teilweise mehrfach ausgegeben, aber die Hersteller versuchen durch geografische Trennungen lokale Kollisionen zu vermeiden.) Da MAC-Adressen modifizierbar sind, muss man darauf achten, keine doppelten Adressen im selben Netz zu verwenden, da es sonst zu Fehlern kommt. Ethernet überträgt die Daten auf dem Übertragungsmedium im sogenannten Basisbandverfahren und in digitalem Zeitmultiplex.

CSMA/CD-Algorithmus

Ein Algorithmus mit dem Namen „Carrier Sense Multiple Access with Collision Detection“ (CSMA/CD) regelt den Zugriff der Systeme auf das gemeinsame Medium. Es ist eine Weiterentwicklung des ALOHAnet-Protokolls, das in den 1970er-Jahren auf Hawaii zum Einsatz kam.

In der Praxis funktioniert dieser Algorithmus bildlich wie eine Diskussionsrunde ohne Moderator, auf der alle Gäste ein gemeinsames Medium (die Luft) benutzen, um miteinander zu sprechen. Bevor sie zu sprechen beginnen, warten sie höflich darauf, dass der andere Gast zu reden aufgehört hat. Wenn zwei Gäste zur gleichen Zeit zu sprechen beginnen, stoppen beide und warten für eine kurze, zufällige Zeitspanne, bevor sie einen neuen Anlauf wagen.

Die Stelle, die Daten senden möchte, lauscht also auf dem Medium (Carrier Sense), ob es bereits belegt ist und sendet erst, wenn die Leitung frei ist. Da zwei Stellen gleichzeitig zu senden anfangen können, kann es trotzdem zu Kollisionen kommen, die dann festgestellt werden (Collision Detection), woraufhin beide Stellen noch kurz ein „Störung-Erkannt“-Signalmuster erzeugen, dann mit dem Senden aufhören und eine zufällige Zeit warten, bis sie einen erneuten Sendeversuch starten. Hierzu muss ein Sender während des Sendens zugleich auf dem Medium lauschen, ob ein anderer Sender mit ihm kollidiert. Daher sind Medien ungeeignet für CSMA/CD, wenn eine hohe Sendeleistung notwendig ist und einem sehr schwachen Empfangssignal gegenübersteht, das dann „untergeht“.

Damit die Kollision festgestellt und eine Sendewiederholung initiiert werden kann, müssen die Datenframes abhängig von der Leitungslänge eine bestimmte Mindestlänge haben – das Störsignal des zweiten Senders muss den ersten erreichen, bevor dieser sein Datenpaket beendet hat (und als „kollisionsfrei gesendet“ betrachtet). Diese Mindestlänge ergibt sich aus der Signalgeschwindigkeit und der Übertragungsrate. Bei einer Übertragungsrate von 10 Mbit/s und einer maximalen Entfernung von 2,5 km zwischen zwei Stationen ist eine Mindestlänge von 64 Byte (14 Byte Header, 46 Byte Nutzdaten, 4 Byte CRC) vorgeschrieben. Kleinere Datenframes müssen entsprechend aufgefüllt werden. Für eine Übertragungsrate mit 10 Mbit/s (Standard-Ethernet) sind eine maximale Segmentlänge von 100 m sowie vier Repeater erlaubt. Damit können zwei Stationen bis zu einer Distanz von 500 m direkt verbunden werden. Bei höheren Übertragungsraten und maximaler Segmentlänge reduziert sich die Anzahl der Repeater aufgrund der physikalischen Abhängigkeiten. So sind bei Fast-Ethernet (100 Mbit/s) nur zwei Repeater und bei Gigabit-Ethernet (1000 Mbit/s) ein Repeater erlaubt. Bei 1-Gbit/s-Ethernet (1000 Mbit/s) im (allerdings eher hypothetischen) Halbduplex-Betrieb werden kleine Frames im Ethernet-Paket auf 520 Byte verlängert, um noch eine sichere Kollisionserkennung bei sinnvoller physischer Netzwerkgröße zu erlauben.[8]

Auch wenn die Norm IEEE 802.3 den Namen „CSMA/CD“ im Titel hat, spielt die Kollisionsauflösung heute nur mehr in geringem Maße eine Rolle. Die meisten Netzwerke werden heute im Vollduplexmodus betrieben, bei dem Teilnehmer (Router, Switches, Endgeräte etc.) mittels Punkt-zu-Punkt-Verbindung die Sende- und Empfangsrichtung unabhängig voneinander nutzen können und somit keine Kollisionen mehr entstehen. Trotzdem blieb das Frame-Format, insbesondere der Frame-Header und die für die Kollisionserkennung vorgeschriebene minimale Frame-Länge, bis hinauf zu 400-Gbit/s-Ethernet, unverändert.[9]

Broadcast und Sicherheit

In den ersten Ethernetimplementierungen wurde die gesamte Kommunikation über einen gemeinsamen Bus, der in Form eines Koaxialkabels realisiert war, abgewickelt. An diesen wurden alle Arbeitsstationen abhängig vom Kabeltyp entweder per T-Stück oder „Invasivstecker“ (auch Vampirklemme, Vampirabzweige oder Vampire Tap genannt) angeschlossen. Jede Information, die von einem Computer gesendet wurde, wurde auch von allen empfangen. Die über Ethernet verbundenen Geräte müssen ständig Informationen ausfiltern, die nicht für sie bestimmt sind.

Diese Tatsache kann genutzt werden, um Broadcast- (deutsch: Rundruf)-Nachrichten an alle angeschlossenen Systeme zu senden. Bei TCP/IP beispielsweise verwendet das ARP einen derartigen Mechanismus für die Auflösung der Schicht-2-Adressen. Diese Tatsache ist auch ein Sicherheitsproblem von Ethernet, da ein Teilnehmer mit bösen Absichten den gesamten Datenverkehr auf der Leitung mitprotokollieren kann. Eine mögliche Abhilfe ist der Einsatz von Kryptographie (Verschlüsselung) auf höheren Protokollebenen. Die Vertraulichkeit der Verkehrsbeziehungen (wer tauscht mit wem in welchem Umfang wann Daten aus?) ist aber so nicht zu schützen.

Der Einsatz von (Repeater) Hubs zur Bildung von Multi-Segment-Ethernet-Netzen ändert hier nichts, weil alle Datenpakete in alle Segmente repliziert werden.

In moderneren Ethernetnetzen wurden zur Aufteilung der Kollisions-Domänen zunächst Bridges, heute Switches eingesetzt. Durch diese wird ein Ethernet in Segmente zerlegt, in denen jeweils nur eine Untermenge an Endgeräten zu finden ist. Werden ausschließlich Switches verwendet, so kann netzweit im Full-Duplex-Modus kommuniziert werden, das ermöglicht das gleichzeitige Senden und Empfangen für jedes Endgerät. Über Switches werden Datenpakete in der Regel direkt vom Sender zum Empfänger befördert – unbeteiligten Teilnehmern wird das Paket nicht zugestellt. Broadcast- (deutsch: Rundruf-) und Multicast-Nachrichten hingegen werden an alle angeschlossenen Systeme gesendet.

Das erschwert das Ausspionieren und Mithören, der Sicherheitsmangel wird durch die Einrichtung einer „geswitchten“ Umgebung allerdings nur verringert und nicht behoben. Zusätzlich zu den Broadcast-Meldungen werden auch die jeweils ersten Pakete nach einer Sendepause – dann, wenn der Switch die Ziel-MAC-Adresse (noch) nicht kennt – an alle angeschlossenen Systeme gesendet. Dieser Zustand kann auch böswillig durch MAC-Flooding herbeigeführt werden. Pakete können auch böswillig durch MAC-Spoofing umgeleitet werden.

Die Sicherheit des Betriebs im Sinne der störungsfreien Verfügbarkeit von Daten und Diensten beruht auf dem Wohlverhalten aller angeschlossenen Systeme. Beabsichtigter oder versehentlicher Missbrauch muss in einer Ethernetumgebung durch Analyse des Datenverkehrs aufgedeckt werden (Netzwerkverkehrsanalyse). Switches stellen vielfach statistische Angaben und Meldungen bereit, die Störungen frühzeitig erkennbar werden lassen bzw. Anlass geben zu einer detaillierteren Analyse.

Switching

Ethernet in seinen frühen Ausprägungen (z. B. 10BASE5, 10BASE2), mit einem von mehreren Geräten gemeinsam als Übertragungsmedium genutzten Kabel (collision domain/shared medium – im Unterschied zu dem späteren geswitchten Ethernet), funktioniert gut, solange das Verkehrsaufkommen relativ zur nominalen Bandbreite niedrig ist. Da die Wahrscheinlichkeit für Kollisionen proportional mit der Anzahl der Sender (englisch „transmitter“) und der zu sendenden Datenmenge ansteigt, tritt oberhalb einer Auslastung von 50 % vermehrt ein als Congestion (Stau) bekanntes Phänomen auf, wobei Kapazitätsüberlastungen entstehen und somit eine gute Effizienz der Übertragungsleistung innerhalb des Netzwerks verhindert wird.

Um dieses Problem zu lösen und die verfügbare Übertragungskapazität zu maximieren, wurden Switches entwickelt (manchmal auch als Switching Hubs, Bridging Hubs oder MAC bridges bezeichnet), man spricht auch von Switched Ethernet. Switches speichern Pakete/Frames zwischen und beschränken damit die Reichweite der Kollisionen (die Kollisionsdomäne) auf die an dem entsprechenden Switchport angeschlossenen Geräte. Bei Twisted-Pair- oder Glasfaser-Verkabelung können Verbindungen zwischen zwei Geräten (Link) außerdem im Vollduplex-Modus (FDX) betrieben werden, wenn beide Geräte dies unterstützen (dies ist dann die Regel).

Wenn (alle) Hubs/Repeater aus einem Netzwerk entfernt und durch vollduplex-fähige Komponenten ersetzt werden, spricht man von einem (pure) switched Ethernet, bei dem es keine Halbduplex-Links und damit auch keine Kollisionen mehr gibt. Die Verwendung von Switches ermöglicht also eine kollisionsfreie Kommunikation im FDX-Modus, d. h., Daten können gleichzeitig gesendet und empfangen werden, ohne dass es zu Kollisionen kommt. Trotz kollisionsfreier Bearbeitung kann es jedoch zu Paketverlusten kommen, etwa wenn zwei Sender jeweils die Bandbreite beanspruchen, um zu einem gemeinsamen Empfänger Datenpakete zu senden. Der Switch kann zwar Pakete kurzzeitig puffern, wenn der Empfänger aber nicht über die doppelte Bandbreite verfügt oder der Datenfluss nicht verlangsamt werden kann, muss er bei Überlauf des Puffers Daten verwerfen, so dass sie nicht zugestellt werden können.

Ethernet flow control

Ethernet flow control (Flusskontrolle) ist ein Mechanismus, der die Datenübertragung bei Ethernet temporär stoppt. In CSMA/CD-Netzen konnte auf diese spezielle Signalisierung verzichtet werden, denn hier ist die Signalisierung einer Kollision praktisch gleichbedeutend mit einem Stopp- oder Pausensignal (Back Pressure).

Seit Fast-Ethernet und der Einführung von Switches findet die Datenübertragung praktisch nur noch kollisionsfrei im Vollduplex-Modus statt. Da damit auf CSMA/CD verzichtet wird, ist eine zusätzliche Flusskontrolle erforderlich, die es einer Station beispielsweise bei Überlastung ermöglicht, ein Signal zu geben, dass sie zurzeit keine weiteren Pakete zugesandt haben möchte – anders als mit CSMA/CD gibt es keine Möglichkeit, einen Verlust und damit die Notwendigkeit einer erneuten Sendung anzuzeigen. Hierzu wurde Flow Control eingeführt. Damit kann eine Station die Gegenstellen auffordern, eine Sendepause einzulegen und vermeidet so, dass Pakete (zumindest teilweise) verworfen werden müssen. Die Station schickt hierzu einer anderen Station (einer MAC-Adresse) oder an alle Stationen (Broadcast) ein PAUSE-Paket mit einer gewünschten Wartezeit. Die Pause beträgt 0 bis 65535 Einheiten; eine Einheit entspricht der Zeit, die für die Übertragung von 512 Bit benötigt wird.

Ethernet Flow Control verbessert die Zuverlässigkeit der Zustellung – da die angeforderten Pausen direkt auf den sendenden Knoten wirken, kann es aber zu Leistungseinbußen kommen. Wenn zum Beispiel ein Zielknoten die zu empfangenden Daten nur langsamer als mit der Übertragungsrate aufnehmen kann und deshalb Pause-Frames verschickt, bremst es den sendenden Knoten insgesamt, und dieser versorgt auch andere Zielknoten langsamer mit Daten als eigentlich möglich wäre (head-of-line blocking).

Flow Control ist optional und wird häufig nicht eingesetzt, um Head-of-Line-Blocking zu vermeiden. In den meisten Netzwerken werden für wichtige Daten in den höheren Netzwerkschichten Protokolle verwendet, die leichte Übertragungsverluste ausgleichen können, insbesondere Transmission Control Protocol. Wenn dies nicht möglich ist, muss durch die Netzwerkarchitektur oder andere Mechanismen sichergestellt werden, dass wichtige Pakete nicht verloren gehen können, zum Beispiel mit Quality of Service oder bei Fibre Channel over Ethernet.

Historische Formate

Es gibt vier Typen von Ethernet-Datenblöcken (englisch ethernet frames):

- Ethernet-Version I (nicht mehr benutzt, Definition 1980 durch Konsortium DEC, Intel und Xerox)

- Der Ethernet-Version-2- oder Ethernet-II-Datenblock (englisch ethernet II frame), der sogenannte DIX-Frame (Definition 1982 durch das Konsortium DEC, Intel und Xerox).

Seit 1983 entsteht der Standard IEEE 802.3. Ethernet ist quasi ein Synonym für diesen Standard. IEEE 802.3 definiert zwei Frame-Formate:

- IEEE 802.3 3.1.a Basic MAC frame

- IEEE 802.3 3.1.b Tagged MAC frame

Der ursprüngliche Xerox-Version-1-Ethernet-Datenblock hatte ein 16-bit-Feld, in dem die Länge des Datenblocks hinterlegt war. Da diese Länge für die Übertragung der Frames nicht wichtig ist, wurde es vom späteren Ethernet-II-Standard als Ethertype-Feld verwendet. Das Format von Ethernet I mit dem Längenfeld ist jetzt Teil des Standards 802.3.

Das Ethernet-II-Format verwendet die Bytes 13 und 14 im Frame als Ethertype. Auf ein Längenfeld wie im Ethernet-I-Frame wird verzichtet. Die Länge eines Frames wird nicht durch einen Zahlenwert, sondern durch die bitgenaue Signalisierung des Übertragungsendes übermittelt. Die Länge des Datenfeldes bleibt wie bei Ethernet I auf 1500 Bytes beschränkt. Auch das Ethernet-II-Format ist jetzt Teil des Standards 802.3, nur die Ethertypen mit Zahlenwerten kleiner als 1500 sind weggefallen, weil jetzt die Zahlenwerte kleiner gleich 1500 in diesem Feld als Länge interpretiert werden und gegen die tatsächliche Länge geprüft werden.

IEEE 802.3 definiert das 16-bit-Feld nach den MAC-Adressen als Type/Length-Feld. Mit der Konvention, dass Werte zwischen 0 und 1500 auf das originale Ethernet-Format hindeuteten und höhere Werte den EtherType angeben, wurde die Koexistenz der Standards auf demselben physischen Medium ermöglicht. Die zulässigen Werte für Ethertype werden von IEEE administriert. Diese Verwaltung beschränkt sich auf die Vergabe neuer Ethertype-Werte. IEEE nimmt bei der Neuvergabe Rücksicht auf bereits für Ethernet II vergebene Ethertype-Werte, dokumentiert diese aber nicht. So kommt es vor, dass zum Beispiel der Wert 0x0800 für IP-Daten in der IEEE-Dokumentation der Ethertype-Werte fehlt. Ethertype beschreibt das Format bzw. das Protokoll zur Interpretation des Datenblocks. Das LLC-Feld und ein eventuelles SNAP-Feld sind bereits Teil des MAC-Frame-Datenfeldes. Im Tagged-MAC-Frame werden vier Bytes mit dem QTAG-Präfix nach der Quell-MAC-Adresse eingeschoben. Dieses Feld wird durch den Standard 802.1Q definiert und ermöglicht bis zu 4096 virtuelle lokale Netzwerke (VLANs) auf einem physischen Medium. Die erlaubte Gesamtlänge des Mac-Frames wird auf 1522 Bytes verlängert, die Länge des Datenfeldes bleibt auf 1500 Bytes beschränkt.

IEEE 802.3 Tagged MAC Frame

Datenframe

Aufbau

Ethernet überträgt die Daten seriell, beginnend jeweils mit dem untersten, niederwertigsten Bit (der Einerstelle) eines Bytes. Das bedeutet, dass beispielsweise das Byte 0xD5 als Bitsequenz (links nach rechts) „10101011“ auf die Reise geht. Die Bytes der breiteren Felder werden als BigEndians übertragen, d. h. mit dem Byte mit der höheren Wertigkeit zuerst. Beispielsweise wird die MAC-Adresse im Bild 0x0040F6112233 in dieser Reihenfolge als „00 40 F6 11 22 33“ übertragen. Da das erste Bit eines Frames das Multicast-Bit ist, haben Multicastadressen ein erstes Byte mit einer ungeraden Zahl, z. B. 01-1B-19-00-00-00 für IEEE 1588.

Eine Abweichung betrifft die FCS (Frame Check Sequence, CRC): Da sämtliche übertragenen Bits durch den CRC-Generator vom LSB zum MSB geschoben werden, muss das höchstwertige Bit des höchstwertigen Bytes der CRC an vorderster Stelle übertragen werden. Ein errechneter CRC-Wert von 0x8242C222 wird somit als „41 42 43 44“ an die übertragenen Datenbytes als FCS-Prüfsumme zur Übertragung angehängt.

Im Gegensatz zum Ethernet-Frame befindet sich bei manchen anderen LAN-Typen (beispielsweise Token Ring oder FDDI) in einem Frame das höchstwertige Bit eines Bytes an erster Stelle. Das bedeutet, dass beim Bridging zwischen einem Ethernet-LAN und einem anderen LAN-Typ die Reihenfolge der Bits eines jeden Bytes der MAC-Adressen umgekehrt werden muss.

Die Präambel und SFD

Die Präambel besteht aus einer sieben Byte langen, alternierenden Bitfolge „10101010…10101010“, auf diese folgt der Start Frame Delimiter (SFD) mit der Bitfolge „10101011“. Diese Sequenz diente einst der Bit-Synchronisation der Netzwerkgeräte. Sie war für all jene Geräteverbindungen notwendig, die die Bit-Synchronisation nicht durch die Übertragung einer kontinuierlichen Trägerwelle auch in Ruhezeiten aufrechterhalten konnten, sondern diese mit jedem gesendeten Frame wieder neu aufbauen mussten. Das alternierende Bitmuster erlaubte jedem Empfänger eine korrekte Synchronisation auf die Bit-Abstände. Da bei einer Weiterleitung über Repeater (Hubs) jeweils ein gewisser Teil der Präambel verloren gehen kann, wurde sie in der Spezifikation so lang gewählt, dass bei maximaler Ausdehnung des Netzwerkes für den Empfänger noch eine ausreichende Einschwingphase übrig bleibt.

Die Bus-Netzwerkarchitekturen, die auf derartige Einschwingvorgänge angewiesen sind, werden heute kaum mehr verwendet, wodurch sich die Präambel, genauso wie das Zugriffsmuster CSMA/CD, die minimale und maximale Frame-Länge und der minimale Paketabstand (IFG, auch IPG) nur aus Kompatibilitätsgründen in der Spezifikation befinden. Genau genommen sind Präambel und SFD Paketelemente, die auf einer Ebene unterhalb des Frames und damit auch des MACs definiert sein sollten, damit ihre Verwendung vom konkreten physischen Medium abhinge. Moderne drahtgebundene Netzwerkarchitekturen sind stern- oder ringförmig und verwenden dauerhaft eingeschwungene (synchrone) Punkt-zu-Punkt-Verbindungen zwischen Endteilnehmern und Netzwerkverteilern (Bridges bzw. Switches), die Paketgrenzen in anderer Form signalisieren und daher Präambel und SFD eigentlich unnötig machen. Andererseits ergeben sich durch IFGs und minimale Frame-Längen für Netzwerkverteiler auch gewisse maximale zu verarbeitende Paketraten, was deren Design vereinfacht.

Ziel- und Quell-MAC-Adresse

Die Zieladresse identifiziert die Netzwerkstation, die die Daten empfangen soll. Diese Adresse kann auch eine Multicast- oder Broadcast-Adresse sein. Die Quelladresse identifiziert den Sender. Jede MAC-Adresse der beiden Felder hat eine Länge von sechs Bytes bzw. 48 Bit.

Zwei Bit der MAC-Adresse werden zu ihrer Klassifizierung verwendet. Das erste übertragene Bit und damit Bit 0 des ersten Bytes entscheidet, ob es sich um eine Unicast- (0) oder Broadcast-/Multicast-Adresse (1) handelt. Das zweite übertragene Bit und damit Bit 1 des ersten Bytes entscheidet, ob die restlichen 46 Bit der MAC-Adresse global (0) oder lokal (1) administriert werden. Gekaufte Netzwerkkarten haben eine weltweit eindeutige MAC-Adresse, die global von einem Konsortium und der Herstellerfirma verwaltet wird. Man kann aber jederzeit individuelle MAC-Adressen wählen und den meisten Netzwerkkarten über die Treiberkonfiguration zuweisen, in denen man für das Bit 1 den Wert (1) wählt und eben spezifikationsgemäß die restlichen 46 Bit lokal verwaltet und in der Broadcast-Domäne eindeutig hält.

MAC-Adressen werden traditionell als Abfolge von sechs zweistelligen Hex-Zahlen dargestellt, die mit Doppelpunkten getrennt sind, z. B. als „08:00:01:EA:DE:21“, was der Übertragungsreihenfolge am Medium entspricht. Die einzelnen Bytes werden beginnend mit dem LSB gesendet.

VLAN-Tag

Im Tagged-MAC-Frame nach IEEE 802.1Q folgen zusätzlich vier Bytes als VLAN-Tag. Die ersten beiden Bytes enthalten die Konstante 0x8100 (=802.1qTagType), die einen Tagged-MAC-Frame als solchen kenntlich machen. Von der Position her würde hier im Basic-MAC-Frame das Feld Ethertype stehen. Den Wert 0x8100 kann man damit auch als Ethertype für VLAN-Daten ansehen, allerdings folgt nach dem Tag noch der eigentliche Ethertype (s. u.). In den nächsten beiden Bytes (TCI Tag Control Information) stehen dann drei Bit für die Priorität (Class of Service, 0 niedrigste, 7 höchste Priorität), ein Bit Canonical Format Indicator (CFI), das für die Kompatibilität zwischen Ethernet und Token Ring sorgt (dieses 1-bit-Datenfeld zeigt an, ob die MAC-Adresse in einem anerkannten oder nicht anerkannten Format ist. Hat das gesetzte Bit eine 0, dann ist es nicht vorschriftsmäßig, bei einer 1 ist es vorschriftsmäßig. Für Ethernet-Switches ist es immer 0. Empfängt ein Ethernet-Port als CFI-Information eine 1, dann verbindet der Ethernet-Switch das Tagging-Frame nicht zu einem nicht-getaggten Port.), sowie 12 Bit für die VLAN-ID. An diesen VLAN-Tag schließt das ursprünglich an der Position des VLAN-Tags stehende Typ-Feld (EtherType) des eigentlichen Frames mit einem Wert ungleich 0x8100 (im Bild beispielsweise 0x0800 für ein IPv4-Paket) an.

Der VLAN-Tag wird als Folge von zwei Bytes „81 00“ übertragen. Die 16 Bit des TCI werden in gleicher Weise Big-Endian mit dem höheren Byte voran verschickt.

Das Typ-Feld (EtherType)

Das Typ-Feld gibt Auskunft über das verwendete Protokoll der nächsthöheren Schicht innerhalb der Nutzdaten. Die Werte sind größer als 0x0600 (ansonsten ist das ein Ethernet-I-frame mit Längenfeld in dieser Position). Der spezielle Wert 0x8100 zur Kennzeichnung eines VLAN-Tags ist im Wertevorrat von Type reserviert. Ist ein VLAN-Tag vorhanden, darf das daran anschließende Typ-Feld nicht 0x8100 sein.

Werte im Typfeld (EtherType) für einige wichtige Protokolle:

| Typfeld | Protokoll |

|---|---|

| 0x0800 | IP Internet Protocol, Version 4 (IPv4) |

| 0x0806 | Address Resolution Protocol (ARP) |

| 0x0842 | Wake on LAN (WoL) |

| 0x8035 | Reverse Address Resolution Protocol (RARP) |

| 0x809B | AppleTalk (EtherTalk) |

| 0x80F3 | Appletalk Address Resolution Protocol (AARP) |

| 0x8100 | VLAN Tag (VLAN) |

| 0x8137 | Novell IPX (alt) |

| 0x8138 | Novell |

| 0x86DD | IP Internet Protocol, Version 6 (IPv6) |

| 0x8847 | MPLS Unicast |

| 0x8848 | MPLS Multicast |

| 0x8863 | PPPoE Discovery |

| 0x8864 | PPPoE Session |

| 0x8870 | Jumbo Frames (veraltet)[10] |

| 0x888E | 802.1X Port Access Entity |

| 0x8892 | Echtzeit-Ethernet PROFINET |

| 0x88A2 | ATA over Ethernet Coraid AoE[11] |

| 0x88A4 | Echtzeit-Ethernet EtherCAT |

| 0x88A8 | Provider Bridging |

| 0x88AB | Echtzeit-Ethernet Ethernet POWERLINK |

| 0x88B8 | IEC61850 GOOSE |

| 0x88CC | Link Layer Discovery Protocol LLDP |

| 0x88CD | Echtzeit-Ethernet Sercos III |

| 0x88E1 | HomePlug AV |

| 0x88E5 | MACsec |

| 0x8906 | Fibre Channel over Ethernet |

| 0x8914 | FCoE Initialization Protocol (FIP) |

| 0x8947 | GeoNetworking protocol |

In Ethernet-802.3-Frames kann zur Kompatibilität mit Ethernet I an Stelle des Typfeldes die Länge des Dateninhalts im DATA-Teil angegeben (Längenfeld) sein. Da das Datenfeld in keinem Ethernet Frame länger als 1500 Bytes sein darf, können die Werte 1536 (0x0600) und darüber als Protokolltypen (Ethertype) verwendet werden. Die Verwendung der Werte 1501 bis 1535 ist nicht spezifiziert.[12] Die Verwendung als Länge ist praktisch vollständig verschwunden – um das Ende eines Frames zu signalisieren, verwenden alle Ethernet-Varianten entweder ein spezielles Steuersymbol (100 Mbit/s aufwärts)[13] oder beenden den Trägertakt (10 Mbit/s).

Das Typ-Feld wird als Big-Endian-Byte-Folge interpretiert und mit dem höherwertigen Byte voran verschickt.

Nutzdaten

Pro Datenblock können maximal 1500 Bytes an Nutzdaten übertragen werden. Die Nutzdaten werden von dem unter Type angegebenen Protokoll interpretiert.[14] So genannte Jumbo Frames, Super Jumbo Frames und Jumbogramme erlauben auch größere Datenblöcke, diese Spezialmodi bewegen sich aber offiziell abseits von Ethernet beziehungsweise IEEE 802.3.

Die Datenbytes werden in aufsteigender Byte-Reihenfolge verschickt.

PAD-Feld

Das PAD-Feld wird verwendet, um den Ethernet-Frame auf die erforderliche Minimalgröße von 64 Byte zu bringen. Das ist bei alten Übertragungsverfahren wichtig, um Kollisionen in der sogenannten Collision-Domain sicher zu erkennen. Präambel und SFD (8 Bytes) werden bei der erforderlichen Mindestlänge des Frames nicht mitgezählt, wohl aber ein VLAN-Tag. Ein PAD-Feld wird somit erforderlich, wenn als Nutzdaten weniger als 46 bzw. 42 Bytes (ohne bzw. mit 802.1Q-VLAN-Tag) zu übertragen sind. Das in Type angegebene Protokoll muss dafür sorgen, dass diese als Pad angefügten Bytes (auch „Padding Bytes“ genannt) nicht interpretiert werden, wofür es üblicherweise eine eigene Nutzdaten-Längenangabe bereithält.

FCS (Frame Check Sequence)

Das FCS-Feld stellt eine 32-Bit-CRC-Prüfsumme dar. Die FCS wird über den eigentlichen Frame berechnet, also beginnend mit der Ziel-MAC-Adresse und endend mit dem PAD-Feld. Die Präambel, der SFD und die FCS selbst sind nicht in der FCS enthalten. Wenn ein Paket beim Sender erstellt wird, wird eine CRC-Berechnung über die Bitfolge durchgeführt und die Prüfsumme an den Datenblock angehängt. Der Empfänger führt nach dem Empfang die gleiche Berechnung aus. Stimmt die empfangene nicht mit der selbst berechneten Prüfsumme überein, geht der Empfänger von einer fehlerhaften Übertragung aus, und der Datenblock wird verworfen. Zur Berechnung der CRC-32-Prüfsumme werden die ersten 32 Bits der Mac-Adresse invertiert und das Ergebnis der Prüfsummenberechnung wird ebenfalls invertiert (Vermeidung des Nullproblems).

In üblichen CRC-Implementierungen als rückgekoppelte Schieberegister werden Datenbits in übertragener Reihenfolge, also vom LSB zum MSB, durch ein Schieberegister geschickt, das aber selbst vom LSB aus beschickt wird. In Schieberichtung steht damit das MSB der CRC zuerst zur Verfügung und gerät auch in Abweichung zu allen anderen Daten zuerst auf die Leitung. Wird nun der Datenstrom beim Empfänger inklusive empfangenem CRC-Wert in das Schieberegister geschrieben, enthält die CRC im fehlerfreien Fall den Wert Null. Ein von Null abweichender Wert deutet auf einen Übertragungsfehler hin.

Durch die Invertierung der ersten 32 Bit und der CRC-Summe ist das Ergebnis nicht mehr Null. Wenn kein Übertragungsfehler aufgetreten ist, dann enthält das Schieberegister immer dieselbe Zahl, auch Magic Number genannt. Beim Ethernet lautet sie 0xC704DD7B.

Reihenfolge der Bits und Bytes

Bei Ethernet werden Bytes (Oktette) grundsätzlich mit dem niederstwertigen Bit voran übertragen (mit Ausnahme der Frame Check Sequence). Viele schnellere Varianten übertragen allerdings keine einzelnen Bits, sondern Mehrbit-Symbole oder ganze Oktette in einem Schritt. Felder, die aus mehreren Bytes bestehen, werden grundsätzlich mit dem höchstwertigen Oktett voran übertragen.

Nachdem der Datenstrom als Folge von Bytes bereitgestellt wurde, werden nun abhängig vom physischen Medium und der Übertragungsrate ein oder mehrere Bits in einen Leitungscode kodiert, um einerseits die physischen Eigenschaften des Mediums zu berücksichtigen und andererseits dem Empfänger eine Taktrückgewinnung zu ermöglichen. So wird, je nach Code, die erlaubte Frequenz-Bandbreite nach unten (Gleichspannungsfreiheit) und oben limitiert.

In übertragungsfreien Zeiten, also zwischen zwei Frames, kommt es definitionsgemäß zu Ruhepausen („Inter-Frame-Spacing“) mit einer gewissen Mindestlänge. Bei physischem Halbduplex-Modus schaltet sich in dieser Zeit der Sender ab, um anderen Stationen auf dem geteilten Medium Zugriff zu ermöglichen. Bei moderneren Medientypen mit physischem Vollduplex-Modus wird eine Trägerschwingung aufrechterhalten, die dem Empfänger ein schnelleres Aufsynchronisieren auf den Datenstrom ermöglicht. Außerdem können in der sendefreien Zeit Out-of-Band-Informationen zwischen den Stationen ausgetauscht werden.

Bei manchen physischen Vollduplex-Medientypen wie beispielsweise 10BASE-T deaktiviert sich die Sendestation trotz exklusiven Zugriffs auf das Medium zwischen den Frames. Hier wird die sendefreie Zeit zur Out-of-Band-Signalisierung (Link-Pulse, Fast-Link-Pulse) der Link-Parameter genutzt.

Die verschiedenen Ethernet-Varianten (PHYs) unterscheiden sich in Übertragungsrate, den verwendeten Kabeltypen und der Leitungscodierung. Der Protokollstack arbeitet bei den meisten der folgenden Typen identisch.

Eine erfolgreiche Verbindung zwischen zwei Anschlüssen (Ports) wird als Link bezeichnet. Einige Varianten teilen den Datenstrom in mehrere Kanäle (Lanes) auf, um Datenrate und Frequenzen auf das Medium anzupassen. Die jeweilige Reichweite ist die maximal mögliche Länge eines Links innerhalb der Spezifikation. Bei einer höheren Qualität des Mediums – insbesondere bei Glasfaser – können auch deutlich längere Links stabil funktionieren.

Die Varianten beziehen ihre Namen aus den verwendeten Spezifikationen:[15]

- 10, 100, 1000, 10G, … – die nominelle, auf der Bitebene nutzbare Geschwindigkeit (kein Suffix = Megabit/s, G = Gigabit/s); die leitungskodierten Sublayer haben üblicherweise eine höhere Datenrate

- BASE, BROAD, PASS – Basisband-, Breitband- oder Passband-Signalisierung

- -T, -S, -L, -C, -K, … – Medium: T = Twisted-Pair-Kabel, S = (short) kurze Wellenlänge ca. 850 nm über Multimode-Faser, L = (long) lange Wellenlänge ca. 1300 nm, hauptsächlich Singlemode-Faser, E/Z = extralange Wellenlänge ca. 1500 nm (Singlemode), B = bidirektionale Faser mit WDM (meist Singlemode), P = Passive Optical Network, C = (copper) Twinaxialkabel, K = Backplane, 2/5 = Koaxialkabel mit 185/500 m Reichweite

- X, R – PCS-Kodierung (generationsabhängig), zum Beispiel X für 8b/10b Blockkodierung (4B5B bei Fast Ethernet), R für große Blöcke (64b/66b)

- 1, 2, 4, 10 – Anzahl der Lanes pro Link oder Reichweite bei 100/1000 Mbit/s WAN PHYs

Bei 10-Mbit/s-Ethernet verwenden alle Varianten durchgehend Manchester-Code, keine Kodierung ist angegeben. Die meisten Twisted-Pair-Varianten verwenden spezielle Kodierungen, nur -T wird angegeben.

Die folgenden Abschnitte geben einen kurzen Überblick über alle offiziellen Ethernet-Medientypen. Zusätzlich zu diesen offiziellen Standards haben viele Hersteller proprietäre Medientypen entwickelt, häufig, um mit Lichtwellenleitern höhere Reichweiten zu erzielen.

Einige frühe Varianten von Ethernet

- Xerox Ethernet (Alto Aloha System) – Der Name entstand dadurch, dass das Konzept auf Alto-Computern getestet wurde. Xerox Ethernet ist die ursprüngliche Ethernet-Implementation, die während ihrer Entwicklung zwei Versionen hatte. Das Datenblock-Format der Version 2 wird zurzeit überwiegend benutzt.

- 10Broad36 (IEEE 802.3 Clause 11) – Obsolet. Ein früher Standard, der Ethernet über größere Entfernungen unterstützte. Es benutzte Breitband-Modulationstechniken ähnlich denen von Kabelmodems und arbeitete mit Koaxialkabeln.

- StarLAN, standardisiert als 1BASE5 (IEEE 802.3 Clause 12) – Die erste Ethernet-Implementation über Twisted-Pair-Kabel, entwickelt von AT&T. 1 Mbit/s über die bereits weit verbreiteten (meist) Cat-3-Verkabelungen mit einer Link-Reichweite von 250 bis 500 m. Ein kommerzieller Fehlschlag, der aber die technische Grundlage für 10BASE-T lieferte.

10-Mbit/s-Ethernet

Beim 10-Mbit/s-Ethernet kommt eine einfache Manchesterkodierung zum Einsatz, die je Datenbit zwei Leitungsbits überträgt (somit 20 MBaud). Mit dieser Verdopplung der Signalisierungsrate und dabei alternierend übertragenen Datenbits wird die Gleichspannung effektiv unterdrückt und gleichzeitig die Taktrückgewinnung im Empfänger nachgeführt, das Spektrum reicht bis 10 MHz. Die Leitung wird nur belegt, wenn ein Ethernet-Paket tatsächlich gesendet wird.

10-Mbit/s-Ethernet mit Koaxialkabel

- 10BASE2, IEEE 802.3 Clause 10 (früher IEEE 802.3a)

- (auch bekannt als Thin Wire Ethernet, Thinnet oder Cheapernet) – Ein Koaxialkabel (RG58) mit einer Wellenimpedanz von 50 Ohm verbindet die Teilnehmer miteinander, jeder Teilnehmer benutzt ein BNC-T-Stück zur Anbindung seiner Netzwerkkarte. An den beiden Leitungsenden angebrachte Abschlusswiderstände sorgen für reflexionsfreie Signalübertragung. Ein Segment (das sind alle durch die BNC-T-Stücke miteinander verbundenen Koaxialkabelstücke) darf maximal 185 Meter lang sein und maximal 30 Teilnehmer versorgen. Jeweils zwei Teilnehmer am Bus müssen zueinander einen Abstand von mindestens 0,5 Meter einhalten. Im Unterschied zum ebenfalls Koaxialkabel verwendenden 10BASE5 sind die Transceiver in der NIC (Network Interface Card) integriert und müssen unmittelbar (ohne weiteres Koaxialkabel) an das T-Stück angeschlossen werden. Über Repeater können weitere Netzwerksegmente angeschlossen werden, sodass die maximale Ausdehnung des Netzwerks 5 Netzwerksegmente in einer Kette umfasst. Mit strukturierter Verkabelung lässt sich die Anzahl der Segmente weiter steigern. Damit ist eine maximale Gesamtausbreitung von 925 m Durchmesser erreichbar. Es wurden auch Ethernet-Anschlussdosen (EAD) verwendet. Bei 10BASE2 fällt das ganze Netzwerksegment aus, wenn an einer Stelle das Kabel oder eine Steckverbindung, insbesondere der Abschlusswiderstand, defekt ist. Besonders anfällig sind manuell konfektionierte Koaxialkabel, wenn bei ihnen der BNC-Stecker nicht korrekt befestigt wurde.

- 10BASE5, IEEE 802.3 Clause 8

- (auch Thicknet oder Yellow Cable) – ein früher IEEE-Standard, der ein 10 mm dickes Koaxialkabel (RG8) mit einer Wellenimpedanz von 50 Ohm verwendet. Zum Anschluss von Geräten muss mittels einer Bohrschablone ein Loch an einer markierten Stelle in das Kabel gebohrt werden, durch das ein Kontakt einer Spezialklemme (Vampirklemme) des Transceivers eingeführt und festgeklammert wird. An diesen Transceiver wird mittels der AUI-Schnittstelle über ein Verbindungskabel die Netzwerkkarte des Computers angeschlossen. Dieser Standard bietet 10 Mbit/s Datenrate bei Übertragung im Basisband und unterstützt auf jedem Segment maximal 500 m Kabellänge und 100 Teilnehmer. Die Leitung hat wie 10BASE2 keine Abzweigungen, und an den Enden sitzen 50-Ohm-Abschlusswiderstände. Wie auch bei 10BASE2 kann über Repeater das Netzwerk bis auf eine max. Länge von 2,5 km ausgedehnt werden. Dieser Typ ist eigentlich obsolet, aber aufgrund seiner weiten Verbreitung in den frühen Tagen noch immer in einigen Systemen in Benutzung.

10-Mbit/s-Ethernet mit Twisted-Pair-Kabel

- StarLAN 10 – aus 1BASE5 entwickelt, 10 Mbit/s, fast identisch mit 10BASE-T

- 10BASE-T, IEEE 802.3i Clause 14 – verwendet vier Adern (zwei verdrillte Paare) eines CAT-3 oder CAT-5-Kabels (Verkabelung nach TIA-568A/B). Ein Hub oder Switch sitzt in der Mitte, und jeder Teilnehmer wird über einen dedizierten Port angeschlossen. Die Übertragungsrate ist 10 Mbit/s und die maximale Länge eines Segments 100 m. Physisch sind die Steckverbindungen als 8P8C-Modularstecker und -buchsen ausgeführt, die meist als „RJ-45“- bzw. „RJ45“-Stecker/-Buchsen bezeichnet werden. Da normalerweise 1:1-Kabel zum Einsatz kommen, sind die Stecker von Computer (MDI) und Uplink (Hub, Switch, MDI-X) gegengleich belegt. Beim Computer gilt folgende Belegung: Pin1 – Transmit+; Pin2 – Transmit−; Pin3 – Receive+; Pin6 – Receive−.

- 10BASE-T1L, IEEE P802.3cg[16] – wird über die in der Prozessautomation üblichen Zweidrahtleitungen nach IEC 61158-2 Kabeltyp A übertragen. Die Übertragung erfolgt mit einer Datenübertragungsrate von 10 Mbit/s, wird 4B3T codiert und als PAM-3 moduliert und mit 7,5 MBaud vollduplex übertragen. Über das gleiche Kabel können die Teilnehmer mit bis zu 60 W Leistung versorgt werden. Der Aufbau besteht aus einem „Trunk“-Kabel mit maximal 1000 m zwischen den Feldswitches und den „Spur“-Kabel von maximal 200 m zwischen einem Feldswitch und einem Feldgerät.

10-Mbit/s-Ethernet mit Glasfaser-Kabel

- FOIRL – Fiber-optic inter-repeater link. Der ursprüngliche Standard für Ethernet über Glasfaserkabel.

- 10BASE-F, IEEE 802.3j (IEEE 802.3 Clause 15) – Allgemeiner Ausdruck für die neue Familie von 10-Mbit/s-Ethernet-Standards: 10BASE-FL, 10BASE-FB und 10BASE-FP. Der einzig weiter verbreitete davon ist 10BASE-FL.

- 10BASE-FL (IEEE 802.3 Clause 18) – Eine revidierte Version des FOIRL-Standards.

- 10BASE-FB (IEEE 802.3 Clause 17) – Gedacht für Backbones, die mehrere Hubs oder Switches verbinden. Ist inzwischen technisch überholt.

- 10BASE-FP (IEEE 802.3 Clause 16) – Ein passives sternförmiges Netzwerk, das keinen Repeater braucht. Es gibt keine Implementationen.

100-Mbit/s-Ethernet

Beim Übergang von 10- auf 100-Mbit/s-Ethernet (Fast Ethernet) wurde die Signalisierungsebene weiter unterteilt, um auf eine klarere Definition dessen zu kommen, was den PHY (die physische Schicht, OSI-Schicht 1) vom MAC trennt. Gab es bei 10-Mbit/s-Ethernet PLS (Physical Layer Signaling, Manchester-Codierung, identisch für alle 10-Mbit/s-Standards) und PMA (Physical Medium Attachment, Coaxial-, Twisted-Pair- und optische Anbindungen), sind es bei Fast Ethernet nunmehr PCS (Physical Coding Sublayer) mit PMA sowie PMD (Physical Medium Dependent). PCS, PMA und PMD bilden gemeinsam die physische Schicht. Es wurden drei verschiedene PCS-PMA-Kombinationen entworfen, von denen jene für 100BASE-T4 und 100BASE-T2 (IEEE 802.3 Clauses 23 und 32) aber keine wirtschaftliche Bedeutung erlangen konnten.

Durchgesetzt hat sich für Kupferkabel einzig 100BASE-TX (IEEE 802.3 Clause 24) für Twisted-Pair-Kabel, das wie die Glasfaser-Varianten statt der Manchesterkodierung den effizienteren 4B5B-Code einsetzt. Dieser ist zwar nicht gleichspannungsfrei, ermöglicht jedoch eine Taktrückgewinnung aus dem Signal und die Symbolrate liegt mit 125 MBaud nur geringfügig über der Datenrate selbst. Die verwendeten Leitungscodeworte garantieren eine für die Bitsynchronisation beim Empfänger ausreichende minimale Häufigkeit von Leitungszustandswechseln. Der Gleichspannungsanteil wird durch die zusätzliche Kodierung mit MLT-3 und mit einem Scrambling-Verfahren entfernt, das auch für ein (statistisch) gleichmäßiges Frequenzspektrum unabhängig von der Leitungsauslastung sorgt. Da es hier keine physischen Busse, sondern nur mehr Punkt-zu-Punkt-Verbindungen gibt, wurde eine kontinuierliche Übertragung favorisiert, die die aufwändigen Einschwingvorgänge des Empfängers auf die Hochfahrphase des Segments beschränkt.

Kupfer

- 100BASE-T

- Allgemeine Bezeichnung für die drei 100-Mbit/s-Ethernetstandards über Twisted-Pair-Kabel: 100BASE-TX, 100BASE-T4 und 100BASE-T2 (Verkabelung nach TIA-568A/B). Die maximale Länge eines Segments beträgt wie bei 10BASE-T 100 Meter. Die Steckverbindungen sind als 8P8C-Modularstecker und -buchsen ausgeführt und werden meist mit „RJ-45“ bezeichnet.

- 100BASE-T4, IEEE 802.3 Clause 23

- 100 Mbit/s Ethernet über Category-3-Kabel (wie es in 10BASE-T-Installationen benutzt wird). Verwendet alle vier Aderpaare des Kabels. Es ist inzwischen obsolet, da Category-5-Verkabelung heute die Norm darstellt. Es ist darüber hinaus auf Halbduplex-Übertragung beschränkt.

- 100BASE-T2, IEEE 802.3 Clause 32

- Es existieren keine Produkte, die grundsätzliche Technik lebt aber in 1000BASE-T weiter und ist dort sehr erfolgreich. 100BASE-T2 bietet 100 Mbit/s Datenrate über Cat-3-Kabel. Es unterstützt den Vollduplexmodus und benutzt nur zwei Aderpaare. Es ist damit funktionell äquivalent zu 100BASE-TX, unterstützt aber ältere Kabelinstallationen.

- 100BASE-TX, IEEE 802.3 Clause 25 (früher IEEE 802.3u)

- Benutzt wie 10BASE-T je ein verdrilltes Aderpaar pro Richtung, benötigt allerdings mindestens ungeschirmte Cat-5-Kabel.

- Die Verwendung herkömmlicher Telefonkabel ist bei eingeschränkter Reichweite möglich.[17] Entscheidend hierbei ist die richtige Zuordnung der beiden Ethernet-Paare zu jeweils einem verdrillten Paar des Telefonkabels. Ist das Telefonkabel als Sternvierer verseilt, bilden die gegenüberliegenden Adern jeweils ein Paar.

- Auf dem 100-Mbit/s-Markt ist 100BASE-TX heute die Standard-Ethernet-Implementation. 100BASE-TX verwendet 4B5B als Leitungscode und zur Bandbreitenhalbierung auf PMD-Ebene die Kodierung MLT-3. Dabei werden nicht nur zwei Zustände (positive oder negative Differenzspannung) auf dem Aderpaar unterschieden, es kommt ein dritter Zustand (keine Differenzspannung) dazu (ternärer Code). Damit wird der Datenstrom mit einer Symbolrate von 125 MBaud innerhalb einer Bandbreite von 31,25 MHz übertragen.

- Während der 4B5B-Code ausreichend viele Signalwechsel für die Bitsynchronisation beim Empfänger garantiert, kann MLT-3 zur benötigten Gleichspannungsfreiheit nichts beitragen. Als „Killer Packets“ bekannte Übertragungsmuster können dabei das Scrambling kompensieren und dem Übertragungsmuster eine signifikante Gleichspannung überlagern (baseline wander), die die Abtastung erschwert und zu einem Verbindungsabbruch der Endgeräte führt. Um gegen solche Angriffe immun zu sein, implementieren die PHY-Bausteine der Netzwerkkarten daher eine Gleichspannungskompensation.

- 100BASE-T1, IEEE 802.3bw-2015

- In der von IEEE 802.3b[18] standardisierten Fast-Ethernet Definition 100BASE-T1[19] werden die Daten über ein symmetrisch verdrilltes Kupferpaar mit PAM-3 vollduplex übertragen. Das Twisted-Pair-Kabel von 100 Ω Impedanz muss mindestens 66 MHz übertragen können, damit eine maximale Länge von 15 m erreicht werden kann. Der Standard ist für Anwendungen im Automobilbereich[20] vorgesehen. Für industrielle Anwendungen wurde von der Interessengruppe Single Pair Ethernet (SPE)[21] in der IEC 63171-6 der Stecker IEC 61076-3-125 für industrielle Anwendungen von 100BASE-T1 festgelegt. 100BASE-T1 wurde vor der IEEE-Normung als BroadR-Reach entwickelt.[22]

Glasfaser

- 100BASE-FX, IEEE 802.3 Clause 26

- 100 Mbit/s Ethernet über Multimode-Glasfaser. Maximale Segmentlängen über Multi-Mode-Kabel: 400 Meter im Halbduplex-/Repeaterbetrieb, 2000 Meter im Vollduplex-/Switchbetrieb. Der gescrambelte 4B5B-Datenstrom wird direkt über einen optischen Lichtmodulator gesendet und in gleicher Weise empfangen, hierfür wird ein Faserpaar verwendet. Es wird eine Wellenlänge von 1300 nm verwendet, daher ist es nicht mit 10BASE-FL (10 Mbit/s über Glasfaser) kompatibel, welches eine Wellenlänge von 850 nm benutzt.

- 100BASE-SX, TIA-785

- Günstigere Alternative zu 100BASE-FX, da eine Wellenlänge von 850 nm verwendet wird; die Bauteile hierfür sind günstiger. Maximale Segmentlänge: 550 Meter über Multimode-Glasfaser. Durch die verwendete Wellenlänge optional abwärtskompatibel zu 10BASE-FL. Es wird ein Faserpaar benötigt.

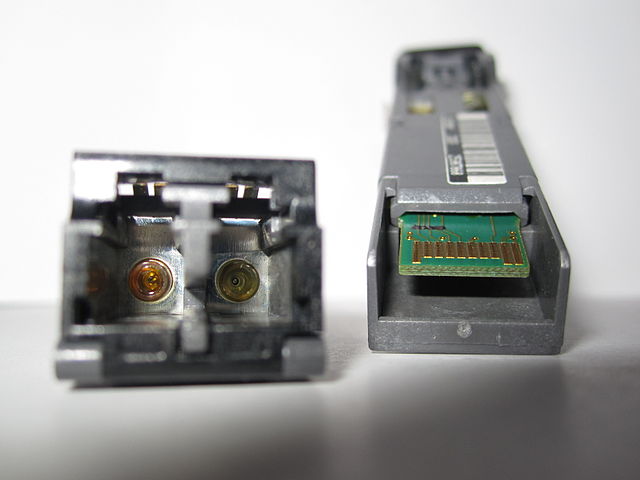

- 100BASE-BX10, IEEE 802.3 Clause 58

- Im Gegensatz zu 100BASE-FX, 100BASE-SX und 100BASE-LX10 wird hier Sende- und Empfangsrichtung über eine einzelne Single-Mode-Glasfaser übertragen. Hierfür wird ein Splitter benötigt, welcher die zu sendenden/empfangenden Daten auf die Wellenlängen 1310 und 1550 nm aufteilt. Dieser Splitter kann im Übertragungsbauteil, z. B. einem SFP-Modul, integriert sein. Dieser Standard erzielt Reichweiten von 10 km, erweiterte Versionen 20 oder 40 km.

- 100BASE-LX10, IEEE 802.3 Clause 58

- Fast-Ethernet über ein Single-Mode Faserpaar. Wellenlänge: 1310 nm, Segmentlänge: 10 km.

Gigabit-Ethernet

Bei 1000-Mbit/s-Ethernet (Gigabit-Ethernet; kurz: GbE oder GigE) kommen im Wesentlichen zwei verschiedene Kodiervarianten zum Einsatz. Bei 1000BASE-X (IEEE 802.3 Clause 36) wird der Datenstrom in 8-Bit breite Einheiten zerlegt und mit dem 8b10b-Code auf eine Symbolrate von 1250 MBaud gebracht. Damit wird ein kontinuierlicher, gleichspannungsfreier Datenstrom erzeugt, der bei 1000BASE-CX über einen Transformator auf einem verdrillten Aderpaar zum Empfänger fließt oder bei 1000BASE-SX/LX/ZX die optische Trägerwelle moduliert. Bei 1000BASE-T hingegen wird der Datenstrom in vier Teilströme unterteilt, die jeweils mit PAM-5 und Trellis-Codierung in ihrer Bandbreite geformt und über die vier Aderpaare gleichzeitig gesendet und empfangen werden.

Die beim frühen Fast Ethernet noch weit verbreiteten Repeater Hubs wurden für Gigabit Ethernet anfangs zwar noch im Standard definiert, allerdings wurden keine Hubs hergestellt, so dass der Standard 2007 eingefroren wurde[23] und GbE real ausschließlich über Switches im Vollduplex-Modus existiert.

Kupfer

- 1000BASE-T, IEEE 802.3 Clause 40 (früher IEEE 802.3ab) – 1 Gbit/s über Kupferkabel ab Cat-5 UTP-Kabel oder besser Cat-5e oder Cat-6 (Verkabelung nach TIA-568A/B). Die maximale Länge eines Segments beträgt wie bei 10BASE-T und 100BASE-TX 100 Meter. Wichtige Merkmale des Verfahrens sind:

- Verwendung aller vier Doppeladern in beide Richtungen (Echokompensation)

- Modulationsverfahren PAM-5 (Pulsamplitudenmodulation mit fünf Zuständen) übermittelt zwei Bit pro Schritt und Aderpaar

- Einsatz einer Trellis-Codierung und Scrambling

- Schrittgeschwindigkeit 125 MBaud pro Aderpaar

- Übertragungsbandbreite 62,5 MHz

- Im Grundprinzip ist 1000BASE-T eine „hochskalierte“ Variante des seinerzeit erfolglosen 100BASE-T2, nur dass es doppelt so viele Aderpaare (nämlich alle vier Paare einer typischen Cat-5-Installation) verwendet und die gegenüber Cat-3 größere verfügbare Bandbreite eines Cat-5-Kabels ausnutzt.

- 1000BASE-TX, 1000BASE-T2/4 (nicht in IEEE 802.3 standardisiert) – Erfolglose Versuche verschiedener Interessengruppen, die aufwändigen Modulier/Demodulier- und Echokompensationsschaltungen von 1000BASE-T durch eine höhere Signalisierungsrate auszugleichen. Statt Klasse-D-Verkabelung bei 1000BASE-T benötigen diese Übertragungsverfahren im Gegenzug Installationen nach Klasse E und Klasse F. Das Hauptargument für die Entstehung dieser Übertragungsverfahren, die hohen Kosten für Netzwerkanschlüsse mit 1000BASE-T-Unterstützung, ist längst entkräftet.

- 1000BASE-CX, IEEE 802.3 Clause 39 – Als Übertragungsmedium werden zwei Aderpaare eines Shielded-Twisted-Pair-Kabels (STP) mit einer maximalen Kabellänge von 25 m und einer Impedanz von 150 Ohm eingesetzt. Der Anschluss erfolgt über 8P8C-Modularstecker/-buchsen (meist als „RJ45“/„RJ-45“ bezeichnet) oder DE-9 in einer Sterntopologie. Im Vergleich zu 1000BASE-T werden bei 1000BASE-CX deutlich höhere Anforderungen an das Kabel gestellt. So ist etwa die verwendete Bandbreite um den Faktor 10 höher (625 MHz gegenüber 62,5 MHz). Die Komponenten sind außerdem zueinander nicht kompatibel.

- 1000Base-T1, IEEE 802.3bp[24] spezifiziert 1Gbit/s über eine einzelne, verdrillte Zweidrahtleitung für Automobil- und Industrieanwendungen. 1000BASE-T1[25] enthält Kabelspezifikationen für eine Reichweite von 15 Metern (Typ A) oder 40 Metern (Typ B). Die Übertragung erfolgt mit PAM-3 bei 750 MBd.

Glasfaser

- 1000BASE-SX, 1000BASE-LX, IEEE 802.3 Clause 38 (früher IEEE 802.3z) – 1 Gbit/s über Glasfaser. Die beiden Standards unterscheiden sich prinzipiell in der verwendeten Wellenlänge des optischen Infrarot-Lasers und der Art der Fasern: 1000BASE-SX verwendet kurzwelliges Licht mit 850 nm Wellenlänge und Multimode-Glasfasern, bei 1000BASE-LX strahlen die Laser langwelliges Licht mit 1310 nm Wellenlänge aus. Die Länge eines Glasfaserkabels muss mindestens 2 Meter betragen, die maximale Ausbreitung hängt von der Charakteristik der verwendeten Glasfaser ab. Multimode-Glasfaserkabel können je nach Faserquerschnitt und modaler Dämpfung zwischen 200 und 550 Meter erreichen, während 1000BASE-LX auf Singlemode-Glasfaserkabel bis 5 km spezifiziert sind.

- 1000BASE-LX10, manchmal auch 1000BASE-LH (LH steht für Long Haul) – Zum Einsatz kommen hierbei Singlemode-Glasfaserkabel mit einer maximalen Länge von 10 km. Die restlichen Eigenschaften gleichen denen von 1000BASE-LX.

- 1000BASE-BX10 verwendet eine einzige Singlemode-Faser mit bis zu 10 km Reichweite mit je Richtung verschiedenen Wellenlängen: downstream 1490 nm, upstream 1310 nm.

- 1000BASE-EX und -ZX sind keine IEEE-Standards – Zum Einsatz kommen Singlemode-Glasfaserkabel mit einer maximalen Länge von 40 km (-EX) bzw. 70 km (-ZX). Das verwendete Licht hat eine Wellenlänge von 1550 nm.

2,5- und 5-Gbit/s-Ethernet

2.5GBASE-T und 5GBASE-T, auch 2.5GbE und 5GbE abgekürzt und bisweilen zusammen NBASE-T[26] oder MGBASE-T[27] genannt, wird wie 1000BASE-T oder 10GBASE-T über Kupferkabel übertragen.[28]

Effektiv sind 2.5GBASE-T und 5GBASE-T herunterskalierte Versionen von 10GBASE-T mit 25 % und 50 % der Signalrate. Durch die niedrigeren Frequenzen ist es möglich, geringerwertiges Kabel als das für 10GBASE-T notwendige Cat6A zu verwenden.

Hierbei dient für 2.5G eine Verkabelung mindestens nach Cat5e und für 5G eine nach mindestens Cat6. Als IEEE 802.3bz offiziell verabschiedet, gab es bereits vorher Produkte von einigen Herstellern, darunter Broadcom, Intel und Marvell.[29][30][31]

10-Gbit/s-Ethernet

Der 10-Gbit/s-Ethernet-Standard (kurz: 10GbE, 10GigE oder 10GE) bringt zehn unterschiedliche Übertragungstechniken, acht für Glasfaserkabel und zwei für Kupferkabel mit sich. 10-Gbit/s-Ethernet wird für LAN, MAN und WAN verwendet. Der Standard für die Glasfaserübertragung heißt IEEE 802.3ae, die Standards für Kupfer sind IEEE 802.3ak und IEEE 802.3an.

Glasfaser

- Multimode

- 10GBASE-SR überbrückt kurze Strecken über Multimode-Fasern, dabei wird langwelliges Licht mit einer Wellenlänge von 850 nm verwendet. Die Reichweite ist dabei abhängig vom Kabeltyp, so reichen 62,5 µm „FDDI-grade“ Fasern bis zu 26 m,[32] 62,5-µm/OM1-Fasern bis zu 33 m weit,[32] 50 µm/OM2 bis zu 82 m und 50 µm/OM3 bis zu 300 m.[33]

- 10GBASE-LRM verwendet eine Wellenlänge von 1310 nm, um über alle klassischen Multimode-Fasern (62,5 µm Fiber „FDDI-grade“, 62,5 µm/OM1, 50 µm/OM2, 50 µm/OM3) eine Distanz von bis zu 220 m zu überbrücken.[32]

- 10GBASE-LX4 (Clause 53) nutzt Wellenlängenmultiplexing, um Reichweiten zwischen 240 m und 300 m über die Multimode-Fasern OM1, OM2 und OM3 oder 10 km über Singlemode-Faser zu ermöglichen.[33] Hierbei wird gleichzeitig auf den Wellenlängen 1275, 1300, 1325 und 1350 nm übertragen.

- Singlemode

- 10GBASE-LW4 überträgt mit Hilfe von Singlemode-Fasern Licht der Wellenlänge 1310 nm über Distanzen bis zu 10 km.

- 10GBASE-LR verwendet eine Wellenlänge von 1310 nm, um über Singlemode-Fasern eine Distanz von bis zu 10 km zu überbrücken.

- 10GBASE-ER benutzt wie 10GBASE-LR Singlemode-Fasern zur Übertragung, jedoch bei einer Wellenlänge von 1550 nm, was die Reichweite auf bis zu 40 km erhöht. Da 10GBASE-ER mit dieser Wellenlänge die seltene Eigenschaft besitzt, kompatibel zu CWDM-Infrastrukturen zu sein, vermeidet er den Austausch der bestehenden Technik durch DWDM-Optik.

- OC-192 – STM-64

- Die Standards 10GBASE-SW, 10GBASE-LW und 10GBASE-EW benutzen einen zusätzlichen WAN-Phy, um mit OC-192- (SONET) bzw. STM-64-Equipment (SDH) zusammenarbeiten zu können. Der Physical Layer entspricht dabei 10GBASE-SR bzw. 10GBASE-LR bzw. 10GBASE-ER, benutzen also auch die gleichen Fasertypen und erreichen die gleichen Reichweiten. Zu 10GBASE-LX4 gibt es keine entsprechende Variante mit zusätzlichem WAN-Phy.

Im LAN erreichen bedingt durch die Verfügbarkeit der Produkte die Standards 10GBASE-SR und 10GBASE-LR eine steigende Verbreitung.

Kupfer

Der Vorteil von Kupferverkabelung gegenüber Glasfasersystemen liegt in der schnelleren Konfektionierung und der unterschiedlichen Nutzbarkeit der Verkabelung (viele Anwendungen über ein Kabel). Darüber hinaus ist die Langlebigkeit von Kupfersystemen nach wie vor höher als bei Glasfasersystemen (Ausbrennen und Verschleiß der LEDs/Laser) und die Kosten bei zusätzlich notwendiger (teurer) Elektronik.

10GBASE-CX4

10GBASE-CX4 nutzt doppelt-twinaxiale Kupferkabel (wie InfiniBand), die eine maximale Länge von 15 m haben dürfen. Dieser Standard war lange der einzige für Kupferverkabelung mit 10 Gbit/s, verliert allerdings zunehmend an Bedeutung durch 10GBASE-T, das zu den langsameren Standards abwärtskompatibel ist und bereits vorhandene Verkabelung nutzen kann.

10GBASE-T

10GBASE-T verwendet wie schon 1000BASE-T vier Paare aus verdrillten Doppeladern. Die dafür verwendete strukturierte Verkabelung wird im globalen Standard ISO/IEC 11801 sowie in TIA-568A/B beschrieben. Die zulässige Linklänge ist vom eingesetzten Verkabelungstyp abhängig: Um die angestrebte Linklänge von 100 m zu erreichen, sind die Anforderungen von CAT-6a/7 zu erfüllen. Mit den für 1000BASE-T eingesetzten CAT-5-Kabeln (Cat-5e) ist nur die halbe Linklänge erreichbar. Der Standard ist in 802.3an beschrieben und wurde Mitte 2006 verabschiedet.

Bei der Übertragung wird der Datenstrom auf die vier Aderpaare aufgeteilt, so dass auf jedem Aderpaar jeweils 2,5 Gbit/s in Senderichtung und in Empfangsrichtung übertragen werden. Wie bei 1000BASE-T wird also jedes Aderpaar im Vollduplex-Betrieb genutzt. Zur Codierung werden die Modulationsverfahren 128-DSQ (eine Art doppeltes 64QAM) und schließlich PAM16 verwendet, wodurch die Nyquistfrequenz auf 417 MHz reduziert wird.[34]

Durch die hohe Signalrate mussten verschiedene Vorkehrungen getroffen werden, um die Übertragungssicherheit zu gewährleisten. Störungen innerhalb des Kabels werden passiv durch einen Kreuzsteg im Kabel vermindert, der für Abstand zwischen den Aderpaaren sorgt. Zusätzlich werden in den aktiven Komponenten digitale Signalprozessoren verwendet, um die Störungen herauszurechnen.

So genanntes Fremdübersprechen (Alien Crosstalk), also das Nebensprechen benachbarter, über längere Strecken eng gebündelter, ungeschirmter Kabel, kann auf diese Weise jedoch nicht verhindert werden. Deshalb sind in den Normen Kabel der Kategorie Cat 6A (Klasse EA) vorgesehen. Diese sind entweder geschirmt oder unterdrücken anderweitig (z. B. durch dickeren oder speziell geformten Mantel) das Fremdübersprechen ausreichend. Ungeschirmte Cat 6 Kabel (Klasse E) erreichen bei enger Bündelung (und nur dann)[35] nicht die üblichen 100 m Leitungslänge. Zum anderen ist ein Mindestabstand der Steckverbindungen zueinander einzuhalten.

10GBASE-T ist eingeschränkt auch über Cat 5e Kabel möglich, siehe Tabelle mit Leitungslängen. Eine Nachteil von 10GBASE-T ist der relativ hohe Stromverbrauch der Ports und Transceiver gegenüber Glasfaser. 10GBASE-T-SFP+-Module sind aufgrund des elektrischen Leistungsbedarfs nur für Kabellängen bis 30 m spezifiziert.

Converged 10 GbE

Converged 10 GbE ist ein Standard für Netzwerke, bei denen 10 GbE und 10 GbFC verschmolzen sind. Zum Converged-Ansatz gehört auch das neue Fibre Channel over Ethernet (FCoE). Das sind FC-Pakete, die in Ethernet gekapselt sind und für die dann ebenfalls die Converged Ethernet-Topologie genutzt werden kann; z. B. sind dann entsprechend aktualisierte Switches (wegen Paketgrößen) transparent für FC- und iSCSI-Storage sowie für das LAN nutzbar.

25-Gbit/s und 50-Gbit/s Ethernet

25 Gigabit (25GbE) und 50 Gigabit Ethernet (50GbE) wurden von einem Industriekonsortium zur Standardisierung vorgeschlagen[36] und von IEEE 802.3 in Form einer Study Group untersucht.[37]

25/50GbE sollen in Rechenzentren höhere Leistungen als 10GbE zu deutlich geringeren Kosten als 40GbE bereitstellen, indem Technologie verwendet wird, die bereits für diejenigen 100GbE-Varianten definiert wurde, die auf mehreren 25-Gbit/s-Lanes basieren (IEEE 802.3ba bzw. 802.3bj). Außerdem lassen sich 25/50-Gbit/s-Verbindungen direkt auf 100 Gbit/s skalieren. Zusätzlich könnte das höhere Fertigungsvolumen von 25-Gbit/s-Komponenten zu einem schnelleren Preisverfall im 100-Gbit/s-Bereich führen.

Übertragungsbandbreite bei 25GBASE-T (IEEE 802.3bq) ist 1000 MHz, wodurch Cat-8 Verkabelung benötigt wird.[38]

Relevante Reichweiten aus der 802.3by:

- 25GBASE-CR (2 Leitungen eines geschirmten Twinax-Kupferkabels) mindestens 5 m

- 25GBASE-CR-S (1 Leitungen eines geschirmten Twinax-Kupferkabels) mindestens 3 m

- 25GBASE-SR (1 OM4-Glasfaser, multimode) 100 m

- 25GBASE-LR (1 OS2-Glasfaser, singlemode) 10 km

- 25GBASE-ER (1 OS2-Glasfaser) 40 km

- 25GBASE-T (Category-7a Twisted Pair) 30 m, Bandbreite 1000 MHz

- 50GBASE-CR (1 Leitungen eines geschirmten Twinax-Kupferkabels) mindestens 3 m

- 50GBASE-SR (2 OM4-Glasfasern, multimode) 100 m

- 50GBASE-FR (2 OS2-Glasfasern, singlemode) 2 km

- 50GBASE-LR (2 OS2-Glasfasern, singlemode) 10 km

- 50GBASE-ER (2 OS2-Glasfasern) 40 km

40-Gbit/s und 100-Gbit/s Ethernet

Die schnellste Variante für Twisted-Pair-Kabel unterstützt 40 Gbit/s, außerdem gibt es 40 und 100 Gbit/s sowohl über Kupferkabel (Twinax) als auch über Glasfaserkabel (single- und multimode). Die Angaben entstammen der Spezifikation 802.3ba-2010[39] des IEEE und definieren folgende Reichweiten (Leitungen je Richtung):

- 40GBASE-KR4 40 Gbit/s (40GBASE-R mit 4 Leitungen einer Backplane) mindestens 1 m

- 40GBASE-CR4 40 Gbit/s (40GBASE-R mit 4 Leitungen eines geschirmten Twinax-Kupferkabels) mindestens 7 m

- 40GBASE-T 40 Gbit/s (Category-8 Twisted Pair) mindestens 30 m, benötigt Kategorie-8-Kabel,[40] Bandbreite 2000 MHz[38]

- 40GBASE-SR4 40 Gbit/s (40GBASE-R mit 4 OM3-Glasfasern, multimode) mindestens 100 m

- 40GBASE-LR4 40 Gbit/s (40GBASE-R mit 1 OS2-Glasfaser und vier Farben/Wellenlängen, singlemode, CWDM) mindestens 10 km

- 100GBASE-CR10 100 Gbit/s (100GBASE-R mit 10 Leitungen eines geschirmten Twinax-Kupferkabels) mindestens 7 m

- 100GBASE-SR10 100 Gbit/s (100GBASE-R mit 10 OM3-Glasfasern, multimode) mindestens 100 m

- 100GBASE-SR4 100 Gbit/s (100GBASE-R mit 4 OM4-Glasfasern, multimode) mindestens 100 m (IEEE 802.3bm)

- 100GBASE-LR4 100 Gbit/s (100GBASE-R mit 1 OS2-Glasfaser und vier Farben, singlemode) mindestens 10 km

- 100GBASE-ER4 100 Gbit/s (100GBASE-R mit 1 OS2-Glasfaser und vier Farben, singlemode) mindestens 40 km

200-Gbit/s- und 400-Gbit/s-Ethernet

Geschwindigkeiten und erwartete Standards schneller als 100 Gbit/s werden manchmal auch als Terabit Ethernet bezeichnet.

Im März 2013 begann die IEEE 802.3 400 Gb/s Ethernet Study Group mit der Arbeit an der nächsten Generation mit 400 Gbit/s,[41] im März 2014 wurde die IEEE 802.3bs 400 Gb/s Ethernet Task Force gebildet. Im Januar 2016 wurde als zusätzliches Entwicklungsziel 200 Gbit/s hinzugefügt. Die neuen Standards wurden im Dezember 2017 veröffentlicht:[42]

- 200 Gbit/s

- 200GBASE-DR4 (Clause 121): 500 m über je vier Singlemodefasern

- 200GBASE-FR4 (Clause 122): 2 km über Singlemodefaser, je vier Wellenlängen/Farben (CWDM)

- 200GBASE-LR4 (Clause 122): 10 km über Singlemodefaser, je vier Wellenlängen/Farben (CWDM)

- 400 Gbit/s

- 400GBASE-FR8 (Clause 122): 2 km über Singlemodefaser, je acht Wellenlängen/Farben (CWDM)

- 400GBASE-LR8 (Clause 122): 10 km über Singlemodefaser, je acht Wellenlängen/Farben (CWDM)

- 400GBASE-SR16 (Clause 123): 70 m (OM3) oder 100 m (OM4) über je 16 Multimodefasern

- 400GBASE-DR4 (Clause 124): 500 m über je vier Singlemodefasern

800-Gbit/s-Ethernet

Ein PHY-loses 800-Gbit/s-Ethernet wurde im Oktober 2020 in einem Standard des Ethernet Technology Consortiums spezifiziert.[43] Dabei handelt es sich um einen Zusammenschluss aus zwei existierenden 400-Gigabit-Verbindungen auf dem Physical Layer zu einem MAC (OSI-Layer 2). Dieser kann einen physikalischen Endpunkt identifizieren. Hierfür werden acht 106,25-Gbit/s-Lanes im Vollduplex-Modus verwendet. Die im 64/66b-Verfahren codierten Daten werden dabei abwechselnd über einen der beiden 400-Gigabit-Physical Coding Sublayer gesendet. Der Internetknoten DE-CIX führte 800-Gbit/s-Ethernet im Oktober 2022 für seine Kunden ein.[44]

Ethernet mit 800 Gbit/s und 1,6 Terabit/s werden von IEEE 802.3 in der 802.3df-Taskforce entwickelt.[45] Standards werden für Mitte 2024 erwartet.[46]

Kabellängen

| Kabelkategorie | Übertragungs- klasse (nach ISO/EN) | Standard | Linklänge | Übertragungs- frequenz | Kabel genormt bis (nach TIA/EIA 568 und EN 50288) |

|---|---|---|---|---|---|

| Cat-3 | Klasse C | 10BASE-T, 100BASE-VG | 100 m | 2 × 10 MHz | 16 MHz |

| Cat-5 | – | 100BASE-TX | 2 × 31,25 MHz | 100 MHz | |

| Cat-5 | – | 1000BASE-T | 4 × 62,5 MHz | 100 MHz | |

| Cat-5e | Klasse D | 100 MHz | |||

| Cat-5e, ungeschirmt | 10GBASE-T | *) 45…? m | 4 × 417 MHz | 100 MHz | |

| Cat-5e, geschirmt | über 45 m | 100 MHz | |||

| Cat-6, ungeschirmt | Klasse E | *) 55…100 m | 250 MHz | ||

| Cat-6, geschirmt | |||||

| Cat-6A | Klasse EA | 100 m | 500 MHz | ||

| Cat-7 | Klasse F | 600 MHz | |||

| Cat-7a | 1000 MHz | ||||

| Cat-8.1 | Klasse 1 | 40GBASE-T | 30 m | 1600 MHz | |

| Cat-8.2 | Klasse 2 | ||||

Die zulässige Gesamtlänge der Übertragungsstrecke beträgt in der Regel 100 m. Darin enthalten sind:

- 90 m Installationskabel

- 10 m Patchkabel (2 × 5 m)

- 2 Steckverbindungen (z. B. Dose und Patchfeld)

Patchkabel haben schlechtere Übertragungseigenschaften. Sind die Patchkabel länger als 10 m, reduziert sich für jeden Meter Überschreitung die zulässige Länge des Installationskabels um jeweils 1,5 m.

Besteht die Strecke nur aus Patchkabeln, ist die zulässige Regellänge ca. 70 m.

Wenn nicht anders angegeben, gelten die Längen für geschirmte und ungeschirmte Kabel gleichermaßen.

Die Werte für 10-Gbit/s-Ethernet entsprechen IEE 802.3-2008, Tabelle 55-13.

*) Reduzierte Längen bei 10 Gbit/s ergeben sich durch Fremdübersprechen zwischen mehreren Kabeln und gelten nur ungeschirmt bei enger Bündelung über viele Meter Länge.

Der Wert für 10 Gbit/s über Cat 5e wurde in einem Entwurf vorgeschlagen,[47] aber nicht in die endgültige IEEE 802.3 Norm übernommen. Allerdings bestätigen zahlreiche Hardwarehersteller die Funktion über 45 m Cat 5e UTP.[48]

Geschirmtes CAT 5e ist außerhalb von Europa ungebräuchlich und wurde von dem US-dominierten Gremium nicht getestet. Es ergeben sich dafür erheblich größere Längen, weil der längenbegrenzende Parameter das Fremdübersprechen ist. Geschirmte Kabel sind davon jedoch praktisch nicht betroffen.

| Geschwindigkeit | Verkabelung | Entfernung (max) |

|---|---|---|

| 10 Mbit/s 10BASE-FL/-FB | OM1 LWL-Multimode 62,5/125 µm | 2000 m |

| 100 Mbit/s 100BASE-FX | OM1/OM2 LWL-Multimode 62,5/125 µm / 50/125 µm HDX | 412 m |

| OM1/OM2 LWL-Multimode 62,5 µm / 50 µm FDX | 2000 m | |

| 1 Gbit/s 1000BASE-SX | OM1 LWL-Multimode 62,5/125 µm | 220 m |

| OM2 LWL-Multimode 50/125 µm | 550 m | |

| OM3 LWL-Multimode 50/125 µm | >550 m | |

| 10 Gbit/s 10GBASE-SR | OM1 LWL-Multimode 62,5/125 µm | 26 m |

| OM2 LWL-Multimode 50/125 µm | 82 m | |

| OM3 LWL-Multimode 50/125 µm | 300 m | |

| 10 Gbit/s 10GBASE-LRM | OM1/2/3 LWL-Multimode 62,5/125 µm / 50/125 µm | 220 m |

| Geschwindigkeit | Verkabelung | Entfernung (max) |

|---|---|---|

| 10 Gbit/s 10GBASE-LR | LWL-Singlemode 8–10 µm | OS2: 10 km |

| 10 Gbit/s 10GBASE-ER | LWL-Singlemode 8–10 µm | OS2: 30–40 km |

| 10 Gbit/s 10GBASE-ZR (nicht IEEE 802.3) | LWL-Singlemode 8–10 µm | 80 km |

8P8C-Stecker für Ethernet

- Token Ring Adernpaar 1 und 3

- 10BASE-T Adernpaar 2 und 3

- 100BASE-TX Adernpaar 2 und 3

- 100BASE-T4 Adernpaar 1, 2, 3 und 4

- 100BASE-VG (VG-AnyLAN) Adernpaar 1, 2, 3 und 4

Belegung und Kabel-Farbcode für 8P8C-Stecker

| Adernpaar | Pins | EIA/TIA-568A | IEC | REA | DIN 47.100 |

|---|---|---|---|---|---|

| 1 | 4/5 | blau/weiß | weiß/blau | weiß/blau | weiß/braun |

| 2 | 3/6 | weiß/orange | rot/orange | türkis/violett | grün/gelb |

| 3 | 1/2 | weiß/grün | schwarz/grün | weiß/orange | grau/rosa |

| 4 | 7/8 | weiß/braun | gelb/braun | türkis/violett | blau/rot |

Belegung 8P8C-Stecker nach EIA/TIA-568B

| Signal | Pin | Farbe |

|---|---|---|

| TX+ | 1 | weiß/orange |

| TX- | 2 | orange |

| RX+ | 3 | weiß/grün |

| 4 | blau | |

| 5 | weiß/blau | |

| RX- | 6 | grün |

| 7 | weiß/braun | |

| 8 | braun |

Metro-Ethernet-Netze (MEN) sind ethernetbasierte Metropolitan-Area-Netze (MAN), die auf Carriergrade-Ethernet basieren. Nachdem mit der Einführung ausgefeilter Glasfasertechniken die Längenbeschränkungen für Ethernet-Netze praktisch aufgehoben sind, gewinnt Ethernet auch bei Weitverkehrsnetzen wie den MAN an Bedeutung. MANs basieren vor allem auf Kundenseite auf kostengünstiger bekannter Technik und garantieren eine vergleichsweise hohe Effizienz bei geringer Komplexität.

Ebenfalls zur Familie der Ethernet-Standards gehört IEEE 802.3af (IEEE 802.3 Clause 33). Das Verfahren beschreibt, wie sich Ethernet-fähige Geräte über das Twisted-Pair-Kabel mit Energie versorgen lassen. Dabei werden entweder die ungenutzten Adern der Leitung verwendet, oder es wird zusätzlich zum Datensignal ein Gleichstromanteil über die vier verwendeten Adern übertragen. Eine Logik stellt sicher, dass nur PoE-fähige Geräte mit Energie versorgt werden. Gemäß 802.3af werden entsprechend ausgelegte Geräte mit 48 V und bis zu 15,4 Watt versorgt. Bis zu 30 W bei 54 V erreicht der Ende 2009 ratifizierte Standard 802.3at oder PoE+. 2018 wurde die dritte Generation 4PPoE als 802.3bt verabschiedet, die über alle vier Leitungspaare Geräte mit bis zu 100 W versorgen kann.

Folgende Netzwerkstandards gehören nicht zum IEEE-802.3-Ethernet-Standard, unterstützen aber das Ethernet-Datenblockformat und können mit Ethernet zusammenarbeiten:

- WLAN (IEEE 802.11) – Eine Technik zur drahtlosen Vernetzung per Funktechnik auf kurzen Strecken (Distanzen sind von den örtlichen Gegebenheiten abhängig und vergleichbar mit LAN), anfänglich mit Übertragungsraten ab 1 Mbit/s, aktuell (2010) mit bis zu 600 Mbit/s.[49]

- VG-AnyLan (IEEE 802.12) oder 100BASE-VG – Ein früher Konkurrent zu 100-Mbit/s-Ethernet und 100-Mbit/s-TokenRing. Ein Verfahren, das Multimedia-Erweiterungen besitzt und beispielsweise wie FDDI garantierte Bandbreiten kennt, es basiert auf einem Demand Priority genannten Zugriffsverfahren (Demand Priority Access Methode, kollisionsfrei, alle Zugriffe werden priorisiert vom Hub/Repeater zentral gesteuert), womit die Nachteile von CSMA eliminiert werden. 100BASE-VG läuft auch über Kategorie-3-Kabel, benutzt dabei aber vier Aderpaare. Federführend bei der Entwicklung waren Hewlett-Packard und AT&T beteiligt, kommerziell war VG-AnyLan ein Fehlschlag.

- TIA 100BASE-SX – Von der Telecommunications Industry Association geförderter Standard. 100BASE-SX ist eine alternative Implementation von 100-Mbit/s-Ethernet über Glasfaser und ist inkompatibel mit dem offiziellen 100BASE-FX-Standard. Eine hervorstehende Eigenschaft ist die mögliche Interoperabilität mit 10BASE-FL, da es Autonegotiation zwischen 10 Mbit/s und 100 Mbit/s beherrscht. Die offiziellen Standards können das aufgrund unterschiedlicher Wellenlängen der verwendeten LEDs nicht. Zielgruppe sind Organisationen mit einer bereits installierten 10-Mbit/s-Glasfaser-Basis.

- TIA 1000BASE-TX stammt ebenfalls von der Telecommunications Industry Association. Der Standard war ein kommerzieller Fehlschlag, und es existieren keine Produkte, die ihn umsetzen. 1000BASE-TX benutzt ein einfacheres Protokoll als der offizielle 1000BASE-T-Standard, benötigt aber Cat-6-Kabel (Gegner behaupten, dieser primär von der Kabelindustrie geförderte Standard sei gar nicht zur Produktentwicklung gedacht gewesen, sondern ausschließlich dafür, um eine erste Anwendung für diese bis dahin mit keinerlei Vorteilen gegenüber Cat-5 ausgestattete Kabelklasse vorweisen zu können).

- InfiniBand ist ein bereits seit 1999 spezifiziertes schnelles Hochleistungsverfahren zur Überbrückung kurzer Strecken (über Kupferkabel bis zu 15 m). Es nutzt bidirektionale Punkt-zu-Punkt-Verbindungen zur kostengünstigen und latenzarmen Datenübertragung (unter 2 µs) und schafft pro Kanal theoretische Datenübertragungsraten von bis zu 2,5 Gbit/s in beide Richtungen und in der neueren DDR-Variante 5 Gbit/s. Bei InfiniBand können mehrere Kanäle transparent gebündelt werden, wobei dann ein gemeinsames Kabel verwendet wird. Üblich sind vier Kanäle (4×), also 10 Gbit/s bzw. 20 Gbit/s. Haupteinsatzgebiet sind Supercomputer (HPC-Cluster), wie sie auch in der TOP500-Liste zu finden sind.

- Patchkabel

- Media Independent Interface, Teilkomponente in einem Fast-Ethernet-Chipsatz.

- 5-4-3-Regel, Verschaltungsregel in einer Ethernet-Baumtopologie.

- Fibre Channel over Ethernet, Übertragungsprotokoll für Fibre-Channel-Rahmen.

- PHY (physikalische Schnittstelle), Schaltkreis zur Datencodierung zwischen digitalen und analogen Systemen.

- TIA-568A/B, Standards für die Kontaktierung von RJ-45-Steckern und -Buchsen.

- RJ45/48, genormte Stecker und Buchsen für Telekommunikationskabel.

- GG-45, Stecker und Buchs für Telekommunikationskabel für höheren Übertragungsgeschwindigkeit wie cat-8, cat-8.1 und cat-8.2.

- BroadR-Reach, ein Ethernet-Physical-Layer-Standard für Connectivity-Anwendungen im Automobilbereich.

- Charles E. Spurgeon: Ethernet. The Definitive Guide. O’Reilly, Sebastopol CA 2000, ISBN 1-56592-660-9.

- Alexis Ferrero: The evolving Ethernet. ISBN 0-201-87726-0.

- Frank R. Walther: Networkers Guide. Pearson / Markt+Technik, 2003, ISBN 3-8272-6502-9.

- Jörg Rech: Ethernet. Technologien und Protokolle für die Computervernetzung. ISBN 3-88229-186-9.

- Michael Reisner: Ethernet. Das Grundlagenbuch. ISBN 3-7723-6670-8.

- Andrew S. Tanenbaum: Computernetzwerke. Pearson Studium, München 2012, ISBN 978-3-86894-137-1.

- Wolfgang Kemmler, Mathias Hein: Gigabit-Ethernet; Der Standard – die Praxis. FOSSIL-Verlag, 1998, ISBN 3-931959-10-4.

Commons: Ethernet – Sammlung von Bildern, Videos und Audiodateien

- Moderne LANs: IEEE 802.3ab 1000 BASE-T

- Ethernet-Paketformate

- Jürgen Plate: Grundlagen Computernetze. FH München

- Charles Spurgeon’s Ethernet Web Site (englisch)

- Projektseite der IEEE 802.3 Working Group (englisch)

- Ethernet-Standards als PDF auf der IEEE-Download-Seite (englisch)

- 10-Gigabit-Ethernet führt iSCSI und Fibre Channel zusammen

- W. Schulte: Metro- / Carrier Ethernet (PDF; 709 kB) DHBW Stuttgart. In: Funkschau, 16, S. 14

Wikiwand in your browser!

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.