Loading AI tools

Filosofin kring artificiell intelligens (förenklat: AI-filosofi) försöker besvara sådana frågor som följer:[1]

- Kan en maskin agera intelligent? Kan den lösa eventuella problem som en person skulle lösa genom att tänka?

- Är mänsklig intelligens och maskinell intelligens samma sak? Är den mänskliga hjärnan i huvudsak en dator?

- Kan en maskin har ett sinne, mentala tillstånd och ett medvetande på samma sätt som en människa kan? Kan den känna saker?

Dessa tre frågor återspeglar de olika intressena hos AI-forskare, lingvister, kognitiva forskare resp. filosofer. De vetenskapliga svaren på dessa frågor beror på definitionen av "intelligens" och "medvetande" samt exakt vilka "maskiner" som diskuteras.

Viktiga förslag inom AI-filosofin är:

- Turingtestet: Om en maskin beter sig så intelligent som en människa, så är den lika intelligent som en människa[2]

- Dartmouthförslaget: Varje aspekt av lärande eller någon annan egenskap hos intelligens kan beskrivas så exakt att en maskin kan tillverkas för att simulera det[3]

- Newells och Simons hypotes om fysiska symbolsystem: Ett fysiskt symbolsystem har nödvändiga och tillräckliga medel för allmänt intelligenta handlingar[4]

- Searles starka AI-hypotes: Den ändamålsmässigt programmerade datorn med rätt in- och utdata skulle kunna ha ett sinne i exakt samma mening som människor har sinnen[5]

- Hobbes mekanism: Orsak är inget annat en beräkning[6]

Är det möjligt att skapa en maskin som kan lösa alla problem som människor löser genom att använda sin intelligens? Denna fråga definierar omfattningen av vad maskiner kommer att kunna göra i framtiden och styr riktningen i AI-forskningen. Den handlar emellertid endast om maskinernas beteende och ignorerar frågor av intresse för psykologer, kognitiva vetenskapsmän och filosofer; för att besvara denna fråga, spelar det ingen roll om en maskin egentligen tänker (som en person) eller bara agerar som om den tänker.[7]

Den grundläggande ståndpunkten hos de flesta AI-forskarna sammanfattas i följande uttalande, som dök upp i förslaget till Dartmouth-konferensen 1956:

- Varje aspekt av lärande eller någon annan egenskap hos intelligens kan beskrivas så exakt att en maskin kan tillverkas för att simulera det[3]

Argument mot denna grundläggande premiss måste visa att det är omöjligt att bygga ett fungerande AI-system, eftersom det inte finns någon praktisk gräns för förmågan hos datorer samt att det inte finns någon speciell kvalitet hos det mänskliga sinnet som är nödvändig för att tänka, som ännu inte kan dupliceras av en maskin (eller med den nuvarande AI-forskningens metoder). Argument för premissen måste visa att ett sådant system är möjligt.

Det första steget för att besvara frågan är att tydligt definiera "intelligens".

Intelligens

Turingtestet

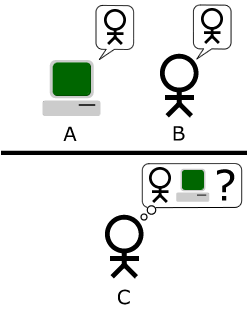

Alan Turing, i sitt berömda och inflytelserika verk Computing Machinery and Intelligence från 1950,[9] reducerade problemet med att definiera intelligens till en enkel fråga om konversation. Han föreslår att: om en maskin kan svara på varje fråga som ställs till den, med samma ord som en vanlig människa skulle, kan denna maskin betraktas som intelligent. En modern version av hans experimentella formgivning skulle kunna utgöras av ett onlinechattrum, där en av deltagarna är en verklig person och en av deltagarna är ett datorprogram. Programmet klarar provet om ingen kan säga vilken av de två deltagarna som är en människa.

- Om en maskin beter sig så intelligent som en människa, så är den lika intelligent som en människa

En kritik av Turingtestet är att det är uttryckligen antropomorft. Om vårt yttersta mål är att skapa maskiner som mer intelligenta än människor, varför bör vi insistera på att våra maskiner måste likna människor? Russell och Norvig skriver att "texter om flygteknik definierar inte att områdets mål är att 'göra maskiner som kan flyga så precist som duvor så att de kan lura andra duvor'".[10]

Definition som intelligenta agenter

Den senaste AI-forskningen definierar intelligens i form av intelligenta agenter. En "agent" är något som uppfattar och agerar i en miljö. Ett "prestationsmått" definierar vad som räknas som framgång för agenten.[11]

- Om en agent agerar för att maximera det förväntade värdet av ett prestationsmått baserat på tidigare erfarenheter och kunskap är den intelligent[12]

Definitioner som denna försöker fånga essensen av intelligens. De har den fördelen att de, till skillnad från Turingtestet, inte också testar för mänskliga egenskaper som vi kanske inte vill betrakta som intelligenta, såsom förmågan att bli förolämpad eller frestelsen att ljuga. De har den nackdelen att de misslyckas med differentiering mellan "saker som tänker" och "saker som inte tänker" baserat på sunt förnuft. Med denna definition, har även en termostat en rudimentär intelligens.[13]

Wikiwand in your browser!

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.