Méthode d'apprentissage cognitif

De Wikipédia, l'encyclopédie libre

La méthode générale d'apprentissage cognitif s'est peu à peu dégagée des travaux de pédagogues[1] qui remettaient en cause les méthodes d'enseignement traditionnelles, prônaient la participation active et l'implication des participants, ainsi que des approches pédagogiques de psychosociologues comme Abraham Maslow, Carl Rogers ou Harold J. Leavitt.

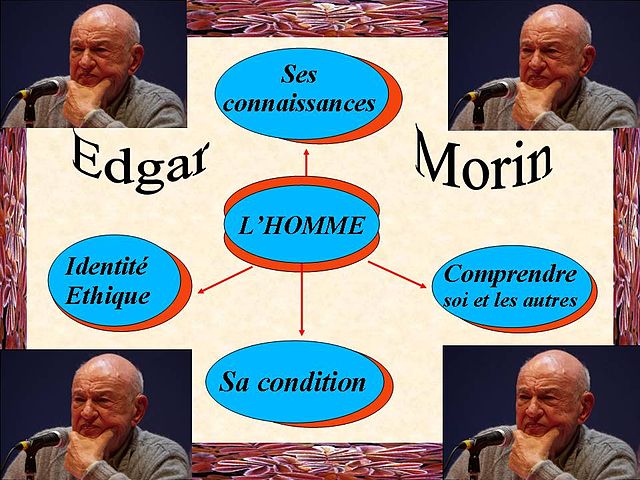

La perspective cognitiviste, qui renvoie au terme cognition, c'est-à-dire connaissance dans le sens de processus et de produit, privilégie une approche fonctionnelle d'utilisation des facultés mentales et des connaissances déjà acquises, liées aux stratégies d'assimilation de ces savoirs, au sens large du terme (du savoir pur au savoir-être). À partir de ces convergences historiques, la Méthode d'Apprentissage Cognitif s'est surtout développée à partir des travaux du psychologue américain Robert Mills Gagné et du sociologue français Edgar Morin avec son livre Sept savoirs nécessaires à l’éducation du futur.

L'introduction en France en 1986 de la méthode d'apprentissage par l'expérience (Experiential Learning/Outdoor Education), à partir des travaux et de l'action d'Alain Kerjean relève également de ce courant.

Les bases théoriques

Résumé

Contexte

La Pédagogie

Les apports de la pédagogie Freinet et de ses successeurs de Paulo Freire à Philippe Meirieu

Célestin Freinet a été l'un des premiers à mettre en cause le rapport traditionnel d'autorité maître-élève. Il considère l'élève comme un apprenant ayant une certaine autonomie et que la favoriser, c'est par là même favoriser son apprentissage. Il a écrit dans Les invariants pédagogiques en 1964 : « Les acquisitions ne se font pas comme l’on croit parfois, par l’étude des règles et des lois, mais par l’expérience. Étudier d’abord ces règles et ces lois, en français, en art, en mathématiques, en sciences, c’est placer la charrue devant les bœufs. »

Cette façon d'enseigner rejoint l'idée que se faisait un homme comme Socrate qui stimulait l'interaction de l'élève avec son professeur à partir une méthode qu'il avait appelé la Maïeutique. Ce sont la réflexion et les interactions qui stimulent le savoir, l'élève n'est pas seulement une machine à emmagasiner des connaissances, il devient sujet agissant et pas seulement objet d'une connaissance à intégrer.

Ces conceptions ont été largement reprises dans les formations mises en place pour les adultes où le rapport d'autorité est encore différent entre professeurs et adultes apprenants qui ont leur propre expérience.

Pour Philippe Meirieu, l'enseignant n'est pas seulement un transmetteur de connaissances, c'est un éducateur qui doit aussi transmettre des normes sociales et permettre ainsi aux individus à penser par lui-même et de manière critique. Il insiste sur la motivation nécessaire des apprenants, même s'il est parfois difficile de concilier leurs intérêts et leurs centres d'intérêt. Pour dépasser cette contradiction, il préconise d'avoir une attitude positive envers l'apprenant -empathique dirait Carl Rogers- afin de le mettre en confiance et de respecter sa liberté afin qu'il puisse mieux se prendre en charge[2]. Le groupe ainsi formé devient un réseau plus coopératif qui permet de compenser les difficultés liées à son hétérogénéité. (Ce qu'il nomme la Pédagogie différenciée)

Par ailleurs, on considère que la méthode d'apprentissage par l'expérience est le prolongement moderne des idées de Montaigne, Comenius, Locke, Rousseau et du mouvement des Ecoles nouvelles, avec par exemple Freinet en France, Maria Montessori en Italie ou John Dewey aux Etats-Unis. C'est le pédagogue allemand Kurt Hahn, réfugié en Grande-Bretagne en 1934, qui en posa les bases modernes avec les écoles Gordonstoun et Outward Bound. Devenu international, le courant Experiential Learning fut introduit en France en 1986 à l'initiative d' Alain Kerjean. L’on retrouve dans ce modèle les théories de Kurt Lewin (le processus de feedback), de Jean Piaget (interaction par accommodation puis assimilation) et de Carl Gustav Jung (interaction par introversion et extraversion).

La psychosociologie

- Plusieurs psychosociologues ont largement influencé dans leur domaine de connaissances, l'évolution de cette méthode, et en premier lieu Abraham Maslow avec la hiérarchie des besoins, la théorie de la motivation et les différents niveaux qu'elle peut revêtir.

- Le psychologue humaniste américain Carl Rogers s'adresse d'abord aux thérapeutes et aux enseignants en définissant l'attitude idéale à atteindre pour être en phase avec ses interlocuteurs : il faut avant tout se placer sur le même canal psychologique pour établir un véritable dialogue, ce que Rogers appelle la congruence. Ceci implique une relation étroite entre expérience acquise et prise de conscience de la situation relationnelle et d'accepter l'autre tel qu'il est et non comme on voudrait qu'il soit, ne pas lui prêter ses propres sentiments (et éviter ainsi toute projection).

D'un point de vue pratique, il faut utiliser un langage et être en adéquation avec l'autre, ce que Rogers appelle avoir un attitude empathique et laisser le dialogue s'instaurer peu à peu par une mise en confiance, en choisissant son langage, ses mots et ses expressions : c'est privilégier une attitude non-directive. On utilise aussi assez souvent une technique qui inclut la non directivité 'rodgérienne', qui s'appelle l'Entretien semi directif.

Pédagogie active et apprentissage cognitif

Résumé

Contexte

La Psychopédagogie

- Les travaux de Roger Mucchielli : ce psychopédagogue français, continuateur en France de l'école de Palo-Alto, a largement contribué à divulguer les idées des grands psychosociologues américains dans ses ouvrages pédagogiques parus chez ESF éditeur, parmi lesquels :

- L'entretien de face dans la relation d'aide sur la pensée de Carl Rogers;

- Communication et réseaux de communication sur la pensée d'Abraham Maslow;

- Attitudes et comportements sur la pensée de Bavelas et Harold J. Leavitt

- La dynamique de groupe à partir des travaux de Kurt Lewin,

- Les méthodes actives dans la pédagogie des adultes et La méthode des cas en matière de pédagogie active.

- L'apport de Robert Mills Gagné : Il a déterminé une hiérarchie des types d'apprentissage, impliquant des prérequis pour passer d'un niveau à un autre. Il distingue plusieurs niveaux, tout d'abord posséder les acquis moteur et le langage adéquat, puis maîtriser les concepts et savoir résoudre des problèmes de plus en plus complexes. Ce qui est important pour lui, c'est : définir précisément les prérequis et l'apprentissage préalable, les objectifs concrets à atteindre, le contenu précis des matières et des domaines à enseigner avec les étapes de progression, un suivi des comportements d'auto organisation.

Enseignement et éducation

Qui est lui-même source de pouvoir. »

- Les types d'objectifs de formation

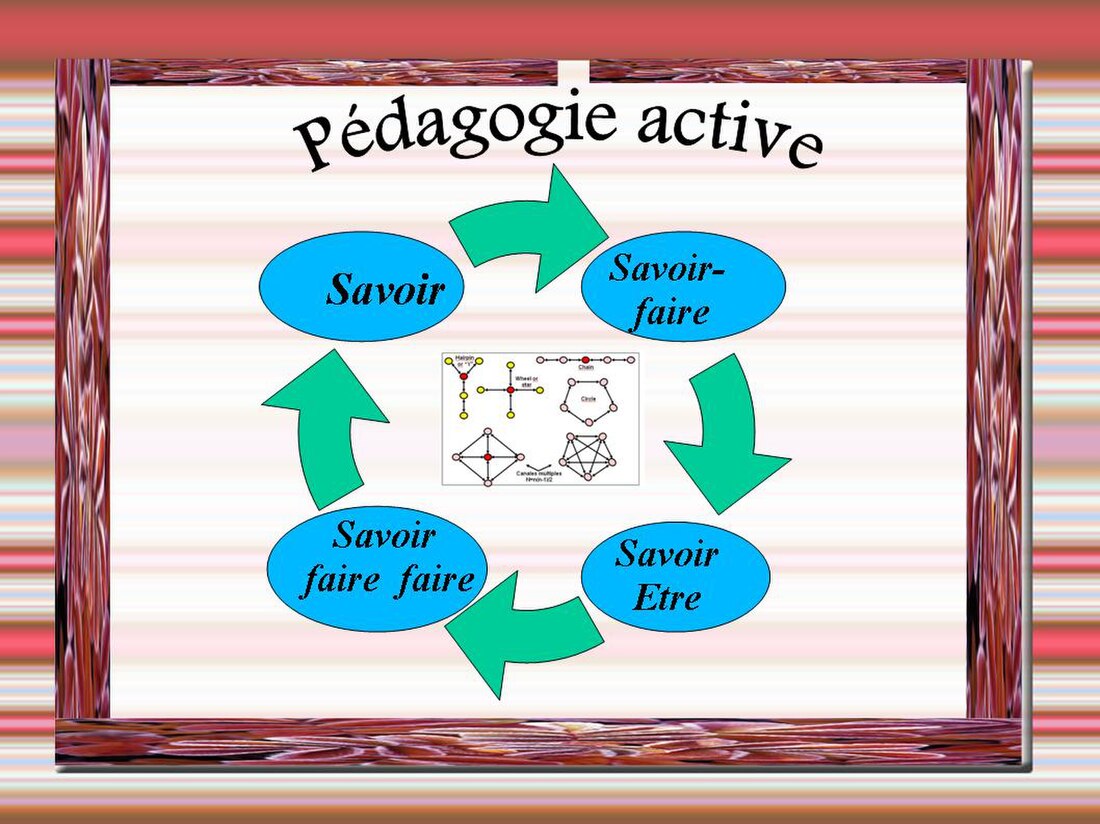

- du savoir au savoir-être

- Le Savoir renvoie à l'enseignement de matières qui demandent une base pratique, factuelle, Gagné parle de "concept concret" en général relativement facile à définir et à circonscrire;

- Le savoir-faire demande d'acquérir des bases fonctionnelles et conceptuelles pour être capable d'appliquer des connaissances dans des situations variées faisant appel à un large panel de savoirs acquis parfois dans d'autres situations;

- Le Savoir faire faire demande d'acquérir des mécanismes, d'avoir assez de recul pour "se mettre à la place de l'autre", mieux comprendre ses enjeux et l'aider efficacement;

- Le Savoir-être demande d'acquérir des comportements adaptés à une situation donnée, une 'distanciation' d'avec soi-même pour dominer ses réactions émotionnelles au profit des objectifs à atteindre.

Chacun de ces niveaux demande une bonne maîtrise du ou des niveaux précédents pour parvenir à une maîtrise complète de la chaîne dans le savoir-être. Cependant, la somme des compétences requises n'est pas forcément de même nature : le savoir-être pour diriger une équipe d'analystes-programmeurs par exemple ne nécessite pas de connaître les langages informatiques utilisés par l'équipe. En revanche, il faut aussi aux analystes-programmes un minimum de savoir-être pour travailler efficacement en équipe. Il existe donc un équilibre à respecter, un "dosage" subtil à définir dans les niveaux de compétence nécessaire à telle tâche.

- L'apprentissage stratégique et cognitif

- Ses principes de base reposent sur des participants actifs et motivés, un processus continu d'appropriation de toutes les formes de connaissances ainsi que la définition de stratégies de formation.

- La conception de l'enseignement suppose le respect des principes de base (contrôlé tout au long du processus), l'organisation des connaissances et l'utilisation de stratégies cognitives. Elle nécessite d'instaurer des situations d'apprentissage avec exécution de tâches complexes, résolution de problèmes, etc.

- L'enseignant doit intervenir à tous les niveaux. Il a un triple activité :

- Un rôle de concepteur et de gestionnaire;

- Un rôle d'entraîneur, vérifiant constamment la motivation du groupe et de tel ou tel de ses membres;

- Un rôle de médiateur entre le contenu de la formation et les participants.

Disciplines utilisées et méthodes d'apprentissage

Résumé

Contexte

Une approche dynamique de la pédagogie

- L'apprentissage par la reproduction et le passage au concret

L'approche éthologique[3] aussi bien que les expériences effectuées avec de jeunes enfants nous ont appris que le premier apprentissage s'opérait par reproduction, copie des gestes, des attitudes et des comportements d'un adulte que l'apprenant prend pour modèle[4].

Il est donc primordial dans toute situation d'apprentissage de concrétiser d'une façon ou d'une autre ce que l'apprenant doit comprendre ou intérioriser. Ceci est d'autant plus vrai que les mécanismes d'acquisition sont différents d'un individu à un autre, que certains sont plus réceptifs aux aspects concrets, que d'autres éprouvent beaucoup de difficultés à s'adonner à l'abstraction, à réfléchir uniquement sur des concepts.

Dans ce cadre, on peut affirmer qu'il n'existe pas d'approche univoque en pédagogie, qu'elle doit être adaptée à la population, au groupe tel qu'il est constitué et peut varier d'une année à l'autre. Piaget entre autres, a constaté des réactions différentes, des taux de réussite différents d'un groupe à un autre sur un même sujet. Par contre, l'apprentissage est en lui-même un facteur de réussite, l'apprenant ayant tendance sur une série d'exercices identiques (quant au niveau de compétence exigé) à "apprendre", c'est-à-dire à corriger lui-même ses erreurs antérieures. C'est ce qu'on appelle "la boucle rétroactive" (ou feed-back) qui initie les ajustements nécessaires à la correction. L'enseignant doit s'assurer que cet outil est systématiquement utilisé, y compris dans des situations variables, et que la mémorisation s'effectue dans de bonnes conditions.

- Les apports de la psychosociologie

Le recours à la dynamique de groupe : Bien que cette technique soit plutôt réservée aux "groupes de projet" (voir ci-dessous) quand elle est utilisée avec le processus voulu par son créateur le psychosociologue américain Kurt Lewin, elle est aussi utile d'une façon plus générale pour l'enseignant qui doit savoir comment fonctionne son groupe, comment se structurent les échanges entre ses membres (qualité et quantité des échanges), à partir de sa configuration.

D'un point de vue psychosociologique, on peut lister les questions auxquelles l'enseignant doit répondre s'il veut comprendre ce qui se passe à un moment donné dans le groupe dont il a la charge (pourquoi les résultats ont baissé dans l'ensemble, pourquoi tendent à émerger deux sous-groupes antagonistes qui perturbent l'ensemble... ?) et les corrections à apporter pour recentrer son fonctionnement :

- Le groupe lui-même : est-il structuré, se voit-il comme un groupe, une somme d'individus ou une véritable entité [5]?

- Le leadership : comment est le leader, y a-t-il plusieurs leaders, sont-ils en concurrence ? (risque de fracture du groupe, risque de domination)[6]

- Comment se font les échanges à l'intérieur du groupe : qualité, quantité et variété représentées par un graphe [7]

- Moral et motivation : le ou les leader(s) d'ambiance ont-ils un comportement plutôt positif ou plutôt négatif ? Quelle est la répartition des compétences et comment agit-elle sur la motivation de ses membres[8]?

- Comment se situe le groupe en matière d'autonomie et de participation [9]?

- Comment le groupe perçoit-il l'image de l'enseignement ? Est-elle bien adaptée au fonctionnement de ce groupe ?

Ce sont des questions fondamentales auxquelles tout enseignant se doit de répondre (le plus rapidement possible) pour adapter son enseignement au groupe dont il a la charge et pour pouvoir s'adapter, prévoir les ajustements nécessaires selon l'évolution du groupe. C'est justement dans la mesure où le groupe n'est pas stable, statique, que Kurt Lewin parle de "dynamique de groupe" et qu'il a élaboré les grandes règles de son enseignement et qu'il nécessite une évaluation permanente.

Panorama des méthodes d'apprentissage

En matière de méthodes pédagogiques, il faut savoir qu'il n'existe pas de bonne ou de mauvaise pédagogie en soi. Une méthode doit d'abord être adaptée à l'objectif fixé et au contenu de l'enseignement : c'est ce qu'on appelle la règle de contingence ou parfois le principe de contingence ce qui signifie qu'en la matière, il n'y a pas de règle absolue qui s'applique automatiquement dans tel ou tel cas d'enseignement ou de projet pédagogique. Simplement, certaines méthodes sont a priori mieux adaptées à telle intervention pédagogique; à l'intervenant de confronter cet a priori à la réalité de son intervention.

- Cours magistral, exposé, conférence

Sous ces vocables, on trouve les différentes formes d'enseignement traditionnel, c'est-à-dire les plus anciennes, quand personne n'osait poser la question de la relation enseignant-enseigné et même quand il eut paru incongru d'aborder une telle question ou de demander au professeur de préciser sa pensée. Le savoir se déversait de son représentant vers un public trop respectueux pour porter un œil critique sur la façon d'enseigner[10].

Cette pédagogie a un gros défaut : elle ne permet pas les ajustements nécessaires à une bonne compréhension de l'apprenant puisqu'il peut rarement demander des précisions ou des explications complémentaires, même si en théorie c'est possible. (une conférence devant cinquante, cent personnes ou plus ne facilite pas les interactions) Elle n'utilise donc le plus souvent qu'un seul canal de communication, du professeur vers l'élève, et se prive d'un élément essentiel en pédagogie : le retour d'informations, ce qu'on appelle La rétroaction ou de son nom d'origine le feed-back.

- Travaux pratiques et études de cas

Ce domaine touche essentiellement tout ce qui est exercices, travaux pratiques, conception de supports, recherches et exposés collectifs. Les méthodes de concrétisation des savoirs tentent de pallier les défauts des méthodes directives ci-dessus en jouant avec ces deux moyens pédagogiques qui permettent de passer de l'abstrait au concret ou du concret à l'abstrait car on peut très bien partir d'un exercice pour en tirer une règle même si c'est généralement le contraire qui est utilisé. On parle effectivement de jouer entre ces possibilités car c'est bien d'un jeu dialectique dont il s'agit, la solution d'un problème concret permettant de conforter la règle étudiée et d'aborder d'autres aspects de la question qui permettront à leur tour de préciser la règle (en abordant par exemple des cas particuliers) ou de l'élargir à des sujets connexes et de recommencer ainsi le processus d'apprentissage règle (abstraction, concept) et concret (mise en application, complexité de la réalité). On parlera alors volontiers d'enseignement dynamique.

- L'auto apprentissage

Cette approche pédagogique très ancienne a été délaissée au profit de l'apprentissage des contenus à partir de programmes très structurés fondés à l'époque médiévale sur la théologie[11] ou la scolastique et ont perduré jusqu'à une époque très récente.

Au départ en effet, c'est le philosophe grec Socrate qui a intégré dans son enseignement le fait de faire révéler à quelqu'un ce qu'il possédait déjà sans en être conscient, ce qu'il appelle La maïeutique, (du grec maieutikè : l'art de faire accoucher), terme qu'il emprunte à sa mère qui était sage-femme. Ces idées ont été reprises et actualisées par les pédagogues qui ont recherché à recréer des liens entre des matières ou des disciplines trop fractionnées aboutissant à un enseignement de plus en plus spécialisé[12].

Ce n'est par exemple que dans les années soixante qu'ont été remis en cause l'enseignement traditionnel de l'histoire fondé sur les événements (l'histoire événementielle) par l'école ou le courant des Annales[13] qui prônait une approche sociologique de l'histoire ou l'abandon des cinq parties traditionnelles des études philosophiques au profit d'un programme global reposant sur l'action et la connaissance.

- Formation permanente et méthode expérimentale

Cette méthode consiste, non plus à accumuler des connaissances de plus en plus spécialisées, pointues, mais à savoir où elles sont stockées, puis à pouvoir les retrouver aisément et rapidement. Elle se caractérise donc par l'accès le plus direct possible aux bases de connaissances disponibles. Il s'agit essentiellement d'acquérir des méthodes, de connaître les filières, de s'approprier les processus d'accès à l'information dont on a besoin à un moment donné.

Trois grands phénomènes concourent à cette évolution des savoirs vers les savoir-faire :

- L'explosion des connaissances depuis un demi-siècle dans les disciplines existantes (anthropologie historique par exemple) et les disciplines nouvelles ou émergentes comme l'informatique, l'électronique ou la numérisation des documents pour ne prendre des exemples que dans ces technologies. Actuellement, plus personne ne peut acquérir un tel savoir encyclopédique comme dans les siècles précédents, les disciplines étant de plus en plus morcelées et spécialisées. (par exemple, la psychologie déclinée en psychopédagogie, psychosociologie, psychothérapie...)

- L'évolution des connaissances touche tous les domaines de la connaissance, domaines scientifiques (médecine, matériaux composites...) ou administratifs. Dans la sphère juridique par exemple, le droit de la famille ou de la consommation évoluent à un rythme tel qu'il devient très compliqué de mettre à jour ses connaissances pour rester opérationnel.

- L'informatique devient un préalable à l'accès au savoir, aussi important que la lecture ou l'écriture. Avec les banques de données ou internet, l'accès à l'information devient un enjeu qui demande la maîtrise des techniques et des procédures d'accès.

L'apprentissage par l'expérience

Il s'agit d'un processus par lequel une personne développe des compétences personnelles et sociales au moyen d'expériences vécues et analysées (Kerjean 2003). Le processus d’apprentissage utilise le support de problèmes à résoudre en grandeur réelle « ici et maintenant », le plus souvent dans la nature, et s’appuie sur l’essai-erreur. La spirale de l'apprentissage par l'expérience est une succession de cycles comprenant quatre étapes.

- La formation commence par une expérience concrète à appréhender émotionnellement par le groupe.

- L’expérience émotive est transformée par la pensée en observation et génère la question « que faisons-nous avec ça ? »

- L’observation une conceptualisation abstraite : « comment pouvons-nous faire autrement ? »

- L’hypothèse est ensuite testée en situation concrète et le cycle se poursuit, tel une spirale.

- Groupe de projet

Cette dernière catégorie regroupe toutes les actions pédagogiques qui mettent l'accent sur le groupe et son fonctionnement, soit à partir d'un objectif précis, d'une organisation bien définie et une implication directe des intervenants, en ce cas on parlera plutôt de groupe de résolution de problèmes, soit à partir d'une autonomie plus ou moins large du groupe (pouvant aller jusqu'à l'autogestion) laissant le groupe libre de définir lui-même ses objectifs et les moyens de les atteindre, la stratégie à adopter, les animateurs-intervenants s'occupant surtout des modes de fonctionnement du groupe (et de ses membres).

Surtout dans ce dernier cas, l'intervention pédagogique se fait moins sur le contenu de la formation que sur des mécanismes et des comportements à acquérir dans un environnement donné. Les méthodes pédagogiques reposent alors surtout sur des études de cas globales, multiformes mises en œuvre à partir de la dynamique de groupe avec la méthode des cas couplée à des échanges impliquant pour les participants à travers les techniques du jeu de rôle et de l'audiovisuel. (filmer les échanges avec une caméra et exploiter ce qui s'est passé ici et maintenant. La séance de conclusion permet de faire un "debriefing" afin d'exploiter le ressenti des participants et d'en tirer des enseignements pour la suite.

L'apport des NTIC (Nouvelles technologies de l'informatique et des communications)

- Les apports de l'audiovisuel et de l'informatique[14]

L'audiovisuel dans ses différentes dimensions qui vont de la simple utilisation de diapositives, de films à un système intégré de diffusion en réseau qu'on trouve dans les services de formation de grandes entreprises ou dans les grands centres de formation du privé. L'audiovisuel couplé à l'informatique à distance permet des applications intégrant texte, tableaux, photos et images pour réaliser des systèmes de télé-enseignement ou de réunions à distance (réseau de téléconférence par exemple).

Son évolution liée aux possibilités de l'information, inclut d'abord les moyens les plus anciens pris en charge par l'ordinateur dans des applications dites 'intégrées' avec une palettes de moyens comprenant au minimum un traitement de texte, un tableur, un gestionnaire d'images et de photos de type 'powerpoint' (remplaçant films et diapositives) pour prendre le logiciel le plus courant, auxquelles on peut adjoindre selon les besoins un logiciel de dessins, un gestionnaire de bases de données, voire un générateur de programmes. On assiste donc à une évolution vers une intégration des fonctions basée sur les plateformes internet et Windows ainsi qu'à partir des formats les plus répandus permettant des échanges multifonctions (langage HTML pour internet, fonctionnalités Windows pour l'interface, formats d'échanges en bureautique, essentiellement à partir des formats fichiers de Microsoft, formats images JPEG, supports CD et DVD)[15].

Pour assurer toutes les tâches routinières, un système informatique peut être conçu de telle façon que l’espace écran soit géré graphiquement (prise en charge des matériels périphériques, de l’affichage, du graphisme…), la surveillance du système, la sécurité interne et la définition des configurations et des formats, ainsi que les travaux de maintenance de l’utilisation (gestion des données, chargement et sauvegarde des fichiers…) mais l'interface textuelle, davantage liée au cœur du système est encore très répandue pour des tâches complexes. Par exemple, l’interface M offre des programmes pour gérer les fichiers de tout type (galerie de photos, convertisseur…), gérer le système (avec le panneau de configuration, la barre des tâches ou le menu Démarrer) ou assurer les travaux de maintenance comme assurer les mises à jour, restructurer le disque (la défragmentation), restaurer le système…

Une interface doit être transparente pour l’utilisateur qui n’a normalement pas à s’en préoccuper, d’autant plus qu’elle prend en charge des tâches autrefois dévolues à l’utilisateur, par exemple ajout d’une imprimante, changement de souris.

Dans l’informatique personnelle, Windows (sous ses différentes versions) l’interface de la société Microsoft s’est imposée comme le produit phare qui équipe la plupart des microordinateurs. Cette situation, si elle a l’inconvénient de tout produit qui occupe un monopole commercial et restreint par là même les possibilités de compréhension d'un système d'exploitation pour microordinateur, offre l’avantage de la compatibilité entre logiciels bureautiques et ludiques, les plus répandus sur les plates-formes personnelles.

De plus, les quelques interfaces concurrentes qu’on trouve sont très souvent disponibles en téléchargement sur des sites internet et offrent un bon niveau de compatibilité avec les versions Windows, ce qui permet de transférer facilement toutes sortes de données (fichiers, textes, images, photos…) à condition de respecter les formats en utilisant les plus courants (par exemple JPEG pour les images ou .doc pour les textes au format Microsoft Word). On peut ainsi passer facilement d’un format à un autre avec une bonne résolution graphique : par exemple, sauvegarder tous ses textes au format Microsoft Word (.doc) en passant par le menu Fichier/Sauvegarder ou passer ses diapositives Powerpoint (format .ppt) au format Images JPEG (.jpg) pour éviter tout problème de transfert ultérieur. Il suffit d’utiliser la même solution en passant par le menu Fichier/Sauvegarder/Présentation et choisir ensuite le format adéquat, généralement en format JPEG (jpg) mais aussi aux autres formats disponibles comme Png, Gif et Tiff fort répandus également.

- L'utilisation des moyens

Des moyens de plus en plus efficaces donc sophistiqués et disponibles, qu'ils soient logiciels comme les didacticiels de plus en plus interactifs ou les matériels comme la nouvelle génération de tableaux blancs interactifs sont souvent une aide précieuse pour les enseignants. Mais ils sont aussi sources de contraintes car ils demandent eux-mêmes une formation pour pouvoir être bien utilisés. D'autre part, ces logiciels doivent être largement testés et doivent être ainsi l'objet d'une 'labellisation' organisée; les matériels représentent un coût important autant en investissements (prix d'achat, antivirus, passage en réseau...) qu'en maintenance et mise à jour.

Le recours à des technologies informatiques de plus en plus sophistiquées contient en soi une crainte que l'enseignant soit dépossédé de son rôle et de son savoir, qu'il maîtrise mal les outils informatiques qui n'entrent pas forcément dans sa culture ou que les apprenants n'aient plus guère de contacts qu'avec des machines, un enseignement dépersonnalisé et rigide aux programmes dont les capacités de réaction sont par nature limitées par les capacités pédagogiques de ceux qui les ont écrits. (même si tout au long de la chaîne de création, il y a collaboration entre pédagogues et informaticiens)

La pratique montre que si les savoirs peuvent être pris en charge par la machine, plus ou moins selon la matière ou la discipline visée, l'informatique intervient surtout dans le recours aux exercices et autres travaux pratiques, surtout dans les domaines des sciences exactes : exercices programmés et "QCM", les questionnaires à choix multiples), bases de données documentaires ou jurisprudentielles par exemple...

Mais toutes les études effectuées à ce sujet sont convergentes[17] : si le contenu d'une formation tend à être partagé entre l'enseignant et la machine, le rôle de l'enseignant devient essentiel, encore plus important que par le passé puisqu'il devra continuellement faire le lien entre les acquis enseignés et plus ou moins fractionnés, et par là même, donner du sens à la formation.

On parle désormais de E-Learning[18]. Des plateformes d'enseignement en ligne telles que Moodle sont de plus en plus utilisées, soit en formation présentielle soit en formation à distance (Mooc). Ces outils peuvent être utilisés sur un réseau interne à l'entreprise ou un groupe d'entreprises mettant en relations les participants de plates-formes informatiques[19].

La pédagogie appliquée au management

Résumé

Contexte

- Introduction au management

Déjà Henri Fayol dans les cinq fonctions essentielles à la vie de l'entreprise qu'il avait définies, y plaçait les fonctions Organisation et commandement. Mais c'est surtout Elton Mayo jusqu'à sa mort en 1947, qui va donner l'impulsion nécessaire au développement d'une nouvelle vision de l'entreprise basée sur les relations humaines. C'est en réaction au taylorisme et à son utilisation abusive qu'il mettra sur un même pied capital travail et capital humain. Il réalisa des enquêtes et des expériences sur les conditions de l'homme face au travail automatisé, comme à l'usine Western Electric de Cicero, sans doute la plus célèbre[20].

C'est le sociologue français Georges Philippe Friedmann qui sera son véritable continuateur, surtout après la publication d'un livre retentissant en 1956 intitulé Le travail en miettes. Il y prenait le contrepied de l'OST de Frederick Taylor et de ses extensions comme le fordisme en défendant la prééminence de l'homme et de ses besoins. Depuis les crises économiques survenues dans les années quatre-vingt, sur fond de crise énergétique latente, c'est l'américain Peter Drucker qui a joué un rôle majeur dans les évolutions des théories du management. D'abord, en marquant l'importance du rôle des managers et en reprenant à sa façon les grands domaines du management définis pat Fayol : fixer des objectifs, organiser le travail, motiver et communiquer, mesurer la performance, former les salariés. Il met en particulier l'accent sur la fonction organisation et le rôle fondamental de la pédagogie et de la formation des hommes. Le grand public le connaît surtout pour avoir publié en 1993 un livre phase intitulé Au-delà du capitalisme dans lequel il condamne la primauté du gain financier sur la création de valeurs, les start-up qui ne sont trop souvent que des "bulles" ou la rémunération excessive des dirigeants[21].

À la même époque, un sociologue canadien, le professeur Henry Mintzberg publie un ouvrage important intitulé Le pouvoir dans les organisations. Il s'oppose lui aussi aux conceptions tayloriennes trop normatives et crée ce qu'on a appelé l'école de la contingence où il affirme que la structure d'une organisation doit dépendre de la nature de son environnement et prône la souplesse de l'organisation qui autrement, est condamnée à stagner au mieux ou à régresser, se scléroser. Pour éviter cela, elle doit mettre en place des mécanismes régulateurs internes pour pouvoir plus facilement s'adapter[22].

En France, c'est surtout le sociologue Michel Crozier qui représente le mieux cette évolution. Créateur en 1962 du Centre de sociologie des organisations, il publie l'année suivante un livre qui fait date Le phénomène Bureaucratique[23]. Il se situe à la fois comme le continuateur de Georges Philippe Friedmann et rejoint Henry Mintzberg dans son analyse des organisations. Pour lui, les acteurs subissent des règles qui les gênent dans leur travail car elles ne peuvent couvrir toutes les situations possibles, ce qui permet à certains de les utiliser pour s'octroyer quelques parcelles de pouvoir, dans les "interstices" de la réglementation. C'est une faiblesse des organisations qui doivent édicter de nouvelles règles pour contrôler le système, règles qui vont s'ajouter aux précédentes pour opacifier le système et déclencher en réaction une certaine routine chez les exécutants, nuisant à leur efficacité : une espèce de cercle vicieux qu'il faut combattre par un management plus participatif et des méthodes de formation active adaptée aux adultes.

Adapté aux entreprises après guerre en Grande-Bretagne, la méthode de l’Experiential Learning/Outdoor Education devient rapidement influent dans les pays anglo-saxons pour la formation des managers. Références : Bank, Eitington

Formation du manager et outils managériaux

Résumé

Contexte

Tout manager a de plus en plus besoin d'avoir une vision de son activité, une évaluation précise de ses résultats et des moyens dont ils dispose pour les atteindre. Cette évaluation repose sur un suivi d'activité avec des outils de mesure quantitative de sa production (de biens ou de services) à travers les méthodes quantitatives de gestion. (comptabilité de gestion et analytique, gestion de suivi...) Il a aussi besoin de savoir comment fonctionne son organisation, si les résultats obtenus sont conformes aux objectifs fixés, que ce soit en termes quantitatifs (le plus souvent) ou en termes qualitatif.

Dans toute organisation, on peut dresser un premier bilan général de l'activité pour évaluer le taux de satisfaction global. Arriver à une première approximation doit permettre de définir une échelle de valeurs avec au moins trois paramètres :

- Pourcentage de cas où on considère que les choses se sont passées 'normalement', c'est-à-dire sont conformes aux prévisions ou aux résultats précédents;

- Pourcentage de cas où on considère que les choses ont connu quelques difficultés (retards, taux de retour de telle marchandise... dans de conditions normales d'exploitation, c'est-à-dire non dues à des conditions exceptionnelles (grèves par exemple) ou extérieures (faillite d'un fournisseur par exemple) ;

- Pourcentage de cas où on considère que les choses se sont mal passées, soit par manque de disponibilité, de fiabilité des produits... soit à cause de problèmes de qualité rencontrés (qualité des produits ou des services, qualité d'accueil, problème de communication).

Dans le premier cas, l'efficacité (efficience) veut qu'on cherche à améliorer les résultats en traquant 'les niches d'amélioration' comme on dit dans les groupes qualité. Dans le cas intermédiaire, il est probable que certains secteurs ou certaines activités fonctionnent mieux que d'autres et les actions de correction doivent bien entendu porter sur ces domaines à problèmes. Dans le dernier cas, si les résultats sont vraiment mauvais ou en diminution par rapport aux constats antérieurs (production en baisse, niveau des invendus, taux de rejet prohibitifs), c'est probablement l'organisation elle-même qui est à revoir.

Une approche souvent utilisée consisté à évaluer les problèmes importants, ceux qui ont eu le plus de conséquences néfastes sur les résultats, ceux donc où les corrections apporteraient les meilleurs gains de productivité, et de leur apporter des solutions à court ou à long terme selon le cas : c'est ce que l'on appelle repérer les grains de sable, ceux qui ont tendance à faire 'gripper la machine'.

Exemples d'application

- La gestion des aléas : de l'enquête préalable au tableau de bord

- La conduite d'une action : diagrammes et tableaux - outils d'analyse de processus.

Il existe de nombreux diagrammes dont les plus utilisés en gestion du management sont : le Diagramme de Gantt, le Diagramme de causes et effets, le Diagramme de Pareto et le Diagramme de Venn.

Notes et références

Voir aussi

Wikiwand - on

Seamless Wikipedia browsing. On steroids.