Imagerie spatiale

images prises par un satellite artificiel De Wikipédia, l'encyclopédie libre

L'imagerie spatiale est une technique d'observation à distance qui repose sur la prise d'images dans le domaine optique (lumière visible, infrarouge et ultraviolet) depuis l'espace par des équipements installés à bord de satellites artificiels. L'imagerie spatiale constitue une des techniques utilisées pour déterminer les propriétés d'objets naturels ou artificiels à partir du rayonnement électromagnétique émis ou réfléchi par ceux-ci. Ces techniques, regroupées sous le vocable de télédétection, comprennent également l'observation des micro-ondes à l'aide de radars et celle des ondes radio.

L'imagerie spatiale repose sur la transformation du rayonnement lumineux en image numérique. Chaque point élémentaire de l'image (pixel) est caractérisé par une valeur (la radiométrie) proportionnel à la puissance de la lumière reçus (la luminance) dans une bande spectrale choisie (l'ensemble du spectre de la lumière visible du violet au rouge pour obtenir une image classique dite panchromatique). Les images sont prises par des instruments comprenant une partie optique, des filtres et des détecteurs. Le résultat est en partie corrigé de manière automatique à bord de l'engin spatial (étalonnage, correction de la géométrie) avant d'être transmis via une station terrienne à un centre de traitement qui complète les corrections et produit des images répondant aux besoins des utilisateurs. Les capacités des satellites produisant ces images sont variables pour répondre aux besoins des utilisateurs : les satellites météorologiques ont ainsi une résolution spatiale moyenne mais effectuent simultanément des observations dans un très grand nombre de bandes spectrales alors que les satellites de reconnaissance militaires ont une résolution spatiale qui peut être inférieure au centimètre.

L'imagerie spatiale est un domaine en forte croissance avec des usages des plus variés. Initialement produite par des engins spatiaux développés par des agences spatiales civiles ou militaires (Landsat, Spot), elle est désormais en grande partie produite et commercialisée par des sociétés privées. Les principales applications sont la cartographie, la météorologie, la reconnaissance militaire, la gestion des productions agricoles, le suivi des catastrophes naturelles, l'étude de la Terre et des planètes à des fins scientifiques.

Définition

Résumé

Contexte

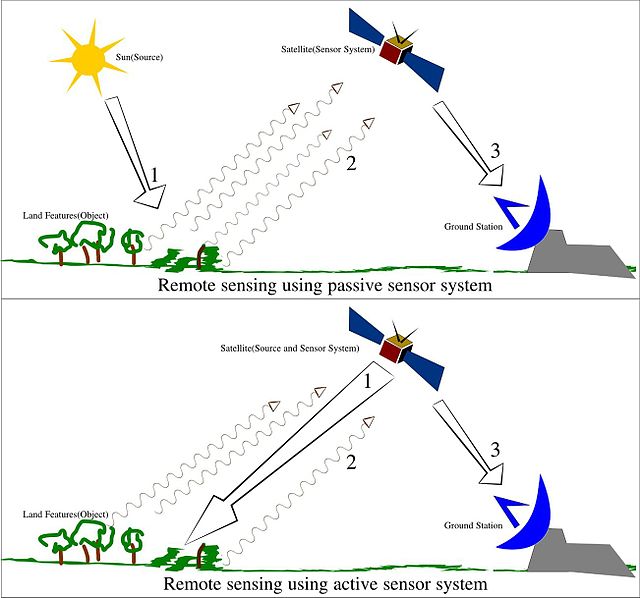

L'imagerie spatiale fait partie des techniques de télédétection qui permettent de déterminer les propriétés d'objets naturels ou artificiels à partir des rayonnements qu'ils émettent ou réfléchissent. Les techniques de télédétection comprennent l'ensemble du processus : la capture et l'enregistrement de l'énergie d'un rayonnement émis ou réfléchi par les objets observés, le traitement des données résultantes et enfin l'analyse des données finales. Ce processus met en œuvre un capteur (appareil photographique, laser, radar, sonar, lidar, sismographe, gravimètre…) qui est généralement embarqué à bord d'une plateforme mobile : avion, satellite, ballon, navire (sonar), etc. Une grande partie du spectre électromagnétique du rayonnement X aux ondes radios (en passant par l'ultraviolet, la lumière visible et l'infrarouge) peut être utilisée. Chaque partie du spectre est susceptible de fournir des informations sur l'objet : forme, température, composition chimique, moléculaire et minéralogie, distance, etc. L'imagerie spatiale est la technique de télédétection qui repose sur la prise d'images dans le domaine optique (lumière visible, infrarouge et ultraviolet) à partir d'engins spatiaux en orbite autour d'un corps céleste (Terre ou autre) ou survolant celui-ci.

Concepts

Résumé

Contexte

Spectre électromagnétique

Le rayonnement du Soleil qui traverse l'atmosphère vient frapper la surface de la Terre et une partie de celui-ci est réfléchi dans l'espace. Ce rayonnement est composé d'ondes de différentes longueurs qui forment son spectre électromagnétique : ondes radio, micro-ondes, infrarouge, lumière visible, ultraviolet, rayons X et rayons gamma. L'imagerie spatiale est réalisée à partie d'une fraction de ce spectre comprenant la lumière visible l'infrarouge et l'ultraviolet. Seule la lumière visible est perçue par notre œil, chaque couleur perçue par l'œil correspondant à un intervalle de longueur d’onde.

Réflectance et signature spectrale

Le rayonnement du Soleil qui vient frapper le sol est en partie absorbé par sa surface ou pénètre dans le sol. Mais une partie du rayonnement est réfléchi. C'est cette partie du rayonnement qui est perçue par les instruments de télédétection (et nos yeux pour la partie du spectre correspondant à la lumière visible). La proportion de lumière réfléchie dépend des caractéristiques de la surface (type de sol, type de végétation, étendue d'eau, température…). Cette grandeur qui s'exprime sous la forme d'un pourcentage est la réflectance. La réflectance d'une surface varie en fonction de la longueur d'onde de la lumière incidente. La courbe représentant la réflectance en fonction de la longueur d'onde, appelée spectre de réflexion, constitue une signature qui permet d'identifier de manière plus ou moins précise les caractéristiques de la surface ou de la végétation qui la recouvre[1].

Résolution spatiale

La résolution spatiale d'une image est la taille du plus petit élément d'une image qu’il est possible de distinguer. Elle est également couramment définie comme étant la taille du pixel (par exemple 1 pixel = 10 mètres). Les objets qu'il est possible de discerner dépendent de la résolution spatiale de l'instrument utilisé. Dans le domaine de l'imagerie spatiale on distingue la basse résolution, la moyenne résolution, la haute résolution et la très haute résolution. De manière générale, l'obtention d'une résolution spatiale élevée se traduit par une superficie de la surface visible réduite : une image très haute résolution couvrira une portion de territoire plus restreinte qu'une image moyenne résolution. Le choix d'une résolution spatiale à la conception du capteur embarqué sur le satellite mais aussi au moment de la conception du produit final dépend du besoin de l'utilisateur. Pour des applications météorologiques, une résolution spatiale basse ou moyenne est suffisante car les phénomènes observés sont généralement à l'échelle kilométrique. Par contre dans le domaine de la reconnaissance militaire il est généralement demandé la résolution spatiale la plus élevée possible pour pouvoir identifier de manière non ambiguë les armes, équipements et installations militaires[1].

Canal spectral et résolution spectrale

Le satellite produisant des images spatiales enregistre celles-ci simultanément dans plusieurs bandes spectrales ou canaux spectraux : pour chaque canal, seul le rayonnement compris dans un intervalle de longueurs d'onde donné est enregistré : par exemple pour Spot-4 le canal spectral du vert enregistre uniquement les longueurs d'onde comprises entre 0,5 et 0,59 micron. Chaque élément de l'image (pixel) est enregistré pour chaque canal en niveaux de gris avec un nombre de niveaux défini pour répondre aux besoins (souvent codé sur 8 bits soit 256 niveaux distincts). Une image correspondant à une photographie classique est obtenue en combinant trois images réalisées respectivement dans la bande du bleu, du vert et du rouge[1].

| Satellite | Opérateur | Type | Date lancement |

Nbre canaux | Détail canaux | Fauchée | Résolution spatiale |

Résolution radiométrique |

Masse | Autre | Remarque |

|---|---|---|---|---|---|---|---|---|---|---|---|

| Landsat 1[2] | NASA | Observation de la Terre | 1972 | 4 | 3 VIS + 1 IR | 185 km | 80 m. | 6 bits | 60 kg (instrument) | Premier satellite d'imagerie civil | |

| Météosat Seconde Generation[3] | Eumetsat | Météorologie | 2002 | 12 | 4 VIS + 8 IR | hémisphère en 15 minutes | 1 km (VIS) | 12 bits | 270 kg (instrument) | En orbite géostationnaire | |

| Pléiades Neo[4] | Airbus DS Geo | Civil/militaire | 2021 | 7 | 6 VIS + 1 IR | 14 km | 30 cm. |

Selon les caractéristiques du satellite, une image peut être enregistrée uniquement dans les trois bandes reproduisant une photographie classique (rouge, vert, bleu) ou dans quelques bandes additionnelles situées dans l'infrarouge (images multi-spectrales) ou dans des centaines de bandes spatiales (images hyper-spectrales). Une image multi-spectrale avec ses bandes spectrales généralement larges et espacées fournie une image partielle de la signature spectrale de la surface alors que l'image hyperspectrale permet de reconstituer avec une grande précision celle-ci mais généralement au détriment de la résolution spatiale du fait du volume de données à collecter et transmettre. La résolution spectrale est la grandeur qui définit le pouvoir de séparation en bandes spectrales de l'instrument embarqué sur le satellite. Plus la résolution spectrale est grande, plus le spectre obtenu est détaillé, et plus on peut y mesurer des raies de faible intensité ou profondeur[1].

| Instrument | Opérateur | Type | Satellite | Date | Bande spectrale | Nbre bandes et largeur | Type capteur | Utilisation | Autre information |

|---|---|---|---|---|---|---|---|---|---|

| HySIS[5] | ISRO | Satellite | HySIS | 2018 | 400-950 nm | 55 (10 nm) | Pushbroom (en) | Surveillance des ressources agricoles et forestières | Résolution spatiale 30 m. |

| PRISMA[6] | Agence spatiale italienne | Satellite | PRISMA | 2019 | 400-2500 nm | 250 (< 12 nm) | Pushbroom | Surveillance des ressources naturelles, démonstrateur technologique | Résolution spatiale 30 m. |

| HSI[7] | DLR | Satellite | EnMAP | 2021 | 420-2450 | 228 (6,5 nm et 10 nm) | Pushbroom | Résolution spatiale 30 m. | |

| HISUI[8] | JAXA | Satellite | ALOS-3 | 2021 | 400-2500 | 185 (10 nm et 12,5 nm) | Pushbroom | Gestion des ressources minières, suivi des productions agricoles, surveillance environnement, agriculture | Résolution spatiale 30 m. |

Restitution : vraies et fausses couleurs

Une image classique (telle que notre œil le perçoit) est produite à partir des enregistrements effectués dans les trois canaux de lumière visible (rouge, vert, bleu). Il s'agit d'image en « vraies couleurs ». Pour pouvoir visualiser les données de l'image enregistrées dans des canaux ne faisant pas partie de la lumière visible on affecte de manière conventionnelle une couleur donnée à chacun des canaux. L'image obtenue en combinant ces différents canaux est dite image en « fausses couleurs »[1].

Historique de l'imagerie spatiale

Résumé

Contexte

Les premières photographies satellites de la Terre ont été réalisées le par le satellite américain Explorer 6[9].

Les premières photographies satellites de la Lune auraient été faites le par le satellite soviétique Luna 3, lors d'une mission destinée à photographier sa face cachée.

La photographie La Bille bleue (en anglais : Blue Marble) a été prise de l'espace en 1972. Elle est rapidement devenue très populaire auprès des médias et du grand public.

En 1972, les États-Unis lancent le programme Landsat, un des plus anciens programmes d'observation de la surface terrestre des États-Unis. Un de ses premiers objectifs était l'évaluation des volumes de récolte céréalières en URSS et aux États-Unis afin d'anticiper l'évolution des cours. Huit satellites Landsat ont été lancés depuis le , le dernier, Landsat 8, a été lancé le .

En 1977, la première image satellite en temps réel est prise par le satellite américain KH-11.

La même année, la France lance le programme SPOT (Satellite pour l’observation de la Terre), afin de fournir le premier service commercial d'imagerie satellite. Le premier satellite de cette famille de satellites civils développés par le CNES s'illustre par la diffusion, peu après son lancement en 1986, des premières images publiques de la catastrophe de Tchernobyl. Le 4e exemplaire s'illustre à son tour en étant le premier satellite à photographier les attentats du 11 septembre 2001, moins de 3 heures après[10].

Accès aux images et fournisseurs d'images

Résumé

Contexte

Aux États-Unis, l'imagerie terrestre a longtemps été l'apanage du renseignement militaire. Il faudra attendre la fin de la Guerre froide, et la réorganisation des efforts stratégiques, pour que les entreprises privées soient autorisées à capter, puis à exploiter des images réalisées par satellite[11]. Bien que de plus en plus dépendantes du secteur privé, les administrations ont toujours recours à ce type d'imagerie : toutes les images satellite prises par la NASA, notamment, sont éditées par la NASA Earth Observatory et sont proposées gratuitement au public (open data).

De nombreux autres pays ont des programmes d'imagerie satellite. Une collaboration internationale européenne, par le biais de l'Agence spatiale européenne (ESA), a permis de lancer les missions ERS 1 en 1992 puis ERS 2 en 1995, suivies par la mission ENVISAT en 2002. ENVISAT, mis en orbite le par Ariane 5 est un programme de 2,3 milliards d'euros pour le plus gros satellite scientifique d'observation de la Terre jamais conçu. Le , l'ESA a annoncé le libre accès à ses contenus (images ses vidéos et certaines autres données), sauf mention contraire. Ces contenus informationnels deviennent librement partageables et réutilisables comme l'étaient depuis toujours ceux de la NASA et des autres grandes agences financées par les budgets de l’État américain (hors cas particuliers liés par exemple au secret défense). La licence utilisée à l'ESA est la CC by-sa 3.0 IGO (« IGO » signifie en anglais : intergovernmental organization, ce qui signifie qu'en cas de litiges (très rares en matière de Creative Commons), il faudra passer par une médiation avec l'Agence)[12],[13].

Les images SPOT 1 à 5 du CNES sont disponibles sous licence ouverte depuis le [14].

Il existe également des compagnies privées qui produisent et commercialisent des imageries satellites telles que Maxar, Airbus DS Geo ou Planet Labs.

Produits

L'image spatiale produit des images satellite (ou satellitaire - l'usage de l'adjectif satellital est discuté[15],[16].

Utilisations

Résumé

Contexte

De très nombreux usages (scientifiques, civils et militaires) sont faits de ces images.

Les satellites ont eu une contribution unique et importante, dans certains domaines dont :

- Météorologie,

- Évaluation et la surveillance de l'environnement (déforestation, pollutions, pollution lumineuse, urbanisation et périurbanisation, fragmentation écologique, érosion, etc.). Par exemple des analyses[17] d'images Landsat faites par la NASA[18], l'université de Californie et le Conservation Research Center du Smithsonian Institution ont clairement montré en 2004 que malgré un triple statut d'Aire protégée (statut de réserve ethnique, de Réserve de la biosphère de l'UNESCO et de Parc national), la région de Yasuni, l'une des plus riches au monde en biodiversité, continue à être déforestée[17] et morcelée. Le taux annuel moyen de déforestation était de 0,11 % au début des années 2000, mais avec une tendance à la hausse qui si elle devait se poursuivre conduirait à ce qu'avant 2063, 50 % de la forêt située à environ 2 km d'une route d'accès au pétrole soient perdus et offerts à une colonisation sans entrave et à une conversion anthropique en zone de culture ou d'habitation)[17].

Il s'agit d'une superpositions d'images prises de nuit et par temps clair ; les limites des continents sont produites par l'ajout en couleurs sombres, des photographies équivalentes diurnes.

- Archéologie,

- Aménagement du territoire, cartographie (SIG notamment),

- Suivi de l'usage des sols,

- Lutte contre les incendies,

- Télécommunications, via l'Internet notamment

- Agriculture[19]

- Sylviculture

- Sécurité maritime (balises Argos, GPS, etc.), alertes Tsunami et suites

- Gestion de certains risques

- Gestion de l'énergie (solaire, éolien en particulier)

- Gestion des ressources naturelles,

- Évaluation des puits de carbone

Ils ont notamment permis de mieux identifier et faire reconnaître les changements climatiques et écologiques globaux.

Notes et références

Annexes

Wikiwand - on

Seamless Wikipedia browsing. On steroids.