Video digital

tipo de sistema de grabación digital que funciona mediante el uso de una señal de vídeo digital en lugar de analógica De Wikipedia, la enciclopedia libre

El video digital o vídeo digital[1] es una representación de imágenes en movimiento en la forma de datos digitales codificados, a diferencia del video analógico que representa estas imágenes mediante señales analógicas.

Comercialmente, el video digital fue introducido en 1986 y destinado a los estudios de televisión mediante el formato propietario D1 de Sony mediante el cual era grabada en forma digital una señal video por componentes, de definición estándar, sin compresión. Los formatos de video digital de la actualidad abarcan desde los formatos sin compresión hasta los formatos de video comprimidos populares como H.264 y MPEG-4. Los estándares de interconexión para video digital incluyen HDMI, DisplayPort, Interfaz Visual Digital (DVI) e Interfaz Digital Serial (SDI).

A diferencia del video analógico, el video digital puede ser copiado sin degradar su calidad. El video digital puede ser almacenado en cinta magnética y en medios ópticos, como los discos DVD y Blu-Ray, en medios informáticos o difundido a usuarios finales mediante transmisión por flujos de video (streaming) a través de Internet para ser visualizado en computadores o televisores inteligentes. En la práctica, el contenido de video digital de programas de televisión y películas incluye una banda de audio digital. La locución genérica de «video digital» debe distinguirse del nombre Digital Video (DV), que es un tipo específico de video digital enfocado al mercado de consumo.

Historia

Resumir

Contexto

En 1947, el ingeniero e inventor estadounidense Robert Lawrence Carbrey, mientras trabajaba para los Laboratorios Bell, había trabajado en el desarrollo de un sistema de comunicaciones por modulación por impulsos codificados y había solicitado una patente para ello el día 30 de octubre de 1947, siendo concedida ésta en 1952.[2] Los esfuerzos de Carbrey condujeron a que en 1960 realizara el primer intento de digitalización de una señal de televisión. Carbrey desarrolló e instaló en el laboratorio un sistema experimental de modulación por impulsos codificados para digitalizar señales de televisión a color y monocromáticas con 7 bits de código Gray sobre un cable telefónico de 7 pares de calibre 22 a una tasa de 10 MHz. El sistema estaba planteado de modo tal que por cada 3000 pies (914 m) de cable fuera instalado un dispositivo que constaba de igual número de repetidores y en el extremo de recepción, un decodificador que constaba de una red de resistencias ponderada, el cual entregaba una reproducción cuantificada de la señal de video original. Aunque los resultados fueron satisfactorios para 6 bits, Carbrey pensó que 7 bits podrían ser necesarios para una transmisión de buena calidad, dentro de ciertos márgenes.[3] En la actualidad, la digitalización del video se realiza a 8 bits.

Pese a ello, posteriormente el trabajo se centró más en las señales monocromáticas, hasta el año de 1971, en el que se volvió a dar atención al vídeo a color. Los principales motivos para que el procesamiento de video se realizara en forma digital, fueron la conversión de estándares para la transmisión e intercambio internacional de programas de televisión, principalmente entre países de Europa y América, debido a las diferencias entre los sistemas de televisión en ambos continentes y la grabación magnética. En este último caso, debido a las variaciones que hay en la velocidad de transporte de la cinta en los equipos de grabación y reproducción, se desarrolló el corrector de base de tiempos en cual el video analógico captado por los cabezales de reproducción, se convertía en digital y se almacenaba para leerlo posteriormente a velocidad constante, eliminando así los errores en los períodos de línea y cuadro de la imagen, así como los errores de fase en las señales de crominancia.[4]

En el año de 1976, comienza a pensarse en un sistema digital de grabación de imagen, ya que los productores de cine comercial deseaban que desarrollara un equipo grabador de video en el cual no se perdiera la calidad de la imagen después de sucesivos copiados de imágenes en cinta magnética. En marzo del año siguiente, el investigador japonés Yoshitaka Hashimoto y su grupo comenzaron a investigar la posibilidad de desarrollar tal equipo en el centro de investigación de Sony en Yokohama. Otro investigador japonés, Takeo Eguchi, quien estudiaba los principios de la tecnología digital aplicada a la grabación de video en Estados Unidos, regresó a Japón y se incorporó al grupo. En la exposición de 1979 de la National Association of Broadcasters (NAB, Asociación Nacional de Difusores de Estados Unidos) Ampex, Sony y Bosch AG presentaron de manera individual los frutos de sus esfuerzos. Un grupo de ingenieros de Sony visitó los Estados Unidos en diversas oportunidades para convencer a sus pares de ese país para desarrollar un estándar al respecto.[5]

No sería hasta el año de 1986, con la introducción del estándar D1, destinado a la industria televisiva, desarrollado las empresas Sony y BTS (consorcio formado por Philips y Bosch) y aprobado por la asociación de profesionales del video SMPTE (Sociedad de ingenieros de imágenes en movimiento y televisión), que el video digital comenzaría a tener presencia en los estudios de televisión. Sony presentó ese año, su videograbador digital DVR-1000, basado en ese estándar.[5] Al año siguiente, SMPTE desarrolló un nuevo estándar llamado D2. Las máquinas en formatos D1 y D2 se fueron introduciendo en los estudios de televisión, aunque de manera paulatina debido a su coste elevado y las modificaciones de instalación técnica que exigían. En el año 1989 Sony lanzó el DVR1, primer videograbador portátil de cinta en formato D2.[6] El video digital haría su aparición en el mercado de consumo con el formato QuickTime desarrollado por la empresa estadounidense Apple Computer hacia 1991 y destinado a la plataforma informática. Sin embargo, este formato requirió la digitalización de la fuente original de información de video y la calidad no era la mejor.[7]

En 1991, Panasonic propuso y estandarizó el formato D3. Pero 1993, en el Simposium Internacional de Montreux, Panasonic presentó el formato D5, Ampex lo hizo con el sistema DCT y Sony, aprovechando su experiencia con el sistema analógico Betacam, desarrolló y presentó una versión digital que fue denominada Betacam Digital. Los tres sistemas trabajan con vídeo digital por componentes, los dos primeros usan compresión de imagen y el último trabaja sin compresión. La aparición de distintos estándares de compresión del video y el audio vinculado a este, a partir de 1993, por parte del grupo de trabajo denominado Moving Picture Experts Group (MPEG) hizo que se adoptara la compresión de video para la grabación de imágenes y audio y posteriormente, para la difusión de televisión. A partir de 1995, varios formatos digitales nuevos compitieron en el mercado de la grabación de vídeo para producción televisiva con desigual fortuna. Ese año, la empresa japonesa Japan Victor Company (JVC) presentó su sistema Digital-S estandarizado con el nombre de D9 y Sony presentó el Betacam SX, variante del Betacam digital, que hacía uso de los principios de compresión de imagen establecidos en los estándares del grupo de trabajo MPEG. Panasonic respondió a este lanzamiento con su sistema DVCPro, a los que sucedieron DVCPro25 y DVCPro50 después del lanzamiento del formato Digital Video en 1995. Hoy en día, estos desarrollos de grabadores de cinta han sido superados por las videocámaras de discos duros internos o unidades de memoria flash removibles desarrolladas por fabricantes tales como Sony y JVC.[8]

La creación de los formatos de compresión de MPEG y los desarrollos en miniaturización de circuitos permitieron la aparición de los primeros sistemas de transmisión de televisión digital, mediante los cuales el video digital se hace presente en los hogares en la actualidad tanto en imágenes de definición estándar como de alta definición bien sea mediante recepción terrestre como satelital, en sistemas libres como pagos.

Visión técnica general

Resumir

Contexto

Las cámaras de vídeo digital capturan imágenes mediante exploración entrelazada o por escaneo progresivo. Una cámara digital de escaneo progresivo graba cada cuadro como una imagen distinta, sin registrar campos. Así, un vídeo entrelazado captura el doble de campos por segundo que el vídeo progresivo cuando ambos funcionan al mismo número de cuadros por segundo. Esta es una de las razones por la que el vídeo tiene un aspecto "hiperreal", ya que dibuja una imagen diferente 60 veces por segundo, al contrario que el cine, que lo hace a 24 imágenes progresivas por segundo. Hablamos aquí de velocidades de reproducción para exhibición. Las cámaras de cine tienen la habilidad de registrar a velocidades variables -por ejemplo, las explosiones en las películas de acción se registran hasta a 300 cuadros (fotogramas) por segundo, que al ser reproducidas luego a 30 dan una excelente cámara lenta- y existe una cámara de vídeo digital llamada Varicam, capaz de registrar hasta 200 cuadros por segundo.

Las videocámaras de escaneo progresivo son generalmente más deseables por las similitudes que comparten con el cine. Ambos graban las imágenes progresivamente, lo que resulta en una imagen más nítida. Ambos pueden rodar a 24 imágenes por segundo, lo que resulta en movimiento "strobing" (hace borroso el objeto cuando hay un movimiento rápido). Así, las videocámaras de escaneo progresivo tienden a ser más caras que sus homólogas entrelazadas. Aunque el formato de vídeo digital solamente permite 29,97 imágenes entrelazadas por segundo [o 25 en PAL], el vídeo progresivo a 24 imágenes por segundo es posible mostrando campos idénticos para cada imagen, y mostrando 3 campos de una imagen idéntica para ciertos cuadros de imagen.[9]

El vídeo digital puede copiarse varias veces sin degradación en la calidad y puede ser procesado y editado en una estación de edición no lineal. Este equipo frecuentemente puede importar video tanto de fuentes analógicas como digitales, pero no están pensado para hacer algo diferente a editar vídeos. El vídeo digital también puede editarse en un ordenador de sobremesa que reúna las características necesarias. Usando una estación de edición no lineal, el vídeo digital puede manipularse para seguir un orden, o secuencia, de clips de vídeo.

Al margen del programa, el vídeo digital se edita generalmente en una configuración con abundante espacio de disco. El vídeo digital con una compresión estándar DV/DVCPRO ocupa unos 250 megabytes por minuto o 13 gigabytes por hora.

El vídeo digital tiene un coste considerablemente más bajo que la película de 35 mm, ya que las cintas pueden verse en el lugar de rodaje sin revelarse, y la propia cinta es muy económica (alrededor de 3,5€ para una cinta MiniDV de 60 minutos, al por mayor, a diciembre de 2005). En comparación, una película de 35 mm cuesta alrededor de 1200€ por minuto, incluyendo el revelado.

El vídeo digital se usa fuera de la creación de películas. La televisión digital, incluyendo la HDTV, comenzó a extenderse en la mayoría de los países desarrollados a principios de la década de 2000. El vídeo digital también se usa en teléfonos móviles modernos y sistemas de videoconferencia. El vídeo digital también se usa para la distribución en Internet de vídeo, incluyendo el vídeo streaming y la distribución de películas entre iguales.

Existen muchos tipos de compresión de vídeo para servir vídeo digital sobre Internet, y en DVD. Aunque el vídeo DV no está comprimido más allá de su propio códec mientras se edita, los tamaños de archivo que resultan no son prácticos para la entrega en discos ópticos o sobre Internet, con códecs como el formato Windows Media, MPEG2, MPEG4, Real Media, el más reciente H.264, y el códec de vídeo Sorenson. Probablemente los formatos más ampliamente usados para entregar vídeo sobre Internet son MPEG4 y Windows Media, mientras MPEG2 se usa casi exclusivamente para DVD, proporcionando una imagen excepcional en el mínimo tamaño pero resultando en un alto nivel de consumo de CPU para descomprimir.

La resolución más alta demostrada para la generación de vídeo digital, hasta el año 2007 era de 33 megapixels (7680 x 4320) a 60 imágenes por segundo (UHDV), aunque esto solo se ha demostrado en una configuración especial de laboratorio.[10] La velocidad más alta se consigue en cámaras de alta velocidad industriales y científicas que son capaces de filmar vídeo 1024x1024 hasta 1 millón de imágenes por segundo durante breves periodos de grabación.

Relación de Aspecto

Resumir

Contexto

La relación de aspecto se refiere a la proporción entre el ancho y largo de la pantalla en la cual se proyectan las imágenes. La misma se expresa a través de un par de números que detallan el aplanamiento de la imagen. Para poder descubrir la relación de aspecto que posee un determinado vídeo simplemente se debe dividir su ancho y altura, es decir que la misma puede expresarse implementando la fórmula “ancho:altura”.[11]

Un ejemplo claro sería en el caso de una imagen de 24cm de ancho y 18cm de alto, su relación de aspecto está demostrada en el cociente de esos valores. La división de estos números da como resultado 1,33 (que es lo mismo que daría el resultado de 4 dividido 3). Por lo tanto la pantalla de 24:18 posee una relación de aspecto de 4:3.

Históricamente los estándares otorgaron la relación de aspecto 4:3 (o en otras palabras 4 veces ancho por tres de alto), dando así una imagen bastante cuadrada en televisores y sistemas de video. Sin embargo, en la actualidad predomina la relación utilizada en los LCD y LEDs digitales de 16:9 (16 de ancho y 9 de alto), un formato más panorámico que el anterior.

Cuando no se respetan estas relaciones de aspecto, el video en cuestión tenderá a verse angosto, estrecho o estirado, es decir que el video puede presentar personajes, objetos delgados, altos, en fin, «deformados» por la falta de atención en la relación de aspecto. Para sortear ese problema se recurren a barras negras a los laterales del video para así completar la totalidad de la pantalla a cambio de perder imágenes en los costados.

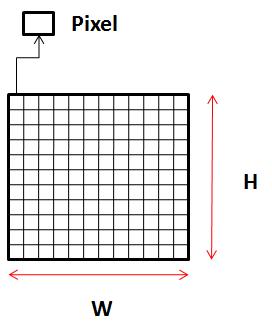

Los videos se almacenan en la computadora como una sucesión de imágenes rectangulares formadas por píxeles cuadrados. Cada píxel es encargado de almacenar un color y a mayor cantidad de píxeles en una imagen digital, mayor será el detalle o resolución de la misma. El video digital almacenado en una computadora no tiene muchas limitaciones en cuanto a la resolución, pero formatos determinados permiten ciertas resoluciones.

- VHS: 300x360 (Por compatibilidad, el VHS se suele capturar con el mismo tamaño que el VCD).

- VídeoCD (VCD): 352x288 PAL, 352x240 NTSC

- SuperVCD (SVCD): 480x576 PAL, 480x480 NTSC

- ChinaVideoDisc (CVD): 352x576 PAL, 352x480 NTSC

- DV y DVD: 720x576 PAL, 720x480 NTSC.[11]

Mientras más resolución tenga, mayor será la calidad y el detalle pero ocupará más espacio de almacenamiento.[12]

Si calculamos la relación de aspecto 720/480 = 1.5, podemos observar que no es la relación de aspecto de un TV clásico ni panorámico: la resolución de un video en pixeles tiene poco que ver con la relación de aspecto normal de la TV. La razón de esto es que se buscó una relación que pudiera cubrir entre 1.33:1 (4:3) y 1.78:1 (16:9). Para llegar entonces a cubrir tales relaciones de aspecto, se encoge o se estira la imagen de forma que llene el área visible: en la imagen 4:3 se completa la pantalla recortando la imagen y en la 16:9 se estira o es bordeada con bandas negras cuando se va a reproducir en la pantalla según el dispositivo.

Compresión de vídeo

Resumir

Contexto

Cuando se habla de compresión de vídeo se refiere a la reducción de datos y por lo tanto del tamaño de un vídeo digital. La misma consta de una comprensión espacial de las imágenes del vídeo y lo compensa en su movimiento temporal. Lo que se intenta conseguir con la compresión es desechar/eliminar aquellos datos que contengan información que sea redundante, ya sea de manera espacial como temporal en el vídeo.

Tipos de algoritmos de compresión de datos

Según el método de compresión que se utilice se puede dar una compresión sin pérdida, que significa que la calidad de la señal decodificada es igual teóricamente a la calidad de la señal de la fuente, y también, una compresión con pérdidas, que significa que la reconstrucción de la señal decodificada no es totalmente fiel a la señal de la fuente porque intervienen aspectos que reducen la cantidad de información, ya que se considera innecesaria porque no es perceptible para el observador final, en este sentido se prioriza tener una calidad máxima subjetiva. Este proceso es irreversible, ya que no se puede recuperar la información original una vez que fue eliminada en la compresión.

Cuando un conjunto de datos es comprimido y se hace una descompresión que reproduce el dato original exacto, el tipo de compresión se llama sin pérdidas lo que significa que no hay degradación/eliminación de datos.

El método más simple consiste en reducir únicamente la redundancia de la codificación, esta redundancia está presente en cualquier codificación binaria de los niveles de gris en una imagen. Se puede eliminar construyendo un código de longitud variable que destine las palabras código más pequeñas a los niveles de gris más probables.

Los más usados son la codificación Huffman y la codificación aritmética.

Todas las formas de compresión involucran la eliminación de datos de la imagen. Esta primero se transforma en otra, y entonces se suprimen partes de ella. Los métodos en que se suprimen los datos son los que distinguen distintos esquemas de compresión de vídeo con pérdida.

Métodos de compresión de archivos de video

Existen dos métodos de compresión de vídeo: Interframe e Intraframe.

Intraframe: es el tipo de compresión que encuentra información similar en un conjunto de píxeles, los unifica y quita aquello redundante y quitando leves diferencias que el ojo humano no detecta. También se la conoce con el nombre de “compresión espacial”.

Interframe: elimina los datos redundantes entre diferentes fotogramas, cuando se detecta que la información entre un cuadro y el otro no cambia la repite en los siguientes y solo cambia los píxeles que sí tienen modificaciones.

Este tipo de compresión también es conocida como “compresión temporal”. Gran parte de las técnicas de compresión se ejecutan a través de detección de información repetitiva lo que disminuye notablemente el tamaño del fichero.[13]

Existen algoritmos de codificación que reducen considerablemente el tamaño de los archivos de vídeo. Esto produce que sean más manejables y fácilmente almacenables. Son los llamados Códecs. Su nombre deriva de las palabras compresión y descompresión.[14]

La “relación de compresión” se puede expresar de la siguiente manera:

C= Flujo binario a la entrada del codificador / Flujo binario a la salida del codificador[15]

Interfaces y cables

Se han diseñado muchas interfaces específicas para responder a los requisitos del vídeo digital sin comprimir (a aproximadamente 400 Mbit/s):

- Interfaz Digital Serial.

- FireWire

- High-Definition Multimedia Interface

- Digital Visual Interface

- Unified Display Interface

- DVB-ASI, para transportar vídeo comprimido según los estándares MPEG.

El vídeo comprimido también se transporta usando UDP-IP sobre Ethernet. Existen 2 enfoques para esto:

Estándares y métodos[16]

Resumir

Contexto

Codificación

Todos los formatos actuales, que se enumeran debajo, están basados en PCM.

- Motion JPEG, usado en MiniDV y videocámaras domésticas.

- MPEG-1, usado para vídeo CD.

- MPEG-2, usado para DVD, Super-VCD y para señal banda base de televisión digital.

- MPEG-4, usado para la compresión de datos de audiovisuales para la web, distribución de CD, voz y difusión de aplicaciones de televisión.

- CCIR 601, usado para estaciones de difusión.

- H.264 también conocido como MPEG-4 Part 10, o AVC.

- Theora, codec libre de video, estandarizado pero aún en desarrollo, usado para vídeo sobre Internet.

Difusión

- DVB, difusión de vídeo digital (Digital Video Broadcasting).

- DVB-S, difusión de vídeo digital por satélite (DVB - Satellite).

- DVB-S2, segunda generación de DVB-S.

- DVB-C, difusión de vídeo digital por cable de banda ancha (DVD - broad-band Cable), también conocido como ITU-T J83A.

- DVB-C2, segunda generación de DVB-C.

- DVB-T, difusión de vídeo digital terrenal (DVB - Terrestrial).

- DVB-T2, segunda generación de DVB-T.

- DVB-H, difusión de vídeo digital en dispositivos móviles (DVB - for Hand-helds).

- DVB-SH, estándar híbrido para difusión por satélite y terrenal dirigida a dispositivos móviles.

- DVB-S, difusión de vídeo digital por satélite (DVB - Satellite).

- ITU-T J83B, difusión de vídeo digital por cable de Estados Unidos.

- ITU-T J83C, difusión de vídeo digital por cable de Japón.

- ATSC, difusión de vídeo digital terrenal de Canadá y Estados Unidos (Advanced Television Systems Committee).

- ISDB-T, difusión de vídeo digital vía terrenal de Japón (Integrated Services Digital Broadcasting-Terrestrial).

- SBTVD, versión brasileña de ISDB-T, también conocido como ISDB-Tb.

- DTMB, difusión de vídeo digital vía terrenal de China (Digital Terrestrial Multimedia Broadcast).

- CMMB, difusión multimedia para terminales móviles de China (Chinese Mobile Multimedia Broadcasting).

Almacenamiento en cintas

- Betacam, Betacam SP, Betacam SX, Betacam IMX, Betacam Digital o DigiBeta: sistemas de vídeo comerciales de Sony, basados originalmente en la tecnología Betamax.

- D1, D2, D3, D5, D9 (también conocido como Digital-S): estándares comerciales de vídeo digital definidos por SMPTE.

- DV, MiniDV: usado en la mayoría de las videocámaras basadas en cinta de vídeo del mercado de consumo de hoy en día; diseñado para alta calidad y fácil edición; puede también grabar datos de alta definición (HDV) en formato MPEG-2.

- DVCAM, DVCPRO: usado en operaciones de difusión profesionales; similar al formato DV pero generalmente considerado más robusto; aunque son compatibles con DV, estos formatos manejan mejor el audio.

- Digital8: datos en formato DV grabados en cintas compatibles con Hi8; en gran parte un formato para el mercado de consumo.

- MicroMV: formato para video MPEG-2, actualmente obsoleto.

- D-VHS: formato para video MPEG-2, en una cinta similar a la del tipo S-VHS.

Almacenamiento en discos

Referencias

Véase también

Enlaces externos

Wikiwand - on

Seamless Wikipedia browsing. On steroids.