Loading AI tools

Die Multimedia-Technologien beschäftigen sich mit den technischen Grundlagen aller multimedialen Anwendungen. Dieser Artikel befasst sich zum einen mit den hardwaretechnischen Grundbausteinen sowie mit den Grundlagen der computergestützten Grafik- und Audiotechnik. Der steigende Bedarf an neuen, verbesserten Verfahren und Systemen treibt die Entwicklungen im Bereich der Multimedia stark an. Dabei prägt die Gesellschaft nicht nur den Bedarf, sondern die Multimedia-Technologien führten selbst zu gesellschaftlichen Wandlungen.

Leistungsfähige und Technikbereich-übergreifende Hardware stellt die Grundkomponente eines jeden Multimedia-Systems dar. Mit der Verbreitung des Internets begann zudem die Entwicklung netz-basierender Multimedia-Technologien. Die Netzwerke müssen ein hohes Maß an Dienstgüte erreichen, um den Anforderungen der Multimedia gerecht werden zu können. Der große Durchbruch gelang mit der Entwicklung optischer Datenspeicher, wodurch es möglich wurde, große Datenmengen einfach und mobil zu speichern.

Hardware

Für berechnungsintensive Anwendungen wie Videoschnitt wird eine leistungsstarke Hardware benötigt. Dazu gehören vor allem gute Prozessoren, große Arbeitsspeicher und allgemein starke Grafikkarten. Externe Hardware wie Lautsprecher oder Kameras gehören genauso zu der grundlegenden Ausrüstung von Multimedia-Systemen.

Nach diesen Anforderungen versuchte die Industrie unter der Leitung von Microsoft, Creative Labs, Dell, Gateway, Fujitsu und weiteren in den 90er Jahren einen Hardware-Standard für Multimedia-Systeme durchzusetzen. Nach diesem Standard, welcher den Namen "Multimedia PC" (kurz MPC) trägt, waren die PC-Systeme so vorkonfiguriert, dass sie alle gängigen Multimedia-Anwendungen unterstützen konnten. Insgesamt gab es drei Spezifikationsstufen vom Jahre 1991 bis ins Jahr 1996. Sie konnten sich aber nicht bei allen Herstellern durchsetzen. Später wurde die Entwicklung der Hardware vielmehr durch neue Anwendungen wie Videoschnitt, Bildbearbeitung und Computerspiele vorangetrieben.

Die höchsten Anforderungen an die Hardware-Systeme setzt heutzutage die Computerspielbranche. Dabei spielen vor allem folgende Punkte eine wesentliche Rolle:

- Breitband-Internetzugang

- 3D-Grafikunterstützung#* intuitive Eingabegeräte

- Multicore-Unterstützung, Multithreading

- Surround-Sound

wichtige Komponenten für ein Multimediasystem:

Datenspeicher

In der Von-Neumann-Architektur existieren in jedem Modul Speicherzellen. Deswegen spielt vor allem der Datenspeicher eine wesentliche Rolle in der Verarbeitung von Multimedia-Daten. Anders als bei der Entwicklung der Prozessoren, stieg die Leistung in Form von Speicherplatz stetig weiter.

Wichtige Leistungsmerkmale von Speichern sind:

- flexible Datenzugriffe

- schnelle Datenlese- und schreibraten

- Speicherplatzgröße auf minimalem Raum

Vor allem bei der Videoverarbeitung fallen große Datenmengen an, die schnell von der Festplatte in den Arbeitsspeicher geladen werden müssen. Doch dabei spielt nicht nur die Hardware eine Rolle, sondern auch das Betriebssystem, welches auf dem Speicher ein Dateisystem anlegt und somit die Verwaltung der Daten übernimmt.

Prozessoren

Multimedia-System bauen nicht nur auf einen Hauptprozessor (CPU) auf, sondern aus mehreren nebenläufigen Prozessoren aus dem Betrachtungsfeld. Weitere wichtige Prozessoren sind:

- Grafikprozessor auf der Grafikkarte

- Kommunikationsprozessor auf der Netzwerkkarte

- die Signalprozessoren auf der Soundkarte

Weiterhin existieren spezielle Multimedia-Prozessoren, wie zum Beispiel AMD Xilleon oder AMD Imageon, welche auf die Bild- und Videobearbeitung optimiert wurden.

Multimedia-Software nutzt meist nicht die gesamte Wortlänge (d. h. Integer), sondern legt mehr Wert auf short- oder char-Werte. Daher wurden Prozessorarchitekturen wie Single Instruction Multiple Data (SIMD) entwickelt, welche mehrere kleine Daten in einem Befehl verarbeiten. Aufgrund der hohen Parallelisierbarkeit bei der Verarbeitung von Bilddaten wurden Erweiterungen wie MMX geschaffen, um den neuen Anforderungen der Multimedia-Anwendungen gerecht werden zu können.

Grafikkarten

Mit den steigenden Anforderungen der Computerspielbranche stieg der Bedarf an eine Recheneinheit, die sich auf grafische Aspekte spezialisierte. Dafür beinhalten Grafikkarten eigene Prozessoren (meist GPUs genannt), welche sich vor allem für eine schnelle Bildverarbeitung eignen. Durch diese Spezialisierung sind sie den universellen CPUs in den Bereichen paralleler Berechnungen überlegen.

Monitore

Um die Leistung von Grafikkarten optimal auszunutzen, sollte der genutzte Monitor die Leistungsmerkmale der Grafikkarte unterstützen.

Leistungskriterien:

- Auflösung

- Bildwiederholfrequenz

- Farben

- Helligkeit

- Kontrast

- Reaktionszeit bei Flüssigkristallbildschirmen

- Schnittstellen (HDMI, VGA)

- Seitenverhältnis

- Vertikalfrequenz

Soundkarten

Soundkarten werden benötigt, um digitale in analoge Signale umzuwandeln (und umgekehrt).

Leistungskriterien:

- Dynamik

- Frequenzgang

- Klirrfaktor

- Spannung am Line-In, Line-Out

- Störabstand

Lautsprecher

Für die akustische Wiedergabe der Audiodaten werden Lautsprecher benötigt, die direkt an der Soundkarte angeschlossen werden.

Leistungskriterien:

- Frequenzgang

- Impedanz

- Klirrfaktor

- Musikbelastbarkeit

- Schallleistung

- Sinusbelastbarkeit

- Wirkungsgrad

Betriebssysteme

Betriebssysteme bilden die Verbindung zwischen der Rechner-Hardware und den Software-Komponenten und dient somit auch als Schnittstelle vieler multimedialer Anwendungen. Die Quellen von Mediendaten liegen meist in Hardwarekomponenten wie Mikrofonen, Kameras oder Touchpads und ihre Ziele sind wiederum Lautsprecher, Videofenster oder der Anwender selbst. Für die Verarbeitung dieser Daten muss das Betriebssystem mindestens eine Verschiebungs-, Kopier- oder Übertragungsoperation ausführen. Hierbei spielen u. a. die Echtzeitverarbeitung, Prozessverwaltung, Betriebsmittelreservierung, Betriebsmittelverwaltung und Speicherverwaltung wichtige Rollen.

Multimedia Frameworks

Frameworks wie DirectX oder auch OpenGL stellen eine Programmierschnittstelle für multimediaintensive Anwendungen dar. Dabei gibt es für jedes Multimedia-Modul eine Komponente. Hierbei soll es dem Programmierer ermöglicht werden einen schnellen und direkten Zugriff auf die Grafikkarte zu erhalten.

- DirectMusic ist die Komponente, welche als Synthesizer zur Wiedergabe von MIDI-Files fungiert.

- DirectShow ist vor allem für das Streaming von Video- und Audiodaten bedeutend.

- Mit DirectSound / XAudio können Klangeffekte verbessert werden und Schnittstellen zur Aufnahme und Wiedergabe von Audio-Signalen erstellt werden.

- DirectX stellt dabei seine DirectX-Graphics-Komponente zur Verfügung, welche DirectDraw für 2D-Grafiken und DirectX für 3D-Grafiken vereint.

Bei der 3D-Grafik spielt die Hardwarebeschleunigung eine bedeutende Rolle.

Eine quelloffene ("open source") und plattformunabhängige Alternative zu DirectX ist OpenGl.

Netzwerke

Um einen kontinuierlichen Datenaustausch zwischen Mediengeräten gewährleisten zu können, müssen Netzwerke über geeignete Dienste und Protokolle geschaffen werden.

Kommunikation

Voraussetzung für die Kommunikation in einem interaktiven Netzwerk sind geringe Verzögerungen, Unterstützung für die Übertragung hoher Datenraten und eine geringe Fehlerrate. Um dies zu ermöglichen, wurden Netzwerktechnologien wie FDDI, High-Speed-Ethernet, Token Ring und ATM geschaffen. Die Kommunikation zwischen Multimedia-Systemen, welche die Vermittlungsschicht bildet, wird über Netz- und Transportprotokolle realisiert.

Anforderungen an Dienste und Protokolle

- Je nach Anwendung erfordern Audio- bzw. Videodaten eine zeitbegrenzte Bearbeitung. Die Datenübertragung muss dementsprechend während der vorgegebenen Intervalle erfolgen.

- Die Verzögerung zwischen den Endnutzern einer Anwendung, wie zum Beispiel aus dem Dialogbetrieb (z. B. Telefon), müssen gering gehalten werden.

- Das Hauptanwendungsgebiet kommunikationsfähiger Multimediasysteme liegt meist auf kooperatives Arbeiten und Konferenzsystemen unter Verwendung mehrerer unterschiedlicher Medien. Das Verbinden und Trennen von Konferenzmitgliedern sollte gelingen, ohne dass die Konferenzverbindung völlig neu aufgebaut werden muss.

- Bei der Übertragung bevorzugter oder garantierter Multimedia-Daten darf es zu keiner Einschränkung bei der Kommunikation der restlichen Daten kommen.

- Um das Fairnessprinzip zwischen unterschiedlichen Anwendungen, Anwendern und Stationen zu schützen, darf kein Client bevorzugt werden.

Meist werden zugrundeliegende Netzsysteme, zum Beispiel das Ethernet, für kommunikative Multimedia-Anwendungen genutzt und keine neuen separaten Netzwerke geschaffen. Die Annahme, dass für multimediale Kommunikationssysteme mindestens eine Bandbreite von mindestens 100 Bit/s benötigt wird, ist somit nicht grundsätzlich wahr.

Wichtige Protokolle im Überblick

IGMP (Internet Group Management Protocol):

- kann Internet-Multicast-Gruppen verwalten

- dynamisches An- und Abmelden von Systemen möglich

- muss selbst nicht Mitglied der Gruppe sein

IP (Internet Protocol):

- ermöglicht Datenübertragung zwischen Absender und Zielsystem

- mehrere Transfersysteme (Gateways oder Router) können durchlaufen werden

RTP (Real-Time Transport Protocol):

- unterstützt Multicast-Sitzungen

RTSP (Real-Time Streaming Protocol):

- steuert keine Nutzdaten, sondern Datenströme

- ähnlich wie HTTP, jedoch bidirektional und zustandbasiert

SIP (Session Initiation Protocol):

- richtet Sitzungen ein und übernimmt dann das Management der Sitzung

TCP (Transmission Control Protocol):

- wird für Videokonferenzen benötigt

TP (Telnet Protocol):

- umfasst das RMTP (Real-Time Message Transport Protocol) und MTP (Continuous Media Transport Protocol)

- unterstützt Übertragung von Multimedia-Daten, da es beim Ausliefern von Daten gewisse Leistungen garantiert

Dienstgüte

Die Dienstgüte (englisch QoS (Quality of Service)) ist ein grundlegendes Konzept für Multimediasysteme. Mit ihr können quantifizierbare technische Parameter für Netzwerke in Echtzeit erfasst, verarbeitet, übertragen und dargestellt werden. Eine Bewertung des Multimediasystems ist vor allem im Sinne vom Ressourcenmanagement wichtig.

Betriebsmittel (Dienstgüte)

- Bandbreite

- Latenz-/Laufzeit

- maximale Bitfehlerrate

- maximaler Paketverlust

- Prozessorleistung

- Speicherplatz

Für die Verwaltung der Betriebsmittel existieren die beiden Ansätze Skalierung und Ressourcenreservierung, die häufig zeitgleich zum Einsatz kommen.

Die Skalierung bezeichnet eine möglichst einfache Anpassung des Datenflusses an vordefinierte Randbedingungen. Dafür werden die Betriebsmittel in Beziehung mit dem Datenstrom gesetzt.

Der Zweite betrachtet einzelne Komponenten als Ressourcen, die noch vor der Ausführung der Evaluation reserviert werden müssen. Sobald alle Ressourcen reserviert wurden, kann beim Ressourcenmanagement eine sinnvolle Zuteilung der Betriebsmittel erfolgen.

Schwer oder nicht quantifizierbare Eigenschaften

- Bedienbarkeit der eingesetzten Endgeräte

- nicht vorhersagbare Einflüsse von außen

- Störungen im Netzwerk

Optische Datenspeicher

Mit der Entwicklung optischer Speicher wurde die Multimedia-Welt grundlegend revolutioniert. Sie sind hauptsächlich wegen ihrer hohen Anforderungen interessant, da sie im Gegensatz zu magnetischen Massenspeichern ein wahlfreien Zugriff ermöglichen. Weitere Vorteile gegenüber den veralteten magnetischen Speichern sind ihre Haltbarkeit und die geringe Abnutzung.

Im Laufe der Entwicklung optischer Speicher war es immer das Ziel die Daten so kompakt wie möglich auf die Speichermedien zu verpacken, um eine hohe Speicherkapazität zu erhalten. So ist der einzige grundlegende Unterschied zwischen der Compact Disk (CD) und der Digital Versatile Disc (DVD) die deutlich höhere Speicherkapazität aufgrund einer höheren Datendichte.

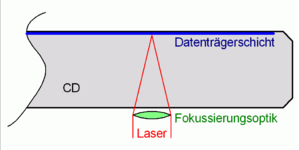

Die Idee besteht darin, die Intensität des an einer vorgeformten Oberfläche reflektierten Lichtes auszuwerten, um damit auf die Codierung der Daten schließen zu können. Dabei werden Laser mit einer Wellenlänge von ungefähr 780 nm (bzgl. CDs) genutzt, um den Fokus so gering wie möglich zu halten.

Auf der Speicherdisk liegt eine Substratschicht, welche zum einen Vertiefungen (Pits) und Plateaus (Lands) beinhaltet. Durch das abwechselnde Lesen von Pits und Lands kann die Codierung aus 1en und 0en decodiert werden.

| Typ | Wellenlänge Numerische Apertur |

Schnittzeichnung der Strahlgeometrie |

|---|---|---|

| CD | Wellenlänge: 780 nm Numerische Apertur: 0,45 Spotdurchmesser: 2,1 µm Spurabstand: 1,6 µm |  |

| DVD | Wellenlänge: 650 nm Numerische Apertur: 0,6 Spotdurchmesser: 1,3 µm Spurabstand: 0,74 µm |  |

Wenn die Daten auf das Speichermedium aufzutragen sind, werden die nötigen Bits als Pits in die Substratschicht eingebrannt (siehe auch Brenner). Dabei wird die gesamte Information auf eine Spur aufgetragen, wodurch das Speichern kontinuierlicher Daten vereinfacht wird. Die Spur besitzt die Form einer Spirale, wobei der Abstand zwischen den Spuren 1,6 µm und die Spurbreite der Pits 0,6 µm beträgt. Zusammen bewirkt das eine Datendichte von bis zu 1.000.000 bit/mm².

Audio

Audiosignale

- Geräusch

- Klang mehrere Frequenzen überlagert

- Knall

- Partitur

- Rauschen

- Sprache

- Ton eine Frequenz

Zusammensetzung der Audiosignale

Entscheidend für die technische Umsetzung von Audiosignalen sind die folgenden Eigenschaften:

Frequenz

Die Frequenz im Audiosignal bestimmt die Tonhöhe des aufgenommenen Schalles. Das Frequenzspektrum erstreckt sich logarithmisch von 10 kHz bis zu 10 MHz und stellt die 8 Grundtöne dar.

Druckpegel

Der Druckpegel ist ein logarithmisches Maß zur Beschreibung der Stärke eines Schallereignisses.

Richtung

Die Richtung des Schallereignisses ist für das räumliche Hören wichtig. Dabei sind folgende Punkte entscheidend, um eine Richtung und den dazugehörigen Abstand wiedergeben zu können.

- Nachhall

- Schallabsorption

- Schallschatten

- Signallaufzeiten

Die Audioqualität wird durch die Richtung in großen Gebäuden, wie zum Beispiel Opern und Kinos, stark verbessert.

Klangfarbe

Mithilfe der Klangfarbe kann man Stimmen von Instrumenten unterscheiden. Die Klangfarbe wird durch die Amplitude in der Signalkurve dargestellt. Dabei werden schrille Töne mit den hohen Ausschlägen und dumpfe Töne mit tiefen Ausschlägen dargestellt.

Audiodateien

- Parameter:

- Abtastfrequenz in kHz

- Anzahl an Kanälen

- Kompressionsrate in kbps

Aus diesen Parametern resultiert die Größe der Audiodatei.

Kompression

Man kann die Audiokompression in zwei große Teilbereiche untergliedern. Zum einen ist dies die verlustlose Audiokompression (Datenkomprimierung), zum anderen die verlustbehaftete Audiokompression (Datenreduktion).

Die Datenkomprimierung nutzt universellere Komprimierungsverfahren wie LZW, oder die Huffman-Kodierung. Somit stellt diese Komprimierungsart keine weitere Besonderheit unter der Audiokompression dar.

Datenreduktion

Man versucht mit Hilfe der Datenreduktion Töne aus dem Frequenzspektrum zu entfernen, die keinen Beitrag zur Klangqualität leisten. In der Vorarbeit wird ein Frequenzspektrum der Audiodatei mit Hilfe von Fast-Fourier-Transformation (FFT) oder der Diskreten Kosinus-Transformation (DCT) erstellt.

Des Weiteren werden folgende Punkte durchgeführt:

- Hörschwellenmaskierung

Hierbei werden die Töne entfernt, welche im Frequenzspektrum der Datei außerhalb der menschlichen Hörschwelle liegen.

- Frequenzmaskierung

Viele Töne werden von anderen Tönen überdeckt und sind somit für das menschliche Gehör von keiner höheren Bedeutung.

- Zeitmaskierung

Unter der Verwendung der Zeit können zeitliche Überlagerungen von Tönen gezielt aufgefunden und entfernt werden.

- Stereoredundanz

Oftmals werden auf verschiedenen Kanälen ein und dasselbe Signal übertragen, dies versucht man an dieser Stelle zu unterbinden. Abhängig vom Verfahren kann es ab diesem Punkt zu erheblichem Qualitätsverlust kommen.

- Koeffizientenquantisierung

Zum Schluss werden die Koeffizienten des Frequenzspektrums noch quantisiert, wobei sich ein sogenannter Quantisierungsfehler bemerkbar macht (6 dB Rauschen pro weggelassenem Bit).

Komprimierte Audioformate

Film / DVD / DF1:

- Dolby AC-3 (Dolby Digital)

- MPEG 2 AAC, bis zu 48 Audiokanäle

- MPEG 2 Layer 2

Internet:

Radio-TV / ADR / DAB:

- MPEG 2 Layer 2

Stereoanlage:

- Digital Compact Cassette (DCC): MPEG 1 Layer 2 (192 kbit/s)

- Sony Minidisc (MD)

Grafiken

Bildformate:

| Bildformate | Kompression (verlustfrei/behaftet und Art) | unterstützte Farbmodelle | Transparenz- unterstützung | unterstützte Bittiefen | Anzahl und Art der Kanäle | Vor- und Nachteile | Häufiger Einsatzzweck |

| Bitmap | verlustfrei (RLE) | RGB,SW,induzierte Farben | nein | 1, 4, 8 und 24 | 4 | +leichte Erzeugung -Größe | Laserdrucker |

| JPEG | verlustbehaftet (Huffman, DCT) | RGB, CMYK, Graustufung | nein | 24 | 3 oder 4 | +gut für fotografische Bilder +Größe -schlecht für digital erzeugte Bilder | Fotos |

| GIF | verlustfrei (LZW) | induzierte Farben | ja | 1–8 | 1 | +Animationen +für Internet gut geeignet wegen geringer Größe | Internet |

| PNG | verlustfrei (LZW-Variante) | RGB, Graustufung | ja | 8, 16, 24, 48 | 3+1Alpha-Kanal | +auch 24 Bit +Interlaced | Rastergrafik |

| RAW | keine Kompression | RGB, Graustufung | keine | bis 14 | 3 | +qualitativ bestes Format für Fotos -Größe | Fotos |

| SVG | verlustfrei (gzip) | RGB | ja | 24 | 3 | +verlustfreie Skalierbarkeit -werden schnell sehr groß | Internet |

| TIFF | verlustfrei (LZW-Variante) | CMYK,SW,RGB | ja | 1–48 | 1, 3 oder 4 | +Plattformunabhängig +viele Meta-Informationen ablegbar -viele Unterformate | Fotos |

Bildgröße und Auflösung

Während die Bildgröße die Gesamtanzahl der Bildpunkte (Pixel) angibt, ist die Auflösung genauso wie die Bittiefe ein Qualitätsmerkmal für die Grafik.

- Bildgröße

- stellt die Gesamtzahl der Bildpunkte dar

- Anzahl der Spalten (Breite) und Zeilen (Höhe)

- Auflösung:

- Bildelemente pro Länge in ppi (pixel per inch) angegeben

- Punktdichte einer Wiedergabe oder Bildabtastung

- neben der Farbtiefe ein Maß für die Qualität

- Bei Rastergrafiken kann keine Auflösung angegeben werden, da dies von der Wiedergabe abhängt

Bittiefe

Mit Hilfe der Bit- oder Farbtiefe möchte man ein geeignetes Farbspektrum auffalten, welches für das geschaffene Bild relevant ist. Grundsätzlich gilt: Mit n Bits sind 2^n Farben darstellbar.

Mit 16 Bit erhält man einen Farbraum von 65.000 Farben, diesen Farbraum nennt man "high color".

32 Bit und damit 16.000.000 Farben sind ausreichend, um den natürlichen Farbraum qualitätsnahe zu repräsentieren. Bei 32 Bit Farbtiefe spricht man von "true color".

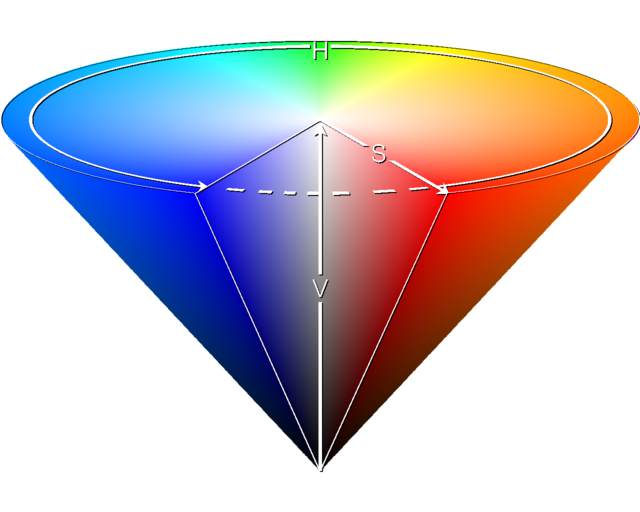

Farbmodelle

Farbmodelle sind geometrische oder mathematische Rahmenwerke, welche die Farbwahrnehmung des Menschen beschreiben sollen. Dafür besitzen Farbmodelle eine oder mehr Dimensionen, die zusammen das sichtbare Spektrum der Farben darstellen.

Um die Farben beschreiben, berechnen, vergleichen oder ordnen zu können, werden die Farben numerisch indiziert.

Mit moderneren Modellen, wie im HSK-Farbmodell, wurde die Lichtintensität als zusätzliche Dimension eingefügt, um Schattierungen besser wiedergeben zu können.

Kanäle

Der Farbkanal enthält die Farbanteile jedes Pixels (Bildpunkts) im digitalen Bild. Dabei können jedem Pixel mehrere Farbkanäle zugeordnet sein. Der rote Farbkanal definiert, wie viel Rot in einem Pixel enthalten ist, der grüne Farbkanal wie viel Grün und so weiter. Somit deutet die Kanalanzahl auf das Farbmodell hin.

Dithering

Das Dithering stellt die Fehlerdiffusion bei Farbverläufen in Bildern dar. Dieses wird genutzt, um Farbabstufungen bei Bildern mit wenig Farben nachzubilden. Mit Hilfe von bestimmten Pixelanordnungen wird somit ein künstlicher Farbverlauf erzeugt. Das menschliche Auge nimmt Dithering als Mischung einzelner Farben wahr und es entsteht die Illusion einer größeren Farbtiefe.

Transparenz

Transparenz (Durchsichtigkeit) bezeichnet in der Computergrafik Bildelemente, die die Inhalte darunter befindlicher Elemente ganz oder teilweise sichtbar lassen.

Für Bitmaps wird ein zusätzlicher α-Kanal genutzt, welcher für jeden einzelnen Pixel seine Transparenz angibt.

Entwicklungen im Überblick

Die Multimedia-Technologie ist in der heutigen Welt fest verankert. Kaum eine Technologie betrifft so viele Menschen wie diese.

Bildschirmtechnologien:

- Kathodenstrahlröhre

- LCD / LED

- Neuentwicklung (noch in Test-Phase): Kontaktlinse als Bildschirm

- Projektor / Beamer

- TFT

- Touchscreen

Entwicklungen im Gebiet Bild/Grafik:

Entwicklungen im Audiobereich:

- Audiobearbeitungsprogramme (Schneid- und Konvertierungsprogramme)

- Lautsprecher

- Mikrofon

- MP3-Player

Entwicklungen im Videobereich:

- Digitalkamera

- Schneid- und Konvertierungsprogramme

- Webcam

neueste Entwicklungen:

- Augmented Reality

- optische Bewegungserkennung (Wii, eyeToy)

Technologien in der Gesellschaft

Eines der Hauptfelder der Multimediaentwicklung dürfte das E-Learning betreffen. Hier gibt es schon zahlreiche Entwicklungen, die das Lernen vereinfachen sollen.

Übungsprogramme

Übungsprogramme dienen dazu, Wissen (meist vorher erworben) durch Wiederholung und Anwendung zu festigen. Es existieren große Mengen an solchen Programmen aus fast allen Wissensbereichen und Lerntypen, angefangen bei Vokabeltrainer über elektronische Aufgabensammlungen bis mathematischen Übungsprogrammen.

Test-Software

Test-Software wird zur Durchführung und Auswertung von Lernkontrollen eingesetzt. Lerner beantworten Fragen nicht mündlich oder auf Papier, sondern am Rechner. Hierfür eignen sich besonders Multiple-Choice-Aufgaben oder Lückentexte (zum Beispiel Führerscheinprüfung). Hier wird der Lehrende entlastet, da die Leistungskontrolle elektronisch erfolgt. Bessere Tests ermöglichen adaptive Systeme, die die Art, Schwierigkeit und Anzahl der Testaufgaben dynamisch in Abhängigkeit vom bisherigen Testverlauf bestimmen.

Tutorielle Systeme

Tutorielle Systeme, oft auch Computer-Based-Training (CBT) bezeichnet, übernehmen alle Lehrfunktionen. Die Lernsoftware vermittelt dem Lernenden einen Wissensbereich, lässt Aufgaben bearbeiten, gibt Rückmeldungen über den Leistungsstand und bestimmt weiteren Lernweg in Abhängigkeit von den bisherigen Leistungen.

- Ralf Steinmetz: Multimedia-Technologie. 3., überarb. Aufl., Springer Verl., Berlin/Heidelberg/New York 2000, ISBN 978-3-540-67332-3.

Wikiwand in your browser!

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.