吉洪諾夫正則化得名於安德烈·尼古拉耶維奇·吉洪諾夫,是在自變量高度相關的情景下估計多元回歸模型係數的方法。[1]它已被用於許多領域,包括計量經濟學、化學和工程學。[2]吉洪諾夫正則化為非適定性問題的正則化中最常見的方法。在統計學中,本方法被稱為脊迴歸或嶺回歸(ridge regression);在機器學習領域則稱為權重衰減或權值衰減(weight decay)。因為有不同的數學家獨立發現此方法,此方法又稱做吉洪諾夫-米勒法(Tikhonov–Miller method)、菲利浦斯-圖米法(Phillips–Twomey method)、受限線性反演(constrained linear inversion method),或線性正規化(linear regularization)。此方法亦和用在非線性最小二乘法的萊文貝格-馬夸特方法相關。它對於緩解線性回歸中的多重共線性問題特別有用,這常見於有大量參數的模型中。[3]總的來說,這種方法提高了參數估計的效率,但也有可容忍的偏差(見偏差-方差權衡)。[4]

該理論於1970年由Hoerl與Kennard發表在《技術計量學》上的文章《嶺回歸:非正交問題的偏估計》及《嶺回歸:非正交問題中的應用》中首次提出。[5][6][1] This was the result of ten years of research into the field of ridge analysis.[7]

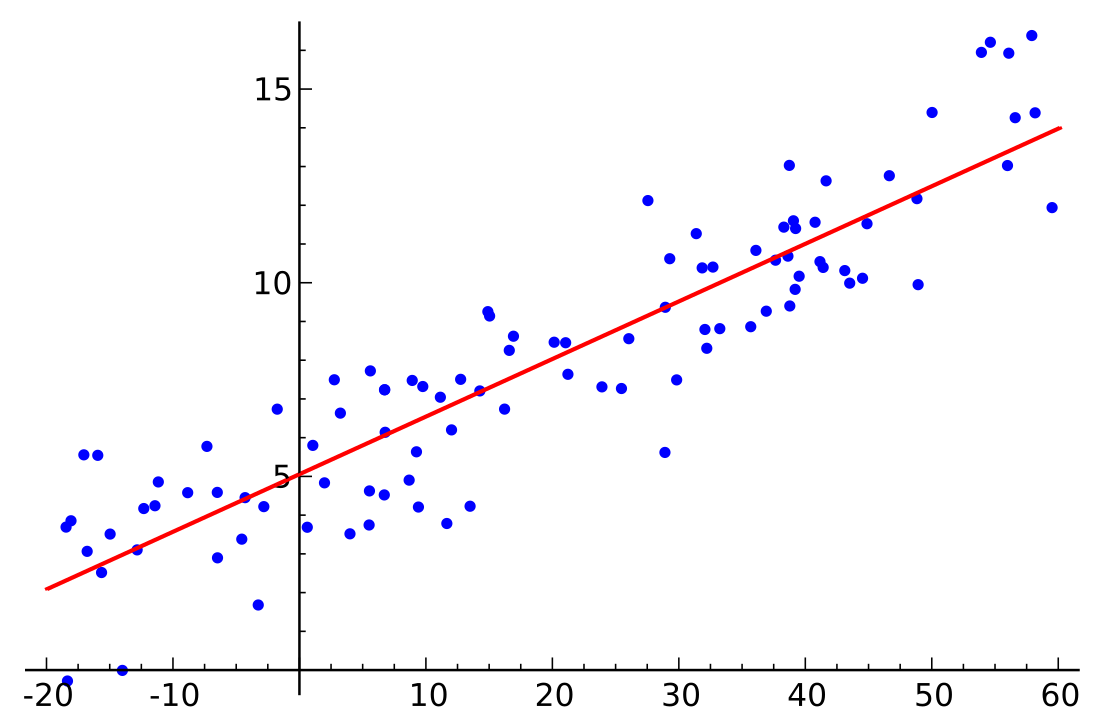

嶺回歸是通過創建嶺回歸估計量(RR)實現的。當線性回歸模型具有多重共線(高度相關)的自變量時,嶺回歸對於最小二乘估計的不精確性是一種可能的解決方案。這提供了更精確的嶺參數估計,因為它的方差和均方估計量通常小於先前推導的最小二乘估計量。[8][2]

當求解超定問題(即)時, 矩陣 的協方差矩陣 奇異或接近奇異時,利用最小二乘方法求出的結果 會出現發散或對 不合理的逼近。為了解決這一問題,吉洪諾夫於1963年提出了利用正則化項修改最小二乘的代價函數的方法,修改後的代價函數如下:

式中 稱為正則化參數[9],這種方法被稱為吉洪諾夫正則化。

概覽

在最簡單的情況下,向主對角線添加正元素可以緩解近奇異矩量矩陣問題,減少條件數。類似於最小二乘估計量,簡單嶺估計量可定義為

其中是回歸子,是設計矩陣,是單位矩陣,嶺參數則是矩量矩陣對角線的恆定位移。[10]可以證明這個估計量是約束為的最小二乘問題的解,可表達為拉格朗日形式:

其說明,不過是約束的拉格朗日乘數。[11]通常要根據啟發式準則選擇,以便不完全滿足約束。特別是在約束,即非約束約束(non-binding constrain),嶺估計量退化為普通最小二乘法。下面討論一種更通用的吉洪諾夫正則化方法。

歷史

吉洪諾夫正則化是在許多不同背景下獨立發明的。 安德烈·吉洪諾夫[12][13][14][15][16]和David L. Phillips最早使用了這種方法。[17] 有限維情形由採用統計方法的Arthur E. Hoerl[18]和Manus Foster完成,後者將其解釋為克里金法濾子。[19]自Hoerl之後,這種方法在統計學文獻中被稱為嶺回歸,[20]以沿單位矩陣對角線的形狀命名。

吉洪諾夫正則化

假設對已知矩陣和向量,我們希望找到向量使[需要解釋]

標準方法是普通最小二乘法線性回歸。[需要解釋]但若沒有滿足方程或超過一個滿足(即解不唯一),則待研究問題為不適定問題,普通最小二乘估計會導致方程組過定或欠定。大多數現實世界的現象在前向問題中都具有低通濾性質[需要解釋],其中將映射到。因此在解決逆問題時,逆映射作為高通濾波器,具有放大噪聲的不良趨勢(特徵值/奇異值在逆映射中最大,在正映射中最小)。此外,普通最小二乘隱式地消除了位於的零空間的的重建版本的每個元素,而非允許將模型用作的先驗。 普通最小二乘尋找最小化殘差平方和,可以緊湊地寫作

其中是歐幾里得範數。

為優先選擇具有所需性質的特定解,可在最小化中包含正則化項:

其中吉洪諾夫矩陣需要適當選取,許多時候選為單位矩陣的純量倍數(),並優先考慮範數較小的解;這叫做L2正則化。[21]這之外,若認為基礎向量幾乎連續,則可使用高通運算(如遞推關係式或加權離散傅里葉變換)以實現平滑。這種正則化改進了問題條件,從而實現了直接的數值求解。顯式解表示為,是這樣得到:

正則化的效果可能因矩陣的尺度而異。若擇,如(ATA)−1存在,則簡化為非正則化最小二乘解。

對於和數據誤差的多元正態分佈,c可以應用變量的變換來簡化上述情況。等價地,可以尋求最小化:

其中表示加權範數平方(比較馬哈拉諾比斯距離)。在貝葉斯解釋中,是的逆協方差矩陣;是的期望;是的逆協方差矩陣。吉洪諾夫矩陣為矩陣的分解(如科列斯基分解),可視作白化變換器。

這個推廣問題有最優解,可以使用公式顯式地寫為

或等效地,當Q非空:

拉夫連季耶夫正則化

有時可以避免使用,這由米哈伊爾·拉夫連季耶夫指出。[24]例如,若是對稱正定矩陣,即,則其逆可以用來在廣義吉洪諾夫正則化中構造加權範數平方,則有最小化

或等價地由常數項,

- .

該最小化問題有最優解,可以緊湊地寫作公式

- ,

是廣義吉洪諾夫問題的解,其中。

拉夫連季耶夫正則化對原吉洪諾夫正則化有利,因為拉夫連季耶夫矩陣的條件數比吉洪諾夫矩陣小。

希爾伯特空間中的正則化

典型的離散線性非適定問題由積分方程的離散化引起,可以在原始的無窮維背景中實現吉洪諾夫正則化。上面,我們可以將解釋為希爾伯特空間上的緊算子,、為的域與範圍上的元素。是自伴隨有界可逆運算。

與奇異值分解和維納濾波器的關係

有這個最小二乘解可用奇異值分解以特殊的方式分析。給定奇異值分解

,奇異值,則吉洪諾夫正則解可表為

其中的對角值為

其餘地方都是0。這表明吉洪諾夫參數對正則化問題條件數的影響。對於廣義情況,可以使用廣義奇異值分解推導出類似的表示。[25]

最後,其與維納濾波有關:

其中維納權為;是的秩。

確定吉洪諾夫因子

最佳正則化參數一般未知,在實踐中常常臨時確定。一種可能的方法依賴於下面描述的貝葉斯解釋。其他方法包括偏差原理、交叉驗證、L曲線法、[26]約束最大似然法和無偏預測風險估計。Grace Wahba證明,這種最優參數用留一交叉驗證最小[27][28]

用前面的SVD分解,可以簡化上述表達式:

;

與概率表述的關係

逆問題的概率公式引入了(當所有不確定量都為正態量時)表示模型參數先驗不確定性的協方差矩陣,以及表示觀測參數不確定性的協方差矩陣。[29]當它們都是對角各向同性矩陣(),且,則逆理論方程簡化為上述方程,且。

貝葉斯解釋

雖然選擇這個正則化問題的解可能看起來是人為的,而且矩陣似乎相當武斷,但從貝葉斯的角度來看,這個過程是合理的。[30]注意,不適定問題必須引入額外假設才能得到唯一解。在統計學中,的先驗分佈有時被認為是多元正態分佈。為簡單起見,此處做出以下假設:均值為零;組分獨立;組分標準差均為。數據也受誤差影響,並且假設中的誤差獨立,均值為零,標準差為。在這些假設下,根據貝葉斯定理,吉洪諾夫正則化解是給定數據和的先驗分佈的最可能的解。[31]

若正態性假設被同方差和無關誤差假設代替,且若假設均值仍是零,則高斯-馬爾可夫定理意味着解是最小 無偏線性估計量。[32]

另見

- Lasso算法是統計學中另一種正則化方法。

- 彈性網絡正則化

- 矩陣正則化

註釋

參考文獻

閱讀更多

Wikiwand in your browser!

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.

![{\displaystyle G={\frac {\operatorname {RSS} }{\tau ^{2}}}={\frac {\|X{\hat {\beta }}-y\|^{2}}{[\operatorname {Tr} (I-X(X^{T}X+\alpha ^{2}I)^{-1}X^{T})]^{2}}},}](http://wikimedia.org/api/rest_v1/media/math/render/svg/f98b29f0dd9c75ec064f6d3a001b179441d8098e)