トップQs

タイムライン

チャット

視点

データ解析

有用な情報を発見し、結論を報告し、意思決定を支援することを目的として、データを検査し、クリーニングや変換を経て、モデル化する一連のプロセスである。 ウィキペディアから

Remove ads

データ解析(データかいせき、英: data analysis)は、有用な情報を発見し、結論を報告し、意思決定を支援することを目的として、データを検査し、クリーニングや変換を経て、モデル化する一連のプロセスである[1]。データ分析(データぶんせき)とも呼ばれる。

概要

データ解析には多数の側面とアプローチがあり、色々な名称のもとで多様な手法を包含し、ビジネス、科学、社会科学のさまざまな領域で用いられている[2]。今日のビジネス界において、データ解析は、より科学的な意思決定を行い、ビジネスの効率的な運営に貢献する役割を担っている[3]。

データマイニングは、(純粋な記述的な目的ではなく)予測的な目的で統計的モデリングと知識獲得に重点を置いた固有のデータ解析技術である。これに対し、ビジネスインテリジェンスは、主にビジネス情報に重点を置いて、集計に大きく依存するデータ解析を対象としている[4]。統計学的な用途では、データ解析は記述統計学 (en:英語版) 、探索的データ解析(EDA)、確認的データ解析(仮説検定)(CDA)に分けられる[5]。EDAはデータの新たな特徴を発見することに重点を置き、CDAは既存の仮説の確認または反証に焦点を当てる[6][7]。予測分析は、予測的な発生予報あるいは分類のための統計モデルの応用に重点を置き、テキスト分析は、統計的、言語的、および構造的な手法を用いて、非構造化データの一種であるテキストデータから情報を抽出し知識の発見や分類を行う。上記はどれも、データ解析の一種である[8]。

Remove ads

データ解析のプロセス

要約

視点

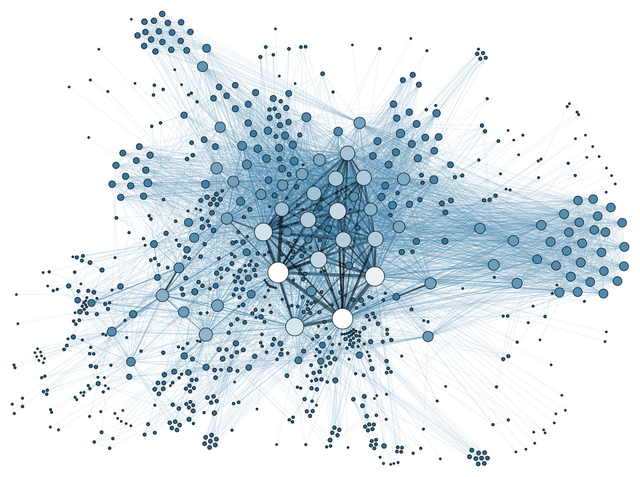

Doing Data Science, Schutt & O'Neil (2013)から。

解析(analysis)とは、全体を構成要素に分割し、個々を考察することである[10]。データ解析とは、生データを入手し、それを利用者の意思決定に役立つ情報に変換するプロセスである[1]。データ(data)は、質問に答えたり、仮説を検証したり、理論を反証するために収集され、解析される[11]。

統計学者のジョン・テューキーは、1961年にデータ解析を次のように定義した。

「データを解析する手順、その結果を解釈するための技術、解析をより容易に、正確で、精密にするためのデータ収集の計画方法、およびデータの解析に適用されるすべての機械と(数学的)統計学の結果」[12]。

以下に説明するように、区別することができるいくつかの段階がある。各段階は反復的であり、後の段階からのフィードバックが、前の段階での追加作業につながることがある[13]。データマイニングで使用されるCRISPフレームワークにも同様のステップがある。

データ要件

データは、解析の入力として必須なものであり、解析プロセスを管理する人(または解析結果を報告する顧客)の要求に基づいて特定される[14][15]。データ収集の対象となる一般的な主体は実験単位と呼ばれる(例:人、または人の集団)。そして、データは母集団に関する特定の変数(例:年齢や所得)を指定して収集される。データは、数値でもカテゴリでもよい(例:番号に紐付くテキスト型ラベル)[13]。

データ収集

データはさまざまな情報源から収集される[16][17]。その要求事項は、解析者からデータ管理者(たとえば、組織内の情報システム技術者)に伝えられる場合がある[18]。データは、交通監視カメラ、人工衛星、記録装置など、環境内のセンサーから収集されることもある。また、インタビュー、オンライン情報源からのダウンロード、または文書の閲覧を通じて得ることもある[13]。

データ処理

入手したデータはまず、解析のために加工あるいは整理する必要がある[19][20]。たとえば、さらなる解析をするためにデータを表形式の行と列に配置することがあり(構造化データと呼ばれる)、多くの場合、表計算ソフトウェアや統計ソフトウェアが用いられる[13]。

データクリーニング

→詳細は「データクレンジング」を参照

一度でも処理されて整理を受けたデータは、不完全であったり、重複があったり、誤りを含むことがある[21][22]。データクリーニングの必要性は、データの入力や保存のしかたに問題があることから発生する。データクリーニングは、このようなエラー(誤り)を防ぎ、修正する作業である[21]。一般的な作業としては、レコードの照合、データの不正確さの特定、既存データ全体の品質管理、重複排除、および列の分割が含まれる[23]。このようなデータの問題は、さまざまな解析技術によっても見つけることができる。たとえば、財務情報の場合、特定の変数の合計を、信頼性が高いと考えられる別途公表された数値と比較することができる[24][25]。また、事前に決められた閾値(しきいち)を上回ったり下回ったりする異常値(外れ値)も再調査されることがある。データクリーニングには、電話番号、電子メールアドレス、勤務先など、データ集合内のデータ型に依っていくつかの種類がある[26][27]。異常値検出のための定量的データ手法を用いて、誤入力された可能性が高いと思われるデータを取り除くことができる[28]。テキストデータのスペルチェッカーを用いて入力ミスの量を減らすことができる。ただし、単語そのものが正しいか否かを判断するのは難しい[29]。

探索的データ解析

→詳細は「探索的データ解析」を参照

データセットをクリーニングすると、次に解析に移ることができる。解析者は、取得したデータに含まれるメッセージを理解し始めるために、探索的データ解析と呼ばれるさまざまな手法を適用することができる[30]。データ探索の過程で、データのクリーニングを追加したり、データへの要求を追加することもある。その結果、本節の冒頭で説明したような反復的な段階が開始される[31]。データの理解を助けるために、平均値や中央値などの記述統計量を作成することもある[32][33]。データ可視化もその一つであり、解析者はデータを図表化し、考察をして、データ内のメッセージについてさらなる洞察を得ることができる[13]。

モデリングとアルゴリズム

変数間の関係を特定するために、数式またはモデル(アルゴリズムと呼ばれる)をデータに適用する場合がある。たとえば、相関関係や因果関係を使用する[34][35]。一般論として、モデルは、データセット内に含まれる他の変数に基づいて特定の変数を評価するために開発され、実装されたモデルの精度に応じて多少の残余誤差が生じる(たとえば、データ = モデル + 誤差)[36][11]。

推測統計には、特定の変数間の関係を測定する手法の利用が含まれる[37]。たとえば、広告の変化(独立変数 X)が、売上(従属変数 Y)が変動する説明を与えるかどうかをモデル化するのに、回帰分析を用いることがある[38]。数学の用語では、Y(売上高)はX(広告)の関数である[39]。たとえば、モデルを「Y = aX + b + 誤差」と記述することができ、X の所与の範囲に対して Y を予測するときの誤差を最小化するように a と b が設計される[40]。また、解析者は、解析を単純化し、結果を伝達することを目的に、記述的データ解析のためのモデル構築を試みることもある[11]。

データプロダクト

データプロダクト(data product)は、データの入力から出力を生成し、環境にフィードバックするコンピュータ・アプリケーションである[41]。モデルやアルゴリズムに基づいている場合もある。たとえば、顧客の購入履歴データを分析し、その結果を利用して、顧客に有益さをもたらすような別の購入を勧めるアプリケーションがあげられる[42][13]。

コミュニケーション

→詳細は「データ可視化」を参照

データの解析後は、解析結果の利用者からの要求に応えるために、さまざまな書式で報告されることがある[44]。利用者からフィードバックがなされ、その結果、追加の分析が行われることもある。このように、分析サイクルの大部分は反復的である[13]。

解析者は、解析結果を伝えるやり方を決める際、メッセージをより明確かつ効率的に報告先に伝達するために、さまざまなデータ可視化手法の導入を検討することができる[45]。データ可視化は、情報ディスプレイ(表やグラフなどのグラフィクス)を用いて、データに含まれる重要なメッセージを伝達する[46]。表は、特定の数値に着目したり照会できる重要なツールであり、一方、チャート(棒グラフや折れ線グラフなど)は、データに含まれる定量的なメッセージを説明するのに役立つ場合がある[47]。

Remove ads

定量的メッセージ

→詳細は「データ可視化」を参照

ステファン・フュー(Stephen Few)は、利用者が一連のデータから理解しようとする、あるいは伝えようとする8種類の定量的メッセージと、そのメッセージの伝達を助けるために使用される関連グラフについて述べた[48]。要求を指定する顧客とデータ解析を行う解析者は、プロセスの推移でこれらのメッセージを検討することができる[49]。

- 時系列: 10年間の失業率など、ある期間にわたって一つの変数を捉える。トレンドを示すために折れ線グラフを使用することもある[50]。

- ランキング: データは、カテゴリで細分化され、昇順または降順でランク付けされる。たとえば、ある期間の営業担当者(カテゴリに対応)が、販売実績(尺度に対応)でランク付けされる[51]。営業担当者間の比較を示すために棒グラフを使用することがある[52]。

- 部分対全体: カテゴリ別に細分化した量を、全体に対する比率(100%中の割合)で測定する。円グラフや棒グラフで、市場における競合他社のシェアなど、比率を比較して示すことができる[53]。

- 偏差値: カテゴリごとに細分化したものを、ある基準に対して比較する。たとえば、ある期間のビジネスにおける幾つかの部門の経費について予算と実績を比較する場合である。棒グラフは、実際の金額と基準金額の比較を示すことができる[54]。

- 度数分布: たとえば、株式市場の利益が0~10%、11~20%などの間隔の間にある年の数など、所与の間隔に対する特定の変数の観察数を示す。棒グラフの一種であるヒストグラムがこの分析に用いられることがある[55]。

- 相関: 2つの変数 (X, Y) で表される観測結果を比較し、それらが同じ方向、または反対方向に動く傾向があるかを判断する。たとえば、月度サンプルについて、失業率(X)とインフレ率(Y)をプロットする。このメッセージには通常、散布図が使用される[56]。

- 名目上の比較: 商品コード別の販売量など、カテゴリ別に細分化したものを順不同で比較する。この比較には棒グラフが用いられる[57]。

- 地理的または地理的空間: 州ごとの失業率や建物の階毎の人数など、地図や配置を横断して変数を比較する。カルトグラムが、典型的なグラフィックとして使用される[58][59]。

定量データの解析手法

要約

視点

→「問題解決」も参照

著者のジョナサン・クーメイ(Jonathan Koomey)は、定量データを理解するための一連のベストプラクティスを推奨している[60]。これらは次のとおりである。

- 解析を行う前に、生データに異常がないかをチェックする。

- 重要な計算を再実行する。たとえば、計算式に基づくデータ列を検証する。

- 総計が小計の合計であることを確認する。

- 時間経過に伴う比率など、予測可能な形で関連すべき数値間の関係を確認する。

- 数字を正規化して比較を容易にする。たとえば、1人当たりの金額、GDPとの比較、または指標値として基準年と比較して分析する。

- 自己資本利益率に対するデュポン分析のように、結果を導いた要因を分析し、問題を構成要素に分解する[25]。

解析者は通常、調査対象となる変数について、平均、中央値、標準偏差などの記述統計量を求める[61]。また、個々の値が平均値の周囲にどのように集まっているかを確認するために、主要変数の分布を分析することもある[62]。

マッキンゼー・アンド・カンパニーのコンサルタントは、定量的な問題を構成要素に分解する手法をMECE原則と名付けた。各層は、その構成要素に分解することができる[63]。各々の部分構成要素は互いに排他的であり、合わせるとその上位層にならなければならない[64]。この関係は「相互に排他的な項目による完全な全体集合」またはMECE(Mutually Exclusive and Collectively Exhaustive)と呼ばれる。たとえば、利益の定義は、総収入と総費用に分解することができる[65]。そして総収入は、部門A、B、Cの収入(これらは互いに排他的)によって分析でき、総収入に加算される(余すところなくまとまる)べきである[66]。

解析者は、特定の分析上の問題を解決するために、ロバスト統計量を使用することがある[67]。解析者は、真の状態に関する特定の仮説を立て、その状態が真であるか偽であるかを判断するために、データが収集されて仮説検定が行われる[68][69]。たとえば、「失業はインフレに影響しない」という仮説が考えられる。これはフィリップス曲線と呼ばれる経済学の概念に関連している[70]。仮説検定では、データが仮説を支持するか棄却するかに関する第一種過誤と第二種過誤の可能性を検討する[71][72]。

回帰分析は、独立変数 X が従属変数 Y にどの程度影響するかを解析者が判断するときに使用される。たとえば「失業率の変化 X はインフレ率 Y にどの程度影響するか」[73]。これは、Y が X の関数であるように、データをモデル化または直線や曲線の方程式を適合させようとするものである[74][75]。

必要条件分析(NCA)は、解析者が独立変数 X が変数 Y をどの程度まで許容するかを決定するときに使用することがある。たとえば「特定のインフレ率(Y)に必要な特定の失業率(X)はどの程度か?」[73]。重回帰分析が、各 X 変数が結果を生成し、X が相互に補償できる(それらは十分であるが必要ではない)加法論理を用いるのに対し[76]、必要条件分析(NCA)は、1つまたは複数の X 変数が結果の存在を可能にするが、それを生成しないかもしれない(それらは必要だが十分ではない)必要論理を用いる。それぞれの単一必要条件は存在しなければならず、補償は不可能である[77]。

Remove ads

データ利用者の分析活動

要約

視点

データ利用者は、上述の一般的なメッセージングとは対照的に、データセット内で特定のデータポイントに関心を抱くことがある。このような利用者による低水準な分析活動を次の表に示す。この分類法はまた、値の取得、データポイントの発見、データポイントの配置という3つの活動の柱によって整理することができる[78][79][80][81]。

Remove ads

効果的な分析の障壁

要約

視点

効果的な分析を阻む障壁は、データ解析を行う解析者の間にだけでなく、顧客どうしの間にも存在する可能性がある。事実と意見を区別すること、認知バイアス、および数学的な基礎知識の不足はすべて、健全なデータ解析に対する課題である[82]。

事実と意見の混同

誰もが自分の意見を言う権利をもつが、それは事実に基づくものでなければならない。

効果的な分析においては、質問に答えたり、結論や正式な意見を裏付けたり、仮説を検証するために、関連する事実を入手する必要がある[83][84]。事実の定義は「反証できないこと」であり、分析に関わるすべての人がその事実に同意できるという意味である[85]。たとえば、2010年8月、米国議会予算局(CBO)は、2001年と2003年のブッシュ減税を2011年-2020年までの期間に延長すると、約3兆3千億ドルの国家債務が追加されると試算した[86]。誰もがCBOの報告を調べることができ、実際そうだと同意するはずである。これは事実である。人がCBOに賛成するか反対するかは、その人自身の意見である[87]。

別の例として、公開会社の監査人は、上場企業の財務諸表が「すべての重要な点において公正に記載されている」かどうか正式な意見を導き出さなければならない[88]。そのためには、事実データや証拠を広範に分析して、意見を裏付ける必要がある。事実から意見へと飛躍するとき、その意見が誤っている可能性は常にある[89]。

認知バイアス

分析に悪影響を及ぼしうる認知バイアスにはさまざまなものがある。たとえば、確証バイアスは、自分の先入観を確認する方法で情報を検索したり、解釈したりする傾向である[90]。さらに、自分の見解を支持しない情報を信用しないこともありうる[91]。

解析者は、これらのバイアスを認識し、克服するための特別な訓練を受けることができる[92]。CIAの元アナリストのリチャーズ・ホイヤーは、著書『情報分析の心理学(Psychology of Intelligence Analysis)』の中で、解析者は自らの仮定と推論の連鎖を明確に描写し、結論に関わる不確実性の程度と原因を明記すべきと述べている[93]。彼は、代替案による視点を表面化させ、議論するための手順を強調した[94]。

数学的基礎知識の欠如

有能な解析者は、一般的にさまざまな数値技法に精通している。しかし、顧客は数字や数学の基礎に関する能力を持っていない場合があり、そのような人々は数学的非識字[訳語疑問点]と呼ぶ[95]。またデータを伝える人が、意図的に悪い数値的技法を使って、誤解を招いたり間違った伝達を引き起こそうとする場合もある[96]。

たとえば、数値が上昇しているか下降しているかは重要な要素ではないことがある。より重要なことは、経済規模(GDP)に対する政府の歳入や歳出の規模、あるいは企業の財務諸表における収益に対する費用の額など、他の数値との相対的な比較かもしれない[97]。このような数値的技法は、正規化または再スケール化と呼ばれる[25]。インフレ調整(実質データと名目データの比較)や、人口増加や人口動態を考慮するかにかかわらず、解析者が採用するこのような手法は数多く存在する[98]。解析者は、本節の冒頭で説明したさまざま定量的メッセージに対処するために、さまざまな手法を適用している[99]。

また、解析者はさまざまな仮定やシナリオの下でデータを解析することもある。たとえば、解析者が財務諸表分析を行う場合、将来のキャッシュフローを推定するために、さまざまな仮定の下で財務諸表を作り直し、それをある金利に基づいて現在価値に割り戻して、企業や株式の評価を下すことがよくある[100][101]。同様に、CBOは、さまざまな政策オプションが政府の歳入、歳出、赤字に及ぼす影響を分析し、主要な指標について代替的な将来シナリオを作成する[102]。

Remove ads

その他の話題

スマートビルディング

建物のエネルギー消費量を予測するために、データ解析の手法が用いることができる[103]。スマートビルディングを実現するために、データ解析プロセスのさまざまな段階が実行される。スマートビルディングでは、暖房、換気、空調、照明、セキュリティなどのビル管理および制御業務が、ビル利用者のニーズを模倣してエネルギーや時間のような資源が最適化することで自動的に行われる[104]。

アナリティクスとビジネスインテリジェンス

→詳細は「解析」を参照

解析(アナリティクス、analytics)とは「意思決定や行動を推進するために、データ、統計的および定量的分析、説明的および予測的モデル、事実に基づくマネジメントを広範に活用すること」である。これはビジネスインテリジェンスのサブセットであり、データを使用してビジネス業績を理解および分析し、意思決定を促進する一連の技術とプロセスである[105] 。

教育

教育活動では、ほとんどの教育関係者が学生のデータを分析する目的でデータシステムにアクセスしている[106]。これらのデータシステムは、教育者によるデータ分析の精度を高めるために、店頭データ形式で教育者にデータを提示する(埋込みラベル、補足文書、ヘルプシステム、主要パッケージ/表示、内容決定)[107]。

Remove ads

専門的注記

要約

視点

この節には、実務家の助けになるようなかなり専門的な説明が含まれているが、ウィキペディアの記事の一般的な範囲を超えている[108]。

初期データ解析

初期データ解析と本解析の段階の間で最も重要な違いは、初期データ解析では、本来の調査課題に答えるための分析を控えることである[109]。初期データ解析の段階は、次の4つの質問によって導かれる[110]。

データの品質

データの品質は、できるだけ早い段階でチェックする必要がある。データの品質は、さまざまな種類の分析を用いて、いくつかの方法で評価することができる。頻度カウント、記述統計(平均、標準偏差、中央値)、正規性(歪度、尖度、頻度ヒストグラム)、普通の代入法(欠測データの補完)を要する[111]。

- 極端な観測値の分析: データ内に含まれる範囲外の観測値を分析して、分布を乱すように見えるかどうかを確認する[112]。

- コーディングスキームの違いの比較と修正: 変数は、データセット外部にある変数のコーディングスキームと比較され、コーディングスキームが比較できない場合はできる限り修正する[113]。

- 共通法分散(CMV)の確認。

初期データ解析段階において、データの品質を評価するために用いる解析手法の選択は、本解析段階で実施される解析に依存する[114]。

測定の品質

計測機器の品質は、それが研究の焦点または研究課題ではない場合、初期データ解析段階でのみチェックされるべきである[115][116]。測定器の構造が文献で報告されている構造と一致しているかどうかを確認する必要がある。

測定品質を評価する方法は2つある。

- 確認的因子分析

- 測定器の信頼性の指標となる均質性(内的整合性)の分析[117]。この分析では、項目と尺度の分散、尺度のクロンバックのα係数、および尺度から項目を削除した場合のクロンバックのαの変化を検査する[118]。

初期変換

データおよび測定値の品質を評価した後、欠損データの入力、または1つ以上の変数の初期変換を行うかを決定することがあるが、これは本解析段階で行うことも可能である[119]。考えられそうな変数の変換を次にあげる[120]。

- 平方根変換(分布が正規分布から中程度にずれている場合)

- 対数変換(分布が正規分布とかなりの程度で異なる場合)

- 逆変換(分布が正規分布と著しく異なる場合)

- カテゴリ化(順序数/二項)(分布が正規分布と大幅に異なり、どの変換も役に立たない場合)

研究の実施は、研究設計の意図を満たしていたか?

たとえば、結果変数と独立変数がグループ内とグループ間で均等に分散しているかどうかなど、無作為化手順が成功したかどうかを確認する必要がある[121]。

無作為化手順を必要としない、あるいは使用しない研究の場合、たとえば、対象の母集団のすべてのサブグループが標本に反映されているかどうかを確認することによって、非無作為抽出の成否を確認する必要がある[122]。

チェックすべきその他の可能性のあるデータの歪みは次のとおりである。

- 脱落(これは初期データ解析段階で特定するべき)

- 項目の無回答(これが無作為かどうかに関わらず、初期データ解析段階で評価する必要がある)

- 処置の質(操作チェックを用いる)[123]

データ標本の特徴

どんな報告書や論文でも、標本の構造を正確に記述する必要がある[124][125]。

特に、本解析段階でサブグループ分析を行う場合は、標本の構造(特にサブグループのサイズ)を正確に決定することが重要である[126]。

データ標本の特性は、以下を確認することによって評価できる。

初期データ解析の最終段階

最終段階では、初期データ解析の結果を文書化し、必要で、望ましく、可能な是正措置を講じる[128]。

また、本データ解析の当初の計画は、より詳細に指定するか書き直すことがあり、そうすべきである[129][130]。

そのためには、本データ解析に関するいくつかの決定を行うことができ、また行うべきである。

- 非正規型の場合: 変数変換か、変数のカテゴリ化(順序変数/二項変数)か、分析手法の修正のいずれかをすべきか?

- 欠測データの場合: 欠測データを無視または補完するか、どの補完手法を使うべきか?

- 外れ値の場合: ロバスト解析技術を用いるべきか?

- 項目が尺度に合わない場合: 項目を省略して測定器を適合させるべきか、それとも他の測定器(その測定器の)との比較可能性を確保すべきか?

- サブグループが小さい(小さすぎる)場合: グループ間差に関する仮説を取り下げるべきか、正確な検定やブートストラップ法のような小さな標本化技術を用いるべきか?

- 無作為化手順に欠陥があると思われる場合: 傾向スコアを計算し、それを本解析に共変量として含めることができるか、またそうすべきか?[131]

解析方法

初期データ解析段階で、いくつかの解析を行うことができる[132]。

- 単変量統計(単一変数)

- 二変量関連性(相関関係)

- グラフィカル手法(散布図)

それぞれの変数の測定レベルに対して特別な統計手法が利用できるので、解析においては変数の測定レベルを考慮することが重要である[133]。

非線形解析

非線形システムからデータを記録する場合、しばしば非線形解析が必要となる。非線形システムは、分岐、カオス、高調波、副高調波など、単純な線形手法では解析できない複雑な動的効果を示すことがある。非線形データ解析は、非線形システム同定と密接に関係している[134]。

本データ解析

本解析段階では、研究課題に答えるための分析、および研究報告書の初稿を書くために必要なその他の関連する分析を行う[135]。

探索的アプローチと確認的アプローチ

本解析段階では、探索的アプローチと確認的アプローチのいずれかを採用することができる。通常は、データを収集する前にアプローチを決定する[136]。探索的分析では、データを分析する前に明確な仮説を立てず、データを適切に説明するモデルを探してデータを検索する[137]。一方、確認的分析では、データに関する明確な仮説が検証される[138]。

探索的データ解析は、慎重に解釈する必要がある。一度に複数のモデルを検定する場合、そのうちの少なくとも1つが有意であることを見いだす可能性が高くなるが、これは第一種過誤によるものである可能性がある[139]。複数のモデルを検定する際には、(たとえばボンフェローニ補正で)常に有意水準を調整することが重要である[140]。また、同じデータセットを用いて探索的分析に続いて確認的分析を行うべきではない[141]。探索的分析は、理論のアイデアを見つけるために用いるが、その理論を検証するためのものではない[141]。あるデータセットで探索的にモデルが見つかったとき、同じデータセットで確認的分析を行うと、確認的分析の結果が、最初の探索的モデルがもたらした第一種過誤と同じ誤りを意味する可能性がある[141]。したがって、その確認的分析は、元の探索的分析よりも有益とはならない[142]。

結果の安定性

解析結果がどの程度一般化できるかについて、何らかの指標を持つことは重要である[143]。これを確認するのは難しいことが多いが、結果の安定性を見ることは可能である。結果が信頼できるか?再現性はあるか?、これを確かめるには、主に2つの方法がある[144]。

Remove ads

データ解析のフリーソフトウェア

データ解析のための代表的なフリーソフトを次にあげる。

- ELKI - データマイニング指向の可視化機能を備えたJavaによるデータマイニングフレームワーク。

- KNIME- Konstanz Information Miner、ユーザーフレンドリーで包括的なデータ分析フレームワーク。

- Orange - 対話的なデータ可視化、統計データ解析、データマイニング、機械学習の手法を備えたビジュアルプログラミングツール。

- Pandas - Python言語によるデータ解析のためのライブラリ。

- PAW- CERNで開発されたFORTRAN/Cデータ解析フレームワーク。

- R - 統計計算とグラフィックスのためのプログラミング言語とソフトウェア環境[149]。

- ROOT - CERNで開発されたC++データ解析フレームワーク。

- SciPy - データ解析のためのPythonライブラリ。

- Julia - 数値解析や計算科学に適したプログラミング言語。

国際データ解析コンテスト

さまざまな企業や団体がデータ解析コンテストを開催し、研究者がデータを活用したり、データ解析による特定の課題を解決したりすることを奨励している[150][151]。よく知られた国際データ解析コンテストの例に次がある[152]。

- Kaggleが開催するKaggleコンペティション[153]。

- 連邦ハイウェイ管理局(FHWA)と米国土木学会(ASCE)が開催するLTPPデータ解析コンテスト[154][155]。

脚注

参考文献

推薦文献

関連項目

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads