Timeline

Chat

Prospettiva

Distribuzione normale

distribuzione di probabilità continua Da Wikipedia, l'enciclopedia libera

Remove ads

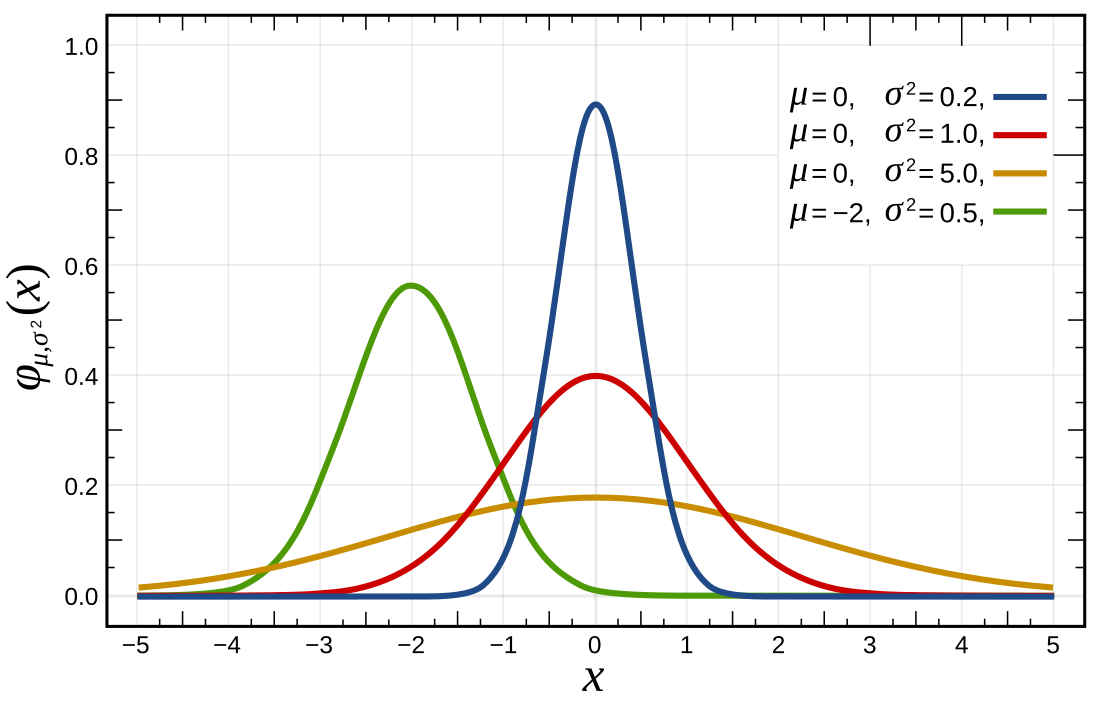

La distribuzione normale (o distribuzione di Gauss dal nome del matematico tedesco Carl Friedrich Gauss, o distribuzione a Campana di Gauss), nella teoria della probabilità, è una distribuzione di probabilità continua che è spesso usata come prima approssimazione per descrivere variabili casuali a valori reali che tendono a concentrarsi attorno a un singolo valor medio.

Il grafico della funzione di densità di probabilità associata è simmetrico e ha una forma a campana, nota come "curva a campana", "curva normale", "curva gaussiana"[1] o "curva degli errori".[2]

Remove ads

Descrizione

La distribuzione normale è considerata il caso base delle distribuzioni di probabilità continue a causa del suo ruolo nel teorema del limite centrale. Un insieme di valori dato potrebbe essere normale: per stabilirlo si può usare un test di normalità. Più specificamente, assumendo certe condizioni, la somma di variabili casuali con media e varianza finite tende a una distribuzione normale al tendere di all'infinito. Grazie a questo teorema, la distribuzione normale si incontra spesso nelle applicazioni pratiche, venendo usata in statistica e nelle scienze naturali e sociali[3] come un semplice modello per fenomeni complessi.

La distribuzione normale dipende da due parametri, la media e la varianza , ed è indicata tradizionalmente con:

Remove ads

Metodologia

Riepilogo

Prospettiva

La distribuzione normale è caratterizzata dalla seguente funzione di densità di probabilità, al cui grafico spesso si fa riferimento con la dizione curva di Gauss o gaussiana:

dove è il valore atteso e la varianza.

Per dimostrare che è effettivamente una funzione di densità di probabilità si ricorre innanzi tutto alla standardizzazione (statistica) della variabile casuale, cioè alla trasformazione tale per cui risulta:

dove la variabile risultante ha anch'essa distribuzione normale con parametri e . L'integrale della funzione di densità di probabilità della variabile casuale standardizzata è il seguente:

Dato che deve necessariamente valere la condizione , allora risulta anche , quindi:

dove anche la variabile casuale ha distribuzione normale standardizzata. Per risolvere questo integrale doppio si ricorre alle coordinate polari e , dove e . La matrice jacobiana della trasformazione è

il cui determinante è uguale a . Sostituendo nell'integrale di cui sopra si ottiene:

La sua funzione generatrice dei momenti è

Il valore atteso e la varianza (che sono gli unici due parametri di questa variabile casuale) sono appunto e .

Non essendo possibile esprimere l'integrale della in forma chiusa mediante funzioni elementari, è necessario rendere disponibili in forma tabellare i valori della sua funzione di ripartizione. I più usati sono:

Essendo una funzione simmetrica, è sufficiente conoscere la funzione di ripartizione dei valori positivi per conoscere pure quella dei valori negativi (e viceversa).

Dalla variabile casuale Normale si possono ottenere altre variabili casuali, come la t di Student, la Chi Quadrato e la F di Fisher-Snedecor, nonché le loro "varianti" non centrali (t non centrale, chi quadrato non centrale e F non centrale).

Remove ads

Teoremi

Riepilogo

Prospettiva

Combinazione lineare di variabili gaussiane

- Se

- sono variabili casuali Normali tra di loro indipendenti, ciascuna con valore atteso e varianza ,

- allora

- la variabile casuale è a sua volta una variabile casuale Normale con valore atteso e varianza .

Altri teoremi: teorema di Cochran.

Relazioni con altre variabili casuali

La Normale come derivazione da altre voci

I teoremi del limite centrale sono una famiglia di teoremi che hanno in comune l'affermazione che la somma (normalizzata) di un grande numero di variabili casuali è distribuita approssimativamente come una variabile casuale normale.

Se è distribuita come una variabile casuale binomiale con molto grande (per dare un'idea di quanto grande, possiamo dire che deve essere ), e approssimativamente , allora la binomiale può essere approssimata con una Normale con valore atteso e varianza .

Se è distribuita come una variabile casuale poissoniana con il parametro molto grande (orientativamente ), allora la Poissoniana può essere approssimata con una Normale con valore atteso e varianza pari a .

Variabili casuali derivate dalla Normale

Date distribuzioni normali con media nulla e varianza unitaria indipendenti tra loro. Allora

è una variabile casuale chi quadro con gradi di libertà.

Siano variabili casuali indipendenti distribuite come una Normale con media nulla e varianza unitaria, e siano inoltre delle costanti tali che

allora si indica con la variabile casuale chi quadro non centrale con gradi di libertà costruita come

Se e tra loro indipendenti, allora è distribuita come una t di Student con gradi di libertà.

Se e è la v.c. media campionaria, mentre è la v.c. varianza campionaria non corretta, allora e , inoltre e sono indipendenti.

Se e , allora è una v.c. di Birnbaum-Saunders con i parametri e .

La normale nell'inferenza bayesiana

Variabile casuale Gamma come priori coniugati della normale

Nell'ambito dell'inferenza bayesiana si trova la seguente relazione tra la normale e la distribuzione Gamma.

Se è una distribuzione normale con parametri e

e il parametro ha una distribuzione con i parametri e

allora il parametro è distribuito a posteriori anch'esso come una variabile casuale Gamma, ma con parametri e :

Priori coniugati normale di una normale

Se è distribuita come una v.c. normale con parametri e

e il parametro è distribuito a priori come una v.c. normale con i parametri e

allora il parametro è distribuito a posteriori anch'esso come una v.c. Normale, ma con parametri:

- e

Remove ads

Storia

Riepilogo

Prospettiva

Abraham de Moivre, nell'ambito dei suoi studi sulla probabilità, introdusse per la prima volta la distribuzione normale in un articolo del 1733. Gauss, che a quel tempo non era ancora nato, ne fu invece un grande utilizzatore: egli propose la "distribuzione normale" studiando il moto dei corpi celesti[5]. Altri la usavano per descrivere fenomeni anche molto diversi come i colpi di sfortuna nel gioco d'azzardo o la distribuzione dei tiri attorno ai bersagli. Da qui i nomi "curva di Gauss" e "curva degli errori".

Nel 1809 il matematico americano Adrain pubblicò due derivazioni della legge normale di probabilità, simultaneamente e indipendentemente da Gauss[6] I suoi lavori rimasero ampiamente ignorati dalla comunità scientifica fino al 1871, allorché furono "riscoperti" da Cleveland Abbe.[7].

Nel 1835 Quételet pubblicò uno scritto nel quale, fra le altre cose, c'erano i dati riguardanti la misura del torace di soldati scozzesi e la statura dei militari di leva francesi. Quételet mostrò come tali dati si distribuivano come una "Gaussiana", ma non andò oltre.

Fu Galton a intuire che la curva in questione, da lui detta anche "ogiva", poteva essere applicata a fenomeni anche molto diversi, e non solo ad "errori". Questa idea di curva per descrivere i "dati" in generale portò ad usare il termine "Normale", in quanto rappresentava un substrato "normale" ovvero la "norma" per qualsiasi distribuzione presente in natura.

Nel tentativo di confrontare curve diverse, Galton - in mancanza di strumenti adeguati - si limitò ad usare due soli parametri: la media e la varianza, dando così inizio alla statistica parametrica.

Remove ads

Esempio in R

Riepilogo

Prospettiva

Per stabilire se una distribuzione è normale o gaussiana si può tracciarne l'istogramma con il seguente codice R e vedere se l'andamento segue la normalita :

library(ggplot2)

#Distribuzione normale di 1000 osservazioni con media 5 e deviazione standard 3:

normal_d <- rnorm(1000, mean = 5, sd = 3)

df <- data.frame(normal_d)

ggplot(df, aes(normal_d))+

geom_histogram(bins = 30)

In alternativa si può tracciare il grafico quantile-quantile che consente di confrontare due distribuzioni di probabilità tracciando i loro quantili l'uno contro l'altro. Nel caso specifico si confronta la distribuzione data con una normale.Se le due distribuzioni confrontate sono simili, i punti del grafico Q-Q si troveranno approssimativamente sulla linea di identità y=x.

# Grafico quantile-quantile:

ggplot(df, aes(sample=normal_d))+

geom_qq()+

geom_qq_line()

Infine si può fare il test di Shapiro-Wilk : se il p_value ottenuto è maggiore di 0,05 vale l'ipotesi nulla secondo cui la distribuzione è normale al 95%, altrimenti vale l'ipotesi alternativa.

shapiro.test(df$normal_d)

Shapiro-Wilk normality test data: df$normal_d W = 0.99832, p-value = 0.4404

Nel caso specifico p-value>0,05 quindi la distribuzione è normale al 95% .

Remove ads

Note

Bibliografia

Voci correlate

Altri progetti

Collegamenti esterni

Wikiwand - on

Seamless Wikipedia browsing. On steroids.

Remove ads

![{\displaystyle J(\rho ,\theta )=\left[{\begin{array}{cc}{\frac {\partial z}{\partial \rho }}&{\frac {\partial z}{\partial \theta }}\\\\{\frac {\partial y}{\partial \rho }}&{\frac {\partial y}{\partial \theta }}\end{array}}\right]=\left[{\begin{array}{cc}\cos \theta &-\rho \sin \theta \\\sin \theta &\rho \cos \theta \end{array}}\right],}](http://wikimedia.org/api/rest_v1/media/math/render/svg/d2496bb44b0d9baa4bf56e31af0b3f0cdbd2ce05)