Loading AI tools

De Wikipedia, la enciclopedia libre

La teoría de la computación o teoría de la informática es un conjunto de conocimientos racionales y sistematizados que se centran en el estudio de la abstracción de los procesos, con el fin de reproducirlos con ayuda de sistemas formales; es decir, a través de símbolos y reglas lógicas. La teoría de la computación permite modelar procesos dentro de las limitaciones de dispositivos que procesan información y que efectúan cálculos; como, por ejemplo, el ordenador. Para ello, se apoya en la teoría de autómatas, a fin de simular y estandarizar dichos procesos, así como para formalizar los problemas y darles solución.[1]

Para realizar un estudio riguroso de la computación, los informáticos trabajan con una abstracción matemática de los ordenadores llamada modelo de computación. Hay varios modelos en uso, pero el más comúnmente examinado es la máquina de Turing.[2] Los informáticos estudian la máquina de Turing porque es sencilla de formular, se puede analizar y utilizar para demostrar resultados, y porque representa lo que muchos consideran el modelo "razonable" de computación más potente posible (véase tesis Church-Turing).[3] Podría parecer que la capacidad de memoria potencialmente infinita es un atributo irrealizable, pero cualquier problema decidible[4] resuelto por una máquina de Turing siempre requerirá sólo una cantidad finita de memoria. Así que, en principio, cualquier problema que pueda ser resuelto (decidido) por una máquina de Turing puede ser resuelto por un ordenador que tenga una cantidad finita de memoria.

Esta teoría provee modelos matemáticos que formalizan el concepto de computadora o algoritmo de manera suficientemente simplificada y general para que se puedan analizar sus capacidades y limitaciones. Algunos de estos modelos juegan un papel central en varias aplicaciones de las ciencias de la computación, incluyendo procesamiento de texto, compiladores, diseño de hardware e inteligencia artificial.

Existen muchos otros tipos de autómatas como las máquinas de acceso aleatorio, autómatas celulares, máquinas ábaco y las máquinas de estado abstracto; sin embargo en todos los casos se ha mostrado que estos modelos no son más generales que la máquina de Turing, pues la máquina de Turing tiene la capacidad de simular cada uno de estos autómatas. Esto da lugar a que se piense en la máquina de Turing como el modelo universal de computadora.

| Gramática | Idiomas | Autómatas | Reglas de producción (restricciones) |

|---|---|---|---|

| Tipo-0 | Enumerable recursivamente | Máquina de Turing | (sin restricciones) |

| Tipo-1 | Sensibles al contexto | Máquina de Turing no determinista de límites lineales | |

| Tipo-2 | sin contexto | No-determinista Autómata con pila | |

| Tipo-3 | Regular | Autómata finito | and |

Esta teoría explora los límites de la posibilidad de solucionar problemas mediante algoritmos. Gran parte de las ciencias computacionales están dedicadas a resolver problemas de forma algorítmica, de manera que el descubrimiento de problemas imposibles es una gran sorpresa. La teoría de la computabilidad es útil para no tratar de resolver algorítmicamente estos problemas, ahorrando así tiempo y esfuerzo.

Los problemas se clasifican en esta teoría de acuerdo a su grado de imposibilidad:

Hay una versión más general de esta clasificación, donde los problemas incomputables se subdividen a su vez en problemas más difíciles que otros. La herramienta principal para lograr estas clasificaciones es el concepto de reducibilidad: Un problema se reduce al problema si bajo la suposición de que se sabe resolver el problema es posible resolver al problema ; esto se denota por , e informalmente significa que el problema no es más difícil de resolver que el problema . Por ejemplo, bajo la suposición de que una persona sabe sumar, es muy fácil enseñarle a multiplicar haciendo sumas repetidas, de manera que multiplicar se reduce a sumar.

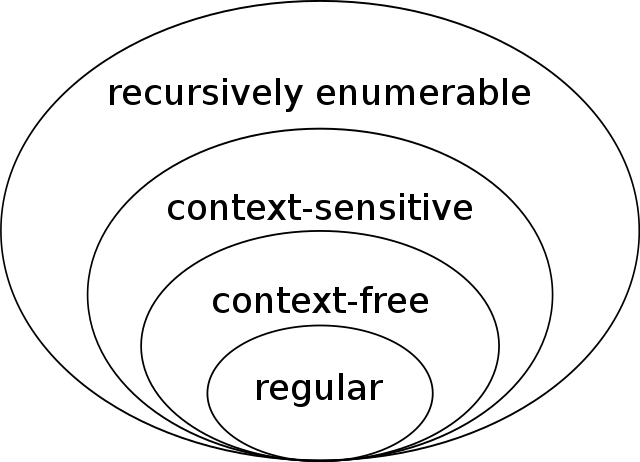

La teoría del lenguaje es una rama de las matemáticas que se ocupa de describir los lenguajes como un conjunto de operaciones sobre un alfabeto. Está estrechamente relacionada con la teoría de autómatas, ya que éstos se utilizan para generar y reconocer lenguajes formales. Existen varias clases de lenguajes formales, cada una de las cuales permite una especificación del lenguaje más compleja que la anterior, es decir, la jerarquía de Chomsky,[5] y cada una correspondiente a una clase de autómatas que la reconoce. Dado que los autómatas se utilizan como modelos para la computación, los lenguajes formales son el modo preferido de especificación para cualquier problema que deba ser computado.

Aun cuando un problema sea computable, puede que no sea posible resolverlo en la práctica si se requiere mucha memoria o tiempo de ejecución. La teoría de la complejidad computacional estudia las necesidades de memoria, tiempo y otros recursos computacionales para resolver problemas; de esta manera es posible explicar por qué unos problemas son más difíciles de resolver que otros. Uno de los mayores logros de esta rama es la clasificación de problemas, similar a la tabla periódica, de acuerdo a su dificultad. En esta clasificación los problemas se separan por clases de complejidad.

Esta teoría tiene aplicación en casi todas las áreas de conocimiento donde se desee resolver un problema computacionalmente, porque los investigadores no solo desean utilizar un método para resolver un problema, sino utilizar el más rápido. La teoría de la complejidad computacional también tiene aplicaciones en áreas como la criptografía, donde se espera que descifrar un código secreto sea un problema muy difícil a menos que se tenga la contraseña, en cuyo caso el problema se vuelve fácil.

Para analizar cuánto tiempo y espacio requiere un algoritmo determinado, los informáticos expresan el tiempo o el espacio necesarios para resolver el problema en función del tamaño del problema de entrada. Por ejemplo, encontrar un número concreto en una larga lista de números se hace más difícil a medida que la lista de números aumenta de tamaño. Si decimos que hay "n" números en la lista, entonces, si la lista no está ordenada o indexada de alguna manera, puede que tengamos que mirar todos los números para encontrar el número que buscamos. Por tanto, para resolver este problema, el ordenador debe realizar un número de pasos que crece linealmente con el tamaño del problema.

Para simplificar este problema, los informáticos han adoptado la notación Big O, que permite comparar funciones de forma que no sea necesario considerar aspectos particulares de la construcción de una máquina, sino sólo el comportamiento asintótico a medida que los problemas se hacen grandes. Así, en nuestro ejemplo anterior, podríamos decir que el problema requiere pasos para resolverse.

Quizás el problema abierto más importante en toda la informática es la cuestión de si una cierta clase amplia de problemas denotada NP puede resolverse eficientemente. Esto se discute más a fondo en Clases de complejidad P y NP, y Clases de complejidad P y NP es uno de los siete Problemas del Premio del Milenio enunciados por el Clay Mathematics Institute en 2000. La Descripción Oficial del Problema Archivado el 4 de septiembre de 2015 en Wayback Machine. fue dada por el ganador del Premio Turing Stephen Cook.

La teoría de la computación comienza propiamente a principios del siglo XX, poco antes que las computadoras electrónicas fuesen inventadas. En esta época varios matemáticos se preguntaban si existía un método universal para resolver todos los problemas matemáticos. Para ello debían desarrollar la noción precisa de método para resolver problemas, es decir, la definición formal de algoritmo.

Algunos de estos modelos formales fueron propuestos por precursores como Alonzo Church (cálculo Lambda), Kurt Gödel (funciones recursivas) y Alan Turing (máquina de Turing). Se ha mostrado que estos modelos son equivalentes en el sentido de que pueden simular los mismos algoritmos, aunque lo hagan de maneras diferentes. Entre los modelos de cómputo más recientes se encuentran los lenguajes de programación, que también han mostrado ser equivalentes a los modelos anteriores; esto es una fuerte evidencia de la conjetura de Church-Turing, de que todo algoritmo habido y por haber se puede simular en una máquina de Turing, o equivalentemente, usando funciones recursivas. En 2007 Nachum Dershowitz y Yuri Gurevich publicaron una demostración de esta conjetura basándose en cierta axiomatización de algoritmos.[6]

Uno de los primeros resultados de esta teoría fue la existencia de problemas imposibles de resolver algorítmicamente, siendo el problema de la parada el más famoso de ellos. Para estos problemas no existe ni existirá ningún algoritmo que los pueda resolver, no importando la cantidad de tiempo o memoria se disponga en una computadora. Asimismo, con la llegada de las computadoras modernas se constató que algunos problemas resolubles en teoría eran imposibles en la práctica, puesto que dichas soluciones necesitaban cantidades irrealistas de tiempo o memoria para poderse encontrar.

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.