В повседневной речи информа́ция (от лат. informātiō «представление, понятие о чём-либо» ← informare «придавать вид, формировать, изображать»[1]) — это абстрактные осмысленные представления суждений о каком-либо объекте. Информация может передаваться, способна наделять знанием и обуславливать действия, обладать количественным измерением[2].

Смысл, вкладываемый в понятие информации, зависит от области применения. Не существует универсального определения, которое объединяло бы концепции информации из разных сфер деятельности.

В международных и российских стандартах даются следующие определения:

- обработанные, организованные и связанные данные, которые порождают смысл (значение) (ISO 5127:2017)[3];

- знания о предметах, фактах, идеях и т. д., которыми могут обмениваться люди в рамках конкретного контекста (ISO/IEC 10746-2:1996)[4];

- знания относительно фактов, событий, вещей, идей и понятий, которые в определённом контексте имеют конкретный смысл (ISO/IEC 2382:2015)[5];

- сведения, воспринимаемые человеком и (или) специальными устройствами как отражение фактов материального или духовного мира в процессе коммуникации (ГОСТ 7.0-99)[6].

Хотя информация должна обрести некоторую форму представления (то есть превратиться в данные), чтобы ей можно было обмениваться, информация есть, в первую очередь, интерпретация (смысл) такого представления (ISO/IEC/IEEE 24765:2010)[7]. Поэтому в строгом смысле информация отличается от данных, хотя в неформальном контексте эти два термина очень часто используют как синонимы.

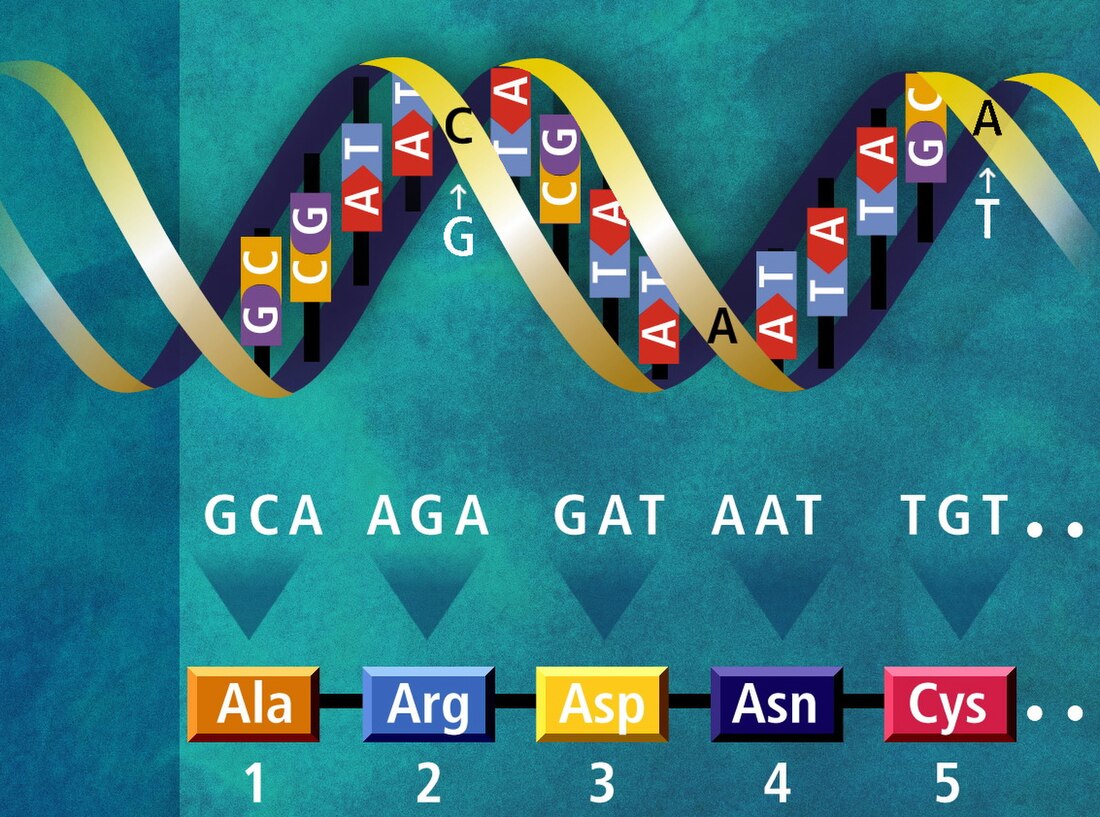

Первоначально «информация» — сведения, передаваемые людьми устным, письменным или каким-либо другим способом (с помощью условных сигналов, технических средств и т. д.); с середины ХХ века термин «информация» превратился в общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире; передачу признаков от клетки к клетке, от организма к организму (например, генетическая информация); одно из основных понятий кибернетики[8].

В современных производных терминах, таких, как информатика, информатизация, подразумевается уже не просто приобщение к обмену сведениями, но и оснащение новейшими технологиями — ИТ.

История понятия

До XX века

В представлении античных философов вся материя существовала в виде четырёх элементов: воды, земли, воздуха и огня. Соответственно, свойства всех вещей были определены той формой, в которую материя соединена[9]. Informatio — «формирование» — понималось как процесс, в результате которого идея получает воплощение: при наблюдении за лошадью в сознании образуется идея о ней; процесс обучения создаёт ученика; художник изготавливает скульптуру, придавая желаемую форму куску мрамора[10]. Историк Джон Дарем Питерс[англ.] предлагает передавать эту концепцию термином «морфогенезис»[11]. Слово informatio использовалось Цицероном и Августином при переводе на латынь таких понятий греческой философии, как эйдос, идея, форма, пролепсис[12]. Фома Аквинский использует для описания гилеморфизма словосочетание informatio materiae («формирование материи»)[10].

Со Средних веков слово «информация» в европейских языках используют в отношении человека образованного, имеющего отношение к науке[10].

Исчезновение концепции морфогенезиса из философского дискурса связано с развитием эмпиризма, не допускающего существования форм за пределами чувственного восприятия. Фрэнсис Бэкон критикует диалектиков, которые «успокаиваются на непосредственных данных (informationibus) хорошо расположенного чувства»[13][11]. Обращаясь к наследию Платона, Джон Локк использует слово «идея» «для выражения того, что подразумевают под словами „фантом“, „понятие“, „вид“, или всего, чем может быть занята душа во время мышления»[14][15]. Для эмпириков поток идей был сырым материалом, на основании которого может быть построено знание, для рационалистов — покровом иллюзий, стоящим на пути разума[11].

Понятие информации как сведений, подлежащих хранению и передаче, возникает в XIX веке[10]. Если для эмпириков информация была связана с чувственным опытом, то с появлением статистики[a] и ростом государственной бюрократии она стала подразумевать знание за пределами опыта конкретного индивида[11]. Такой смысловой переход также связывают с развитием способов коммуникации: массовый выпуск газет, словарей, энциклопедий, распространение почтовых услуг, изобретение телеграфа и телефона привели к восприятию информации как самостоятельного явления, представленного в конкретной форме и обладающего истинностью. Понятие стало относиться не к знаниям, а к определённому способу их приобретения — утверждениям, объективность которых проистекает из факта их публикации в книге или ином авторитетном источнике[16]. Как отмечает социолог Алвин Уорд Гоулднер, знание в виде информации — «это скорее атрибут культуры, чем личности; его значение, его отыскание и его последствия — всё является деперсонализованным… Культура может помогать или препятствовать осознанию, но культура сама по себе не может осознавать»[17]. По мнению Мишеля де Серто, переход читателя в положение пассивного потребителя стал шагом в развитии идей Просвещения о преобразовании общества посредством популяризации знания[18][19].

Математическая теория информации

В середине XX века слово «информация» приобретает новый смысл, связанный с понятием энтропии. В 1948 году выходит книга Норберта Винера «Кибернетика, или управление и связь в животном и машине», где об информации говорится как о третьем фундаментальном понятии природы наряду с материей и энергией. В то же время Клод Шеннон, развивая идеи Гарри Найквиста и Ральфа Хартли, вводит понятие бита как единицы измерения количества информации. Рассматривая проблему оптимизации передачи сигнала по каналу связи, он предлагает свою модель коммуникации, будучи уверенным в том, что «семантические аспекты связи не имеют отношения к инженерной стороне вопроса»[9]. Уоррен Уивер[англ.] уточняет, что в рамках их теории слово «информация» используется не в общепринятом значении, а как характеристика передаваемого сигнала, не подразумевающая наличия смысла.[20][19][21] Такое понимание термина ложится в основу таких концепций, как обработка информации и информационные технологии[16].

Ларс Квортруп[дат.] отмечает, что информация в теории Шеннона и Уивера описывается противоречиво: и как объективная количественная величина, и как субъективный выбор отправителя сообщения[22][23]. С точки зрения семиотики, математическая теория информации описывает только синтаксис (взаимосвязь знаков между собой), но не касается семантики (связи знаков и смысла) и прагматики (связи знаков и людей).[21] Философ Петер Яних[нем.] видит в этом влияние идей семиотика Чарлза Морриса, который считал, что решение проблем синтаксиса создаст предпосылки для решения проблем семантики и прагматики[24]. В 1952 году семантическая теория информации была представлена Йегошуа Бар-Хиллелом и Рудольфом Карнапом[25]. В 1980-е годы теория Шеннона разрабатывается Фредом Дрецке с точки зрения эпистемологии и Джоном Барвайзом[англ.] и Джоном Перри[англ.] в рамках философии языка[15][12]. Теории семантической информации проводят разграничение между данными (последовательностью звуков или символов) и их смысловым содержанием[26].

Дальнейшее распространение термина

С распространением вычислительной техники математическая теория информации оказывает большое влияние на другие сферы деятельности, которые в послевоенные годы всё больше перенимают позитивистские методы естественных наук.[21] Во второй половине XX века закрепляется понимание информации как абстрактного явления, существующего в отрыве от её истинности и конкретной формы представления[16]. Лингвист Джеффри Нанберг[англ.] отмечал, что связанная с современными технологиями концепция начинает ретроактивно применяться по отношению к событиям прошлого: «Нас убеждают, что передаваемая компьютерами субстанция — „информация“ в техническом смысле — по сути то же, что привело к Реформации и Французской революции»[19].

В терминах работы с информацией начинают определять себя такие сферы деятельности, как информатика, электротехника, библиотековедение, психолингвистика, менеджмент, экономика, журналистика, коммуникативистика[11]. С когнитивной революцией эта концепция занимает центральное место в психологии, где начинает доминировать функционализм, рассматривающий сознание по аналогии с обработкой информации вычислительными машинами. За дисциплиной, прежде известной как документалистика, закрепляется название «информационная наука».[27] В 1964 году Мартин Хайдеггер говорил о том, что науки «начинают определяться и направляться новой основной наукой» — кибернетикой, которая «преображает речь в обмен сообщениями», а «искусства становятся направленно-направляющими инструментами [передачи] информации»[28]. В опубликованной в 1983 году работе экономиста Фрица Махлупа отмечается, что представители гуманитарных наук используют в своих теориях общепринятое определение информации, накладывая на него для своих нужд некоторые ограничения: «Требование истинности или правильности должно исключить ложные или неправильные сообщения; требование ценности или полезности должно исключить сообщения, бесполезные для принятия решений; требование новизны должно исключить повторные или избыточные сообщения; требование неожиданности должно исключить сообщения, ожидаемые получателем; требование уменьшения неопределенности должно исключить сообщения, которые не меняют или увеличивают состояние неопределенности получателя; и так далее… Специалисты в ряде дисциплин… ввели удобные для своих целей ограничения, осложнив для неспециалистов понимание того, что имеется в виду». Использование термина «информация» в контекстах, не подразумевающих наличие разумного получателя, Махлуп считает метафорическим (когда речь идёт о биологических системах или группах организмов) или просто некорректным (когда речь идёт о воздействии на механизм или коммуникациях)[29].

Понятие информационной экономики закрепилось в связи с опубликованной в 1977 году одноимённой работой Марка Пората[англ.] и Майкла Рубина. Они обосновывали предложенную ранее Махлупом идею о переходе экономики развитых стран от промышленного производства к знаниям, оценивая четвертичный сектор в 46 % ВНД США[30][31]. По мнению историка Джеймса Бенигера[англ.], парадигмы кибернетики и математической теории информации помогли решить вызванный индустриализацией кризис управления производством, распространением и потреблением товаров. Распространение новых технологий обработки и передачи информации обусловило переход от индустриального общества к информационному[32].

Суть и границы явления

Утверждается, что мы живём в эпоху информации, но при этом очевиден возмутительный факт: у нас нет ни теории, ни даже определения информации, которое было бы достаточно широким и чётким, чтобы придать этому утверждению смысл.

Слово «информация» получило множество определений от различных авторов в рамках теории информации… Едва ли следует ожидать, что единое понятие информации сможет удовлетворить все потребности этой дисциплины.

...нельзя уверенно сказать о чём-либо, что оно не может быть информацией.

Не существует универсального определения информации, которое объединяло бы смыслы, вкладываемые в это понятие в рамках различных теорий: физики, теории связи, кибернетики, статистической теории информации, психологии, семантики, индуктивной логики[36]. Некоторые исследователи скептически оценивают возможность сформулировать такое определение[37][30].

Согласно трилемме Капурро[нем.] ответ на вопрос об определении информации предполагает выбор одной из трёх позиций[38]:

- Однозначность: информация имеет одно и то же значение во всех контекстах.

- Аналогия: информация имеет одно правильное значение в определённом контексте, но может применяться в других контекстах как аналогия.

- Неоднозначность: информация может иметь множество определений, зависящих от контекста.

Гернот Версиг[нем.] отмечает, что под информацией могут подразумевать[39]:

- характеристику объектов материального мира или их взаимоотношений, существующая независимо от наблюдателя;

- знание, полученное посредством восприятия;

- сообщение;

- смысл, выражаемый знаками;

- результат процесса;

- процесс.

Лучано Флориди выделяет три подхода к определению информации[40]:

- информация как реальность (вид физического сигнала, к которому не применим критерий истинности);

- информация о реальности (семантическая информация, к которой применим критерий истинности и на основе которой конструируется знание);

- информация для реальности (инструкции — генетическая информация, алгоритмы, рецепты).

Джонатан Фёрнер классифицирует определения информации следующим образом[26]:

- семиотические определения предполагают разграничение между фактами реального мира, мысленными представлениями о них и языковыми выражениями этих представлений, относя понятие информации к одной из этих категорий;

- социокогнитивные определения понимают информацию как действие или событие, связанное с изменением представлений индивида о реальности, которые зависят от индивидуальных, социальных и культурных факторов;

- эпистемические определения направлены на выявление свойств, которыми должен обладать источник информации, чтобы обосновать некое утверждение в достаточной степени, чтобы его можно было считать знанием.

Теория связи рассматривает информацию как физический феномен с точки зрения синтаксиса. Она касается сложности и частоты передаваемых сигналов в отрыве от их интерпретации. Алгоритмическая теория информации также рассматривает информацию как количественную характеристику, исходя из необходимых для её кодирования вычислительных ресурсов[40].

| Четыре аспекта информации[35] | ||

|---|---|---|

| Нематериальный | Материальный | |

| Явление | Информация как знание | Информация как объект (данные, документ, записанные сведения) |

| Процесс | Информация как процесс (информирование) | Обработка информации (обработка данных, документов, инженерия знаний) |

Майкл Бакленд выделяет три категории информации: знания, процесс информирования и объекты информации. К последним он относит все объекты и события, из которых можно получить знания, высказываясь против определения информации как обработанных данных, собранных в осмысленном виде[b]: «Во-первых, это оставляет без ответа вопрос о том, как следует называть другие информативные явления, такие как окаменелости, следы и крики ужаса. Во-вторых, возникает дополнительный вопрос о том, какой объем обработки и/или сбора необходим для того, чтобы данные могли называться информацией»[42].

Грегори Бейтсон определял информацию как «различимое различие» (англ. a difference which makes a difference)[43], то есть такой феномен реальности, который влияет на воспринимающего субъекта. Для животного, адаптированного к жизни в своей экологической нише, информативными будут те свойства среды, изменения в которых воспринимаются его органами чувств. Для людей информативность зависит от культурных и социальных факторов[9]. Бенни Карпачоф определял информацию как эмерджентный феномен, связанный с конкретным механизмом, устроенным таким образом, чтобы специфическим образом высвобождать запасённую потенциальную энергию при получении определённого сигнала извне[44]. В таком представлении базовой функцией информации является управление действиями в организованной системе, состоящей из взаимозависимых элементов или подсистем, и любую такую систему (живой организм, сообщество, рукотворный механизм) можно рассматривать как информационный процессор[45][30].

Информационные процессы

Марк Бургин предлагает следующую классификацию информационных процессов по отношению к участвующей в них системе[30]:

- Информирование (воздействие информации на систему)

- Приём информации (получение системой информации от источника)

- Добыча информации (работа системы, направленная на получение существующей информации)

- Производство информации

- Обработка информации (воздействие системы на информацию)

- Преобразование информации (изменение информации или её представления)

- Передача информации (перемещение носителя информации в пространстве)

- Хранение информации (перемещение носителя информации во времени)

- Применение информации (воздействие одной системы на другую посредством информации)

Классификация информации

В разделе не хватает ссылок на источники (см. рекомендации по поиску). |

Информацию можно разделить на виды по различным критериям:

- По способу восприятия:

- Визуальная — воспринимаемая органами зрения.

- Звуковая — воспринимаемая органами слуха.

- Тактильная — воспринимаемая тактильными рецепторами.

- Обонятельная — воспринимаемая обонятельными рецепторами.

- Вкусовая — воспринимаемая вкусовыми рецепторами.

- По форме представления:

- Текстовая — передаваемая в виде символов, предназначенных обозначать лексемы языка.

- Числовая — в виде цифр и знаков (символов), обозначающих математические действия.

- Графическая — в виде изображений, предметов, графиков.

- Звуковая — устная или в виде записи и передачи лексем языка аудиальным путём.

- Видеоинформация — передаваемая в виде видеозаписи.

- По назначению:

- Массовая — содержит тривиальные сведения и оперирует набором понятий, понятным большей части социума.

- Специальная — содержит специфический набор понятий, при использовании происходит передача сведений, которые могут быть не понятны основной массе социума, но необходимы и понятны в рамках узкой социальной группы, где используется данная информация.

- Секретная — передаваемая узкому кругу лиц и по закрытым (защищённым и адаптивным) каналам.

- Личная (приватная) — набор сведений о какой-либо личности, определяющий социальное положение и типы социальных взаимодействий внутри популяции.

- По значению:

- Актуальная — информация, ценная в данный момент времени.

- Достоверная — информация, полученная без искажений с надежных источников.

- Понятная — информация, выраженная на языке, понятном тому, кому она предназначена.

- Полная — информация, достаточная для принятия правильного решения или понимания.

- Ценная — полезность информации определяется субъектом, получившим информацию в зависимости от объёма возможностей её использования.

- По истинности:

В основу классификации положено пять общих признаков:

- Место возникновения.

- Стадия обработки.

- Способ отображения.

- Стабильность.

- Функция управления.

Информация в различных областях деятельности

Этот раздел нуждается в переработке. |

В информатике

Этот раздел не завершён. |

Предметом изучения информатики являются именно данные: методы их создания, хранения, обработки и передачи[46]. Данные представляют собой информацию в формализованном виде (в цифровой форме), позволяющем автоматизировать её сбор, хранение и дальнейшую обработку в ЭВМ. С этой точки зрения информация является абстрактным понятием, рассматриваемым безотносительно к её семантическому аспекту, а под количеством информации обычно понимается соответствующий объём данных. Однако одни и те же данные могут быть закодированы различным образом и иметь при этом различный объём, поэтому иногда рассматривается также понятие «ценность информации», которое связано с понятием информационной энтропии и является предметом изучения теории информации.

В теории информации

Теория информации (математическая теория связи) — изучает процессы хранения, преобразования и передачи информации. Она основана на научных методах измерения количества информации[47]. Теория информации развилась из потребностей теории связи. Основополагающими считаются «Передача информации[48]» Ральфа Хартли опубликованные в 1928 году и «Работы по теории информации и кибернетике[49]» Клода Шеннона, опубликованные в 1948 году. Теория информации изучает пределы возможностей систем передачи данных, а также основные принципы их проектирования и технической реализации[50].

С теорией информации связаны радиотехника (теория обработки сигналов) и информатика, относящиеся к измерению количества передаваемой информации, её свойства и устанавливающие предельные соотношения для систем. Основные разделы теории информации — кодирование источника (сжимающее кодирование) и канальное (помехоустойчивое) кодирование. Информация не входит в число предметов исследования математики. Тем не менее, слово «информация» употребляется в математических терминах — собственная информация и взаимная информация, относящихся к абстрактной (математической) части теории информации. Однако, в математической теории понятие «информация» связано с исключительно абстрактными объектами — случайными величинами, в то время как в современной теории информации это понятие рассматривается значительно шире — как свойство материальных объектов[источник не указан 3606 дней].

Связь между этими двумя одинаковыми терминами несомненна. Именно математический аппарат случайных чисел использовал автор теории информации Клод Шеннон. Сам он подразумевает под термином «информация» нечто фундаментальное (нередуцируемое). В теории Шеннона интуитивно полагается, что информация имеет содержание. Информация уменьшает общую неопределённость и информационную энтропию. Количество информации доступно измерению. Однако он предостерегает исследователей от механического переноса понятий из его теории в другие области науки[источник не указан 3606 дней].

В теории управления (кибернетике)

Основоположник кибернетики Норберт Винер дал следующее определение информации: «Информация — это обозначение содержания, полученное нами из внешнего мира в процессе приспосабливания к нему нас и наших чувств»[51].

Кибернетика рассматривает машины и живые организмы как системы, воспринимающие, накапливающие и передающие информацию, а также перерабатывающие её в сигналы, определяющие их собственную деятельность[52].

Материальная система в кибернетике рассматривается как множество объектов, которые сами по себе могут находиться в различных состояниях, но состояние каждого из них определяется состояниями других объектов системы. В природе множество состояний системы представляет собой информацию, сами состояния представляют собой первичный код или код источника. Таким образом, каждая материальная система является источником информации.

Субъективную (семантическую) информацию кибернетика определяет как смысл или содержание сообщения. Информация — это характеристика объекта.

Алгоритмическая теория информации

Как область математики — алгоритмическая теория информации была создана А. Н. Колмогоровым[53]. Две основополагающие статьи по ней были опубликованы в журнале «Проблемы передачи информации» в 1965 и 1969 годах[54][55][56]. Центральным в этой теории является понятие алгоритмической (также называемой колмогоровской) сложности информационного объекта, то есть алгоритмического способа его описания (формирования); эта сложность определяется как минимальная длина алгоритма, формирующего такой объект. Теорема Колмогорова устанавливает, что среди алгоритмов, формирующий информационный объект существуют оптимальные, хотя такие алгоритмы не единственные и отличаются для разных способов представления алгоритмов, тем не менее для заданных двух оптимальных способов их длина (сложность) отличается не более чем на аддитивную константу. Задача вычисления алгоритмической сложности объекта является алгоритмически неразрешимой.

В семиотике

Семиотика — комплекс научных теорий, изучающих свойства знаковых систем. Наиболее существенные результаты достигнуты в разделе семиотики — семантике. Предметом исследований семантики является значение единиц языка, то есть информация, передаваемая посредством языка.

Знаковой системой считается система конкретных или абстрактных объектов (знаков, слов), с каждым из которых определённым образом сопоставлено некоторое значение. В теории доказано, что таких сопоставлений может быть два. Первый вид соответствия определяет непосредственно материальный объект, который обозначает это слово и называется денотат (или, в некоторых работах, — номинат). Второй вид соответствия определяет смысл знака (слова) и называется концепт. При этом исследуются такие свойства сопоставлений как «смысл», «истинность», «определимость», «следование», «интерпретация» и др. Для исследований используется аппарат математической логики и математической лингвистики.

Идеи семантики, намеченные ещё Г. В. Лейбницем и Ф. де Соссюром в XIX веке, сформулировали и развили Ч. Пирс (1839—1914), Ч. Моррис (1901—1979), Р. Карнап (1891—1970) и др.

Основным достижением теории является создание аппарата семантического анализа, позволяющего представить смысл текста на естественном языке в виде записи на некотором формализованном семантическом (смысловом) языке.

Семантический анализ является основой для создания устройств (программ) машинного перевода с одного естественного языка на другой.

В юриспруденции

Любые сведения, сообщения, данные, независимо от их оформления, являются информацией — материальным или нематериальным объектом, участвующим в любых отношениях. Развитие технологических возможностей переработки и передачи информации выделило её в самостоятельный предмет производственных, управленческих, идеологических и личных отношений. Информация стала товаром, продукцией, предметом труда и объектом услуг. В системе правовых отношений её рассматривает информационное право. Некоторые международные правовые акты и законодательства ряда стран (в том числе России) провозглашают право человека на свободный поиск, получение, передачу, производство и распространение информации любым способом, не нарушающим законы[57].

В квантовой физике

Квантовая теория информации рассматривает общие закономерности передачи, хранения и преобразования информации в системах, изменяющихся по законам квантовой механики[58].

Информационная политика в организациях

Можно выделить следующие модели информационной политики в организациях[59]:

- Анархия: отсутствие общей политики управления информацией.

- Феодализм: подразделения организации самостоятельно принимают решения по управлению информацией, предоставляя её руководству в ограниченном виде.

- Федерализм: поиск консенсуса по управлению информацией между структурами организации.

- Монархизм: руководство организации контролирует потоки информации и может ограничивать доступ к ней.

- Техноутопизм: поиск технологического решения для категоризации и моделирования информации.

Измерение информации

| Измерения в байтах | ||||||||

|---|---|---|---|---|---|---|---|---|

| ГОСТ 8.417—2002 | Приставки СИ | Приставки МЭК | ||||||

| Название | Обозначение | Степень | Название | Степень | Название | Обозначение | Степень | |

| байт | Б | 100 | — | 100 | байт | B | Б | 20 |

| килобайт | Кбайт | 103 | кило- | 103 | кибибайт | KiB | КиБ | 210 |

| мегабайт | Мбайт | 106 | мега- | 106 | мебибайт | MiB | МиБ | 220 |

| гигабайт | Гбайт | 109 | гига- | 109 | гибибайт | GiB | ГиБ | 230 |

| терабайт | Тбайт | 1012 | тера- | 1012 | тебибайт | TiB | ТиБ | 240 |

| петабайт | Пбайт | 1015 | пета- | 1015 | пебибайт | PiB | ПиБ | 250 |

| эксабайт | Эбайт | 1018 | экса- | 1018 | эксбибайт | EiB | ЭиБ | 260 |

| зеттабайт | Збайт | 1021 | зетта- | 1021 | зебибайт | ZiB | ЗиБ | 270 |

| йоттабайт | Ибайт | 1024 | йотта- | 1024 | йобибайт | YiB | ЙиБ | 280 |

| роннабайт | - | 1027 | ронна- | 1027 | - | - | - | - |

| кветтабайт | - | 1030 | кветта- | 1030 | - | - | - | - |

Пионером в области информационной теории был Ральф Хартли. Он ввёл понятие «информации» (энтропии) как случайной переменной и был первым, кто попытался определить «меру информации».

Простейшей единицей измерения информации является бит — единица измерения количества информации, принимающая 2 логических значения: да или нет, истина или ложь, включено или выключено; 1 или 0 в двоичной системе счисления.

В современных вычислительных системах одномоментно обрабатываются 8 бит информации, называемые байтом. Байт может принимать одно из 256 (28) различных значений (состояний, кодов). Производные от байта десятичные единицы измерения, соответственно, именуются килобайт (103 = 1000 байт), мегабайт (106 = 1 000 000 байт), гигабайт (109 = 1 000 000 000 байт) и т. д.[60]

Производные от байта двоичные (бинарные) единицы измерения именуются кибибайт (210 = 1024 байт), мебибайт (220 = 1 048 576 байт), гибибайт (230 = 1 073 741 824 байт) и так далее[60].

Также, информацию измеряют такими единицами как трит, Хартдит (децит) и Нат.

Символ информации

В разделе не хватает ссылок на источники (см. рекомендации по поиску). |

Обычно[где?] информацию обозначают маленькой буквой i в кружочке

| Символ | Юникод | Название |

|---|---|---|

| ℹ | U+2139 | information source |

| ⓘ | U+24D8 | circled latin small letter i |

Дезинформация

Дезинформацией (также дезинформированием) называется один из способов манипулирования информацией, как то введение кого-либо в заблуждение путём предоставления неполной информации или полной, но уже не нужной информации, или полной, но не в нужной области, искажения контекста, искажения части информации.

Цель такого воздействия всегда одна — оппонент должен поступить так, как это необходимо манипулятору. Поступок объекта, против которого направлена дезинформация, может заключаться в принятии нужного манипулятору решения или в отказе от принятия невыгодного для манипулятора решения. Но в любом случае конечная цель — это действие, которое будет предпринято.

См. также

- Информационные процессы

- Информационный взрыв

- Информационный барьер

- Информационная безопасность

- Информационная война

- Информационное общество

- Информационное пространство

- Данные, сигнал, сообщение

- Знание, смысл, семантика

- База данных

- Квантовая информация

Категория информации по отраслям знаний

- Аэронавигационная информация

- Географическая информация

- Инсайдерская информация

- Научно-техническая информация

- Секретная информация

- Генетическая информация

В информатике:

- Предмет исследования

- Единицы измерения информации

- Носитель информации

- Передача информации

- Скорость передачи информации

- База знаний

- Экспертные системы

- Защита информации

- Информационная безопасность

- Информационное право

В общественных науках:

- Асимметричность информации

- Общение

- Рабочие источники информации переводчика

- Обязательное раскрытие информации

- Средства массовой информации

В физиологии и медицине:

В других областях:

Примечания

Литература

Ссылки

Wikiwand in your browser!

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.