Virtuelle Maschine

rein softwarebasierter Computer auf einem anderen Computer Aus Wikipedia, der freien Enzyklopädie

Als virtuelle Maschine (VM) wird in der Informatik die Software-technische Kapselung eines Rechnersystems innerhalb eines lauffähigen Rechnersystems bezeichnet. Die virtuelle Maschine bildet die Rechnerarchitektur eines real in Hardware existierenden oder eines hypothetischen Rechners nach.[1]

Die abstrahierende Schicht zwischen realem oder Host- bzw. Wirt-Rechner, auf dem die virtuelle Maschine ausgeführt wird, und der virtuellen Maschine wird Hypervisor oder Virtual Machine Monitor genannt; ihre Implementierung erfolgt

- rein hardwarebasiert

- rein softwarebasiert oder

- durch eine Kombination.

Der Hypervisor erlaubt in der Regel den Betrieb mehrerer virtueller Maschinen gleichzeitig auf einem physischen Rechner.

Virtuelle Maschinen werden direkt auf der CPU des Gastgeberrechners ausgeführt und nutzen üblicherweise deren Virtualisierungsfunktionen. Dagegen wird bei Emulatoren die Ausführung rein als Software realisiert, wodurch auch eine andere Rechnerarchitektur als die des Gastgeberrechners nachgebildet werden kann.

Typen virtueller Maschinen

Zusammenfassung

Kontext

Virtuelle Maschinen werden heute danach eingeteilt, in welchem Umfang sie die Funktionalität eines realen Rechners nachstellen. Systembasierte virtuelle Maschinen bilden einen Rechner so vollständig nach, dass Betriebssysteme, die für den realen Rechner entworfen wurden, sich auf der virtuellen Maschine genauso wie auf dem entsprechenden realen Rechner ausführen lassen.[2] Dieser Ansatz wird auch als vollständige Virtualisierung bezeichnet.[3] Er basiert im Wesentlichen auf der von Robert Goldberg gegebenen und von Gerald Popek 1972 noch enger gefassten Definition:

„Eine virtuelle Maschine ist ein effizientes, identisches und isoliertes Duplikat eines echten Prozessors.“[4]

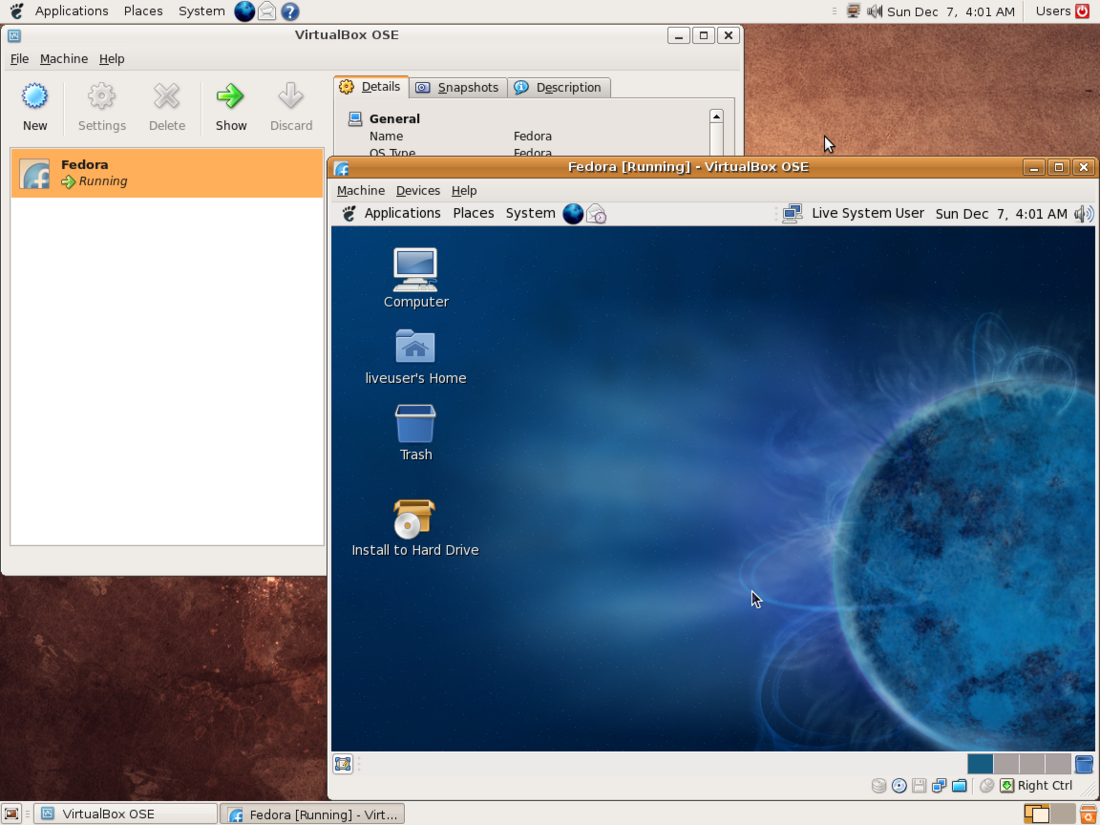

Beispiele für bekannte Produkte, die Virtualisierung mit Hilfe systembasierter virtueller Maschinen realisieren, sind Oracles VirtualBox oder VMwares vSphere.

Im Gegensatz dazu erlauben es prozessbasierte virtuelle Maschinen lediglich, einzelne Programme abstrahiert von der Ausführungsumgebung einer Rechnerarchitektur auszuführen, indem sie eine darauf aufbauende Laufzeitumgebung bereitstellen.[5] Meist werden solche virtuellen Maschinen auf mehreren Rechnerarchitekturen bereitgestellt, wodurch die Anwendung dann auf all diesen Plattformen ohne Änderung ausgeführt werden kann. Bekannte Beispiele solcher Umgebungen mit entsprechenden virtuellen Maschinen sind die Java-Laufzeitumgebung als Teil der Java-Plattform und die Common Language Runtime als Teil des .NET Frameworks.

Systembasierte virtuelle Maschinen

Geschichte

Der Wunsch, mehrere Betriebssysteme gleichzeitig auf einem Rechner betreiben zu können, war die ursprüngliche Motivation zur Einführung systembasierter virtueller Maschinen. IBMs 1966 erstmals veröffentlichte CP/CMS war das erste Betriebssystem, welches vollständige Virtualisierung unterstützte und es dadurch mehreren Benutzern erlaubte, gleichzeitig auf einem physischen Rechner jeweils ein eigenes Einzelbenutzerbetriebssystem unabhängig zu nutzen.[6]

In ihrem Artikel Formal Requirements for Virtualizable Third Generation Architectures von 1974 legten Gerald J. Popek and Robert P. Goldberg die formalen Grundlagen und stellen die grundlegenden Anforderungen an eine Architektur dar, um virtuelle Maschinen mit Hilfe eines Hypervisors zu unterstützen.[4]

Vor- und Nachteile des Einsatzes systembasierter virtueller Maschinen

Der Einsatz systembasierter virtueller Maschinen bietet gegenüber der direkten Ausführung von Betriebssystemen auf dem Rechner einige Vorteile:

- Mehrere Betriebssysteme gleichzeitig

- Unterschiedliche Betriebssysteme können gleichzeitig auf der gleichen physischen Maschine betrieben werden. Dadurch können Ressourcen des physischen Rechners (z. B. der Prozessor) besser ausgenutzt werden, da mehrere Betriebssysteme sich diese teilen können. Auch können unterschiedliche Betriebssystemversionen oder Systeme von unterschiedlichen Betriebssystemherstellern parallel betrieben werden.

- Unterstützung unterschiedlicher Instruktionssätze

- Die virtuelle Maschine kann eine Befehlssatzarchitektur unterstützen, die von der physischen Maschine abweicht. Dadurch können Betriebssysteme ausgeführt werden, die auf der realen Hardware gar nicht lauffähig wären.

- Erhöhte Sicherheit

- Virtuelle Maschinen können zwar ebenso von Schadprogrammen befallen werden. In diesem Fall kann die virtuelle Maschine jedoch meist gelöscht und neu aufgesetzt werden, ohne dass der physische Computer dahinter mit langfristigen Schäden zu kämpfen hat.

- Günstigerer und vereinfachter Betrieb

- Insbesondere in Rechenzentren müssen sehr viele Systeme parallel betrieben werden. Durch den Einsatz von virtuellen Maschinen muss nicht für jedes System eigene Hardware bereitgestellt werden, sondern unterschiedliche Systeme teilen sich eine sehr leistungsfähige Plattform. Da der Betrieb einer sehr leistungsfähigen Plattform in der Regel wirtschaftlicher ist als der Betrieb vieler kleinerer Plattformen mit der (insgesamt) gleichen Leistung, bietet sich der Ansatz der Virtualisierung für Rechenzentren (siehe auch Rezentralisierung) an.

Allerdings „erkauft“ man sich diese Vorteile auch mit einigen Nachteilen, die sich gegenüber direkter Ausführung des Betriebssystems auf dem Rechner ergeben:

- Effizienzverlust

- Eine virtuelle Maschine ist weniger effizient als die reale Maschine, da ein Teil der Leistungsfähigkeit für den Betrieb des Hypervisors (zur Verwaltung der virtuellen Maschinen) verwendet werden muss.

- Gegenseitige Beeinflussung gleichzeitig betriebener virtueller Maschinen

- Wenn mehrere virtuelle Maschinen parallel betrieben werden, ist zwar durch den Hypervisor eine Trennung sichergestellt, jedoch teilen sie sich die (beschränkten) Ressourcen des physischen Rechners. Da das Lastverhalten anderer virtueller Maschinen für eine einzelne VM nicht vorhersehbar und beeinflussbar ist, können Lastspitzen zu instabiler bzw. nicht vorhersagbarer Leistungsfähigkeit einzelner oder aller gleichzeitig betriebener virtuellen Maschinen führen, wenn der Hypervisor hier nicht gesonderte Vorkehrungen trifft (z. B. durch Zusicherung von Ressourcen für einzelne VMs).

- Neuartige Herausforderungen bzgl. Sicherheit und Datenschutz

- Schutzmechanismen gegen Viren und Malware wurden bisher auf Betriebssystemebene umgesetzt und schützten so den Benutzer. Durch den Einsatz von Hypervisoren entsteht eine neue Angriffsmöglichkeit, nämlich der Hypervisor selbst, um Schadcode auf dem Rechner auszuführen. Daher sind neuartige Schutzmechanismen über die bisher bekannten hinaus erforderlich.

- Neue Herausforderungen hinsichtlich der Lizenzierung von Betriebssystemen

- Während die Lizenzierung eines Betriebssystems früher an einen jeweiligen physischen Rechner mit seinen Eigenschaften (z. B. Anzahl Prozessoren, Speichergröße) gebunden war, ist das durch die Virtualisierung nicht mehr ohne weiteres möglich. Es muss kein Rechner mehr mit der tatsächlichen Speichergröße oder Anzahl Prozessoren existieren, sondern er existiert ggf. nur virtuell. Dies zwingt Hersteller und Kunden zur Auseinandersetzung mit teils recht komplizierten Lizenzmodellen. Bestimmte Hersteller (z. B. Apple) erlauben auch gar keine Virtualisierung ihrer Betriebssysteme. Die Rechtsgültigkeit dieses Verbotes ist allerdings in Deutschland umstritten.

Methoden

Hypervisor

Hardware-Emulation

Hardware-Virtualisierung

Paravirtualisierung

Anwendungsszenarien

Prozessbasierte virtuelle Maschinen

Geschichte

Die Geschichte der prozessbasierten virtuellen Maschinen begann mit dem bahnbrechenden Aufsatz Transportability of Software Applications on Microcomputers von W. Wellbourne (1983) und der vorausgegangenen Arbeit A Comparison of Pascal Intermediate Languages von P. Nelson (1979).[7] Es geht hier um die Lösung des Problems, Anwendungscode, der für eine Rechnerarchitektur entwickelt wurde, ohne Änderungen auf einer anderen Rechnerarchitektur auszuführen. Insbesondere um den Portierungsaufwand für Anwendungen von einer Architektur zu anderen (z. B. neuen Rechnerarchitekturen) gering zu halten.

Vor- und Nachteil des Einsatzes prozessbasierter virtueller Maschinen

Der Einsatz von prozessbasierten virtuellen Maschinen bietet folgende Vorteile:

- Plattformunabhängigkeit: Programme für eine virtuelle Maschine laufen auf allen physischen Maschinen, für die die virtuelle Maschine implementiert ist.

- Dynamische Optimierung ist möglich

Der Einsatz von prozessbasierten virtuellen Maschinen hat folgende Nachteile:

- Die Ausführung eines portablen Programms auf einer portablen virtuellen Maschine ist langsamer als die native Ausführung eines Programms, das speziell für die Zielumgebung übersetzt wurde.

- Bei Verwendung eines Interpreters ergeben sich zusätzliche Indirektionen, was ineffizienter ist als direkte Ausführung.

- Dynamische Übersetzung zur Laufzeit (JIT-Compiler) löst zwar die meisten Indirektionen auf und sorgt für großteils direkte Ausführung, jedoch erfordert die Übersetzung selbst zusätzlichen Aufwand, bis der Code direkt ausgeführt werden kann (jedoch nur im Moment der Übersetzung, nicht mehr bei späteren Durchläufen).

Diese Nachteile können durch geeignete (z. B. dynamische) Optimierung verringert werden. Eine weitere Möglichkeit ist die automatische Kompilierung mittels Ahead-of-time-Compiler unmittelbar vor der Ausführung. Damit wird das Backend eines hochoptimierenden, maschinenorientierten Compilers unmittelbar auf dem Anwendersystem ausgeführt. Dadurch kann der Compiler noch spezifischere Optimierungen für das System des Anwenders vornehmen als es bei einem vorkompilierten Programm ohne spezielle Optimierungen für das System bzw. den Prozessor des Anwenders möglich wäre.

Anwendungsszenarien

- Entwicklung von Unternehmenssoftware

Siehe auch

Literatur

- Iain D. Craig: Virtual Machines. Springer, 2006, ISBN 1-85233-969-1, 269 Seiten

Weblinks

- Pascal-P-Code-Maschine. (das p-System war auch ein komplettes Betriebssystem – englisch)

- Virtual Private Server (Weiterführender Artikel über Virtual Private Server)

Einzelnachweise

Wikiwand - on

Seamless Wikipedia browsing. On steroids.