Big data (от английски: „големи данни“) е научна област, изучаваща начините за анализиране, систематичното извличане на информация от и въобще работата с големи набори от данни, които иначе са твърде големи или сложни за традиционния приложен софтуер за обработка на данни. Данните с много полета (колони) предлагат по-голяма статистическа мощ, докато данните с по-голяма сложност (повече атрибути или колони) могат да доведат до по-висока фалшива степен на откриване.[1] Предизвикателствата пред анализа на големи набори от данни включват прихващането на данните, съхранението, анализа, споделянето, трансфера, визуализацията, търсенето, обновяването и предпазването им. В началото big data се свързва с три ключови концепции: обем, разнообразие и скорост.[2] Анализът на многобройните данни среща препятствия при извличането на извадка от тях. Big data често включва данни, чийто размер надхвърля капацитета на традиционния софтуер за своевременното им обработване.

Днешната употреба на термина big data често се отнася за употребата на прогнозни анализи, анализ на поведението на потребителите или други сложни аналитични методи, които извличат стойности от голям обем данни, и по-рядко за определен размер на набор от данни.[4] Анализаторите на данни могат да открият нови корелации, чрез които да забелязват нови бизнес трендове, да предотвратяват болести, да се борят с престъпността и други. Учените, ръководителите на бизнеси, медицинският персонал, рекламните агенции и правителствата редовно срещат трудности с обработването на голям обем от данни в области като интернет търсения, финансови технологии, геоинформационни системи и други. Учените срещат ограничения в работата си в сферата на метеорологията, геномиката,[5] сложните физични симулации, биологията и изследванията на околната среда.[6]

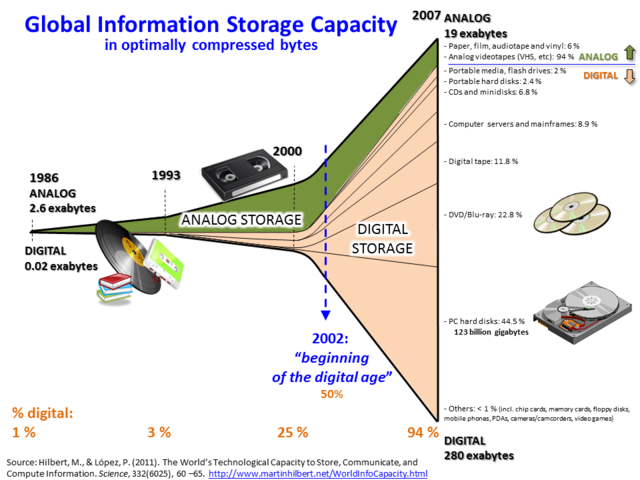

Размерът и броят на наличните множества от данни нараства много бързо със събирането на данни от различни устройства, като например мобилни, евтини и многобройни IoT устройства, софтуерни логове, камери, микрофони, RFID четци и безжични сензорни мрежи.[7][8] Световният технологичен капацитет на глава от населението за съхранение на информация се удвоява на всеки 40 месеца от 1980-те години насам.[9] Към 2012 г., всеки ден се генерират 2,5 ексабайта (2,5×260 байта) данни.[10] По прогнози на International Data Group, обемът на данните в световен мащаб ще нарасне експоненциално от 4,4 зетабайта до 44 зетабайта в периода 2013 – 2020 г. Към 2025 г. се очаква по света да има общо 163 зетабайта данни.[11]

Релационните системи за управление на бази от данни и настолният статистически софтуер се справя много трудно с обработването и анализирането на big data. Такива задачи обикновено изискват софтуер, който работи паралелно на десетки, стотици или дори хиляди сървъри.[12] Това какво се счита за „big data“ зависи от способностите и инструментите на тези, които ги анализират. Освен това, постоянно променящият се капацитет превръща big data в движеща се мишена. Така например, за някои компании стотици гигабайти данни могат да породят нуждата от специалното им управление, докато други компании могат да срещнат предизвикателство чак при обем на данните от стотици терабайти.[13]

Източници

Wikiwand in your browser!

Seamless Wikipedia browsing. On steroids.

Every time you click a link to Wikipedia, Wiktionary or Wikiquote in your browser's search results, it will show the modern Wikiwand interface.

Wikiwand extension is a five stars, simple, with minimum permission required to keep your browsing private, safe and transparent.